- 12021-03-11_安徽大学奥比中光

- 2Github 2024-02-04 开源项目日报 Top9_2024开源项目

- 3Mysql的原理解析_mysql原理

- 4告别昂贵的 AI 图像生成:试试DiffusionBee 免费的 AI 图像生成工具

- 5android backtrace,Android程序backtrace分析方法

- 6基于PyTorch的卷积神经网络经典BackBone(骨干网络)复现

- 7Google Play 关联了

- 8鸿蒙os骁龙845,800块的骁龙845旗舰?双扬声器+线性马达,这才叫真香?

- 9一文带你了解python是什么?能做什么?为什么要学?_python什么东西

- 10华清远见嵌入式学院学员实践项目案例介绍一

搭桥!接通本地大模型+知识库,部署one api搞掂,让知识库拥有大模型能力!17/45_one api 如何接入模型

赞

踩

hi~

上一篇,我们搭建了本地的知识库应用:fastgpt!

不!GPTs无法取代知识库?0基础搭建本地私有知识库!本地fastgpt部署!16/45

先跟着雄哥搭建出来,后面会教你怎样用知识库的!

今天我们要搭一条桥出来,以备之后使用API接入本地大模型!

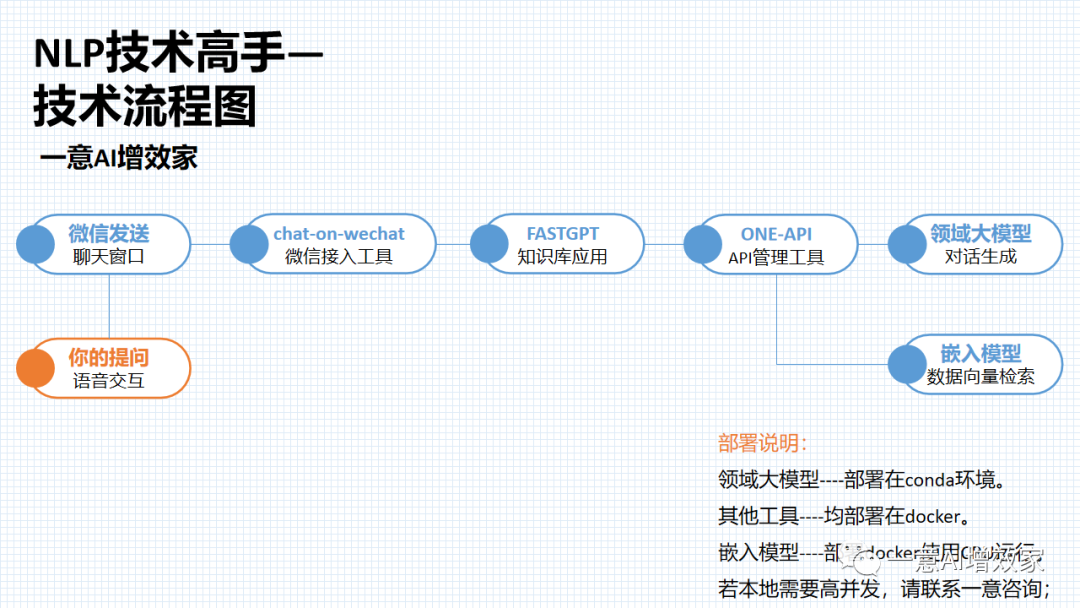

整体项目是这样的!

今天跟着雄哥做【知识库搭建】,我们在纯本地的环境搭建,涉及垂类大模型+嵌入模型的部署、docker部署,都搞掂后!使用知识库应用去搭建本地私有的知识库!

现在市场上已有大量的知识库/文档对话产品了,学会了这个部署,你基本了解到整个企业知识库部署的过程!内容如下:

day16:动手本地部署fastgpt知识库应用【已更新】

day17:动手本地部署ONE-API管理工具,与知识库打通!【本篇】

day18:与知识库对话!部署Qwen-7B/14B,用API接入知识库!

dat19:与知识库对话!部署ChatGLM3-6B,用API接入知识库!

day20:本地部署M3e嵌入模型!接入知识库,完全体!大功告成!

day21:快速上手!3分钟动手搭建私有的知识库!

day22:进阶!三种数据处理办法,提高知识库性能!

day23:进阶!知识库可视化高级编排!

day24:进阶!自定义内容,不该说的一句不说,只聊指定内容!

day25:按部门/学科,建立知识库并分发给对应部门使用

一边做一边看大家反馈,有不清楚的,雄哥再补充!

ok!人的专注力只有10分钟!那,话不多说!

本篇在win11系统完成,需要docker+WSL子系统(非wsl不稳定)!

星球的伙伴学完【7天精通docker】,可以直接上手!

还没来得及学的,可以回星球先学!

点击申请加入星球![]() https://t.zsxq.com/15XR5BKhd

https://t.zsxq.com/15XR5BKhd

整个过程非常的简单!

① docker部署one api

② 登录one api系统

③ 创建API key准备接入fastgpt

④ 修改fastgpt配置,给知识库创建接口

第一部分:docker部署one api

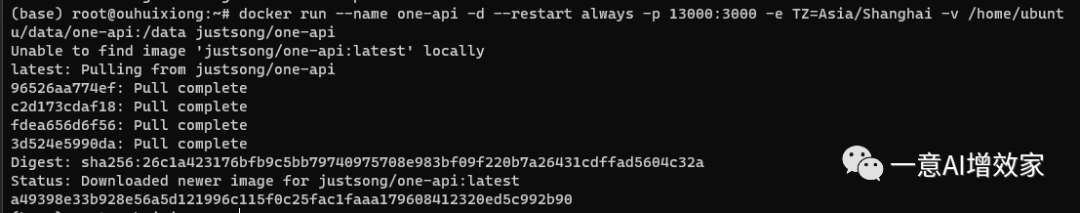

非常简单!打开‘cmd’窗口,或者打开wsl的窗口,输入输入以下命令:

docker run --name one-api -d --restart always -p 13000:3000 -e TZ=Asia/Shanghai -v /home/ubuntu/data/one-api:/data justsong/one-api

这里解释一下代码!

因为前面我们已经在docker中部署了fastgpt了,用的是‘3000’端口!你往后部署任何的docker镜像,要注意端口不能重复的,否则会占用报错!

所以这里one api,我们用的是‘13000’端口!这样就不冲突了!

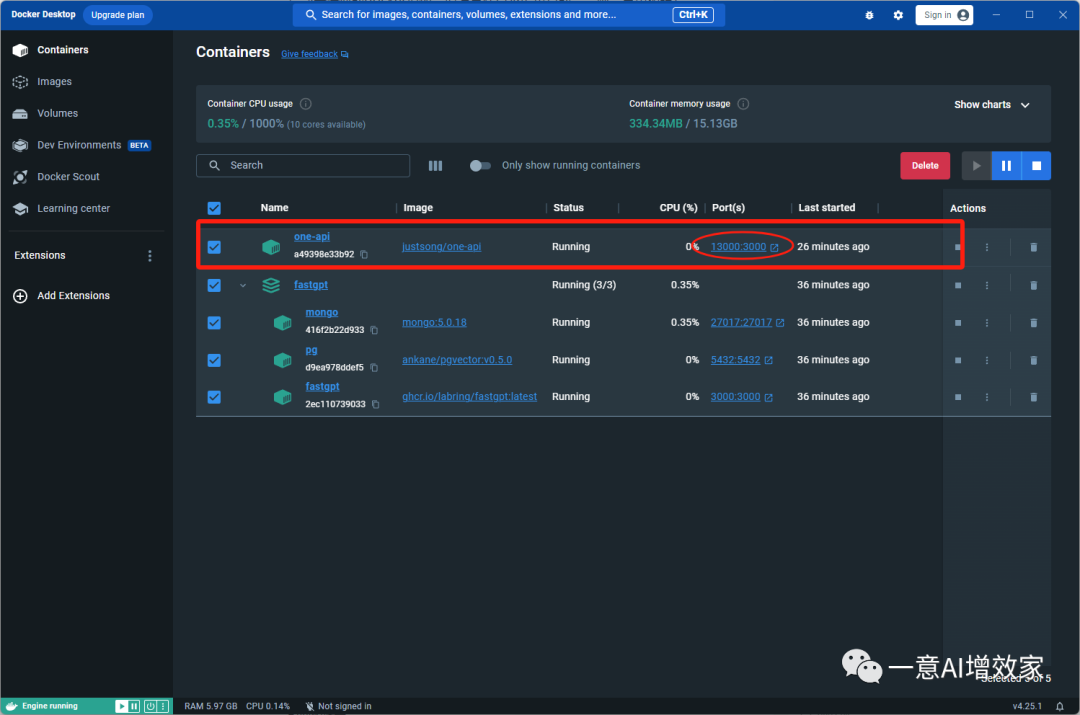

docker run:用于启动一个新容器的命令。--name one-api:为容器指定一个名称,便于识别。-d:表示以分离模式运行容器,使得容器在后台运行。--restart always:设置容器的重启策略,当容器退出时,自动重启。-p 13000:3000:端口映射,将主机的 13000 端口映射到容器的 3000 端口。-e TZ=Asia/Shanghai:设置容器的时区为上海时区。-v /home/ubuntu/data/one-api:/data:volume 映射,将主机的 /home/ubuntu/data/one-api 目录映射到容器的 /data 目录。justsong/one-api:要运行的容器镜像名称,该镜像包含了 one-api 应用程序。然后,跟着雄哥打开docker的窗口,你会看到这样一条记录!

没错,部署成功了,点开红色圈圈,就能打开管理界面了!

第二部分:登录one api系统

这个系统非常的强大!现在已经把它部署到本地了!如果你有OpenAI的key!或者百度文心一言、讯飞星火等等在线API key,都可以通过他来接入本地的知识库!

而且他还有一个用户管理系统,你完全可以用它来做自己的chat服务站!

这里是它的功能介绍:

支持多种大模型: OpenAI ChatGPT 系列模型(支持 Azure OpenAI API) Anthropic Claude 系列模型 Google PaLM2 系列模型 百度文心一言系列模型 阿里通义千问系列模型 讯飞星火认知大模型 智谱 ChatGLM 系列模型 360 智脑 腾讯混元大模型支持配置镜像以及众多第三方代理服务: OpenAI-SB CloseAI API2D OhMyGPT AI Proxy (邀请码:OneAPI) 自定义渠道:例如各种未收录的第三方代理服务支持通过负载均衡的方式访问多个渠道。支持 stream 模式,可以通过流式传输实现打字机效果。支持多机部署,详见此处。支持令牌管理,设置令牌的过期时间和额度。支持兑换码管理,支持批量生成和导出兑换码,可使用兑换码为账户进行充值。支持通道管理,批量创建通道。支持用户分组以及渠道分组,支持为不同分组设置不同的倍率。支持渠道设置模型列表。支持查看额度明细。支持用户邀请奖励。支持以美元为单位显示额度。支持发布公告,设置充值链接,设置新用户初始额度。支持模型映射,重定向用户的请求模型,如无必要请不要设置,设置之后会导致请求体被重新构造而非直接透传,会导致部分还未正式支持的字段无法传递成功。支持失败自动重试。支持绘图接口。支持 Cloudflare AI Gateway,渠道设置的代理部分填写 https://gateway.ai.cloudflare.com/v1/ACCOUNT_TAG/GATEWAY/openai 即可。支持丰富的自定义设置,支持自定义系统名称,logo 以及页脚。支持自定义首页和关于页面,可以选择使用 HTML & Markdown 代码进行自定义,或者使用一个单独的网页通过 iframe 嵌入。支持通过系统访问令牌访问管理 API(bearer token,用以替代 cookie,你可以自行抓包来查看 API 的用法)。支持 Cloudflare Turnstile 用户校验。支持用户管理,支持多种用户登录注册方式:邮箱登录注册(支持注册邮箱白名单)以及通过邮箱进行密码重置。GitHub 开放授权。微信公众号授权(需要额外部署 WeChat Server)。今天我们的重点是接入本地部署的LLM,而不是闭源LLM(百度/星火/智谱),但是,只要你跟着雄哥学会了本地部署,那其他的就更简单了!

ok!跟着雄哥,点开了上面的‘13000’的端口之后,他会自动跳转到浏览器!

如果你没更改过配置文件,默认账号密码是:

账号:root

密码:123456

第一次登录需要你改一个8位数的密码,改一个容易记的就行!

第三部分:创建API key准备接入fastgpt

ok!我们创建一个API key,让知识库应用fastgpt接入one API!

点击‘令牌’,添加!

输入‘yiyiai’!

点击永不过期+无限额度!这样,这个API key的访问量就是不限量,不限期的了,如果你是外发给其他人使用的,你可以让他购买算力,然后给他设置一个限量的key!

点击提交!返回!

你会看到这里已经新建成功,点击‘复制’!你就得到了API key了!

第四部分:修改fastgpt配置,给知识库创建接口

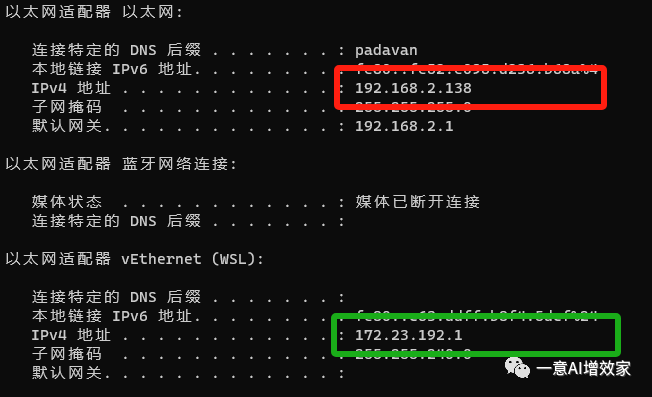

恭喜啊!现在我们要获取本地的IP地址,不然fastgpt不认啊!

打开cmd窗口,随便哪里打开都可以!输入,以下!回车!

ipconfig往下拉,你就可以看到本机的IP地址了!这里有两个IP,一个是本地真实IP,另外一个是WSL中的子系统IP!

简单提一嘴,如果你以后在WSL里部署的大模型,那你要用这个来中转的!

看红色框里面的IP地址,这就是我们要的,本地IP!

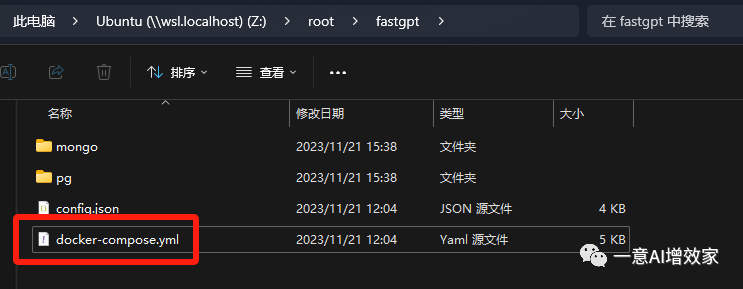

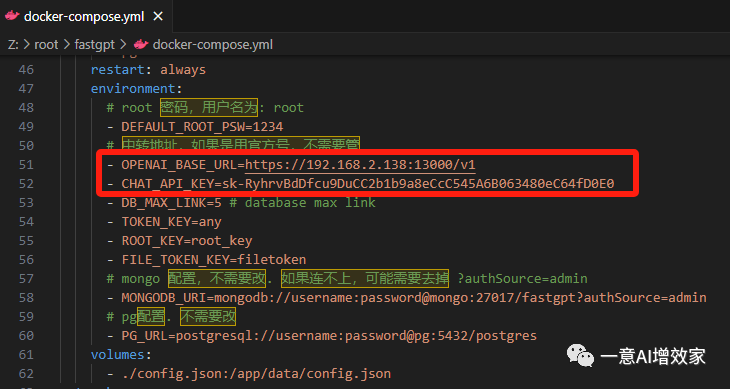

这时,打开上一篇下载的fastgpt的镜像配置文件‘docker-compose.yml’!跟着雄哥修改它!接入one api!

打开之后,往下拉!把自己的IP地址和刚刚ONE api的端口填进去!

端口多少?‘13000’!后面一定要加‘v1’!

确保全部英文字符啊!别搞中文全字符,那是用不了的!

还没完,我们修改完了,要更新一下配置文件!

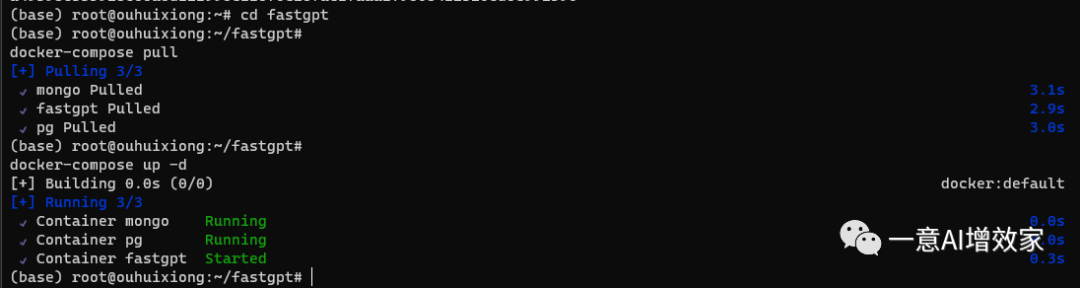

cd到fastgpt配置文件的路径!

docker-compose pulldocker-compose up -d

至此!已经接入成功了!

之后,你的知识库就打通了通道,我们可以用它接入本地大模型!

或者任意的在线LLM!

下一篇!

我们开始在本地部署Qwen-14B,然后通过API的方式接入到知识库!