- 1经典排序算法的VC实现_vc实现文件按时间顺序排列

- 22024年软件测试最全当前软件测试市场现状,2024年最新跳槽大厂必看

- 3模块化 git管理_gitlab 一个项目多个模块

- 4SpringBoot狂神08-(实现WebMvcConfigurer扩展配置)

- 5网络分析工具介绍_常见的网络分析工具有哪些及其区别

- 6利用python求解规划问题_python规划求解

- 7我好像发现了车载测试面试成功的秘籍

- 8视觉Transformer笔记_transformerconv

- 9Node.js的安装和环境配置以及历史版本_nodejs历史版本安装及环境配置

- 10KAN网络技术最全解析—最热KAN能否干掉MLP和Transformer?(收录于GPT-4/ChatGPT技术与产业分析)

分布式搜索-elaticsearch基础 安装es

赞

踩

这里是在虚拟机的Linux系统里安装es的教程:

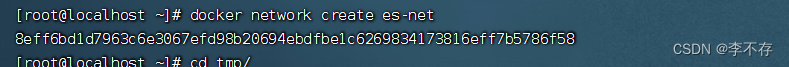

1.创建网络

在Finashell终端输入指令

docker network create es-net

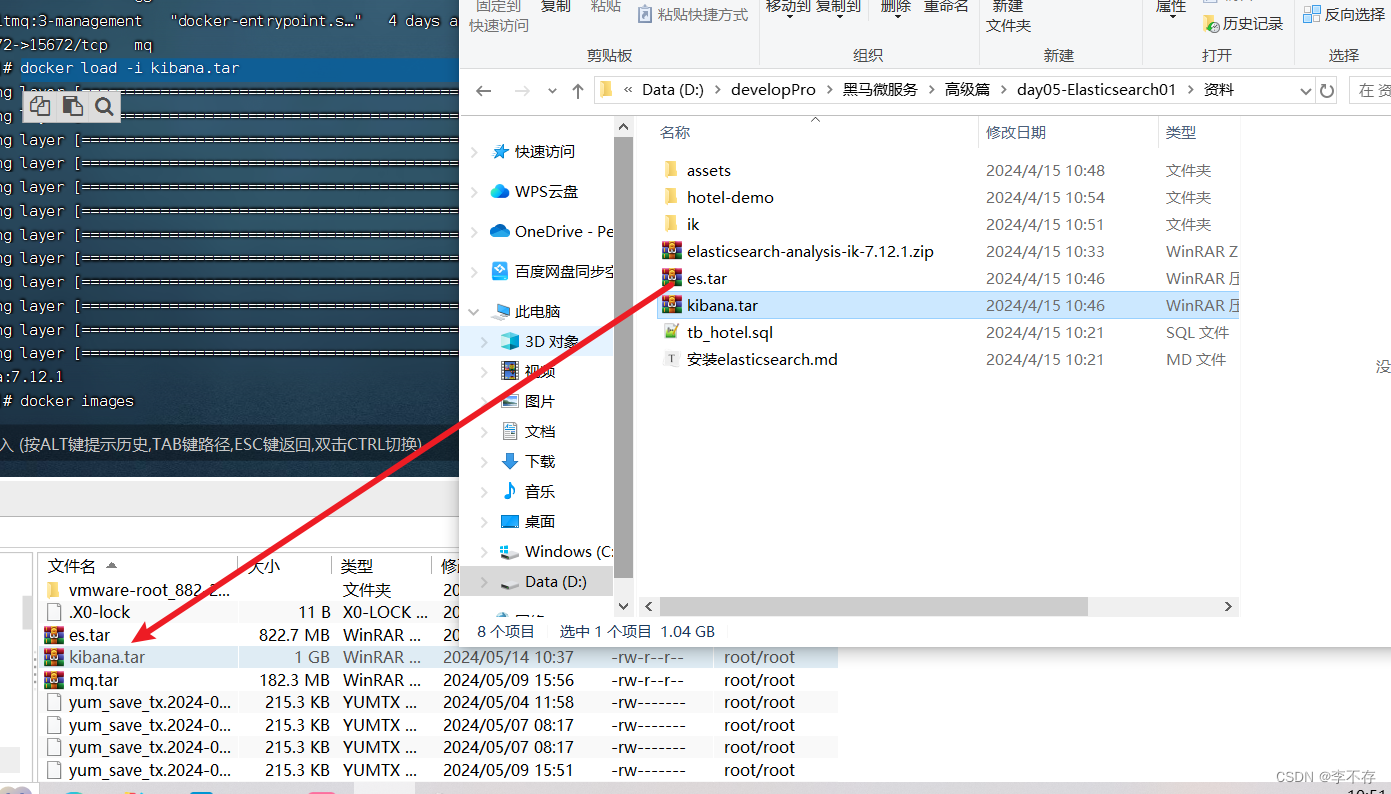

2.将es.tar安装包放入tmp的目录下

输入指令加载镜像:docker load -i es.tar

3.再运行docker 命令

- docker run -d \

- --name es \

- -e "ES_JAVA_OPTS=-Xms512m -Xmx512m" \

- -e "discovery.type=single-node" \

- -v es-data:/usr/share/elasticsearch/data \

- -v es-plugins:/usr/share/elasticsearch/plugins \

- --privileged \

- --network es-net \

- -p 9200:9200 \

- -p 9300:9300 \

- elasticsearch:7.12.1

命令成功后输入:docker ps 可以看到容器已经运行起来了

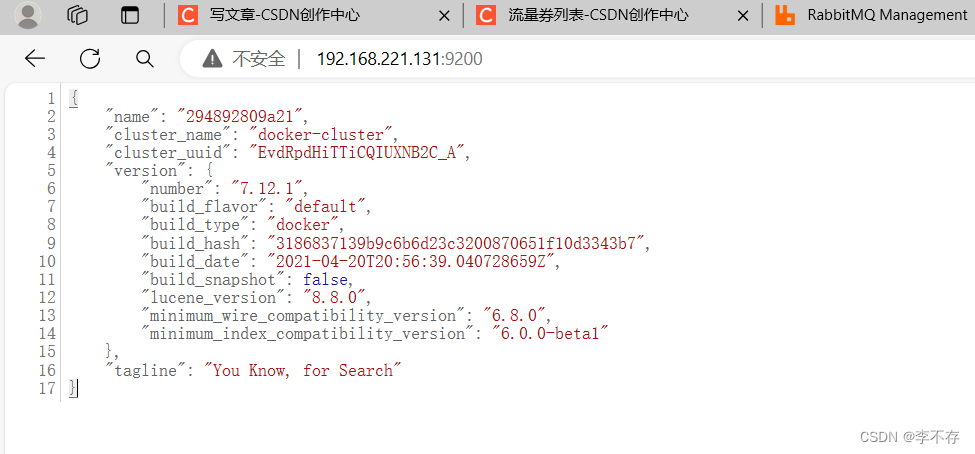

4.在主机通过映射地址可以访问到:这里是你虚拟机地址:9200

这里是在虚拟机的Linux系统里安装kibana:

1.将kibana安装包放入tmp目录下

2.docker load -i kibana.tart 通过这个指令加载镜像

3.运行容器

- docker run -d \

- --name kibana \

- -e ELASTICSEARCH_HOSTS=http://es:9200 \

- --network=es-net \

- -p 5601:5601 \

- kibana:7.12.1

运行成功后在主机的映射地址可以访问提供的图形化界面:

在这个图形化界面里可以编写dsl语句发送给es。

非常的好用

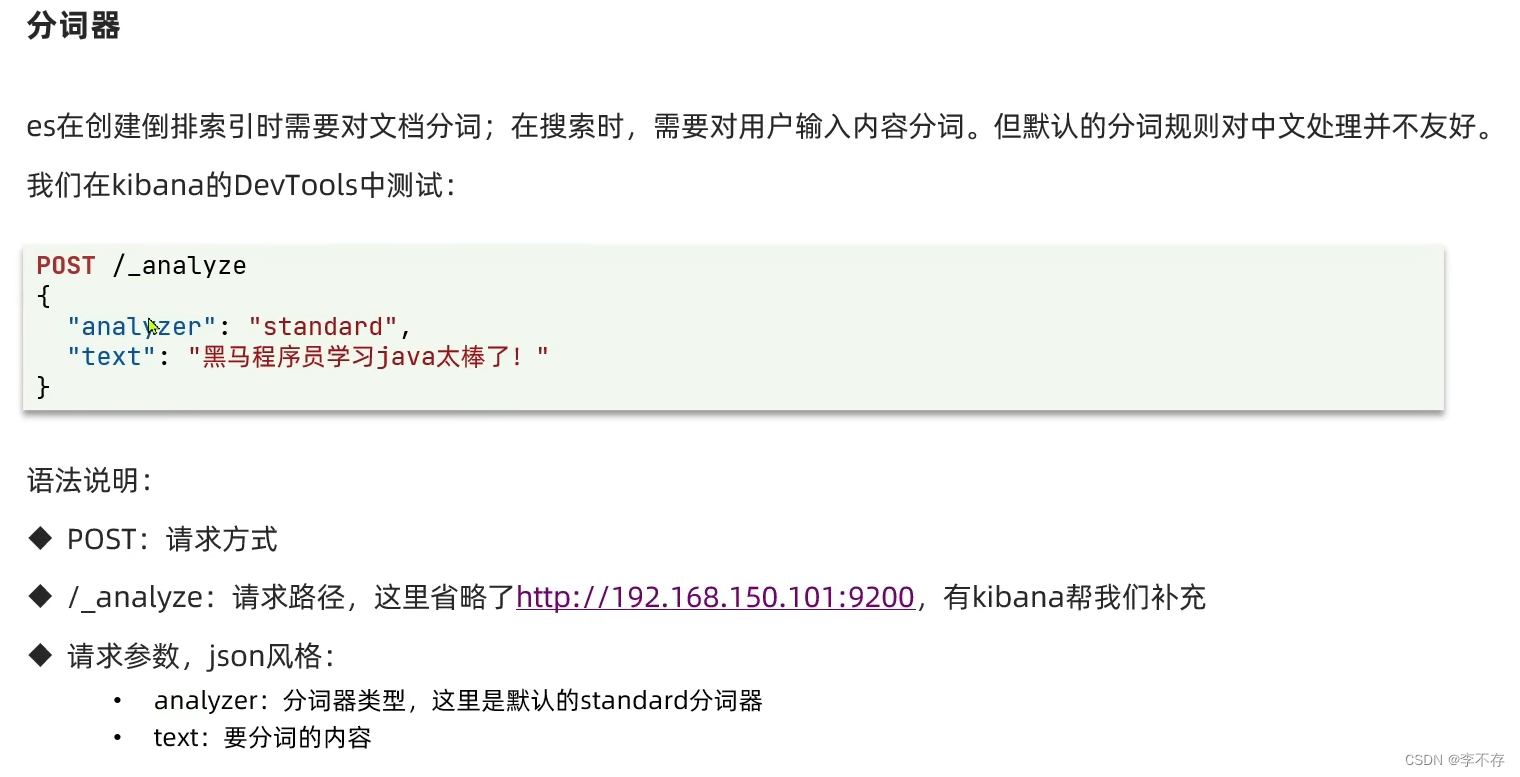

分词器:

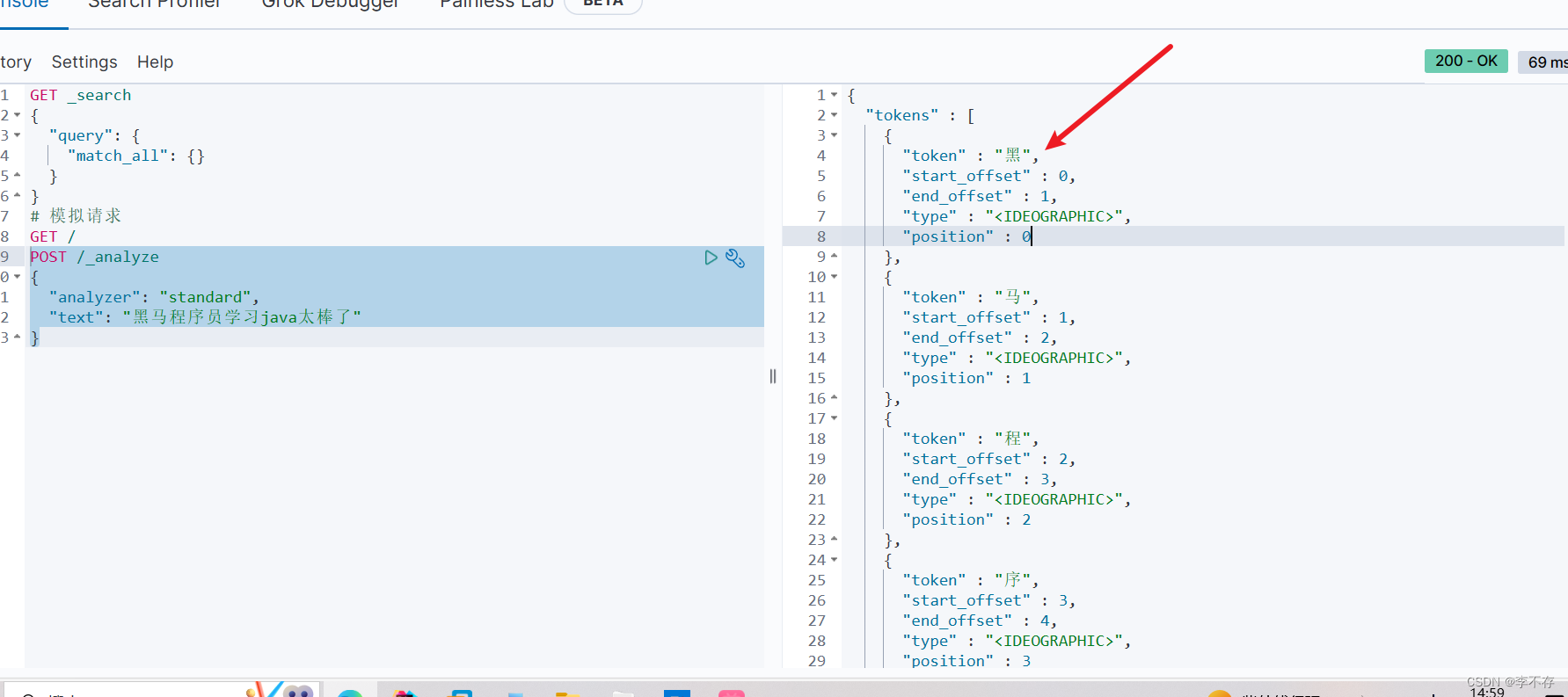

练习:可以看出来默认的standard分词效果并不是很好

- POST /_analyze

- {

- "analyzer": "standard",

- "text": "黑马程序员学习java太棒了"

- }

IK分词器:

这个分词器真好用

IK分词器包含两种模式:

-

ik_smart:最少切分 -

ik_max_word:最细切分

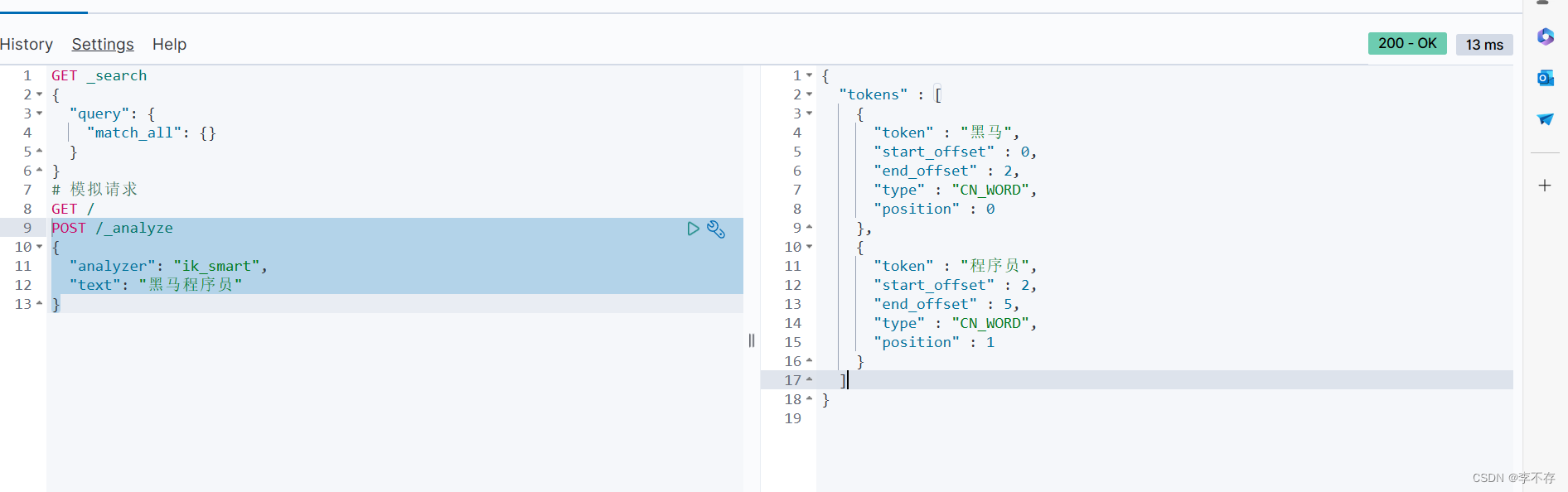

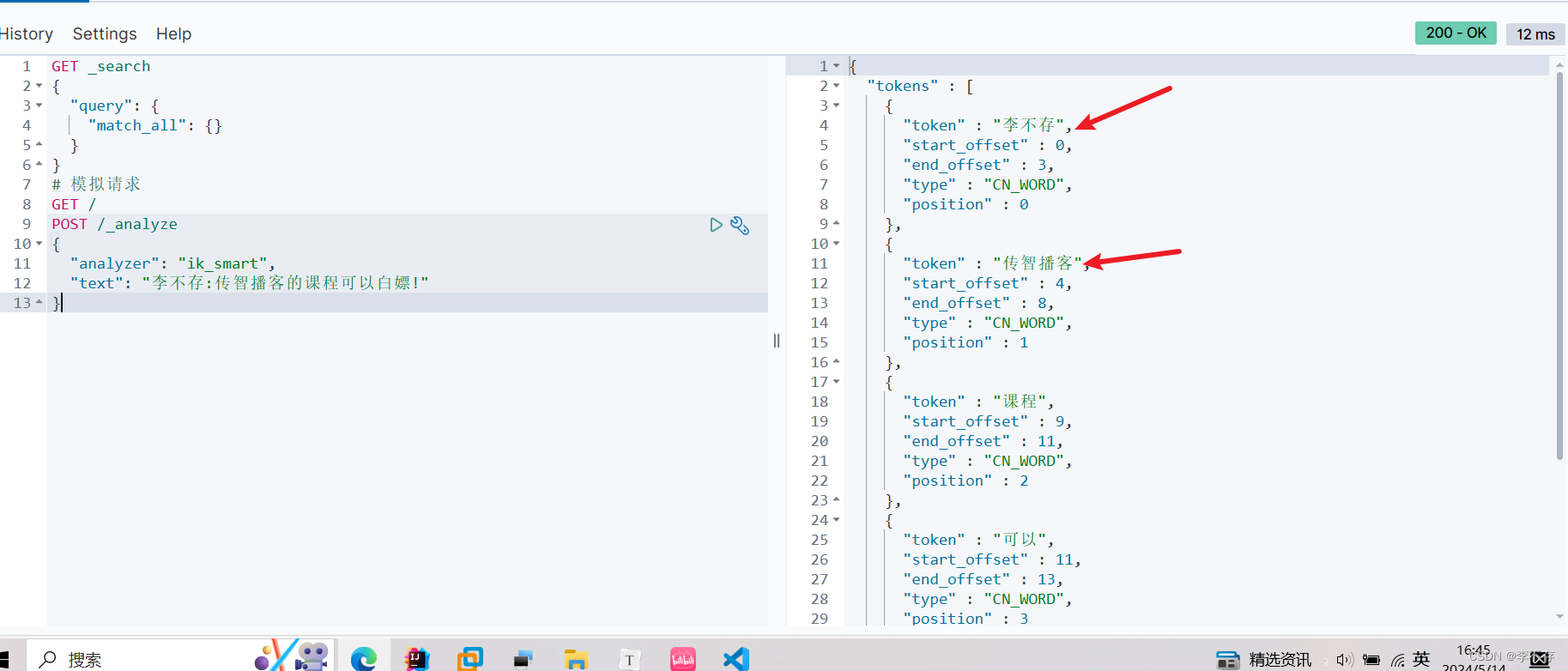

ik_smart模式测试:

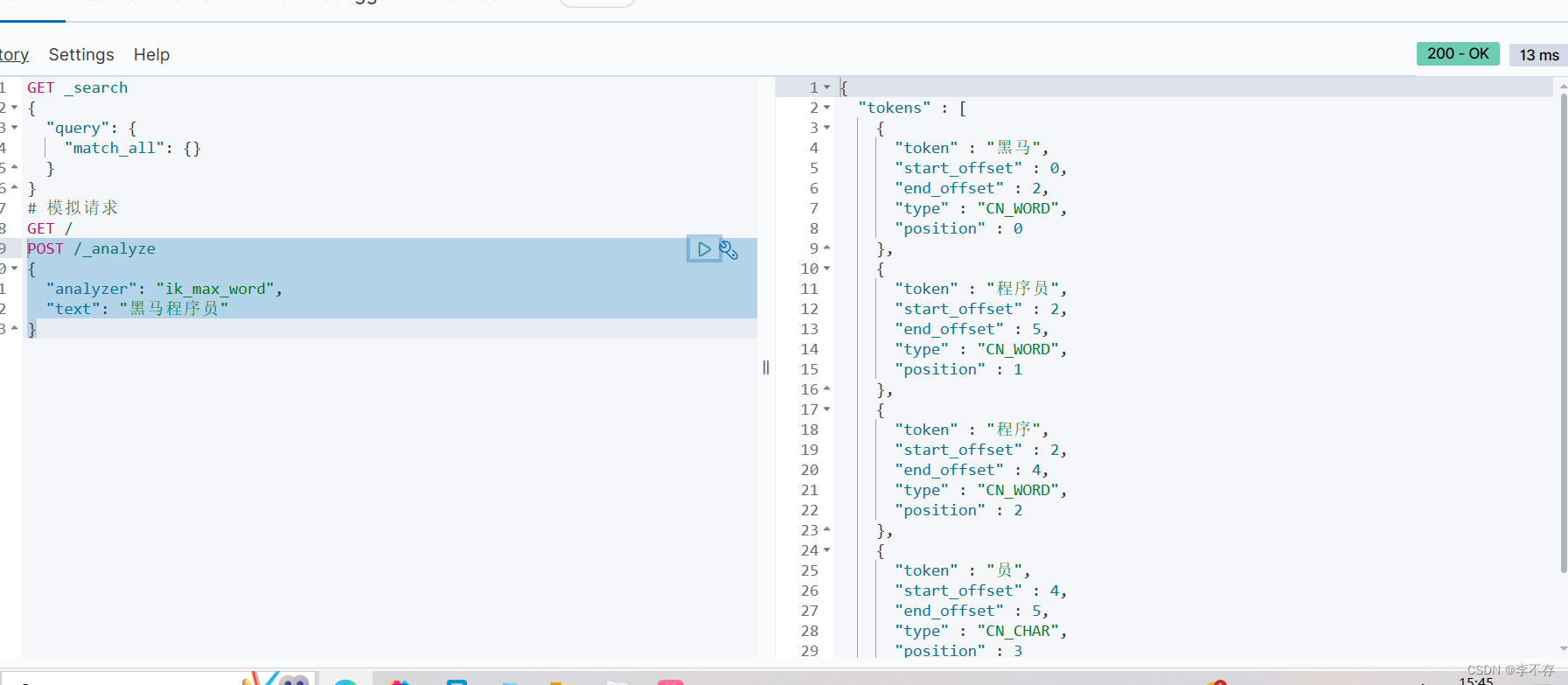

ik_max_smart测试

:感觉还是有少许缺陷

IK分词器安装:

IK分词器安装:

1.在线安装:

# 进入容器内部

docker exec -it elasticsearch /bin/bash# 在线下载并安装

./bin/elasticsearch-plugin install https://github.com/medcl/elasticsearch-analysis-ik/releases/download/v7.12.1/elasticsearch-analysis-ik-7.12.1.zip#退出

exit

#重启容器

docker restart elasticsearch

2.离线安装:

前提:前边加载elasticsearch镜像时候设置了数据卷挂载,有ik的安装包(我有安装包需要的可以私信我拿)。

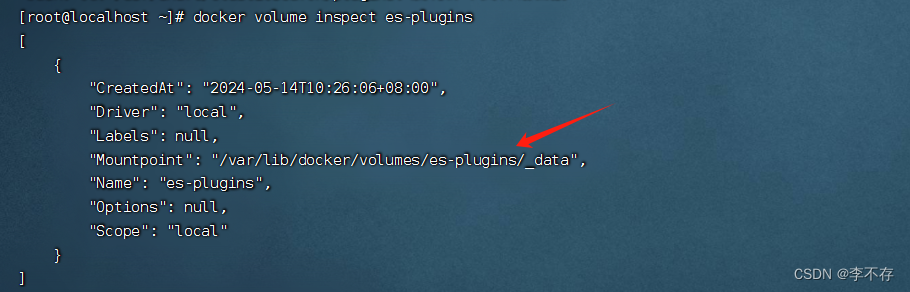

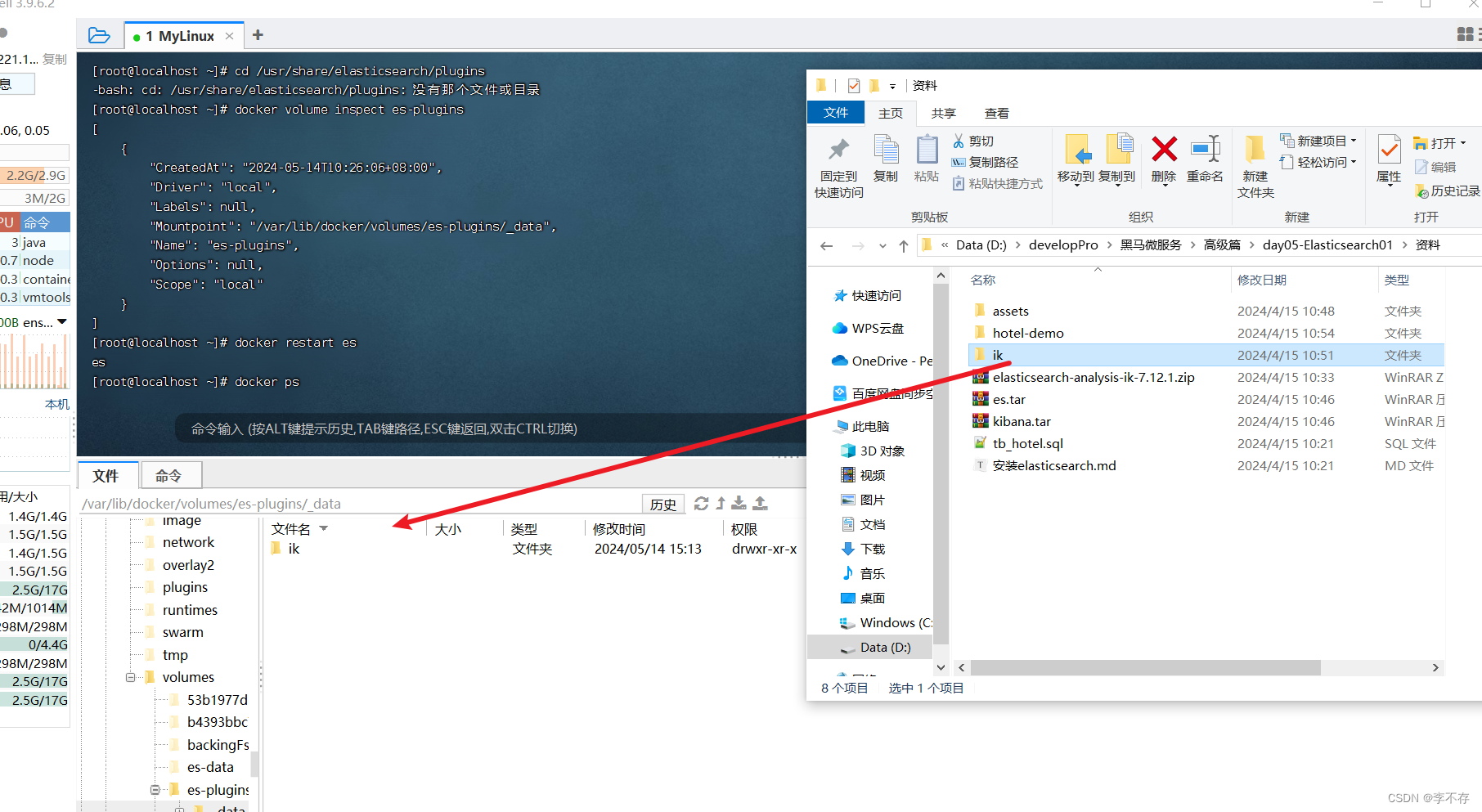

1.输入命令查看挂载的数据卷路径:

docker volume inspect es-plugins

2.进入路径后把ik安装包拖进去:

3.重启容器:

docker restart es

IK分词器自定义词典:

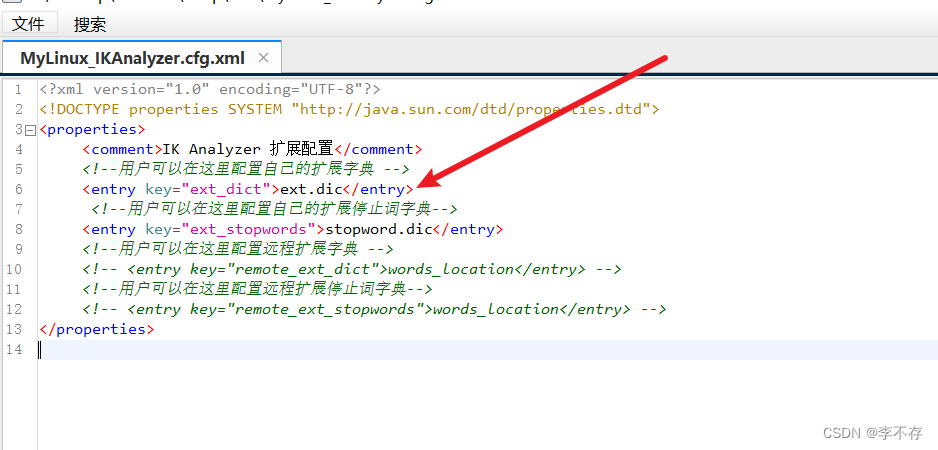

1.在哪里配置:

在ik文件config目录里边的xml文件。

在这里更改配置:

停用字典

扩展词字典

- <?xml version="1.0" encoding="UTF-8"?>

- <!DOCTYPE properties SYSTEM "http://java.sun.com/dtd/properties.dtd">

- <properties>

- <comment>IK Analyzer 扩展配置</comment>

- <!--用户可以在这里配置自己的扩展字典 -->

- # 这里的ext.dic是文件名名字 可以在该文件同目录的地方创建添加 这里可以自定义

- <entry key="ext_dict">ext.dic</entry>

- <!--用户可以在这里配置自己的扩展停止词字典-->

- <entry key="ext_stopwords">stopword.dic</entry>

- <!--用户可以在这里配置远程扩展字典 -->

- <!-- <entry key="remote_ext_dict">words_location</entry> -->

- <!--用户可以在这里配置远程扩展停止词字典-->

- <!-- <entry key="remote_ext_stopwords">words_location</entry> -->

- </properties>

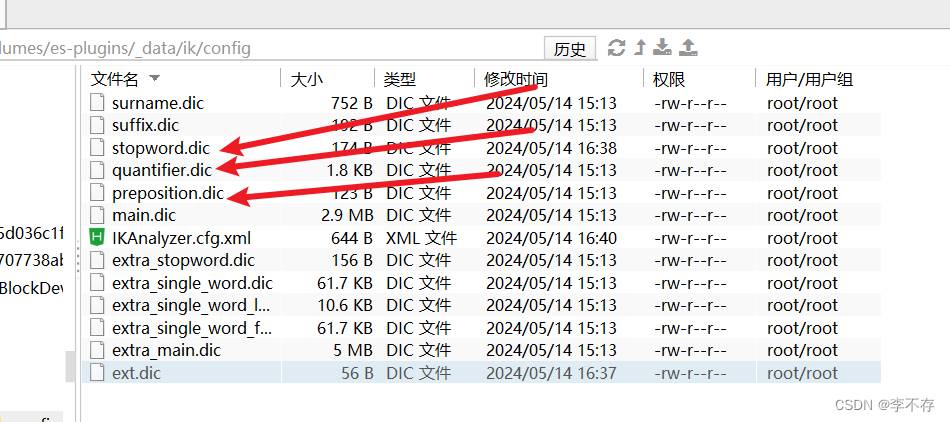

这里边的所有dic后缀的文件都是词典,可以自己创建并且config配置,可以点开看一下里边的配置格式,这个还是挺简单的。

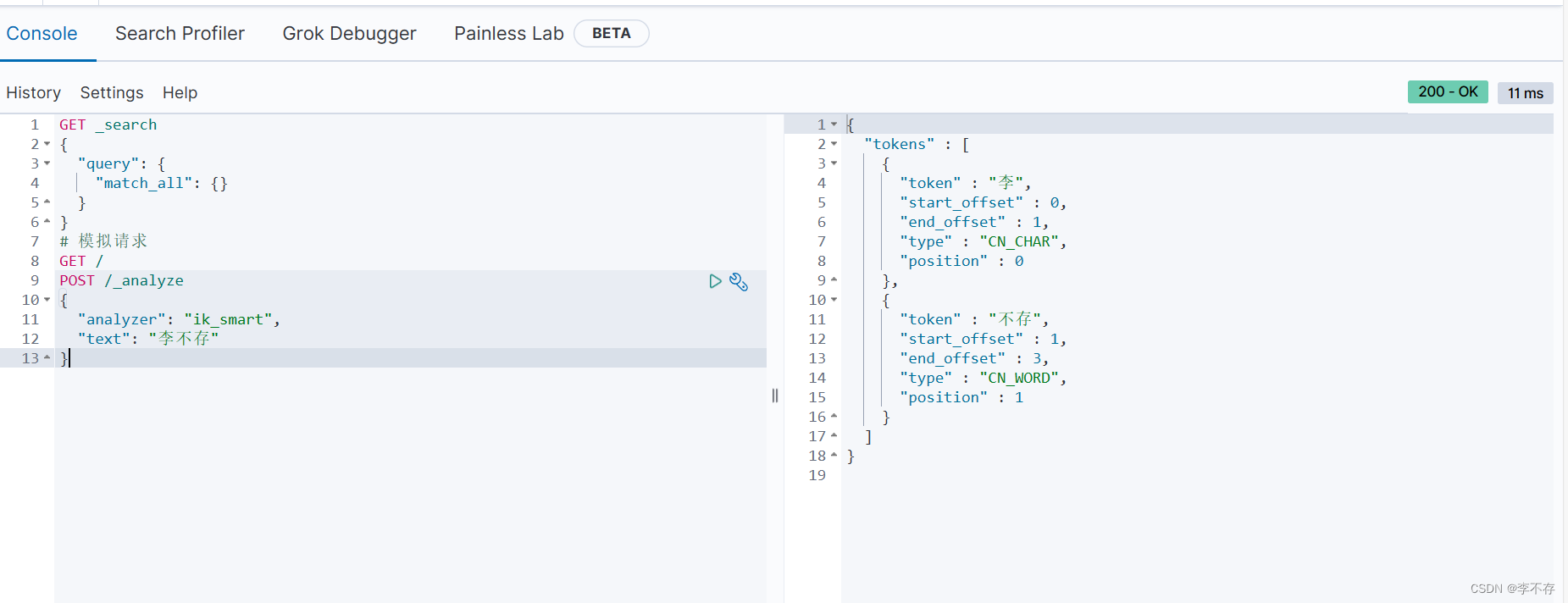

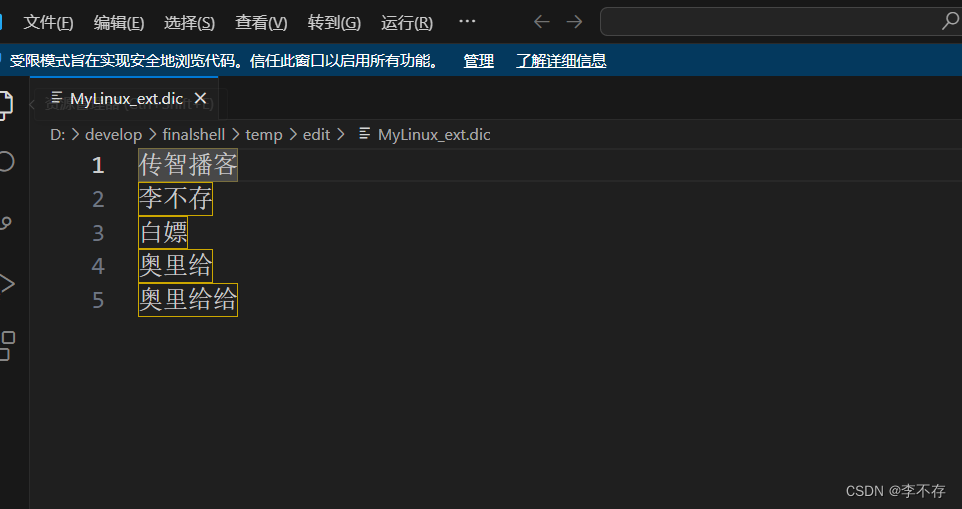

这是我新创的dic 并且在配置文件里边指定了

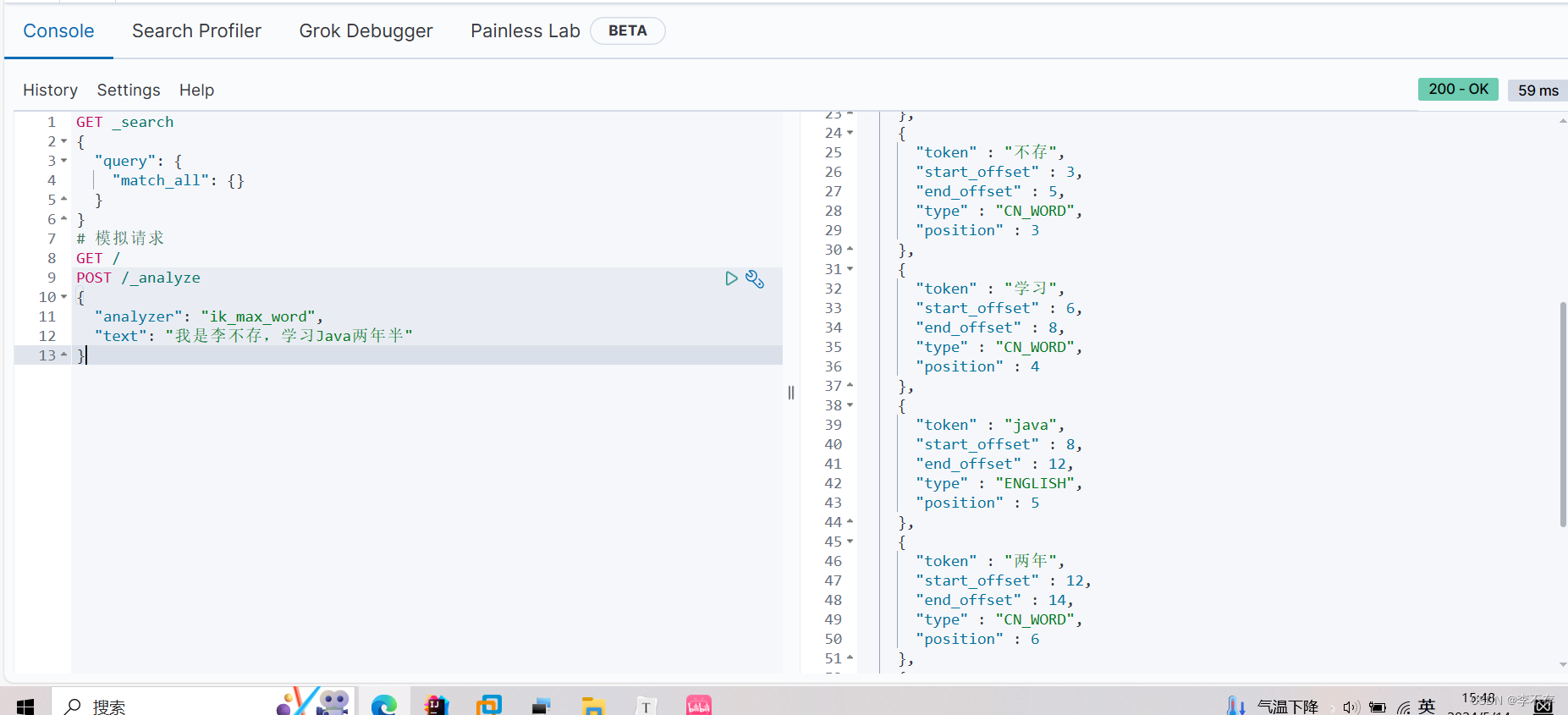

2.测试:

这里看测试结果发现传智播客和李不存已经可以分词分出来了,非常的好用!

3.ik分词器总结: