热门标签

当前位置: article > 正文

从零实现Llama3中文版_llama3 从零

作者:你好赵伟 | 2024-06-05 02:03:25

赞

踩

llama3 从零

1.前言

一个月前,Meta 发布了开源大模型 llama3 系列,在多个关键基准测试中优于业界 SOTA 模型,并在代码生成任务上全面领先。

此后,开发者们便开始了本地部署和实现,比如 llama3 的中文实现、llama3 的纯 NumPy 实现等。

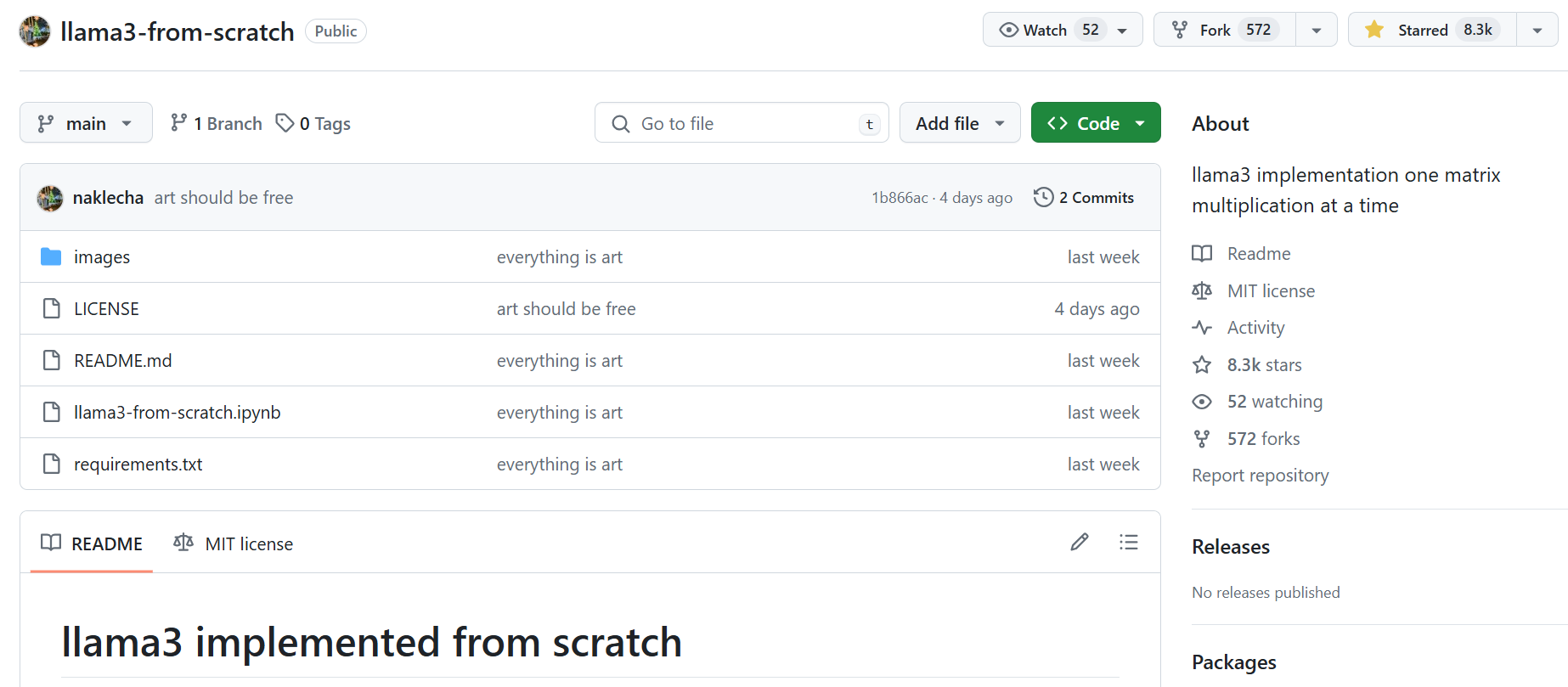

几天前,有位名为「Nishant Aklecha」的开发者发布了一个从零开始实现 llama3 的存储库,包括跨多个头的注意力矩阵乘法、位置编码和每个层在内都有非常详细的解释,帮助我们理解大语言模型是如果构建和工作的。

该项目得到了大神 Karpathy 的称赞,他表示项目看起来不错,完全展开后,通过模块嵌套和相互调用,可以更容易看到实际的情况。

项目地址:https://github.com/naklecha/llama3-from-scratch

2.从零实现Llama3中文版

详细实现见仓库地址:wdndev/llama3-from-scratch-zh: 从零实现一个 llama3 中文版

项目主要翻译「Nishant Aklecha」的 llama3-from-scratch 仓库,并对中文版做了特殊的适配,使该项目能在一台 16G RAM 的笔记本电脑上运行:

- 将英文翻译为中文,文中的 Youtube 视频也替换为 Bilibili链接,方便查看;

- 将原版 Llama3-8B模型上传至Modescope社区,方便国内下载;

- 因原版 Llama3-8B 模型采用32层 Transformers,且大佬「Nishant Aklecha」使用CPU加载,如果加载全部的参数,16G内存机器加载失败,故选取原版 Llama3-8B 模型权重的前2层,重新保存,大小约占为2.7G,此教程也可以直接加载,实际测试内存占用约4~5G,唯一缺点是后续推理结果不对,但不影响学习矩阵变换等其他知识;

- Jupyter文件,可直接在 16G RAM 笔记本电脑运行;

2.1 实现细节

- 分词器(Tokenizer):

- 使用

tiktoken库进行文本分词。 - 定义了一些特殊标记,如文本开始

<|begin_of_text|>、文本结束<|end_of_text|>等。 - 通过

tokenizer.encode将文本转换为标记序列,通过tokenizer.decode将标记序列转换回文本。

- 使用

- 模型权重和配置:

- 加载Llama3-8B模型Pytorch格式权重。

- 加载Llama3-8B模型配置,包括:

- 维度

dim: 4096 - 层数

n_layers: 32 - 注意力头数

n_heads: 32 - 键值头数

n_kv_heads: 8 - 词汇表大小

vocab_size: 128256 - 其他参数如

multiple_of、ffn_dim_multiplier、norm_eps、rope_theta等。

- 维度

- 文本到标记(Tokenization):

- 使用分词器将输入文本转换为标记序列。

- 将标记转换为对应的标记ID。

- 标记嵌入(Embeddings):

- 使用

torch.nn.Embedding层将标记ID转换为词嵌入向量。 - 将词嵌入向量进行归一化处理。

- 使用

- Transformer层:

- 实现了Transformer模型的一个层,包括:

- 归一化: 使用RMS归一化对输入进行归一化。

- 注意力机制:

- 使用模型权重初始化查询(Query)、键(Key)、值(Value)矩阵。

- 对查询矩阵进行拆分,得到每个注意力头的查询向量。

- 通过点积计算查询向量与键向量的关系,得到注意力分数矩阵。

- 对注意力分数应用掩码,防止未来信息的泄露。

- 使用Softmax函数对注意力分数进行归一化。

- 将归一化的注意力分数与值向量相乘,得到加权的值向量。

- 多头注意力: 对每个注意力头重复上述过程,并将结果合并。

- 输出权重: 使用模型权重将注意力输出映射到最终的输出向量。

- 实现了Transformer模型的一个层,包括:

- 前馈网络(Feed-Forward Network):

- 使用SwiGLU网络架构,增加模型的非线性表达能力。

- 通过矩阵乘法实现前馈网络的计算。

- 多层堆叠:

- 将上述Transformer层和前馈网络堆叠32层。

- 每一层都会对输入进行更复杂的变换和抽象。

- 输出解码:

- 使用模型的输出层权重将最终的嵌入向量映射到词汇表上。

- 通过取最大值获取预测的下一个标记ID。

- 使用分词器将标记ID解码回文本。

2.2 总结

- 详细展示了从头开始构建大型语言模型的一个层的完整过程。

- 通过分步实现文本分词、标记嵌入、注意力机制、多头注意力、前馈网络等关键组件,让读者能够深入理解模型的工作原理。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/你好赵伟/article/detail/674373

推荐阅读

相关标签