热门标签

当前位置: article > 正文

Seq2Seq in Tensorflow_资源耗尽 seq2seq模型 tensorflow gpu

作者:你好赵伟 | 2024-06-08 00:24:15

赞

踩

资源耗尽 seq2seq模型 tensorflow gpu

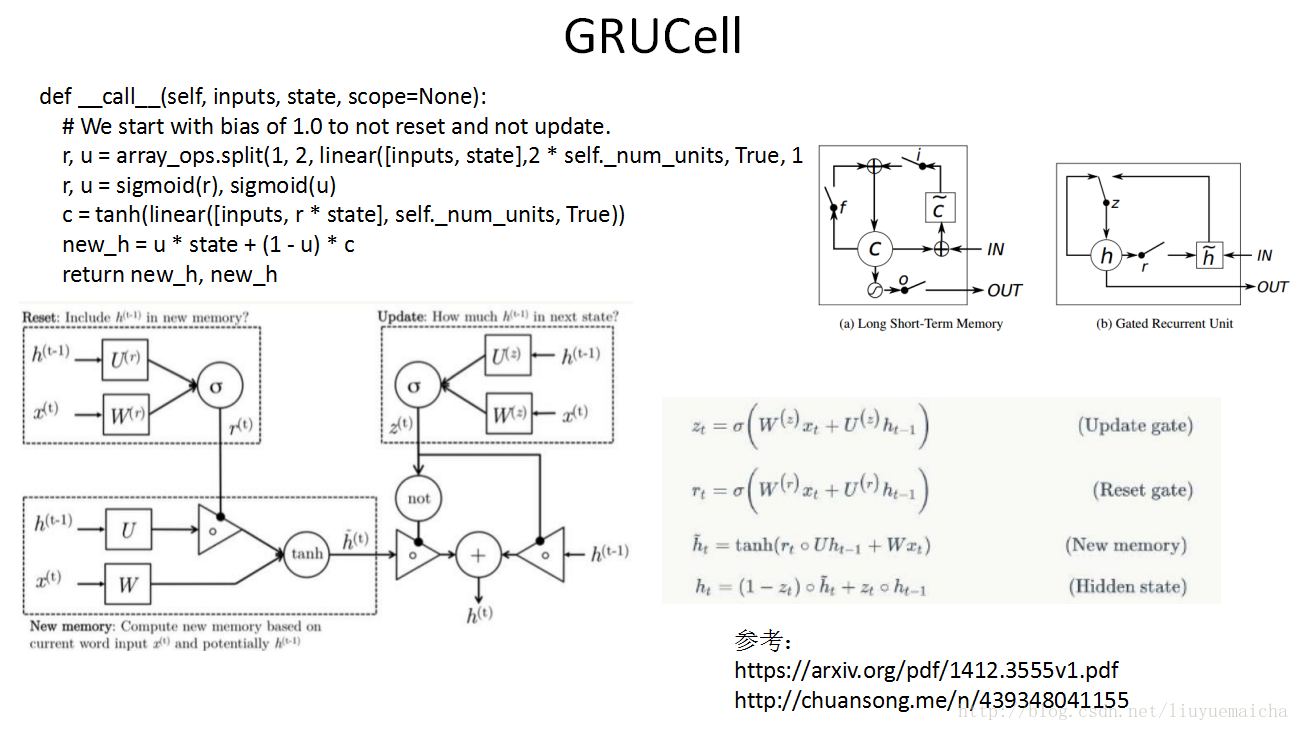

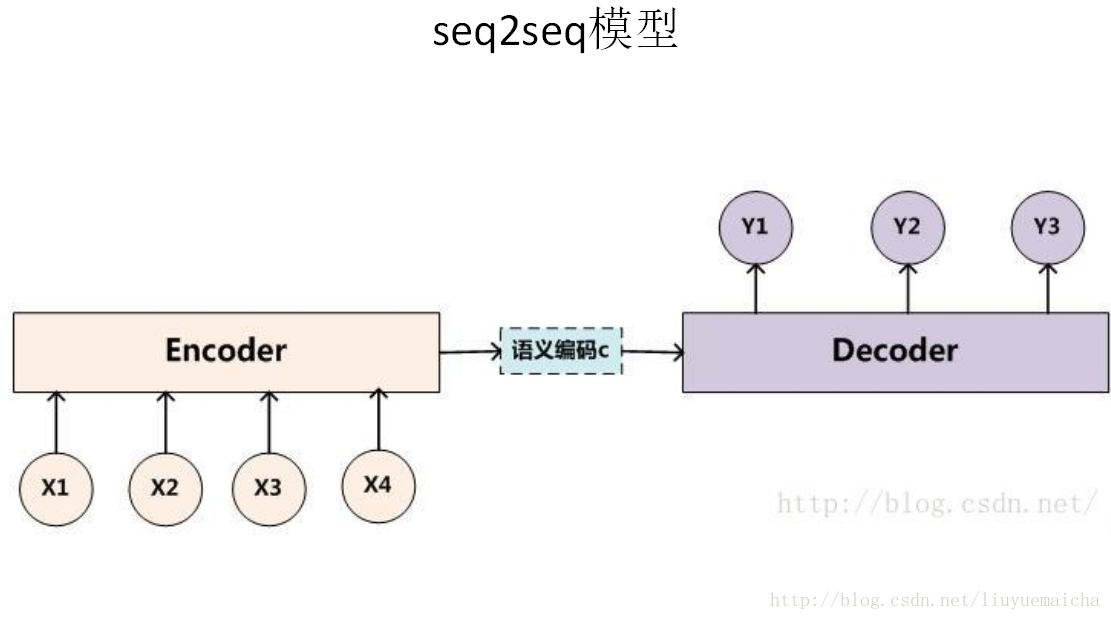

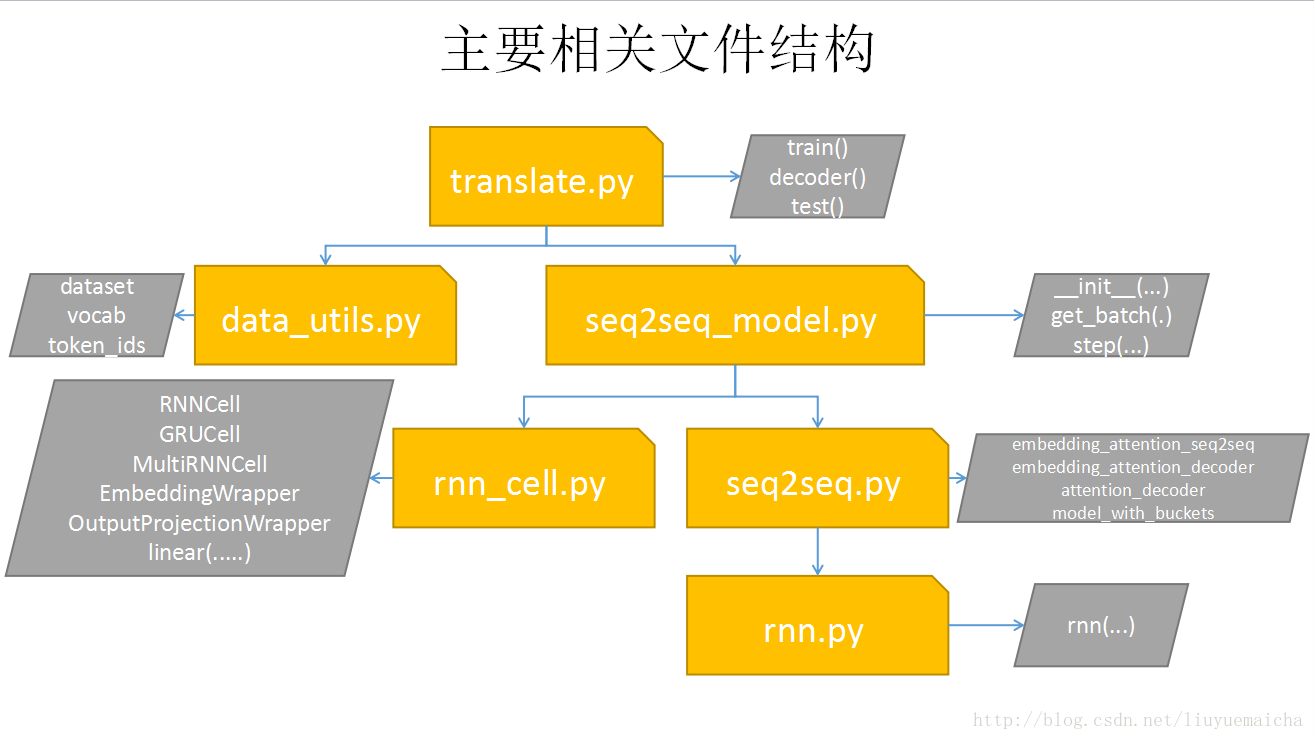

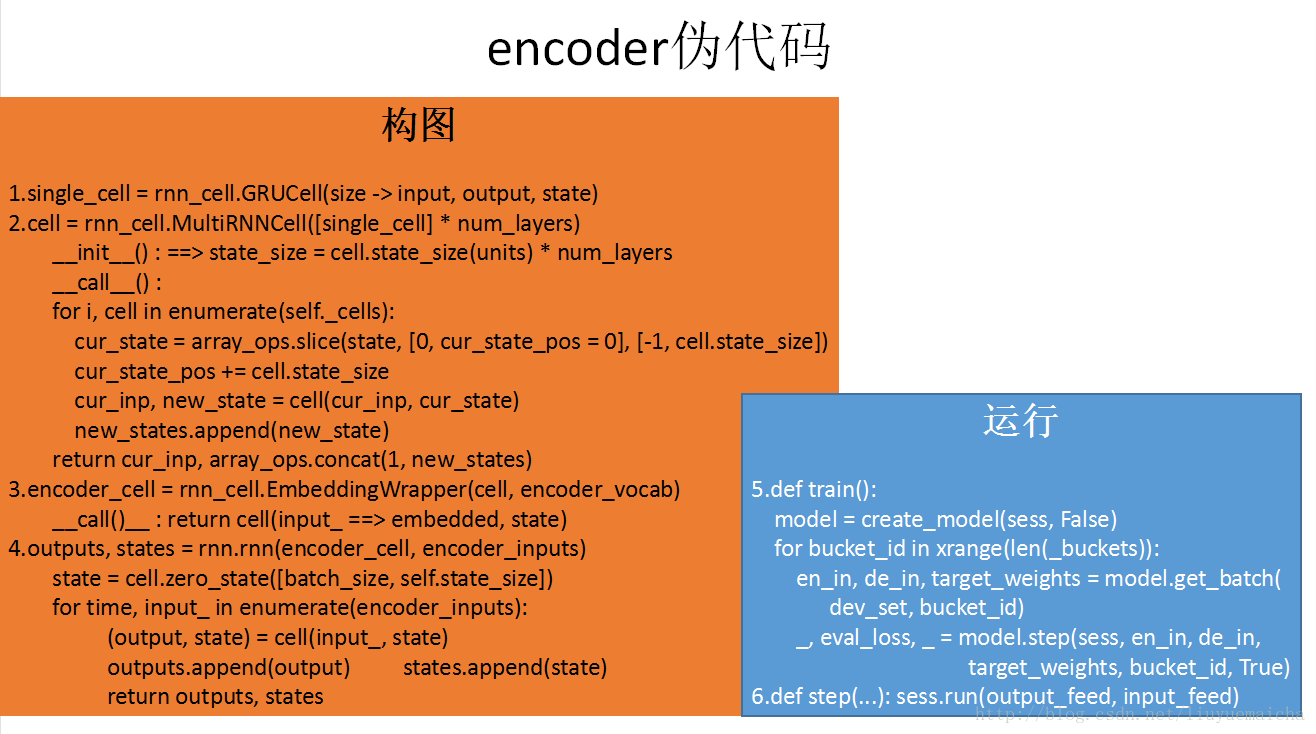

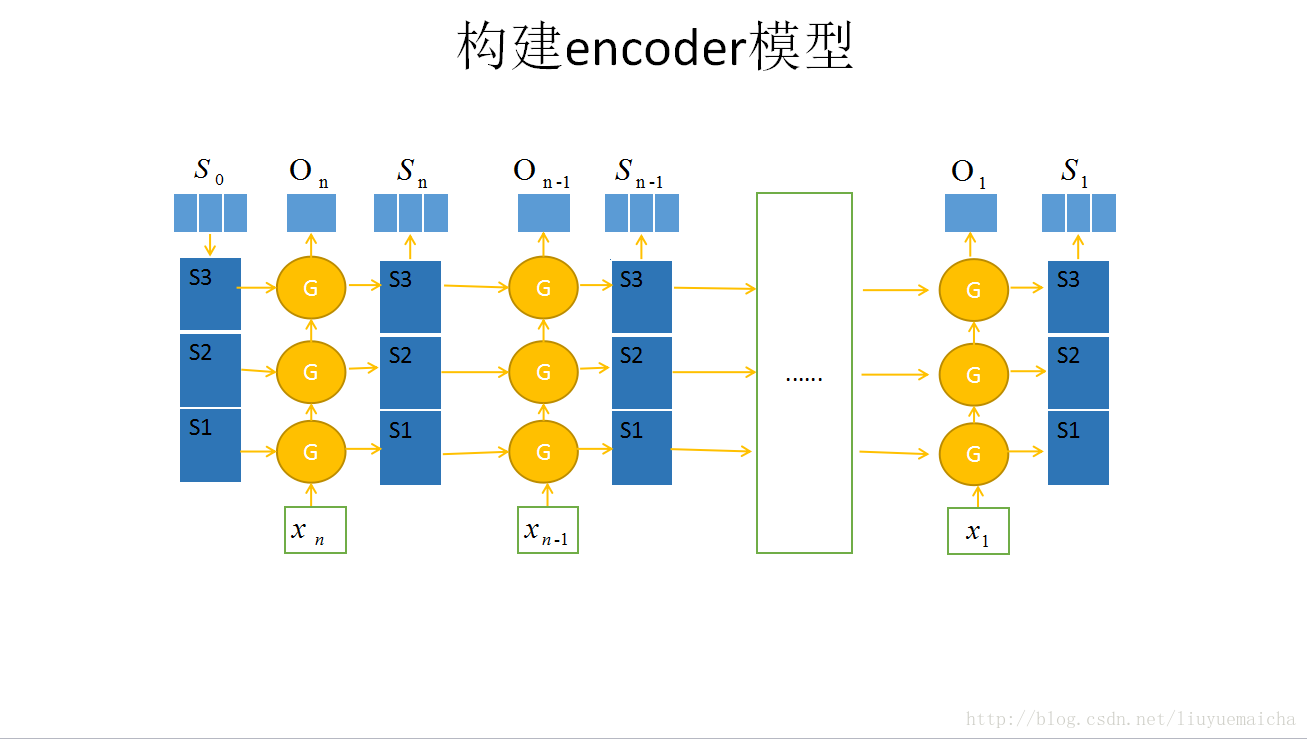

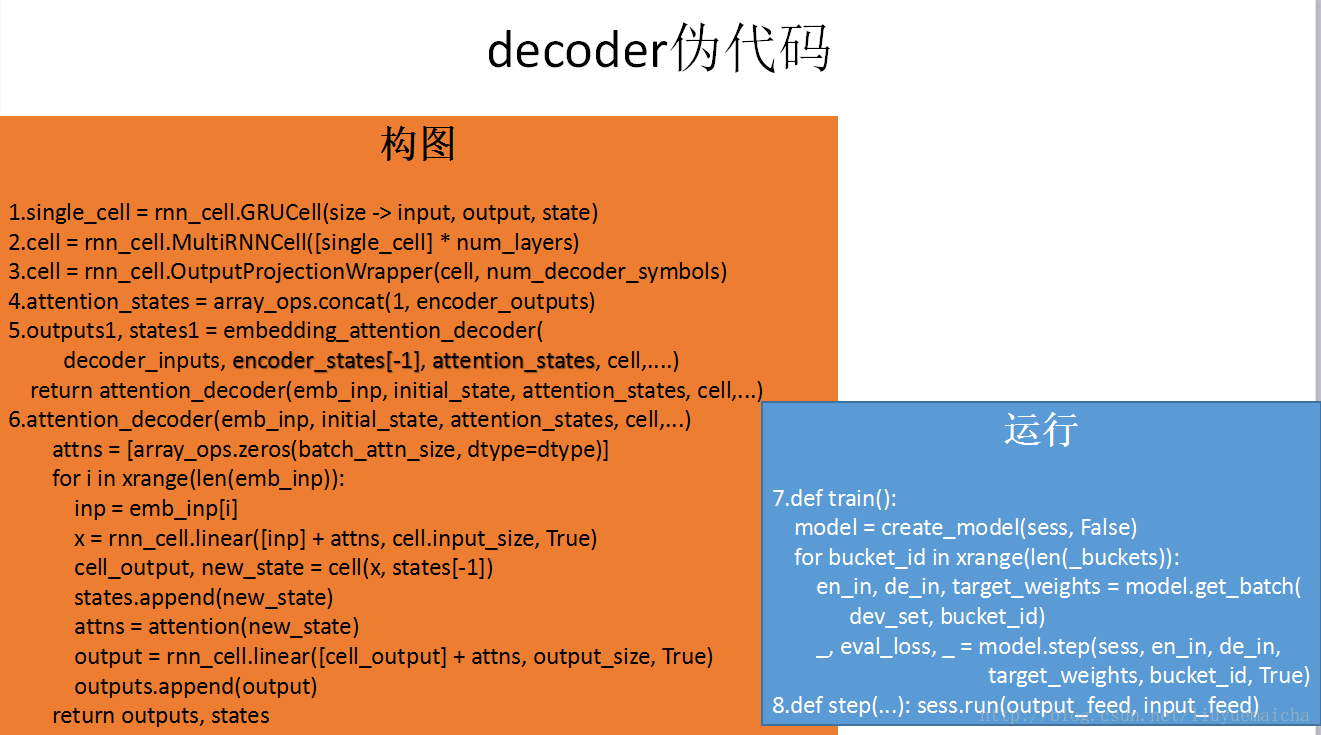

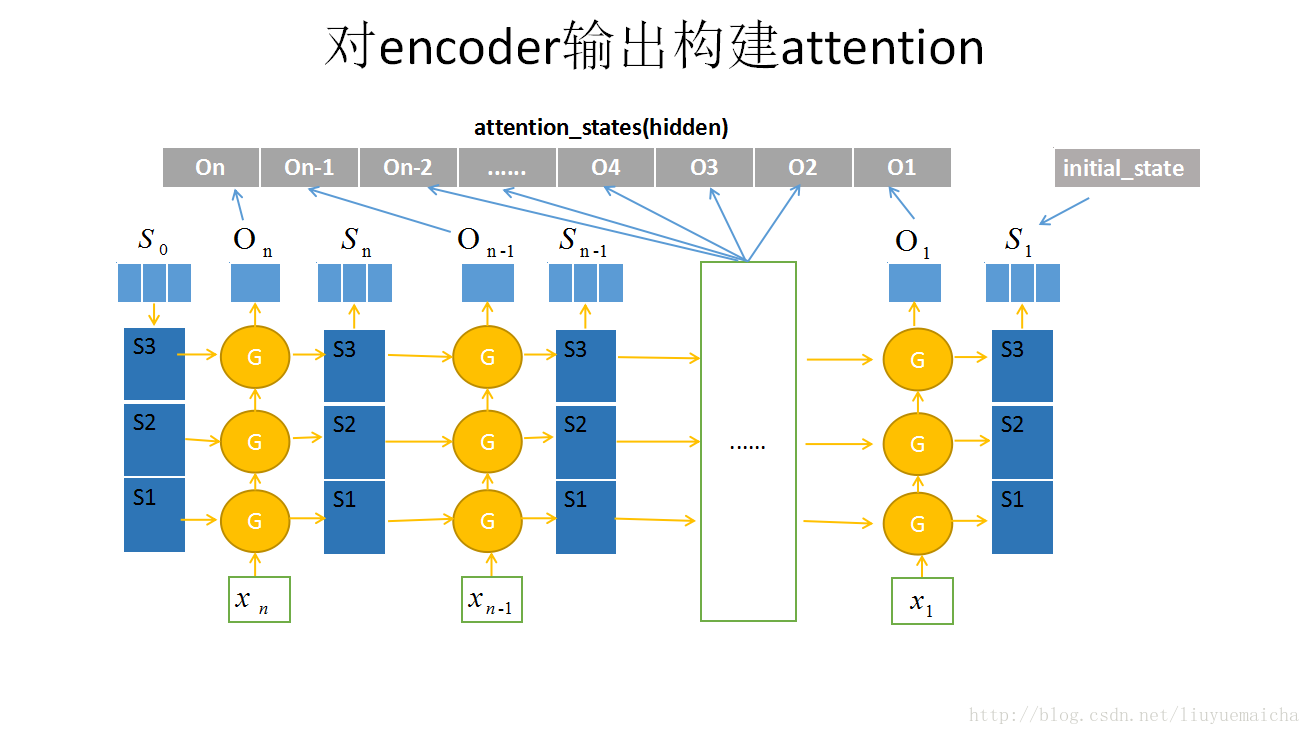

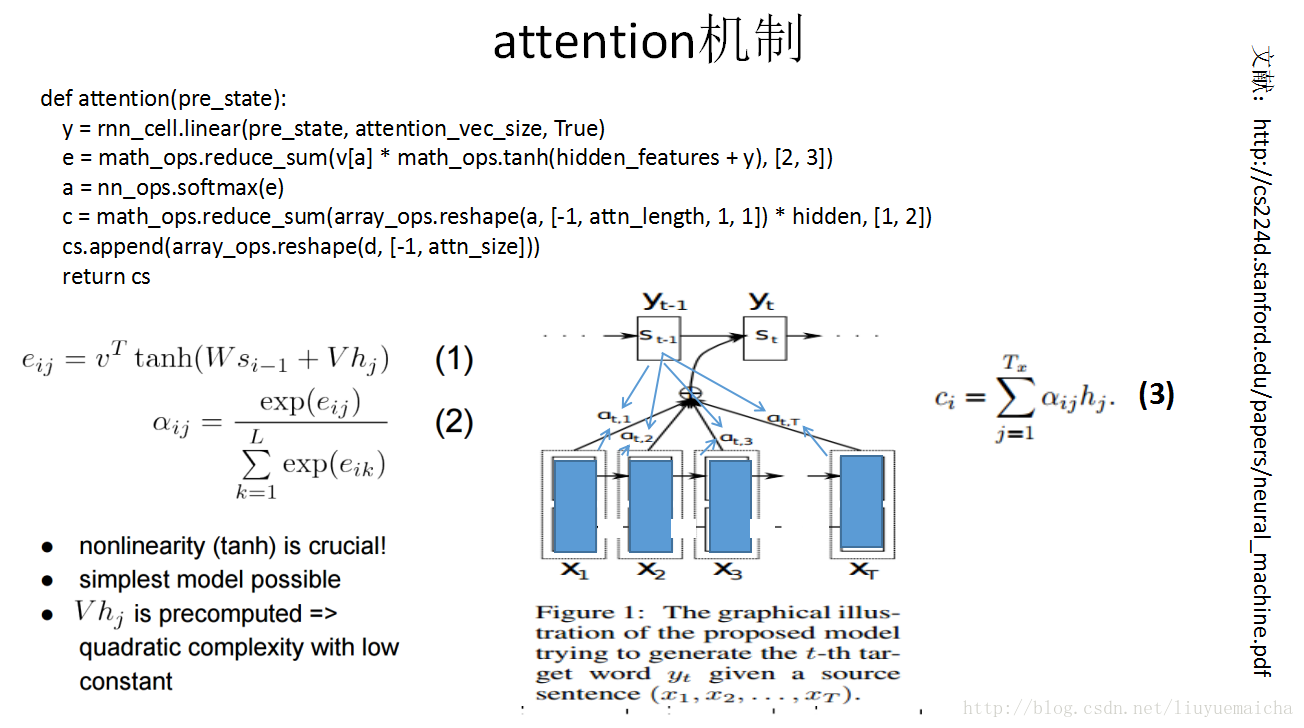

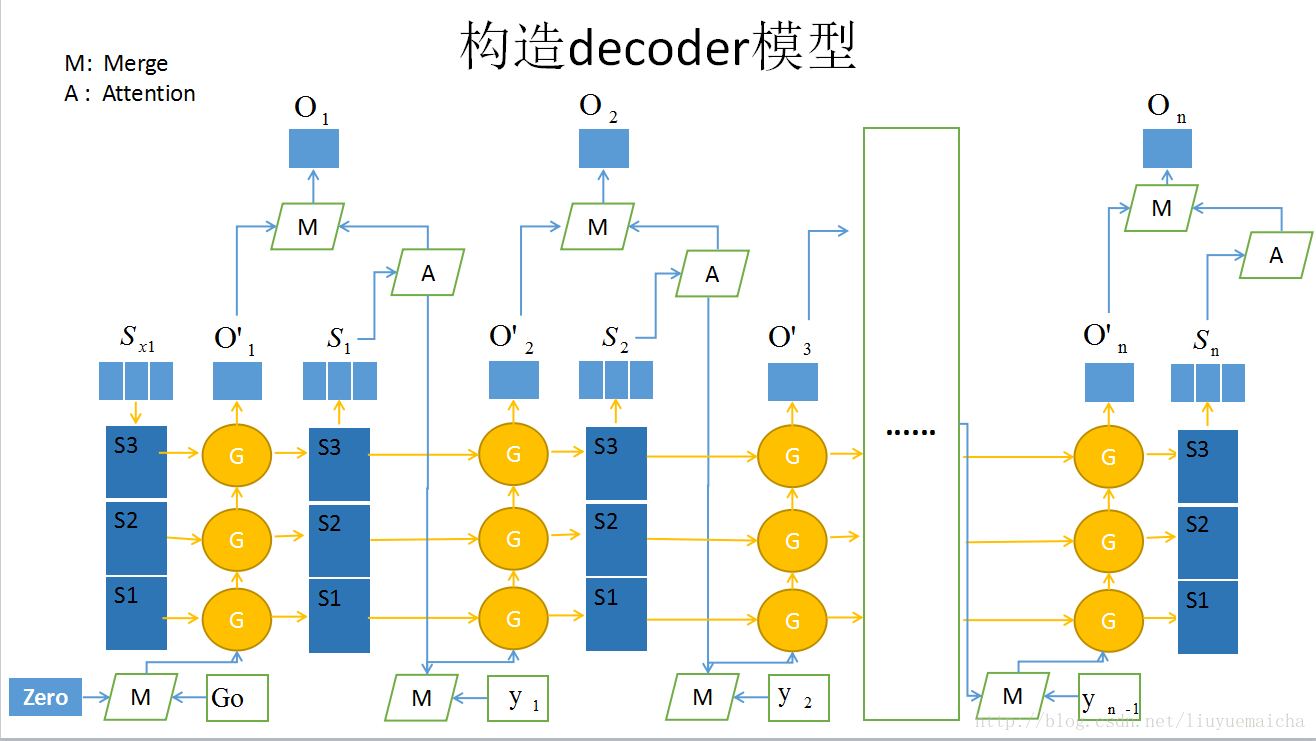

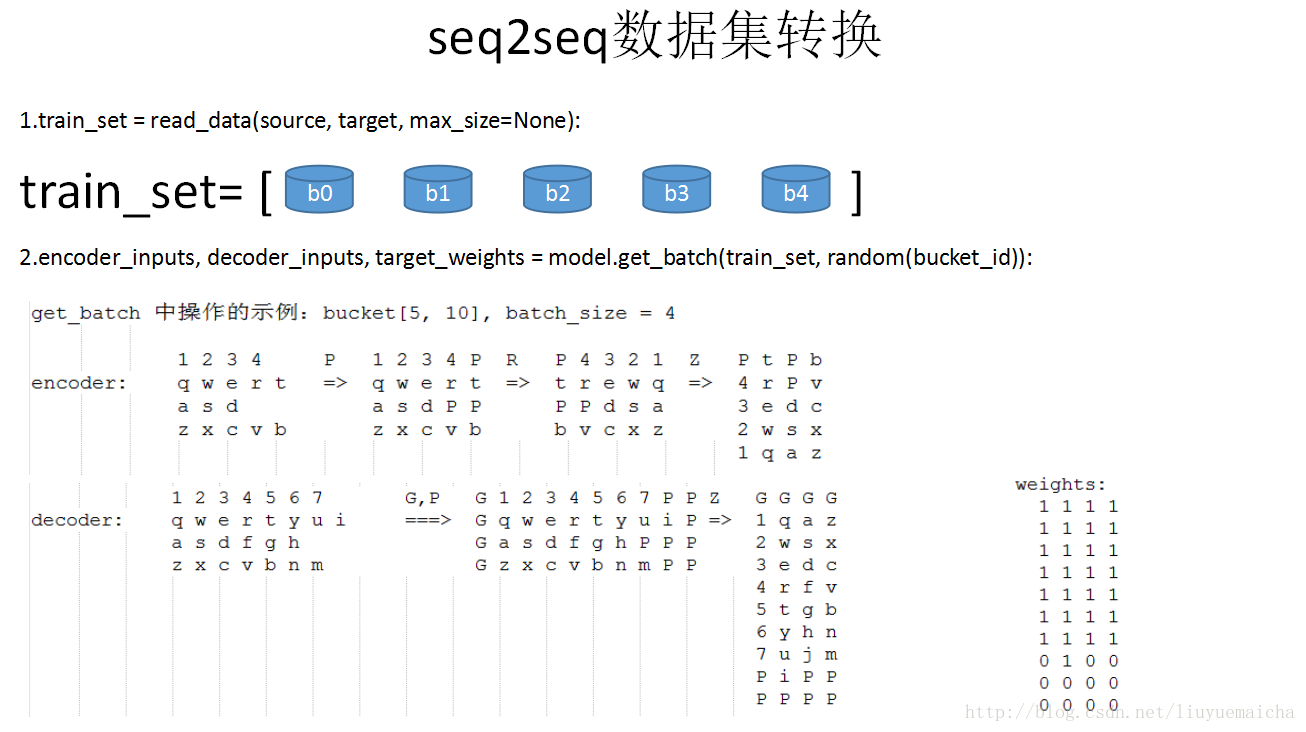

Tensor flow中自带的seq2seq,这么经典的encoder-decoder模型,网上都没有相关的详细介绍。花了一个星期的时间,整理了该模型的详细架构。感兴趣的可以看一下。后面抽时间再把代码注释一下,本博主从来不玩虚的,注释的会很详细,有打算入手的期待一下吧。^-^

这段时间一直忙着做Dialogue Generation相关的实验,刚刚入手,拿了tensorflow现有的seq2seq练练手。总结了下面几页PPT。分享出来,也算给自己做个公开云笔记。如有错误,也希望各路大牛能给指出!

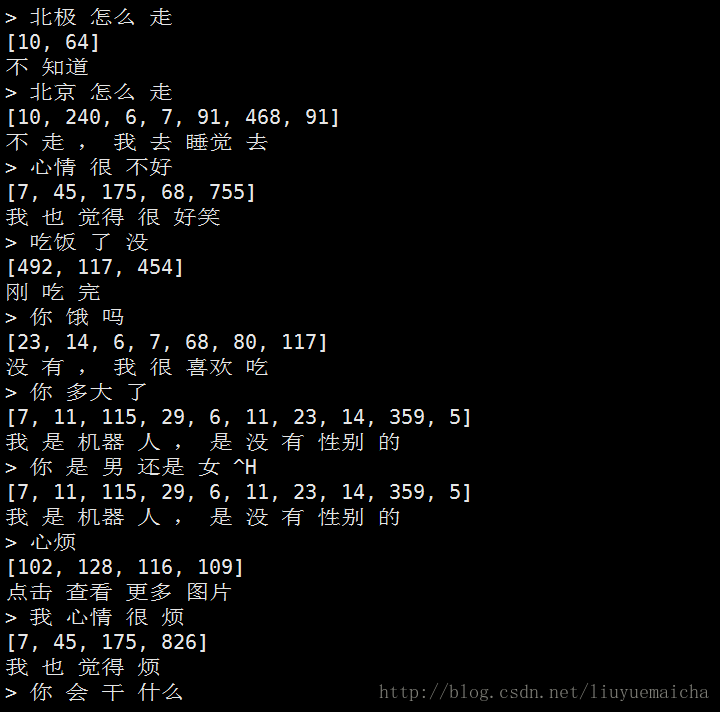

先看下测试效果吧:

PPT正文:

修正:倒数第二页PPT中,decoder的batch序列在最后一位还有结束标志位:EOS_ID(2). 即:decoder中有开始位:G,填充位PAD(0)和结束标志位EOS_ID(2).

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/你好赵伟/article/detail/687680

推荐阅读

相关标签