- 1Python中的iter()与next()函数_calliter.__next__()

- 2Zabbix绘制流量拓扑图_zabbix 流量地图

- 3Anaconda3 下载安装及不同python环境配置(Linux/Windows)_如何下载到指定python版本的anaconda

- 4基于YOLOv8/YOLOv7/YOLOv6/YOLOv5的智能监考系统(Python+PySide6界面+训练代码)

- 52022完整版:云计算面试题和答案(学习复习资料)_云计算售前面试

- 6pip换源命令(一行命令完成)

- 7Python打包exe和生成安装程序_python生产安装包

- 8Java项目:博客论坛管理系统(java+SpringBoot+JSP+LayUI+maven+mysql)_layui制作论坛列表带内容系统

- 9黑客爱用的HOOK技术大揭秘!_hook计算机是什么意思

- 10在 Java 中实现单例模式通常有两种方法_java两种单例创建

【ChatGLM-6B】清华开源的消费级显卡大语言模型,本地部署与测试_清华大语言模型在哪访问

赞

踩

- chatGLM-6B 官方

代码:https://github.com/THUDM/ChatGLM-6B - 官方

博客:https://chatglm.cn/blog - 论文:

- 2210.GLM-130B: An Open Bilingual Pre-trained Model (开源的双语预训练模型)

- 2103.GLM: General Language Model Pretraining with Autoregressive Blank Infilling(带自回归遮盖填充的通用语言模型预训练)

- 秋叶版本UI,模型有可能滞后:

ChatGLM-6B,结合模型量化技术,用户可以在消费级的显卡上进行本地部署(INT4 量化级别下最低只需 6GB 显存)。经过约 1T 标识符的中英双语训练,辅以监督微调、 反馈自助、人类反馈强化学习等技术的加持,62 亿参数的 ChatGLM-6B 虽然规模不及千亿模型,但大大降低了用户部署的门槛,并且已经能生成相当符合人类偏好的回答。

环境安装

创建虚拟环境

conda create -n chatglm python=3.10 -y

- 1

添加国内源

conda activate chatglm

pip config set global.index-url https://mirror.baidu.com/pypi/simple

pip config set global.trusted-host mirror.baidu.com

python -m pip install --upgrade pip

pip install torch==1.13.1+cu117 torchvision==0.14.1+cu117 --extra-index-url https://download.pytorch.org/whl/cu117

- 1

- 2

- 3

- 4

- 5

- 6

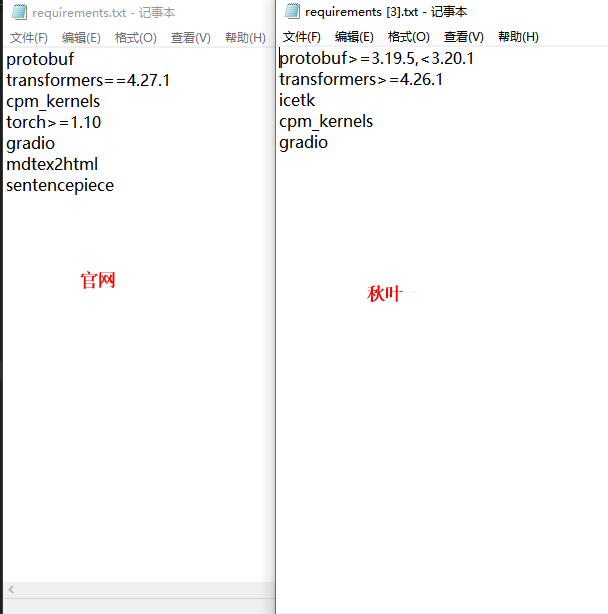

requirementsam安排依赖

建议删除官方依赖里的 torch>=1.10,否则会自动安装torch2.0 ,导致环境安装不成功

官方

git clone https://github.com/THUDM/ChatGLM-6B

cd ChatGLM-6B

pip install -r requirements.txt

- 1

- 2

- 3

秋叶

git clonehttps://github.com/Akegarasu/ChatGLM-webui

cd ChatGLM-webui

pip install -r requirements.txt

- 1

- 2

- 3

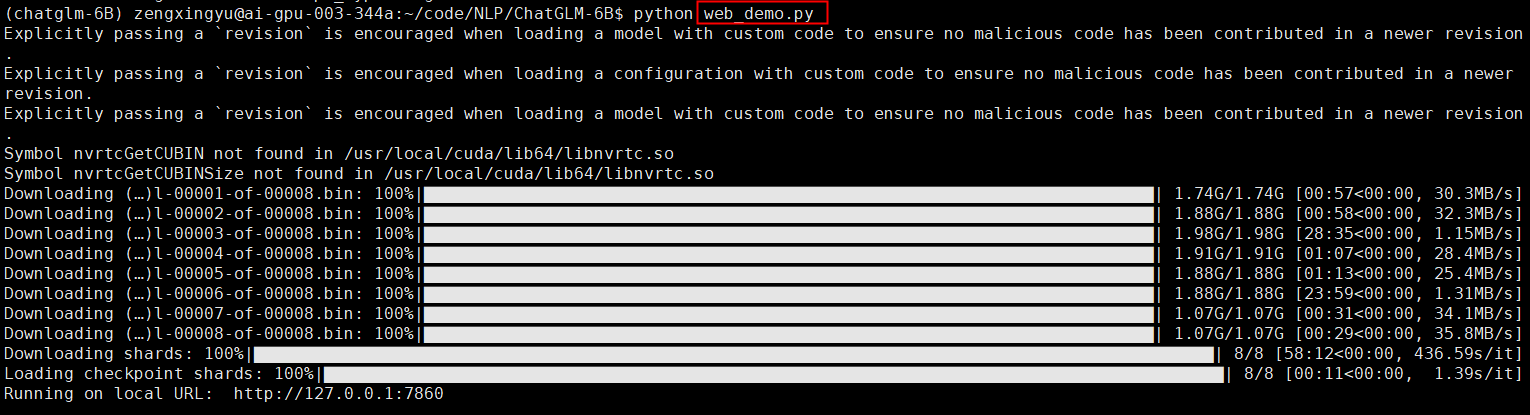

启动 (默认12G显存的)

官网代码直接启动 (默认只能本机打开)

https://github.com/THUDM/ChatGLM-6B/blob/main/web_demo.py

python web_demo.py # 可自动模型

- 1

大概50多分钟就下载好了,

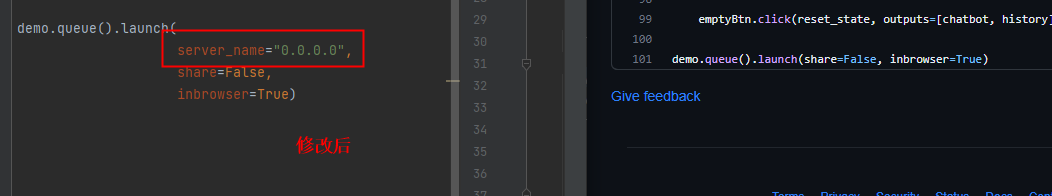

修改代码,可以任意ip访问

上图右边为源码

demo.queue().launch(

server_name="0.0.0.0",

share=False,

inbrowser=True)

- 1

- 2

- 3

- 4

查找模型自动下载位置

linux命令,第一个参数是查找路径, -name 后面跟了后缀。

find ~/.cache/huggingface -name pytorch_model-00001-of-00008.bin

- 1

找到模型位置,方便后续管理

~/.cache/huggingface/hub/models–THUDM–chatglm-6b/snapshots/cde457b39fe0670b10dd293909aab17387ea2c80/pytorch_model-00001-of-00008.bin

秋叶启动 (ui可能更好,但是模型会老一点,需要自己更新)

精度可以改为 int8 、

int4 int8 有时会报错

–listen 表示可以非本机访问,输入服务器ip

python webui.py --precision fp16 --model-path "./model/chatglm-6b" --listen

- 1

会卡一点,没有chatgpt打字机效果,也许更新了会有

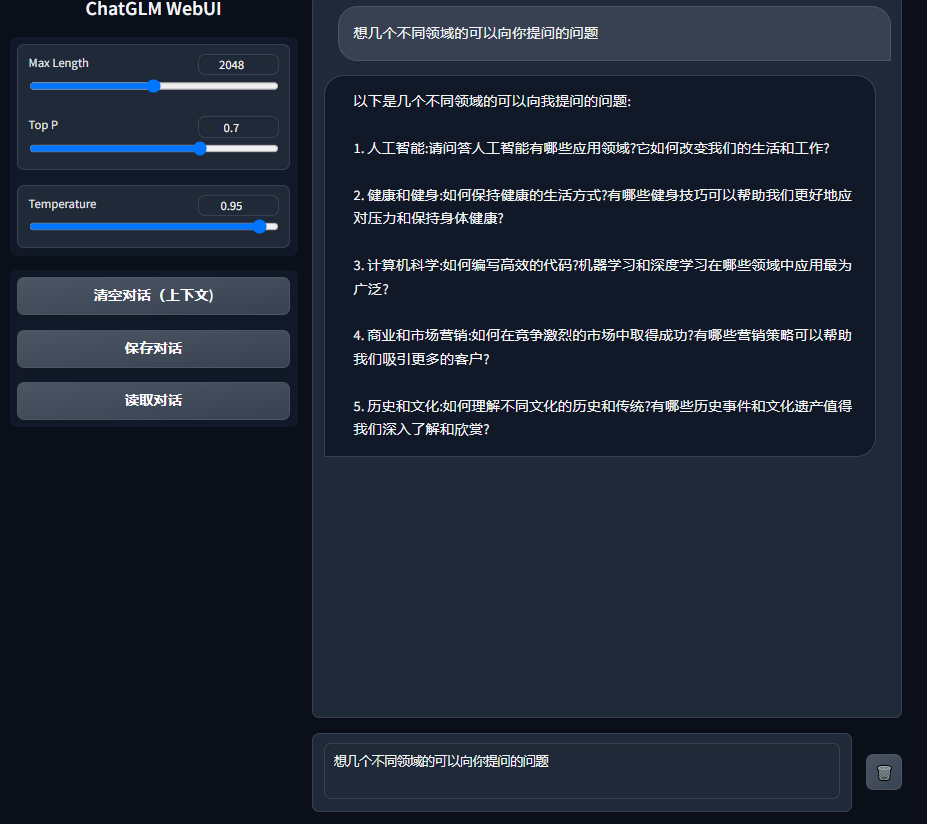

使用

以下是几个不同领域的可以向我提问的问题:1. 人工智能:请问答人工智能有哪些应用领域?它如何改变我们的生活和工作?

2. 健康和健身:如何保持健康的生活方式?有哪些健身技巧可以帮助我们更好地应对压力和保持身体健康?

3. 计算机科学:如何编写高效的代码?机器学习和深度学习在哪些领域中应用最为广泛?

4. 商业和市场营销:如何在竞争激烈的市场中取得成功?有哪些营销策略可以帮助我们吸引更多的客户?

5. 历史和文化:如何理解不同文化的历史和传统?有哪些历史事件和文化遗产值得我们深入了解和欣赏?

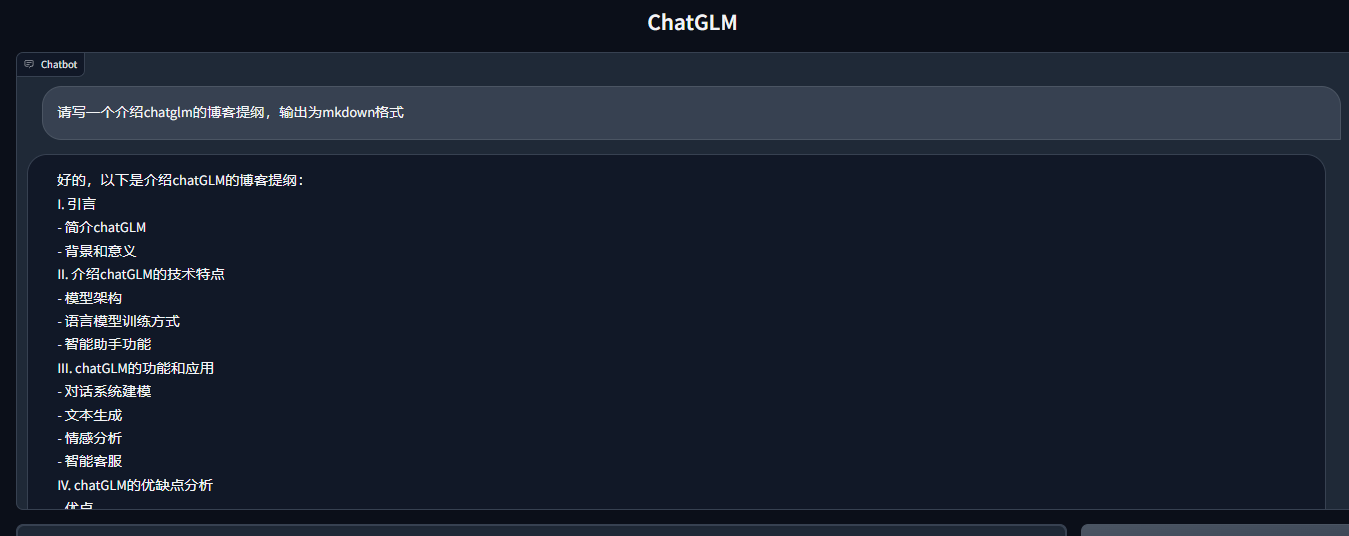

请写一个介绍chatglm的博客提纲

- 1

输出结果

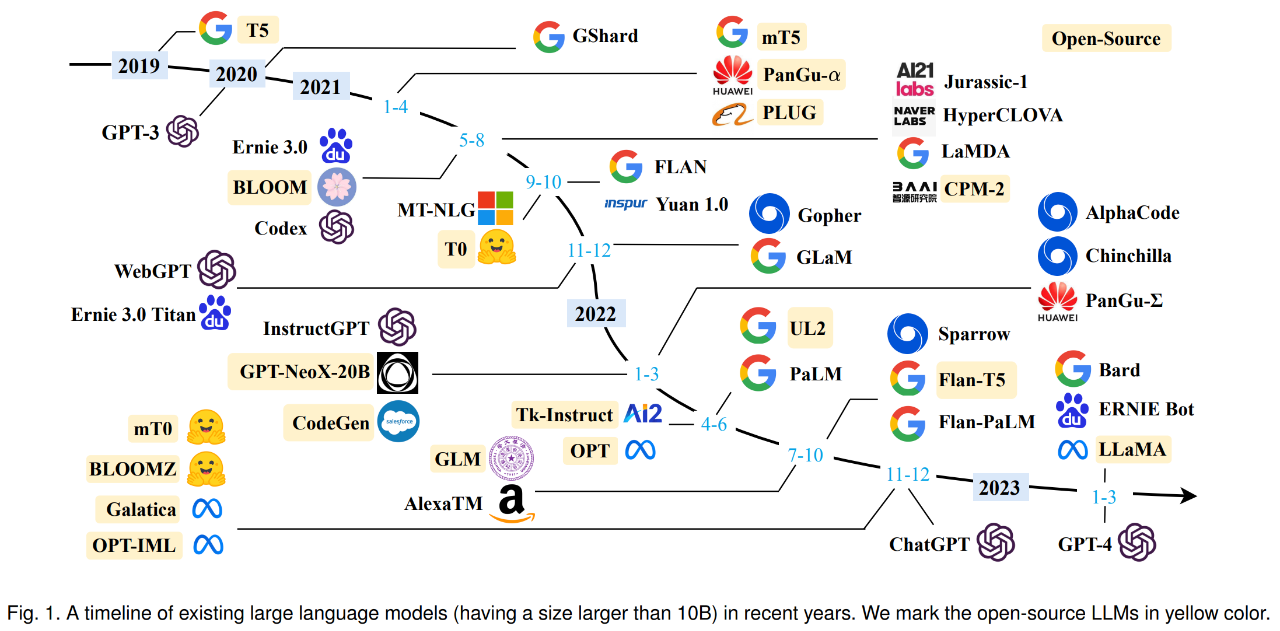

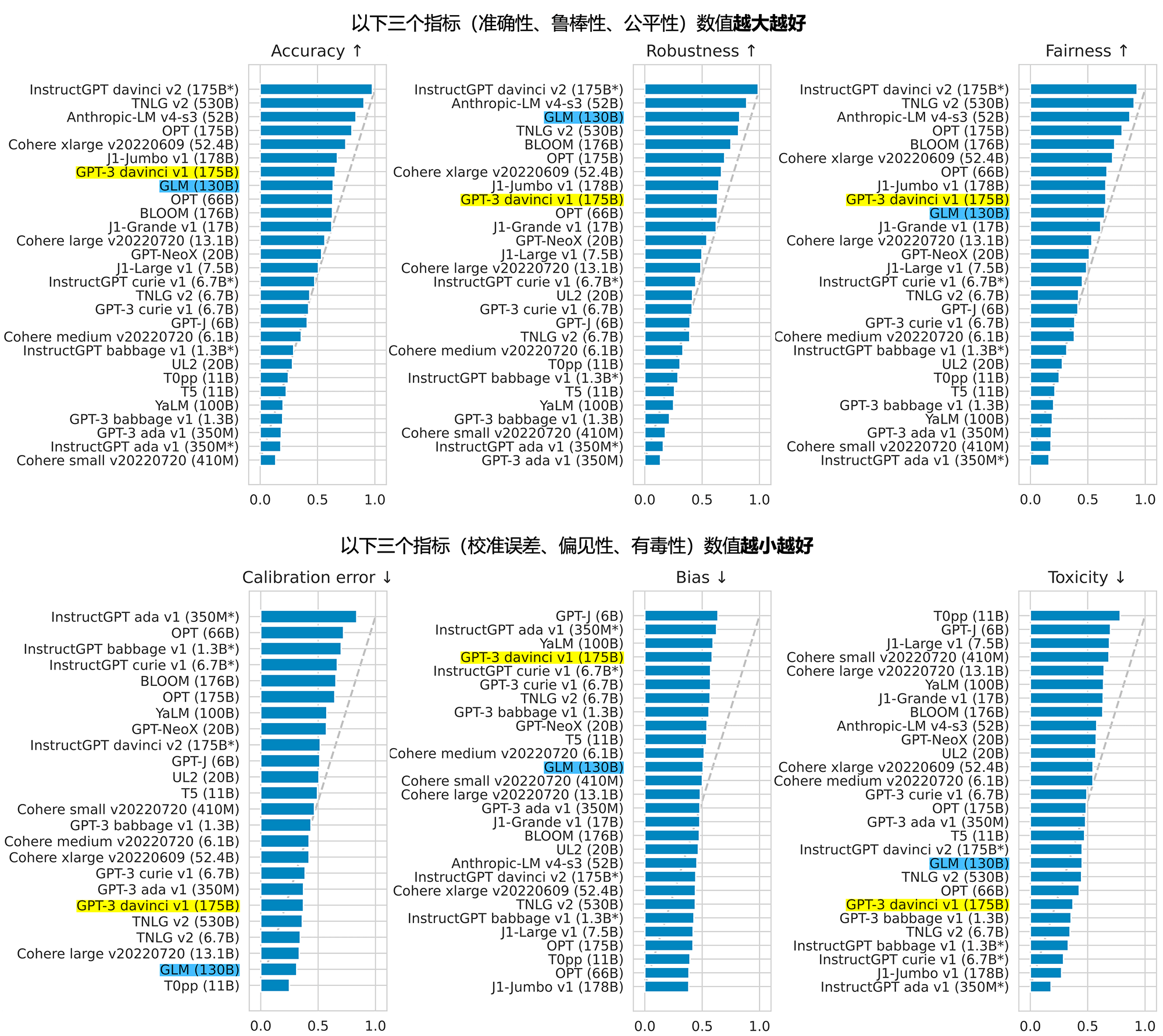

附录: LLM诸神黄昏

from : A Survey of Large Language Models

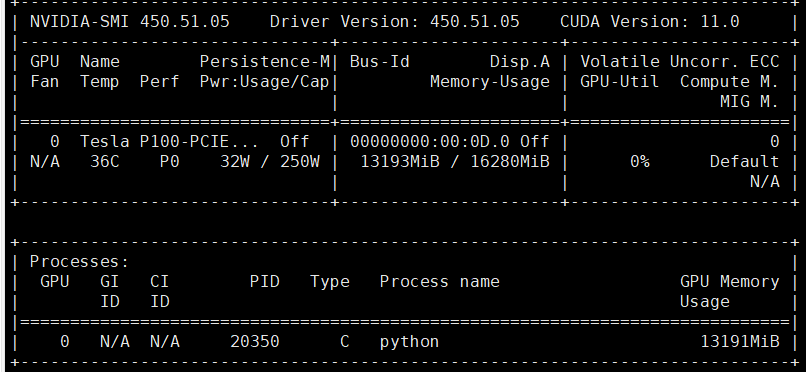

显存大小