热门标签

热门文章

- 1因为启动模拟器之类导致adb devices多了一台设备,导致给设备安装时报错:adb.exe: more than one device/emulator

- 2Swift 中的 Actors 使用以及如何防止数据竞争_swift actor

- 3wget 命令实用

- 42022华为软挑比赛(初赛笔记)_华为软挑入门

- 5微信小程序如何插入广告_微信小程序怎么挂广告

- 6QML 布局

- 7mac u盘无法写入_在MacOS系统中,怎么读取U盘的好方法

- 8真机调试鸿蒙HarmonyOS应用步骤(超详细!!!)_鸿蒙 project signing configs

- 9ubuntu root 如何启用,以及解决root下声卡没声音问题_为啥root用户下 看不到声音输出设备

- 10SpringBoot利用Actuator来监控应用的方法_templated:false

当前位置: article > 正文

支持向量机基础简述_支持向量机是基于经验风险最小化原则构造的,因此有更好的泛华性能

作者:凡人多烦事01 | 2024-04-02 10:53:41

赞

踩

支持向量机是基于经验风险最小化原则构造的,因此有更好的泛华性能

学习笔记来自《知识发现》—史忠植

支持向量机(support vector machine,SVM)建立在学习理论的结构风险最小化原则之上。

主要思想:针对两分类问题,在高位空间中寻找一个超平面作为两类的分割,以保>证最小的分类错误率。

优点:SVM可以处理 线性不可分 情况。

1.统计学习问题

1.1 经验风险

机器学习问题就是根据 l 个独立同分布的观测样本

传统学习方法中,采用经验风险最小化(empririal risk minimization,ERM)准则,即用样本定义 、经验风险:

机器学习就是要设计学习算法使

1.2 VC维

模式识别中,VC维:对一个指示函数集,如果存在 h个样本能够被函数集里的函数按照所有可能的

2h 中形式分开,则称函数集能够把h个样本打散。函数集里的VC维就是它能打散的最大样本数目h。

有界实函数的VC维可以通过用一定的阈值将他转化成指示函数来定义

2.支持向量机

2.1 线性可分

假设存在训练样本

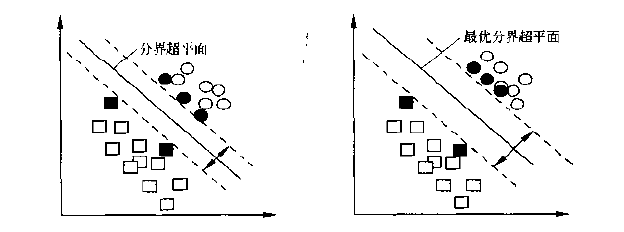

如果训练数据可以无误差地被划分,以及每一类数据与超平面距离最近的向量与超平面之间的距离最大,则称这个超平面为最优超平面

经过变换线性可分条件下的原问题成为对偶问题,求解下式的极大化

选用一个支持向量样本

2.2 线性不可分

线性可分的判别函数建立在欧式距离的基础上,即有

![输入空间到特征空间的映射][2]

图2.2输入空间到特征空间的映射 如果以特征向量

Φ(x) 代替输入向量

x ,则由式(2.1.10)和式(2.1.13)可知Dij=yiyjΦ(xi)⋅Φ(xj)(2.2.2)

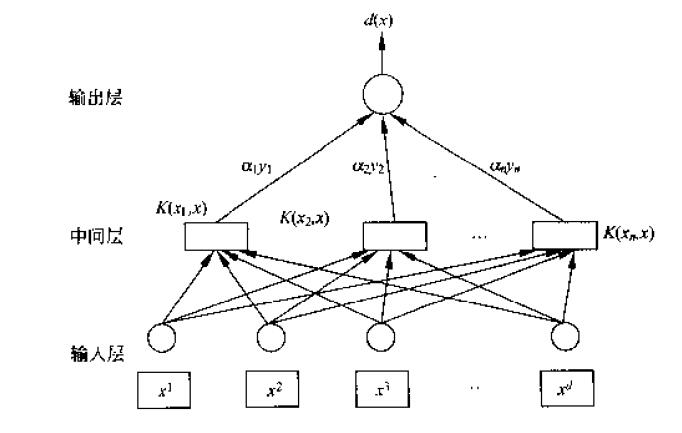

d(x)=Φ(x)⋅w∗+b=∑i=1lαiyiΦ(xi)⋅Φ(x)+b∗(2.2.3) 不论是寻优函数式(2.1.8)还是分类函数式(2.1.13)都只涉及训练样本之间的内积

(xi⋅xj) .*根据泛函数相关理论,只要一种核函数

K(xi⋅xj) 满足Mercer条件,它就对应某一空间中的内积。* 在最优分类面中采用适当的内积函数

K(xi⋅xj) 就可实现某一非线性变换后的线性分类,而计算复杂度却没增加,那么式(2.1.8)可变为

则对应的分类函数为

这就是支持向量机。

对给定的

构造类型判定函数的学习机称为支持向量机,在支持向量机中构造的复杂性取决于支持向量机的数目,而不是特征空间的维数。示意图如图2.3.

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/凡人多烦事01/article/detail/351951

推荐阅读

相关标签