热门标签

热门文章

- 1JDK+hadoop+spark快速安装指南

- 2HBase的数据热点和Hbase常见避免热点问题的方法_什么是hbase中的热点及如何避免热点

- 3记一次解决MQTT软件包内存泄露的心路历程_kawaii-mqtt

- 4Git工作流指南:Pull Request工作流_bitbucket 发起git pull request

- 5esp8266-12f介绍与使用_esp12f

- 6死磕GMSSL通信-java/Netty系列(二)_java集成gmssl

- 7华为机考入门python3--(15)牛客15-求int型正整数在内存中存储时1的个数

- 8微信小程序展示倒计时

- 9Kali linux零基础学习教程(从下载、安装、汉化到使用)全套教程开源分享_kali linux 新手教程

- 10算法入门教程(一、模拟)_模拟算法

当前位置: article > 正文

使用Ollama实现本地部署大模型

作者:凡人多烦事01 | 2024-04-21 09:43:10

赞

踩

ollama

打开Ollama的官网,整个网页上就只有一句显眼的话:Get up and running with large language models, locally. 中文意思是:在本地快速上手并运行大型语言模型。

1 什么是 Ollama?

Ollama 是一种假设存在的本地大模型运行框架,允许用户在自己的硬件环境中轻松部署和使用大规模预训练模型。

1.1 Ollama 特性概览:

- 易用性与广泛支持:

Ollama具有良好的生态支持,可以兼容不同架构的大语言模型,截至今天(2024年3月20日),Ollama官网上公开支持的大模型就有70个之多。 - 量化与推理能力:

提供了对模型的量化和推理优化能力,这使得模型能够在有限计算资源下进行高效推理,并且能够近乎无缝地迁移至相同架构的开源大模型上。 - 安全、快速、稳定的服务:

使用Ollama,个人开发者或企业可以在不依赖云端的情况下,在本地设备上实现大模型的服务化,从而满足隐私保护、实时响应或其他特定需求。

1.2 Ollama 资源网址

官网:https://ollama.com/

Gtihub:https://github.com/ollama/ollama

2 安装 Ollama

访问 Ollama 下载地址:https://ollama.com/download

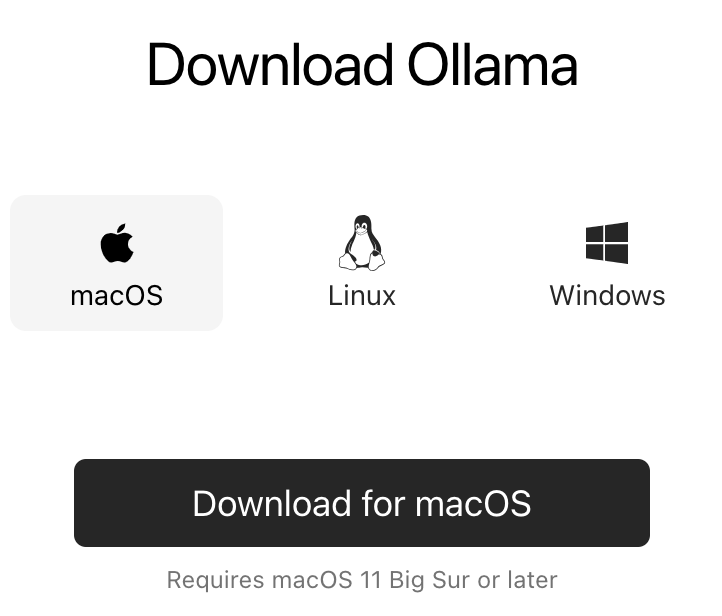

1)macOS 版本

注意上图底部的 macOS 版本,请检查是否具备安装要求。

点击下方的“Download for macOS”按钮,下载安装文件的zip压缩包。打开解压缩后生成的文件 ollama.app,直接执行即可完成安装并运行。在终端窗口里输入:

ollama --version

- 1

返回版本信息即表示安装完成并正在运行。

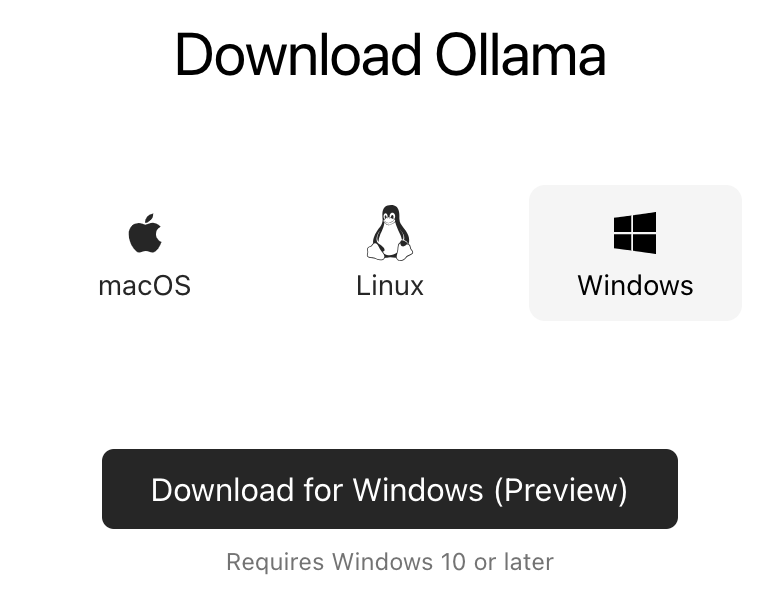

2) Windows 版本

请注意,目前 Windows 版本为预览版,切要求系统为 Windows 10 以上。

点击下方的“Download for Windows(preview)”按钮,下载 .exe 可执行安装文件。

执行下载的文件,安装过程中杀毒软件提示有病毒,关闭杀毒软件,或者将提示的执行文件加入信任白名单,即可完成安装和运行。

打开 cmd 窗口,在命令行输入执行:

ollama --version

- 1

如果返回版本信息,即表示安装成功!

3 使用 Ollama

Windows 和 macOS 在使用上几乎没有区别。访问 Ollama 官网,列举了很多大模型,我们可以从中找一个模型进行测试:

在首页右侧点击 Models 连接,可以看到列举的可以使用的大模型,当然也可以通过其左边的搜索框进行搜索。

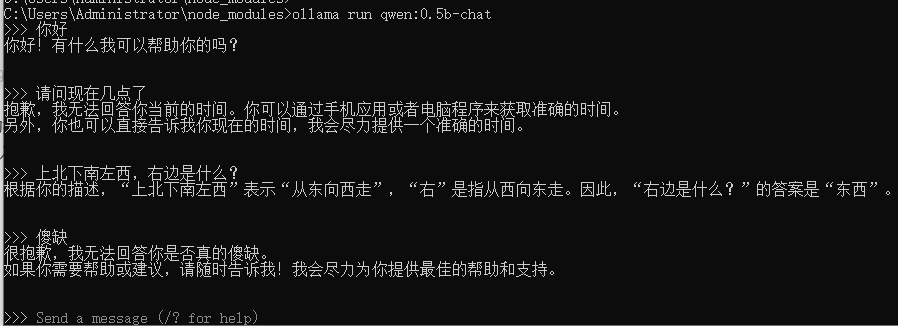

找个参数少一点的模型先测试一下,就下载“通义千问”的 qwen:0.5b-chat 模型,在 cmd 里输入下面的命令:

ollama pull qwen:0.5b-chat

- 1

下载完成后,运行此模型,在 cmd 中输入下面的命令:

ollama run qwen:0.5b-chat

- 1

简单测试一些,可以运行了:

0.5b 的参数,效果也确实只能呵呵了。看到现在,您应该也会了,你可以下个 qwen:1.8b-fp16 或 gemma:2b 试试。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/凡人多烦事01/article/detail/462328

推荐阅读

相关标签