热门标签

热门文章

- 1正确解决JedisDataException: ERR Client sent AUTH, but no password is set异常的有效解决方法

- 2RK3568笔记二十五:RetinaFace人脸检测训练部署

- 3inline的作用_inline函数的作用

- 4简单前后端分离的token验证流程_tooken后端代码

- 5Vue3框架在大规模应用中的性能优化策略_[1] 石冠洲.基于vue的web系统前端性能优化研究与应用[d].长安大学,2020

- 6【转】一次HBase问题的解决过程(Status: INCONSISTENT)

- 7Mysql5.7与8.0版本不兼容问题_mysql5.7和8.0兼容吗

- 8Python3 错误和异常 | 菜鸟教程(十五)_python3 try

- 9互联网面试题集_mycat 、360的atlas、网易的ddb

- 10TCL - 库编译过程和官方手册_windows tcl编译

当前位置: article > 正文

NLP中的Transformer 简介_transformer在nlp中的任务类型

作者:凡人多烦事01 | 2024-05-29 20:01:16

赞

踩

transformer在nlp中的任务类型

作者|Renu Khandelwal 编译|VK 来源|Towards Data Science

在这篇文章中,我们将讨论以下有关Transformer的问题

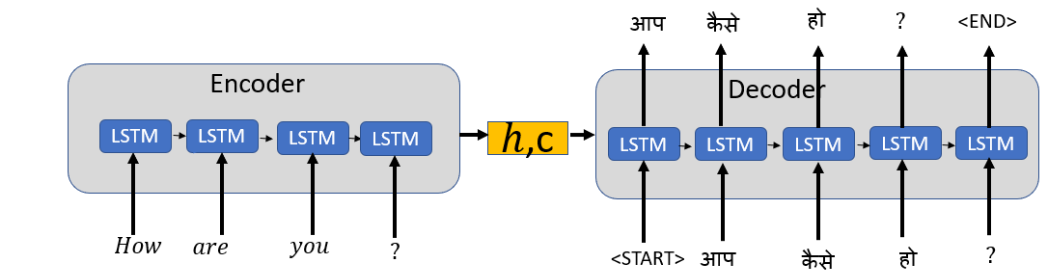

- 为什么我们需要Transformer,Sequence2Sequence模型的挑战是什么?

- 详细介绍了Transformer及其架构

- 深入研究Transformer中使用的术语,如位置编码、自注意力、多头注意力、掩码多头注意力

- 可以使用Transformer的NLP任务

Sequence2Sequence (Seq2Seq)的缺点

- 顺序计算:在Seq2Seq中,我们以顺序的方式在每个步骤中向编码器输入一个单词,以便在解码器中每次生成一个单词的输出。在Seq2Seq架构中我们做不到通过并行化操作来提高计算效率。

- 长期依赖关系:长期依赖关系是Seq2Seq的一个问题,这是由于需要为长句执行大量操作造成的,如下所示。

这里的“it”指的是“Coronavirus”还是“countries”?。

让我们深入了解Transformer的体系结构和Transformer的关键概念,以了解Transformer如何应对这些挑战

Tr

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/凡人多烦事01/article/detail/643752

推荐阅读

相关标签