- 1RabbitMQ死信延时队列阻塞问题_rabbitmq延迟队列阻塞

- 2C++练习题(附答案)

- 3秒杀项目常见面试题

- 4OptaPlanner Spring Boot Java快速启动

- 5最新最全论文合集——数据库与人工智能_ai db

- 6nlp-tutorial代码注释3-2,LSTM简介

- 7Ubuntu 23.04安装最新版本Halcon 23.05_halcon ubuntu

- 810行python代码实现动物识别(百度API方式)_人工智能动物识别代码

- 9[转]System Verilog的概念以及与verilog的对比

- 10神器 SpringDoc 横空出世!最适合 SpringBoot 的API文档工具来了!_springboot apidoc

6D姿态估计算法汇总(下)_6d姿态估计算法汇总下

赞

踩

前言

接着上篇6D姿态估计算法汇总(上),原文请见6D姿态估计算法汇总(下)

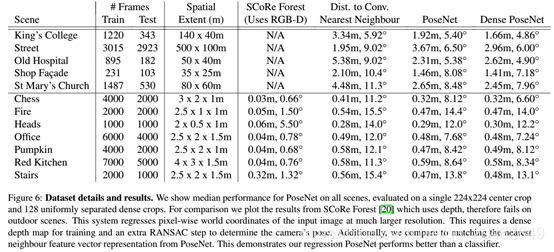

10、PoseNet: A Convolutional Network for Real-Time 6-DOF Camera Relocalization

论文链接:https://arxiv.org/abs/1505.07427

代码链接:http://mi.eng.cam.ac.uk/projects/relocalisation/

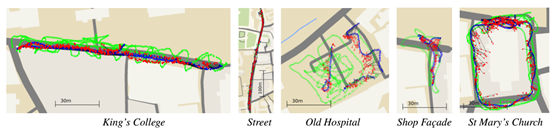

主要思想:本文提出了一个鲁棒且可以实时运行的重定位系统,该系统利用一个CNN实现了输入为RGB图像输出为相机位姿的端到端定位系统。该系统在室内和室外都能够以每帧5ms的计算速度实时运行。其在室外场景的定位精度为2m&3°,在室内场景的定位精度为0.5m&5°。除此之外,提出了23层深度卷积网络PoseNet,利用迁移学习将分类问题的数据库用于解决复杂的图像回归问题。其训练得到的特征相较于传统局部视觉特征,对不同的光照、运动模糊以及不同的相机内参等具有更强的鲁棒性。同时,该论文展示了PoseNet基于已有的分类数据库可以在很少训练样本的情况下取得很好的性能。

主要贡献:

1、提出了一种自动标注方法,利用SfM自动生成训练样本的标注(相机位姿),可以仅利用视频生曾用于训练PoseNet的训练样本和标注,不需要人工标注每一幅图像的位姿信息,极大地节约了人力成本。

2、提出迁移学习,利用训练好的分类器(classifier)以及少量的训练样本训练得到用于重定位的回归器(regressor),可以有效解决训练样本不足的问题。

实验结果:

11、6-PACK: Category-level 6D Pose Tracker with Anchor-Based Keypoints

论文链接:https://arxiv.org/abs/1910.10750v1

代码链接:https://sites.google.com/view/6packtracking

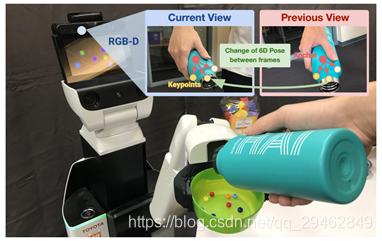

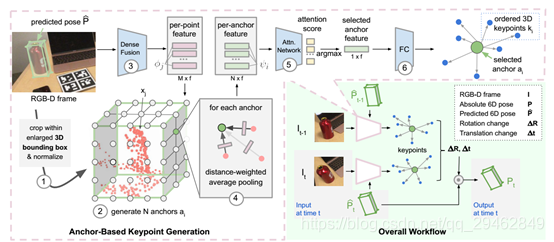

主要思想:本文提出了一种基于RGB-D数据的类别级6D目标姿态跟踪的深度学习方法-6-PACK算法。论文中的方法可以实时跟踪已知对象类别(如碗、笔记本电脑和杯子)的新对象实例。6-PACK学习通过少量的3D关键点来紧凑地表示对象,在此基础上通过关键点匹配来估计对象实例的帧间运动。这些关键点在没有人工监控的情况下端到端学习,以便最有效地跟踪。实验表明,这种方法大大优于现有方法上的NOCS类别6D姿态估计基准,并支持物理机器人执行简单的基于视觉的闭锁循环操作任务。

主要贡献:

1、这种方法不需要已知的三维模型。相反,它避免了通过类似于2D对象检测中使用的proposals方法的新anchor机制来定义和估计绝对6D姿势的需要。

2、这些anchor为生成三维关键点提供了基础。与以往需要手动标注关键点的方法不同,提出了一种无监督学习方法,该方法可以发现用于跟踪的最佳三维关键点集。

3、这些关键点用作对象的紧凑表示,从中可以有效地估计两个相邻帧之间的姿态差。这种基于关键点的表示方法可以实现鲁棒的实时6D姿态跟踪。

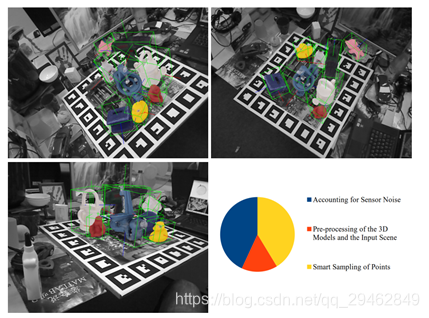

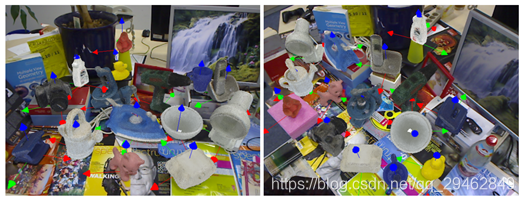

实验结果:

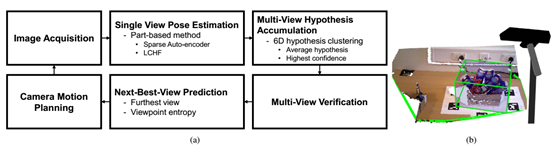

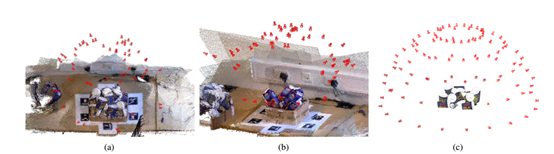

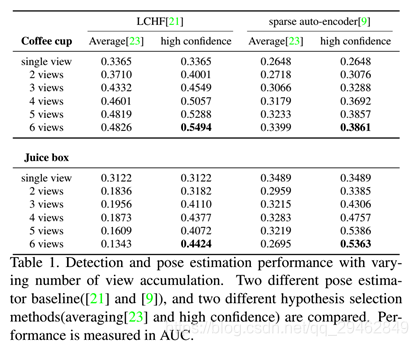

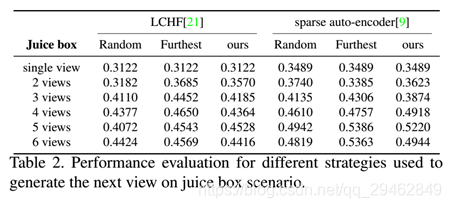

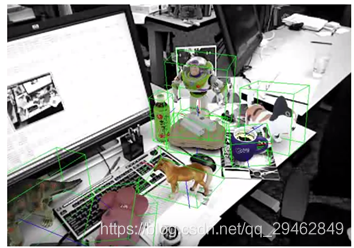

12、Multi-view 6D Object Pose Estimation and Camera Motion Planning using RGBD Images

论文链接:https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=8265470

主要思想:在主动场景中,当观察者无法从当前视点恢复目标的姿态时,观察者可以确定下一个视点的位置,并从另一个视点捕获新的场景,以提高对环境的认识,从而降低6D姿态估计的不确定性。我们提出了一个完整的主动多视图框架来识别拥挤场景中多个物体实例的6自由度姿态。我们在主动视觉设置中加入了几个部分以提高准确性:假设积累和验证结合了先前观点估计的基于单镜头的假设,并提取了最可能的假设集;基于熵的次优视角预测生成下一个摄像机位置以捕获新数据以提高性能;摄像机运动规划基于视角熵和运动代价规划摄像机的运动轨迹。对每个组件的不同方法进行了实现和评估,以显示性能的提高。

主要贡献:

我们的贡献是:

1、集成不同的组件,建立一个完整的主动系统,对多个目标进行检测和姿态估计。

2、无监督下一个最佳视图(NBV)预测算法,通过基于当前对象假设的场景渲染来预测下一个最佳摄像机姿态,用于目标检测和姿态估计。

3、使用物理引擎生成具有真实多对象配置的合成数据集。

实验结果:

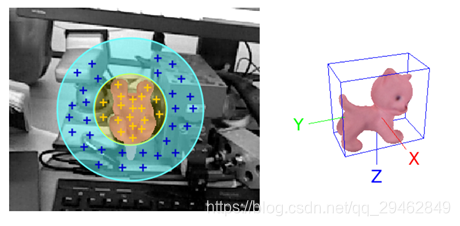

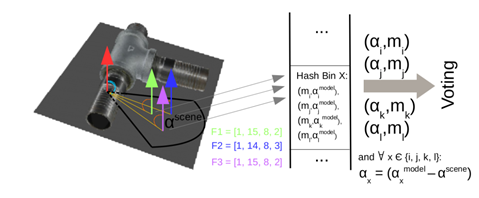

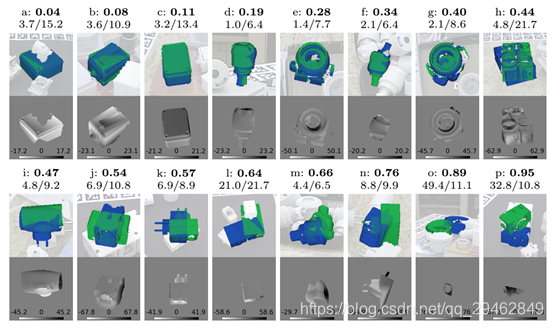

13、Going further with point pair features

论文链接:http://arxiv.org/abs/1711.04061

主要思想:点对特征是一种广泛应用的点云三维目标检测方法,但在存在传感器噪声和背景杂波的情况下容易失效。我们引入了新的采样和投票方案,大大减少了杂波和传感器噪声的影响。实验表明,随着我们的改进,PPF变得比最先进的方法更具竞争力,因为它在一些具有挑战性的基准测试对象上的性能优于它们,而且计算成本较低。

主要贡献:

提出了一种更好、更有效的抽样策略,加上对前处理和后处理步骤的小修改,使得文中的方法与最先进的方法相比具有竞争力:它以较低的计算成本,在最近具有挑战性的数据集上击败了它们。

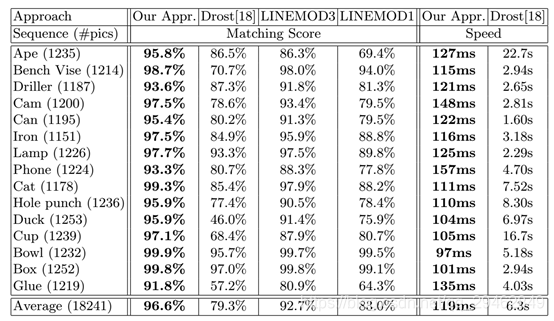

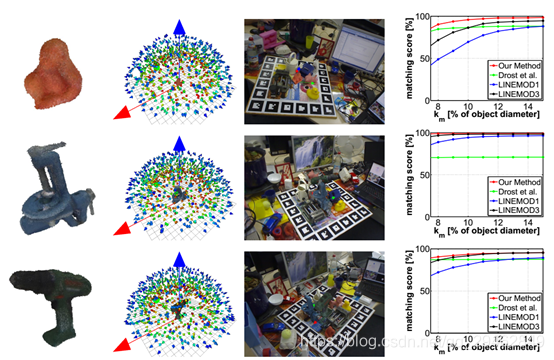

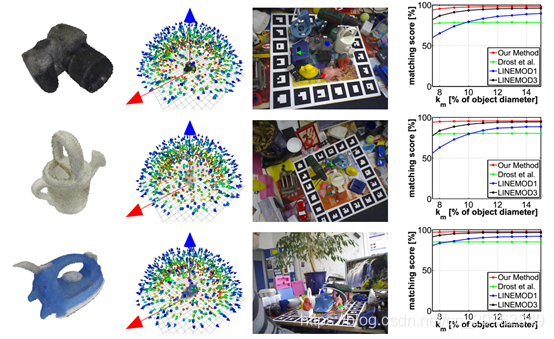

实验结果:

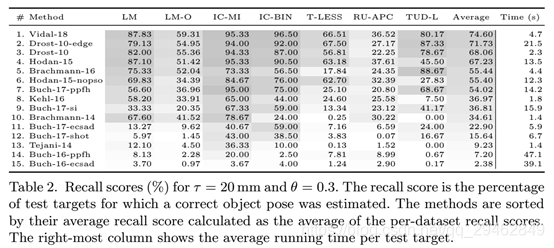

14、BOP: Benchmark for 6D Object Pose Estimation

论文链接:https://arxiv.org/abs/1808.08319

代码链接:https://bop.felk.cvut.cz/home/

主要思想:提出了一种基于单RGB-D输入图像的刚体6D姿态估计基准。训练数据由一个纹理映射的三维物体模型或已知6D姿势的物体图像组成。该基准包括:i)8个统一格式的数据集,涵盖不同的实际情况,包括两个新的数据集,侧重于不同的照明条件;ii)一个具有姿势误差函数的评估方法,处理姿势模糊性,iii)对15种不同的近期方法进行综合评估,以了解该领域的现状;iv)一个在线评估系统,可随时提交新的结果。评估结果表明,基于点对特征的方法目前表现最好,优于模板匹配方法、基于学习的方法和基于三维局部特征的方法。

实验结果:

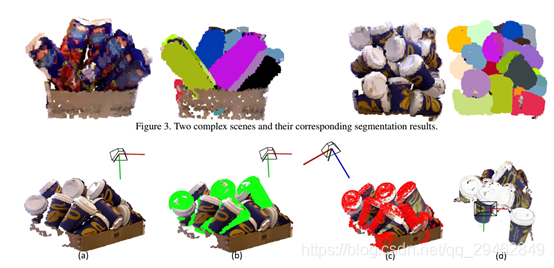

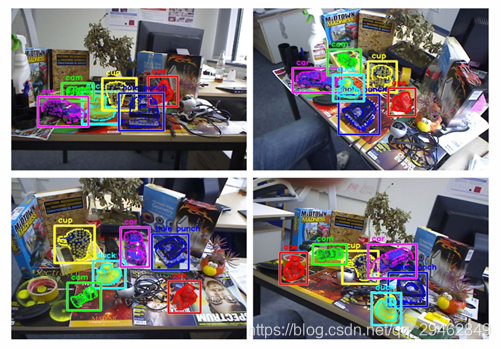

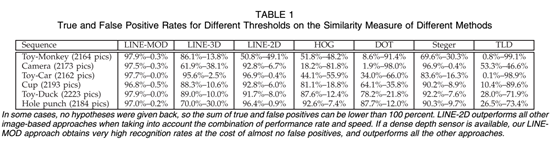

15、 Multimodal Templates for Real-Time Detection of Texture-less Objects in Heavily Cluttered Scenes (ICCV), 2011.

论文链接:http://ieeexplore.ieee.org/xpls/abs_all.jsp?arnumber=6126326

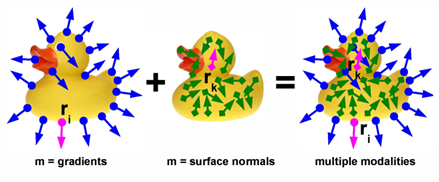

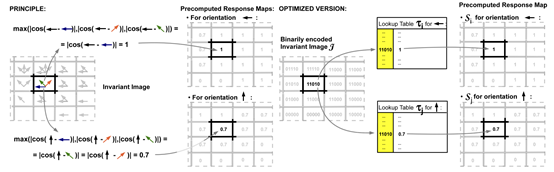

主要思想:提出了一种多模式检测三维物体的方法。虽然它是通用的,但论文将它演示在图像和提供互补对象信息的稠密深度图的组合上。这种方法可以实时工作,在繁杂的杂波环境下,不需要耗时的三位一体阶段,并且可以处理不受约束的对象。论文基于对捕获不同模式的模板的有效表示,并且在商品硬件上的许多实验中表明,该方法显著地超过了单模式的最新方法。

主要贡献:

1、提出一种有效的方法,同时利用多个采集模式的信息来定义一个模板,从而在复杂的环境中可靠地检测已知对象。

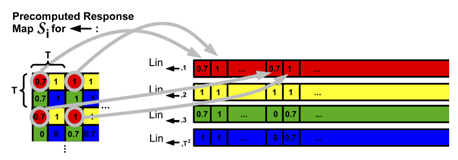

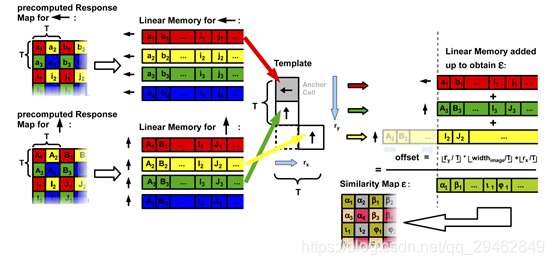

2、每个模态的数据被离散到存储箱中,使用 “线性化响应图”来最小化缓存未命中并允许大量并行化。

3、重点研究了彩色图像和稠密深度图的结合。

4、方法是非常通用的,可以很容易地整合其他模式,只要提供的测量与图像可以量化对齐。

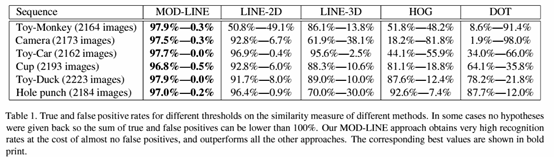

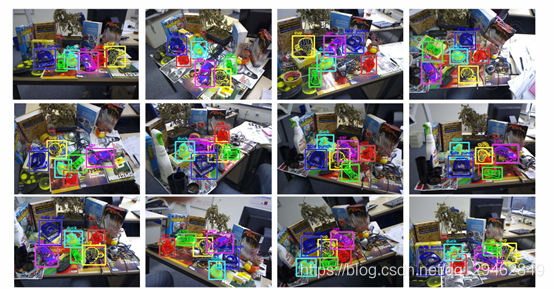

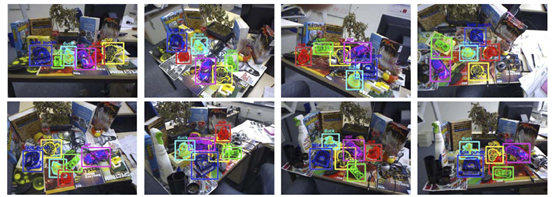

实验结果:

16、Gradient Response Maps for Real-Time Detection of Texture-Less Objects.

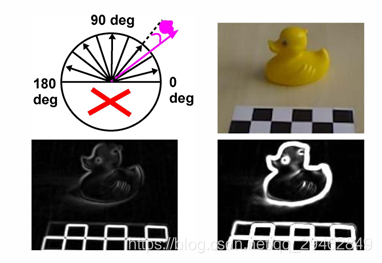

论文链接:https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=6042881

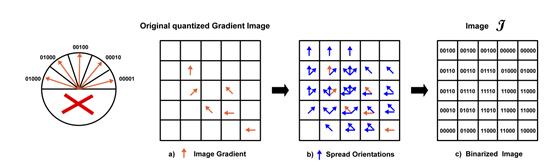

主要思想:本文提出了一种实时三维物体实例检测的方法,该方法不需要耗时的训练阶段,并且能够处理未加纹理的物体。该方法的核心是一种新的模板匹配图像表示方法,该方法对小图像变换具有鲁棒性。这种稳健性基于扩展图像梯度方向,允许在分析图像时只测试所有可能像素位置的一小部分,并用有限的模板集表示三维对象。此外,本文还提出,如果有密集深度传感器,同时考虑到三维表面法向,可以扩展该方法以获得更好的性能。论文展示了如何利用现代计算机的体系结构来构建一个有效但非常有鉴别力的输入图像表示,该表示可用于实时考虑数千个模板。在大量的实际数据实验中,我们证明了我们的方法比目前最先进的方法在背景杂波方面要快得多,并且更具鲁棒性。

实验结果:

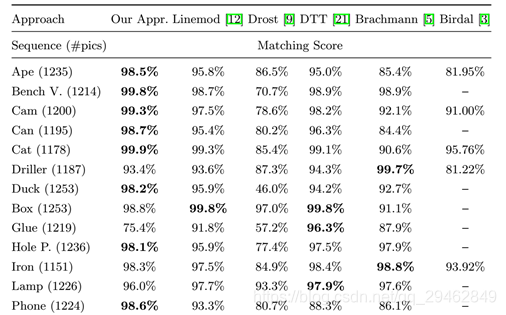

17、Model Based Training, Detection and Pose Estimation of Texture-Less 3D Objects in Heavily Cluttered Scenes.

论文链接:https://link.springer.com/content/pdf/10.1007%2F978-3-642-37331-2.pdf

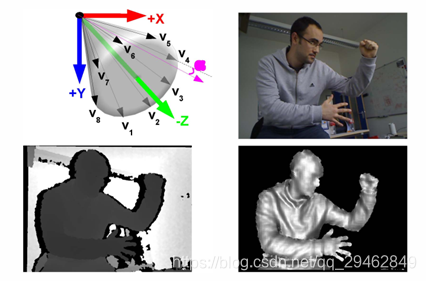

主要思想:文章提出了一个使用Kinect体感相机(RGBD sensors),实现对3D目标自动建模、检测和跟踪的构架。基于LINEMOD法(其目标检测部分主要运用基于模板的LINEMOD方法,通过改进,提升13%检测正确率),利用RGBD信息,完成多视角模板匹配,提供姿态粗估计,具有可在线实时学习3D模型能力,可处理大量杂波和中度遮挡场景,能同时检测多目标。

主要贡献:

1、以色彩梯度和表面法线自动减少特征冗余,自动学习3D模型的模板,此外,在保证探测速度和稳定性的同时,提供了特征空间的采样方案。

2、提供了新靓高效的后处理方法,表明姿态估计和色彩信息可验证特测假设,并提升13%探测正确率。

3、提供新的数据集,新数据集的主要特点为:对每一幅图像和序列提供3D模型和真实姿态;每一个序列均匀的覆盖了姿态空间;每幅图像包含了远近距离的2D和3D杂波。

实验结果: