热门标签

热门文章

- 1在Unity中使用Protobuf进行序列化_unity protobuf

- 2服务器升级Nacos2.2.3报错、rocksdb报错问题处理

- 3window系统git上传码云超过100M错误解决步骤_uploading lfs objects

- 4毕业设计 微信小程序选题大全(最新)_微信小程序毕设选题

- 5保险行业数据分析_保险数据分析

- 6记一次 MQ 消息流量异常放大原因分析_mq放大

- 715:00面试,15:06就出来了,问的问题有点变态。。

- 8动态规划:戳气球——有 n 个气球,编号为0 到 n-1,每个气球上都标有一个数字,这些数字存在数组 nums 中...

- 9springcloud集成rocketMQ

- 10hive的安装教程_hive数据库安装教程

当前位置: article > 正文

最强AI开源模型Llama3本地部署教程_ollama github

作者:喵喵爱编程 | 2024-07-04 05:07:16

赞

踩

ollama github

最近开源的llama模型非常火,BX同学在这里向大家演示一下,如何本地部署。

本文章谨代表BX个人思考

Meta公司发布的新一代大语言模型,

本期介绍如何在本地,在自己电脑上利用CPU/GPU部署运行,

介绍:

第一步:

用Ollama

下载ollama:

https://ollama.com/

第二步:

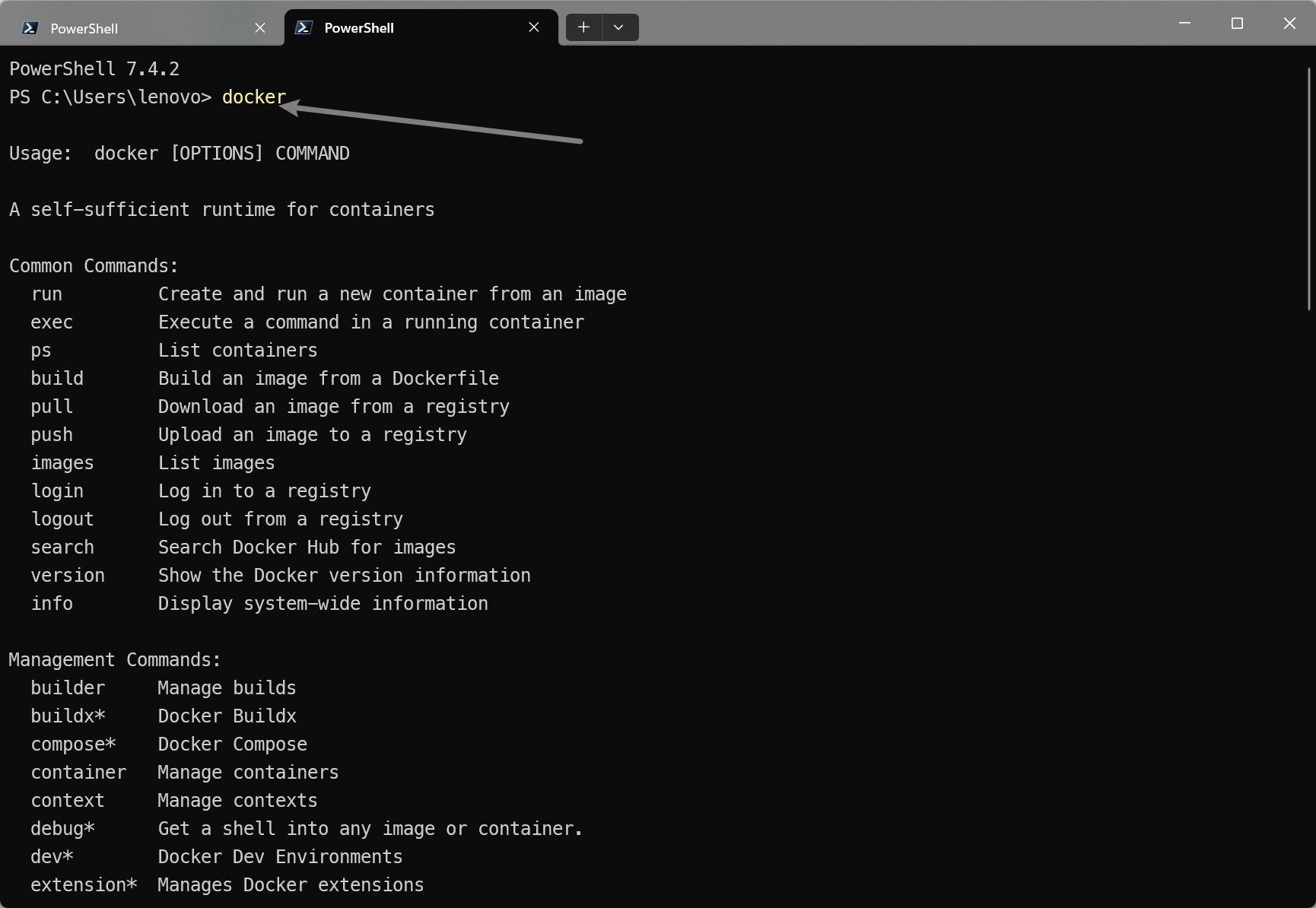

下载Docker desk:https://www.docker.com/get-started/

根据提示操作 按部就班 的下载

检查:

第三步:

下载 open-webui框架

- GitHub:https://github.com/open-webui/open-webui

- 在cmd/powershell中

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

- 1

这样就安装完成了

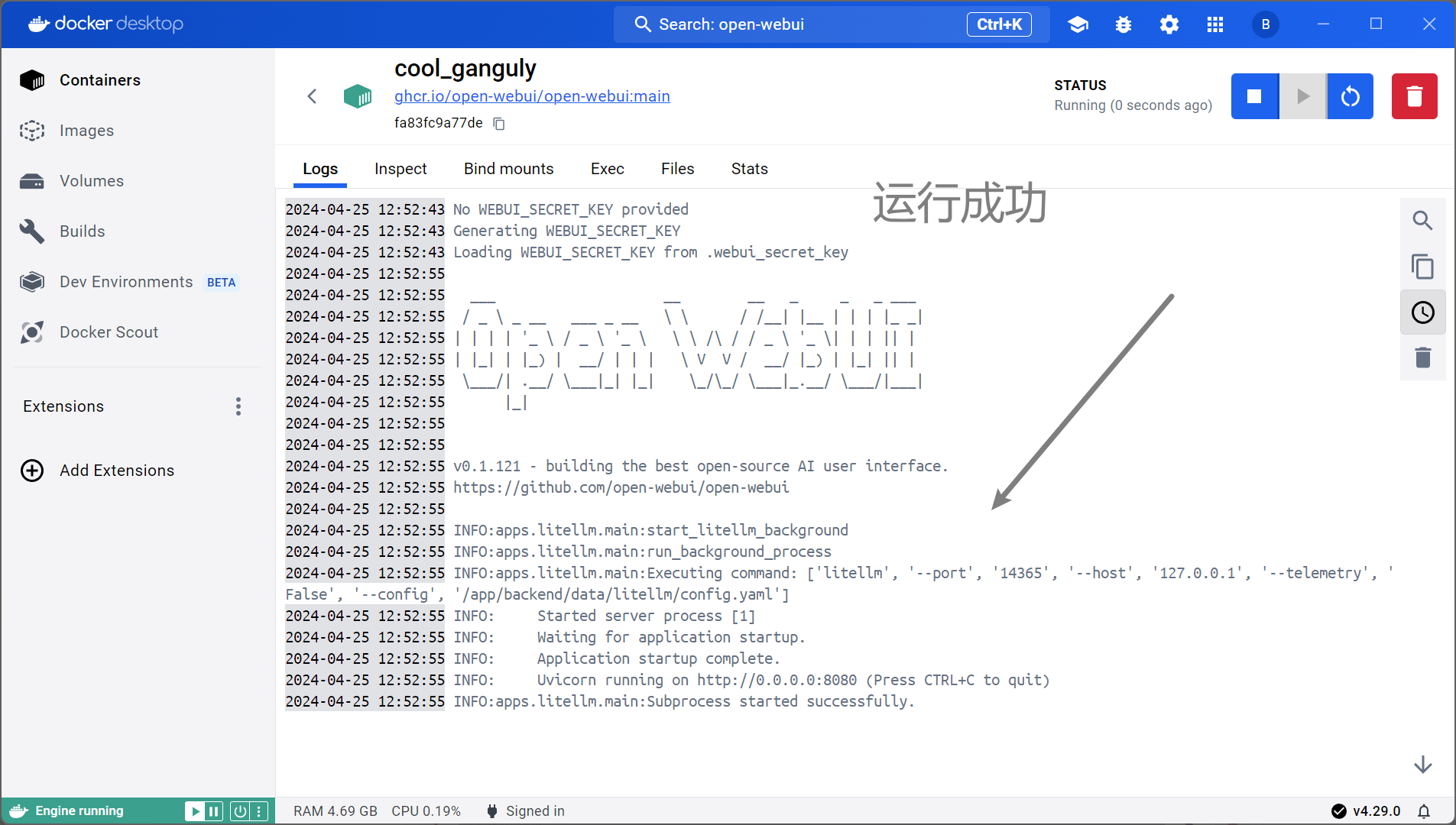

第四步:

在docker中运行这个项目

然后进入:

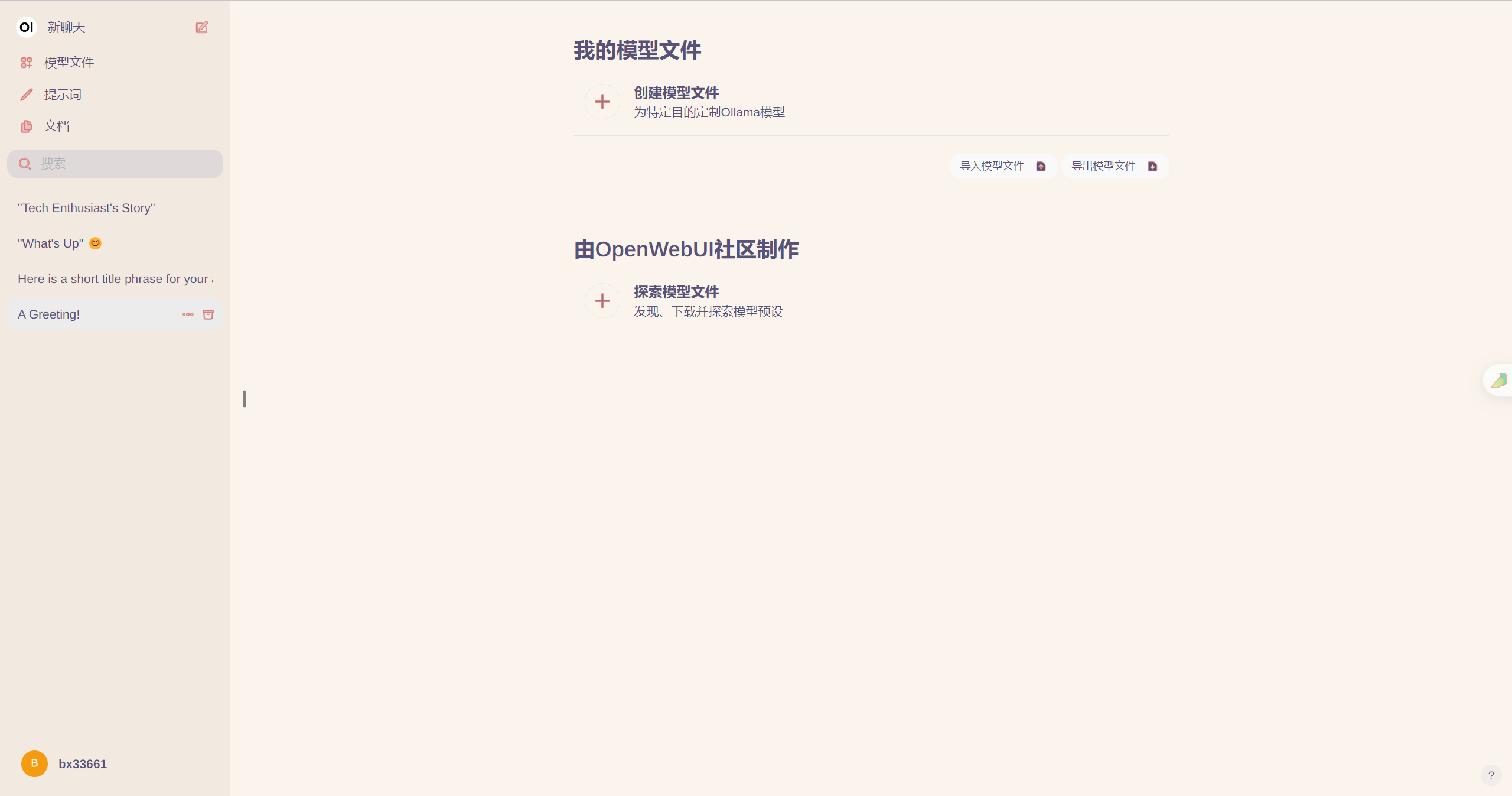

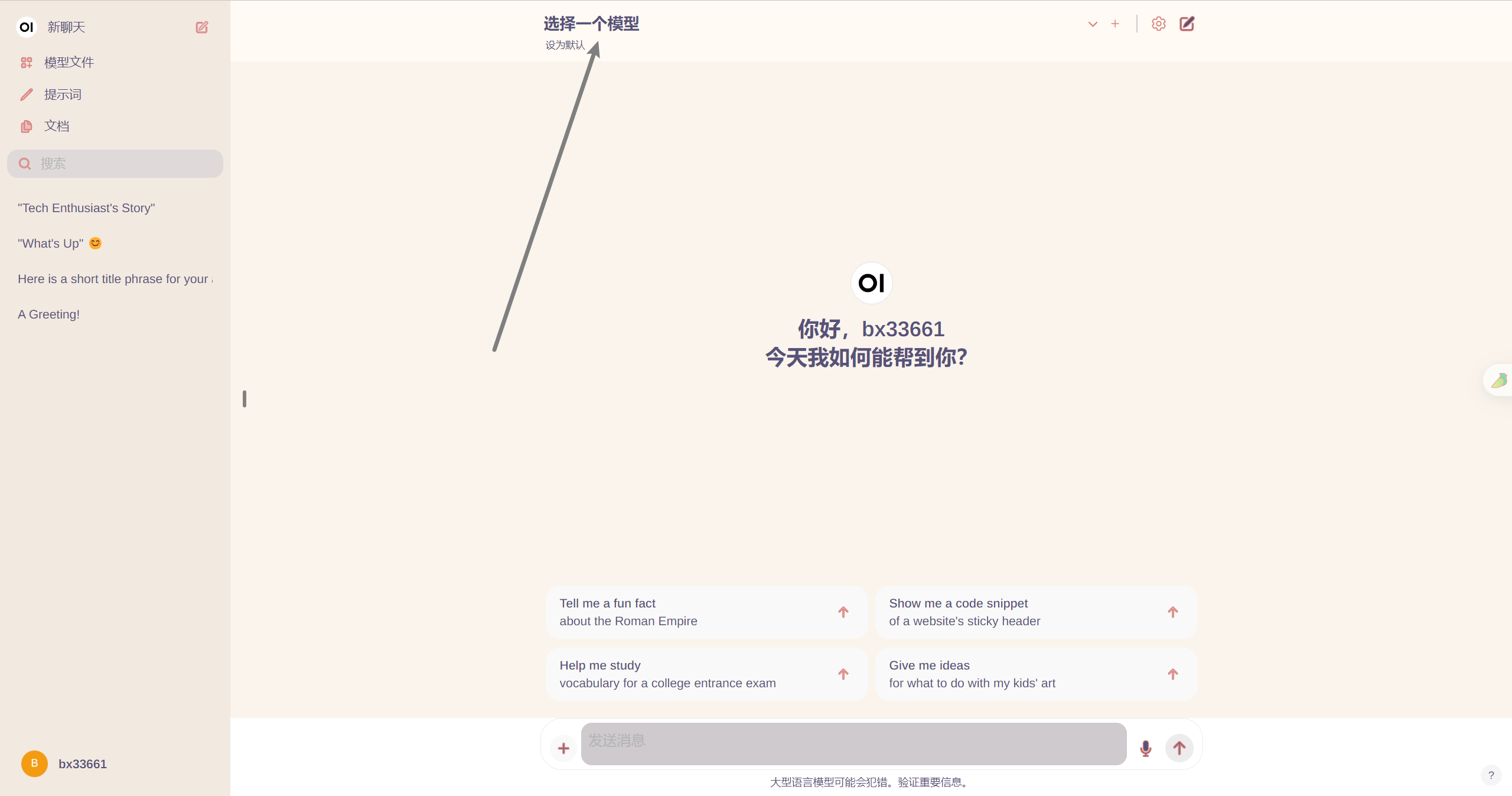

第五步:

注册登录后进入界面

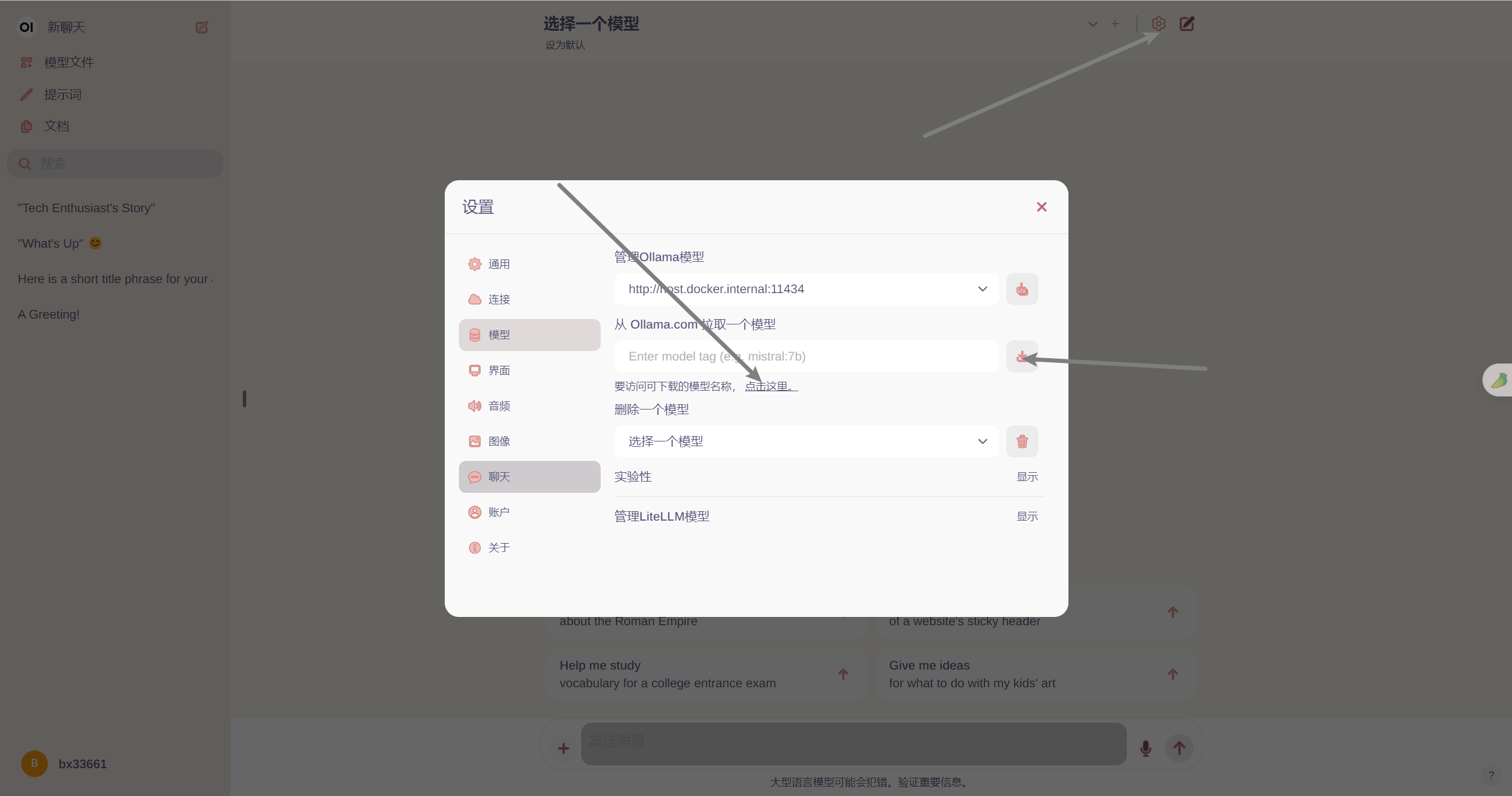

然后进入设置去下载模型

进入到模型选择界面

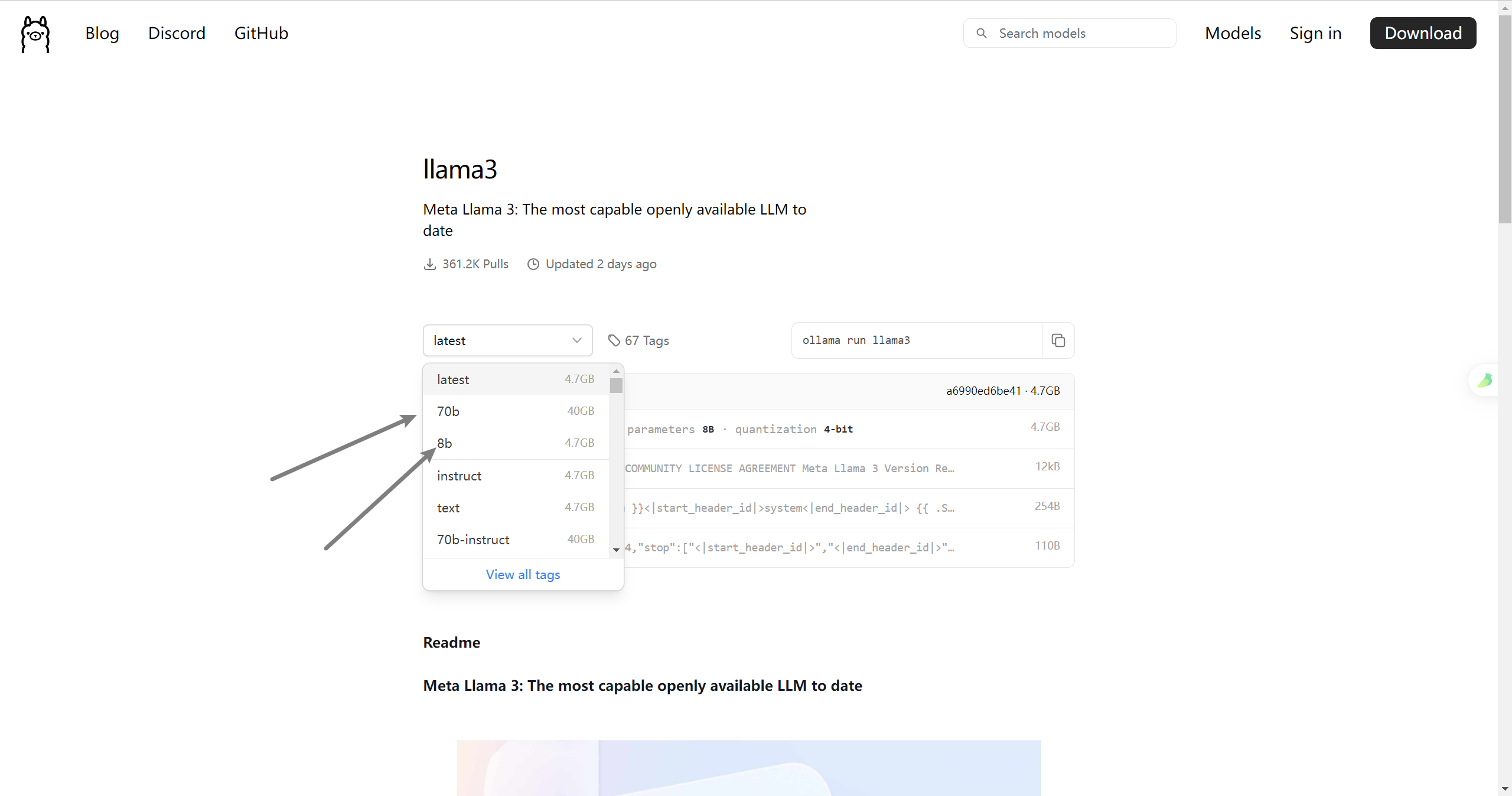

有一个70B和8B和两种情况,根据自己的情况去下载

把下载指令填入下载框,等待下载就行了

最后一步:

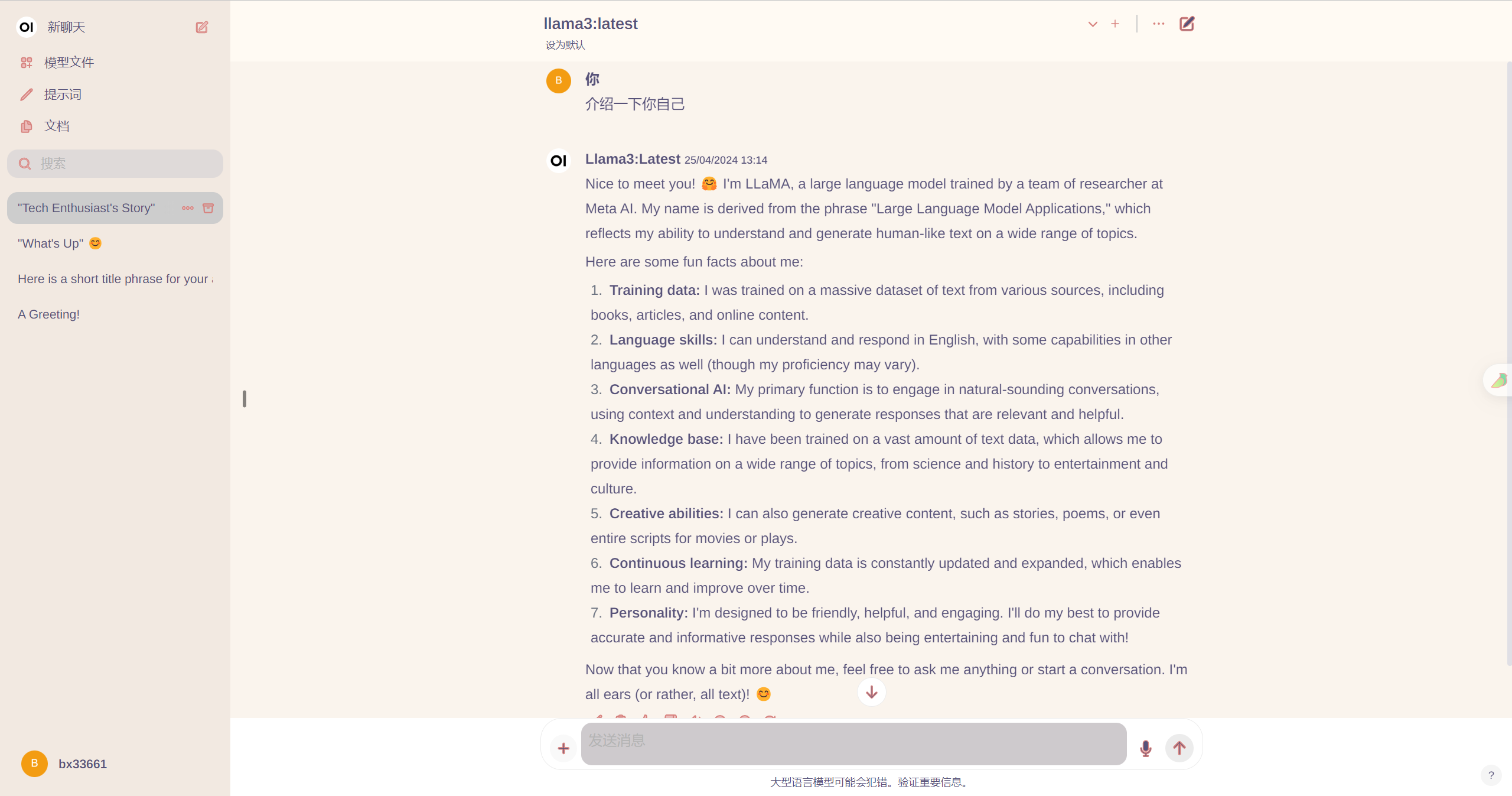

选择模型就可以开始对话了

效果还是很不错!

感谢大家观看,让我们一起进步

本文内容由网友自发贡献,转载请注明出处:https://www.wpsshop.cn/w/喵喵爱编程/article/detail/785729

推荐阅读

相关标签