- 1face替换工具Roop在Windows下的安装_roop安装依赖包命令

- 2用Python获取Linux资源信息的三种方法

- 3探索 GitCode:一个高效、开源的代码托管与问题管理平台

- 4OJ-2:区间问题【九度1554】

- 5计算机推免经历(西工大、南开、电科、哈工大威海)_西北工业大学计算机推免

- 6机器学习MATLAB实现:基于DCT变换的JPEG图像压缩_简述基于dct编码的jpeg压缩过程

- 7调用同一个API地址,相同的入参,Postman正常,但RestTemplate一直报错:{“ErrorMessage“: “(IndexError) list index out of range“_postman有数据resttemplate无数据

- 8[AIGC] 区块链简介_aigc区块链

- 9pyqt5实现定时的显示:_pyqt5 使用time.sleep

- 10python疫情监控(爬虫+可视化)_python疫情监控项目

python爬取的图片无法显示的问题_采集图片无效不显示怎么回事

赞

踩

一开始把图片爬下来的时候完全都不能看,查了很多也没清楚原因,暑假那会貌似看到了这篇博客,没有在意。现在补上,补上,补上。膜拜大神呀。

原博客地址:http://www.cnblogs.com/eastmount/p/5055908.html

一. 简单分析原因及知识巩固

1.urllib.urlretrieve()

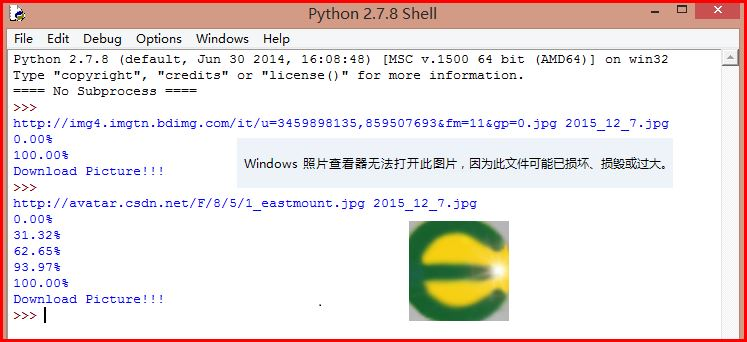

通过urlretrieve()函数可设置下载进度发现图片是一下子就加载的。这里给大家巩固这个urlretrieve函数的方法和Python时间命名方式,代码如下:

1 # -*- coding: utf-8 -*- 2 import urllib 3 import time 4 import os 5 6 #显示下载进度 7 def schedule(a,b,c): 8 #a:已下载的数据块 b:数据块的大小 c:远程文件的大小 9 per = 100.0 * a * b / c 10 if per > 100 : 11 per = 100 12 print '%.2f%%' % per 13 14 if __name__ == '__main__': 15 url = "http://img4.imgtn.bdimg.com/it/u=3459898135,859507693&fm=11&gp=0.jpg" 16 #定义文件名 时间命名 17 t = time.localtime(time.time()) 18 #反斜杠连接多行 19 filename = str(t.__getattribute__("tm_year")) + "_" + \ 20 str(t.__getattribute__("tm_mon")) + "_" + \ 21 str(t.__getattribute__("tm_mday")) 22 target = "%s.jpg" % filename 23 print target 24 urllib.urlretrieve(url,target,schedule) 25 print "Download Picture!!!"

发现该图片的大小仅为168字节,其中输出结果如下图,获取的URL地址如下:

http://img4.imgtn.bdimg.com/it/u=3459898135,859507693&fm=11&gp=0.jpg

而换张图片是能显示下载进度的,如我的头像。显然我想让程序加个进度就能爬取图片的想法失败。

头像地址: http://avatar.csdn.net/F/8/5/1_eastmount.jpg

猜测可能获取的百度URL不是原图地址,或者是个服务器设置了相应的拦截或加密。参考"Python爬虫抓取网页图片",函数相关介绍如下:

>>> help(urllib.urlretrieve) Help on function urlretrieve in module urllib: urlretrieve(url, filename=None, reporthook=None, data=None) 参数url: 指定的下载路径 参数 finename: 指定了保存本地路径(如果参数未指定,urllib会生成一个临时文件保存数据。) 参数 reporthook: 是一个回调函数,当连接上服务器、以及相应的数据块传输完毕时会触发该回调, 我们可以利用这个回调函数来显示当前的下载进度。 参数 data: 指 post 到服务器的数据,该方法返回一个包含两个元素的(filename, headers)元组, filename 表示保存到本地的路径,header 表示服务器的响应头。

2.urllib2.urlopen()

换个方法urlopen()实现,同时设置消息头试试,并输出信息和图片大小。

1 # -*- coding: utf-8 -*- 2 import os 3 import sys 4 import urllib 5 import urllib2 6 7 #设置消息头 8 url = "http://img4.imgtn.bdimg.com/it/u=3459898135,859507693&fm=11&gp=0.jpg" 9 header = { 10 'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64) \ 11 AppleWebKit/537.36 (KHTML, like Gecko) \ 12 Chrome/35.0.1916.114 Safari/537.36', 13 'Cookie': 'AspxAutoDetectCookieSupport=1' 14 } 15 request = urllib2.Request(url, None, header) 16 response = urllib2.urlopen(request) 17 print response.headers['Content-Length'] 18 19 with open("picture.jpg","wb") as f: 20 f.write(response.read()) 21 print response.geturl() 22 print response.info() #返回报文头信息 23 print urllib2.urlopen(url).read()

返回内容是”HTTPError: HTTP Error 403: Forbidden“,Selenium打开如下:

其中403错误介绍如下,服务器拒绝服务:

推荐一篇文章:[Python]网络爬虫(五):urllib2的使用细节与抓站技巧

二. 解决方法

主要参考三篇文章和自己的一些想法:

selenium+python 爬取网络图片(2) -- 百度

Python 3 多线程下载百度图片搜索结果

CSDN博客搬家到WordPress - curl设置headers爬取

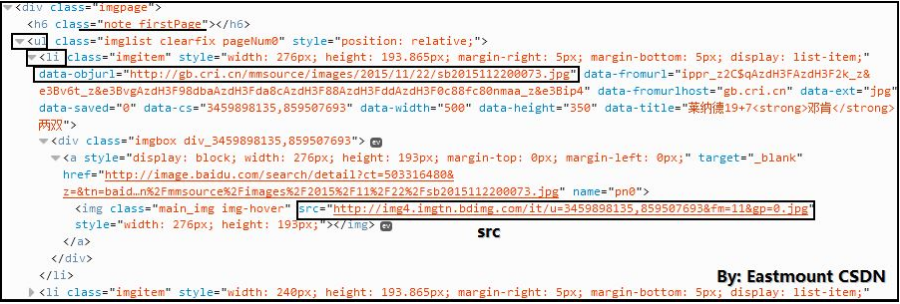

第一个方法 F12审查元素和SRC的骗局

这是感谢"露为霜"同学提供的方法,如果你通过浏览器点开百度搜索"邓肯"的第一张图片,复制网址后,会发现图片真实的地址为:

http://gb.cri.cn/mmsource/images/2015/11/22/sb2015112200073.jpg

此时你再分析百度搜索页面,你会发现"F12审查元素和获取src元素的行为欺骗了你",正是因为它俩定位到了错误的图片链接。而真实的URL是在"ul/li/"中的"data-objurl"属性中。

代码如下:

1 # -*- coding: utf-8 -*- 2 import urllib 3 import re 4 import time 5 import os 6 from selenium import webdriver 7 from selenium.webdriver.common.keys import Keys 8 import selenium.webdriver.support.ui as ui 9 from selenium.webdriver.common.action_chains import ActionChains 10 11 #Open PhantomJS 12 #driver = webdriver.PhantomJS(executable_path="G:\phantomjs-1.9.1-windows\phantomjs.exe") 13 driver = webdriver.Firefox() 14 wait = ui.WebDriverWait(driver,10) 15 16 #Search Picture By Baidu 17 url = "http://image.baidu.com/" 18 name = u"邓肯" 19 driver.get(url) 20 elem_inp = driver.find_element_by_xpath("//form[@id='homeSearchForm']/span[1]/input") 21 elem_inp.send_keys(name) 22 elem_inp.send_keys(Keys.RETURN) 23 time.sleep(5) 24 25 #Get the URL of Pictures 26 num = 1 27 elem_pic = driver.find_elements_by_xpath("//div[@class='imgpage']/ul/li") 28 for elem in elem_pic: 29 elem_url = elem.get_attribute("data-objurl") 30 print elem_url 31 #Download Pictures 32 name = "%03d" % num 33 urllib.urlretrieve(elem_url, str(name) + ".jpg") 34 num = num + 1 35 else: 36 print "Download Pictures!!!"

运行代码成功爬取了9张图片,显然成功了!虽然最后报错:IOError: [Errno socket error] [Errno 10060] ,只爬取了9张图片,但是至少可以正确解决了该问题。

同样的道理,googto的elem.get_attribute("src")改成elem.get_attribute("data-imgurl")即可获取正确的图片地址并正确下载。PS:百度图片动态加载的功能是非常强大的,当你的鼠标拖动时,它会自动增加新的页面,在<ul>中包括新的一批<li>张图片,这也是不同于其它网页在右下角点击"1、2、3..."翻页的,可能也会成为海量图片爬取的又一难点。

第二个方法 Selenium使用右键另存为

还是使用老的链接,虽然读取是无法显示的,但尝试通过Selenium的鼠标右键另存为功能,看能不能爬取成功。

1 # -*- coding: utf-8 -*- 2 import urllib 3 import re 4 import time 5 import os 6 from selenium import webdriver 7 from selenium.webdriver.common.keys import Keys 8 import selenium.webdriver.support.ui as ui 9 from selenium.webdriver.common.action_chains import ActionChains 10 11 #Open PhantomJS 12 driver = webdriver.Firefox() 13 wait = ui.WebDriverWait(driver,10) 14 15 #Search Picture By Baidu 16 url = "http://image.baidu.com/" 17 name = u"邓肯" 18 driver.get(url) 19 elem_inp = driver.find_element_by_xpath("//form[@id='homeSearchForm']/span[1]/input") 20 elem_inp.send_keys(name) 21 elem_inp.send_keys(Keys.RETURN) 22 time.sleep(5) 23 24 #Get the URL of Pictures 25 elem_pic = driver.find_element_by_xpath("//div[@class='imgpage']/ul/li/div/a/img") 26 elem_url = elem_pic.get_attribute("src") 27 print elem_url 28 29 #鼠标移动至图片上 右键保存图片 30 driver.get(elem_url) 31 print driver.page_source 32 elem = driver.find_element_by_xpath("//img") 33 action = ActionChains(driver).move_to_element(elem) 34 action.context_click(elem) #右键 35 36 #当右键鼠标点击键盘光标向下则移动至右键菜单第一个选项 37 action.send_keys(Keys.ARROW_DOWN) 38 action.send_keys('v') #另存为 39 action.perform() 40 print "Download Pictures!!!"

虽然它能实现右键另存为,但是需要手动点击保存,其原因是selenium无法操作操作系统级的对话框,又说"set profile"代码段的设置能解决问题的并不靠谱。通过钩子Hook函数可以实现,以前做过C#的钩子自动点击功能,但是想到下载图片需要弹出并点击无数次对话框就很蛋疼,所以该方法并不好!

钩子函数java版本结合robot可以阅读下面这篇文章:

selenium webdriver 右键另存为下载文件(结合robot and autoIt)

第三个方法 通过Selenium自动点击百度的下载按钮

其实现过程就是通过Selenium找到"下载"按钮,再点击或获取链接即可。

该方法参考文章:selenium+python 爬取网络图片(2) -- 百度

同时,这里需要强调百度动态加载,可以通过Selenium模拟滚动窗口实现,也参考上面文章。其中核心代码为:

driver.maximize_window()

pos += i*500 # 每次下滚500

js = "document.documentElement.scrollTop=%d" % pos

driver.execute_script(js)

第四个方法 百度图片解码下载及线程实现

参考文章:Python 3 多线程下载百度图片搜索结果

- b站视频下载 ...

赞

踩