- 1国内无法访问下载Docker镜像的多种解决方案, Docker 镜像 网络代理配置,推荐使用网络代理_国内无法拉取docker镜像

- 2使用Dom4j解析XML文件

- 3SpringCloud源码学习笔记之Eureka服务端——服务注册_no static resource eureka.

- 4自然语言生成(NLG)的好处是什么,它如何影响BI?_智能语音 nlg

- 5基于Big-Bang-Big-Crunch(BBBC)算法的目标函数最小值计算matlab仿真

- 6开源低代码平台,JeecgBoot v3.7.0 里程碑版本发布_检测到当前菜单表是 vue2版本 的,这将导致菜单加载异常,请更换成vue3版本的表!

- 7飞桨模型保存_重磅发布开源框架、生物计算平台螺旋桨,百度飞桨交了年终成绩单...

- 8svn提交提示服务器文件被锁,svn被锁定怎么解决-svn被锁定的解决方法 - 河东软件园...

- 9鸿蒙实战开发教程-注册登录页面_鸿蒙登录页面

- 10软考中级系统集成必备100题(91-100)真题精炼(1)

大语言模型参数真的必须要万亿以上吗?_大语言模型 参数规模

赞

踩

目录

引言

随着人工智能技术的飞速发展,大语言模型(Large Language Models, LLMs)在自然语言处理领域扮演着越来越重要的角色。然而,随着模型规模的不断扩大,人们开始质疑:模型参数真的需要达到万亿级别吗?本文将探讨这一问题,并提供一些代码示例来展示参数设置。

1. 大语言模型概述

1.1 定义与作用

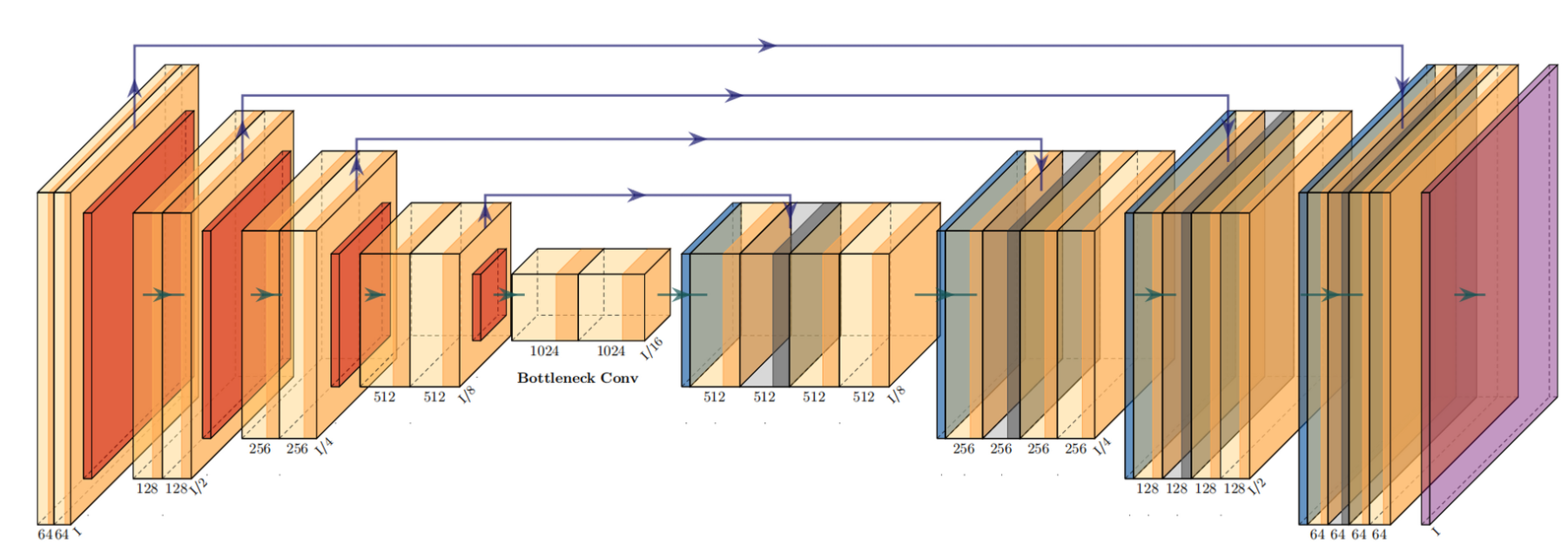

大语言模型(LLMs)是深度学习中用于处理自然语言任务的一类模型,它们通过大量的参数来学习和模拟人类语言的复杂性。这些模型通常基于变换器(Transformer)架构,能够捕捉语言中的长距离依赖关系,并在多种语言任务上表现出色,如文本生成、翻译、摘要、问答等。

作用:

- 文本生成:生成连贯、语法正确的文本。

- 语言理解:理解文本的含义,包括情感分析、意图识别等。

- 翻译:将一种语言的文本翻译成另一种语言。

- 问答系统:回答有关文本内容的问题。

- 摘要生成:生成文本的简短摘要。

1.2 发展历程

大语言模型的发展可以追溯到早期的机器学习和自然语言处理技术。以下是一些关键的发展里程碑:

- 早期模型:如N-gram模型,它们基于统计方法来预测文本。

- 深度学习兴起:随着深度学习技术的发展,神经网络开始被用于语言模型。

- 变换器架构:2017年,变换器(Transformer)模型的提出,为处理序列数据提供了新的可能性。

- BERT的出现:2018年,BERT(Bidirectional Encoder Representations from Transformers)模型的发布,标志着预训练语言模型的新纪元。

- 模型规模扩大:随后,模型的规模不断扩大,从百万参数到数十亿,再到今天的万亿参数。

1.3 当前趋势

当前,大语言模型的发展呈现出以下趋势:

- 规模持续增长:模型的参数数量不断增加,以期获得更好的性能。

- 多模态学习:模型开始整合视觉、声音等多种数据类型,以提高理解和生成能力。

- 知识整合:尝试将外部知识库整合到模型中,以增强模型的知识基础和推理能力。

- 效率优化:研究如何提高模型的训练和推理效率,包括模型剪枝、量化等技术。

- 伦理和可解释性:随着模型规模的扩大,人们越来越关注模型的伦理问题和可解释性。

- 跨领域应用:大语言模型被应用于医疗、法律、教育等多个领域,以解决特定问题。

2. 参数规模与性能的关系

2.1 参数规模对性能的影响

参数规模是大语言模型设计中的关键因素之一,它直接影响模型的学习能力和性能。参数可以视为模型的“记忆单元”,更多的参数意味着模型有更大的能力来记忆和学习数据中的复杂关系和特征。

- 学习能力:更多的参数通常使模型能够捕捉到更多的语言现象和细微差别,从而提高其对语言的理解和生成能力。

- 复杂性处理:大规模模型更擅长处理语言的复杂性和多样性,包括歧义、双关语和复杂的语法结构。

- 数据拟合:参数众多的模型能够更好地拟合训练数据,学习到数据中的统计规律。

然而,参数规模的增加也带来了一些挑战:

- 计算成本:更多的参数意味着更高的计算和存储需求,这可能导致训练和部署成本的增加。

- 训练难度:大规模模型需要更多的数据来有效训练,避免过拟合,同时训练过程也更为复杂。

2.2 不同规模模型的比较

不同规模的语言模型在性能上存在差异,这些差异在不同类型的任务上表现得尤为明显。

- 小型模型:小型模型参数数量较少,训练速度快,资源消耗低,适用于资源受限的环境或简单的语言任务。

- 中型模型:中型模型在小型模型的基础上增加了一些参数,能够处理更复杂的任务,但仍然受限于其规模。

- 大型模型:大型模型拥有数十亿甚至数万亿的参数,能够处理高度复杂的语言任务,提供更深层次的语言理解。

在实际应用中,选择模型的规模需要考虑以下因素:

- 任务复杂性:任务越复杂,可能需要的模型规模越大。

- 资源可用性:计算资源和预算限制可能会影响模型规模的选择。

- 部署环境:不同的部署环境可能对模型的大小和复杂性有不同的要求。

2.3 过拟合与泛化能力

过拟合是指模型在训练数据上表现得很好,但在未见过的数据上表现不佳的现象。这通常是因为模型学习到了训练数据中的特定噪声和细节,而没有学习到数据背后的普遍规律。

- 过拟合风险:大规模模型由于其高学习能力,如果没有足够的数据或适当的正则化技术,可能会过拟合。

- 泛化能力:泛化能力是指模型对新数据的适应能力。一个具有良好泛化能力的模型能够将从训练数据中学到的规律应用到新数据上。

- 数据量与质量:足够的数据量和数据的多样性是防止过拟合的关键。此外,数据的质量和相关性也对模型的泛化能力有重要影响。

为了避免过拟合并提高泛化能力,研究人员采取了多种策略:

- 数据增强:通过增加数据的多样性来模拟更多的语言现象。

- 正则化技术:如Dropout、权重衰减等,减少模型对训练数据的敏感度。

- 早停:在验证集上的性能不再提升时停止训练,以避免过拟合。

3. 万亿参数模型的优势与挑战

3.1 优势分析

万亿参数级别的大语言模型因其庞大的规模,带来了一系列显著的优势:

-

更丰富的语义理解:拥有如此多参数的模型能够捕捉到语言中极为细微的语义差异,理解复杂的概念和语境。这使得模型在执行诸如文本推理、情感分析等任务时更加精准。

-

更广泛的知识覆盖:万亿参数模型能够存储和处理大量的知识,使其能够理解和生成涉及广泛主题的内容,包括专业领域的知识。

-

高级语言生成:这些模型能够生成连贯、逻辑性强、风格多样的文本,适用于创意写作、内容创作等应用。

-

多任务学习能力:由于其庞大的容量,万亿参数模型可以在训练过程中同时学习多种语言任务,实现多任务学习。

-

更好的上下文理解:在处理长文本或对话时,这些模型能够维持更长的上下文信息,从而更好地理解整体含义。

3.2 挑战探讨

尽管万亿参数模型提供了显著的优势,但它们也带来了一系列挑战:

-

计算资源消耗:训练和运行万亿参数模型需要巨大的计算资源,包括高性能的GPU/TPU集群和大量的存储空间。这不仅成本高昂,而且对能源的需求也非常大。

-

训练与部署难度:由于模型的复杂性,训练过程可能需要数月时间,并且需要专业的知识和技能来管理。部署这样的模型同样复杂,需要解决模型优化、压缩和加速等问题。

-

数据需求:为了充分发挥万亿参数模型的潜力,需要大量的高质量训练数据。数据的收集、清洗和标注都是耗时且成本高昂的过程。

-

环境影响:大规模模型的训练和运行对环境造成的影响不容忽视,包括碳足迹和对电力供应的需求。

-

可解释性和透明度:随着模型规模的增加,其决策过程变得更加复杂和难以解释,这在某些应用场景中可能引起法律和伦理问题。

-

泛化能力:尽管模型规模庞大,但如何确保模型在各种任务和数据分布上都具有良好的泛化能力,仍然是一个挑战。

-

公平性和偏见:大规模模型可能会无意中学习并放大训练数据中的偏见,导致不公平的结果。

为了应对这些挑战,研究者和工程师们正在探索各种解决方案,包括模型压缩、知识蒸馏、高效的训练算法、以及更加环保的计算硬件等。同时,对模型的伦理和可解释性的关注也在不断增加,以确保这些强大的工具能够在负责任和可持续的方式下使用

4. 实际应用场景分析

4.1 学术研究

在学术界,大语言模型,尤其是万亿参数级别的模型,已成为推动自然语言处理领域研究的重要工具。

- 基础研究:这些模型帮助研究人员探索语言的深层结构和语义,为理解人类语言提供新的视角。

- 新算法和架构:研究者利用大规模数据和计算资源,开发新的算法和模型架构,以解决传统方法难以克服的问题。

- 跨学科研究:大语言模型促进了语言学、心理学、认知科学等多个学科的交叉融合,为复杂问题提供新的研究路径。

- 知识发现:通过分析模型的预测和生成的文本,研究人员可以发现新的语言学现象和知识。

4.2 商业应用

商业领域中,大语言模型的应用正变得越来越广泛,为企业提供了新的增长机会和竞争优势。

- 客户服务:聊天机器人和自动回复系统可以提供24/7的客户支持,提高客户满意度并降低人力成本。

- 内容生成:自动生成新闻、报告、营销内容等,节省时间和资源,同时保持内容的新鲜度和相关性。

- 数据分析:分析社交媒体、客户反馈等非结构化数据,提取有价值的洞察和趋势。

- 个性化推荐:通过理解用户的语言偏好和需求,提供个性化的产品推荐和服务。

4.3 特定领域定制

在特定领域,如医疗、法律、金融等,大语言模型可以根据特定需求进行定制,以解决领域特有的问题。

- 医疗领域:辅助诊断、患者沟通记录的自动整理、医学文献的快速检索和总结。

- 法律领域:自动化合同审查、案例研究、法律咨询等,提高法律服务的效率和准确性。

- 金融领域:市场分析、风险评估、自动化报告生成等,帮助金融机构做出更明智的决策。

- 教育领域:个性化学习辅导、语言教学、课程内容的自动生成和更新。

在特定领域的应用中,模型需要针对该领域的术语、概念和数据进行训练和优化,以确保其输出的准确性和相关性。此外,这些应用还需要考虑隐私、安全性和伦理等重要因素。

5. 参数设置的代码示例

基础模型参数设置

- class BasicModel:

- def __init__(self, num_parameters=1000000):

- self.parameters = num_parameters

- # 初始化模型参数

- print(f"Initialized BasicModel with {self.parameters} parameters.")

扩展模型参数设置

- class ExtendedModel(BasicModel):

- def __init__(self, num_parameters=10000000000):

- super().__init__(num_parameters)

- # 扩展模型参数

- print(f"Initialized ExtendedModel with {self.parameters} parameters.")

模型训练示例

- def train_model(model, data):

- # 模型训练逻辑

- print("Training model with provided data.")

-

- # 创建模型实例

- model = ExtendedModel()

- # 训练模型

- train_model(model, "Sample dataset")

6. 优化策略与未来展望

3.1 参数优化技术

为了解决大规模模型带来的挑战,研究者们开发了多种参数优化技术:

-

知识蒸馏:

- 概念:这是一种模型压缩技术,其中小型模型(学生模型)被训练来模仿大型模型(教师模型)的行为。

- 优势:通过这种方式,小型模型可以学习到大型模型的知识,而无需直接处理大型模型的复杂性和资源需求。

-

稀疏激活:

- 概念:在这种技术中,不是所有参数都被激活,而是只有一部分参数参与模型的计算。

- 优势:这可以显著减少模型的计算量和内存需求,同时保持模型的性能。

6.2 未来研究方向

未来的研究将继续探索新的优化策略和应用领域:

-

模型压缩:

- 目标:减少模型的存储和计算需求,使其更适合在资源受限的环境中使用。

- 方法:包括权重剪枝、量化和知识蒸馏等。

-

多模态学习:

- 目标:通过整合视觉、声音和文本等多种数据类型,提高模型对世界的理解能力。

- 应用:可以应用于自动驾驶、机器人交互和增强现实等领域。

7. 结论

在追求模型规模的同时,我们必须考虑实际应用的需求和资源限制。选择合适的模型规模,平衡性能和效率,是未来发展的关键。优化技术和新的研究方向,如模型压缩和多模态学习,将为大语言模型的发展提供新的动力,并帮助我们克服当前面临的挑战。本文通过分析大语言模型的参数规模与性能的关系,提供了代码示例,并探讨了优化策略与未来展望。我们得出结论,模型参数的规模应该根据实际应用场景和需求来确定,而不是盲目追求规模的扩大。同时,我们也展望了未来的研究方向,包括模型优化技术和多模态学习等领域的发展。

8. 参考文献与资源链接

以下是一些有关参数优化技术和未来研究方向的参考文献和资源链接:

- "The Lottery Ticket Hypothesis: Finding Sparse Networks" 论文链接

- 这篇论文提出了一种有效的网络剪枝方法,可以帮助发现稀疏但高效的神经网络结构。

- "Efficient Training of BERT by Progressively Stacking" 论文链接

- 该研究介绍了一种渐进式堆叠的训练方法,可以提高BERT模型的训练效率。

- Hugging Face Transformers 开源项目链接

- 这是一个流行的开源库,提供了多种预训练模型和工具,支持研究人员和开发者在自然语言处理领域的工作。