大语言模型(Large Language Model,LLM)简介

赞

踩

1. 什么是大语言模型

它是一种基于深度学习的人工智能模型,它从大量来自书籍、文章、网页和图像等来源的数据中学习,以发现语言模式和规则,如处理和生成自然语言文本。通常,大语言模型含数百亿(或更多)参数。

ChatGPT 的出现,不仅证明了大型语言模型能近乎完美的处理和理解人类的自然语言,更让我们看到了实现通用人工智能(Artificial General Intelligence AGI) 的希望。大型语言模型本质上就是神经网络,也就是一种机器学习的方法。

2.大模型的特点

LLM具有多种显著特点,这些特点使它们在自然语言处理和其他领域中引起了广泛的兴趣和研究。以下是LLM的一些主要特点:

- 巨大的规模:LLM通常具有巨大的参数规模,可以达到数十亿甚至数千亿个参数。这使得它们能够捕捉更多的语言知识和复杂的语法结构。

- 预训练和微调:LLM采用了预训练和微调的学习方法。它们首先在大规模文本数据上进行预训练(无标签数据),学会了通用的语言表示和知识,然后通过微调(有标签数据)适应特定任务,从而在各种NLP任务中表现出色。

- 上下文感知:LLM在处理文本时具有强大的上下文感知能力,能力理解和生成依赖于前文的文本内容。这使得它们在对话、文章生成和情境理解方面表现出色。

- 多语言支持:LLM可以用于多种语言,不仅限于英语。它们的多语言能力使得跨文化和跨语言的应用变得更加容易。

- 多模态支持:一些LLM已经扩展到支持多模态数据,包括文本、图像和语音。这意味着它们可以理解和生成不同媒体类型的内容,实现更多样化的应用。

- 涌现能力:LLM表现出令人惊讶的涌现能力,即在大规模模型中出现但在小型模型中不明显的性能提升。这使得它们能够处理更复杂的任务和问题。

- 多领域应用:LLM已经被广泛应用于文本生成、自动翻译、信息检索、摘要生成、聊天机器人、虚拟助手等多个领域,对人们的日常生活和工作产生了深远的影响。

- 伦理和风险问题:尽管LLM具有出色的能力,但它们也引发了伦理和风险问题,包括生成有害内容、隐私问题、认知偏差等。因此,研究和应用LLM需要谨慎。

3.大模型的应用

LLM 的应用案例有很多。其中不仅包括纯文本生成,还包括翻译、人际互动或摘要。它们被企业组织用于解决各种问题,包括但不限于:

- 通过减少重复性任务来提高生产力

- 解决人才短缺问题

- 内容创作

- 情感分析

总之,LLM是一种令人兴奋的技术,它让计算机更好地理解和使用语言,正在改变着我们与技术互动的方式,同时也引发了对未来人工智能的无限探索。

4. 常见的大模型

-

GPT系列

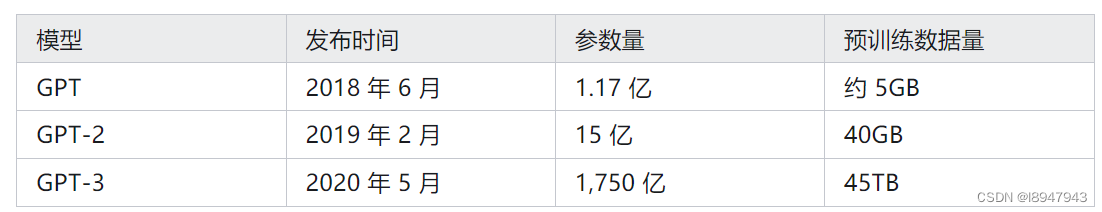

OpenAI公司在2018年提出的GPT(Generative Pre-Training)模型是典型的生成式预训练语言模型之一。

GPT模型的基本原则是通过语言建模将世界知识压缩到仅解码器的Transformer模型中,这样它就可以恢复(或记忆)世界知识的语义,并充当通用任务求解器。 -

ChatGPT

热度都炸锅了,相信大家使用是没有啥问题吧。GPT4版本是真的好用! -

Claude系列

不知道为啥,现在注册就封号。。。

但是测试过一次,是真的好用,不错!

诸如文心一言、通义千问,自行测试

5. 什么是大模型的基础模型?

基础模型是指 LLM 的特定实例或版本。 例如,GPT-3、GPT-4 或 Codex。基础模型采用所有不同格式的训练数据,并使用转换器体系结构生成通用模型。 可以创建适应和专用化,以通过提示或微调来实现某些任务。

ChatGPT 底层使用的大型语言模型是 GPT-3.5 模型。这是由 OpenAI 自己研发的大型语言模型,已经迭代了 3 次。

6.大模型与传统的自然语言处理有何不同?

| 传统 NLP | 大型语言模型 |

|---|---|

| 每个功能需要一个模型。 | 单个模型用于许多自然语言用例。 |

| 提供一组标记的数据来训练 ML 模型。(即监督学习) | 在基础模型中使用数 TB 的未标记数据。(即无监督学习,也称为自监督学习) |

| 用自然语言描述希望模型执行的操作。 | 针对特定用例进行高度优化。 |

ps:什么是自监督学习?

自监督学习主要是利用辅助任务(pretext)从大规模的无监督数据中挖掘自身的监督信息,通过这种构造的监督信息训练模型,从而学习到对下游任务有价值的表征。

借用一个小例子:学生通过做英语题来提升自己的英语应试能力。英语的题目是数据,题目的答案是数据的标签。除了刷题来练习英语的应试能力外,更可以利用看英文电影,听英文音乐,读英文小说的方式间接的加强自身的英文能力。看英文电影,听英文音乐,读英文小说属于辅助任务(pretext),这些数据本身是没有标签信息的(相比于英语应试题目)。

7.大模型不能做什么?

-

了解语言:LLM 是一个预测引擎,它基于预先存在的文本拉取模式以生成更多文本。 LLM 不理解语言或数学。(无法分析推理数学内涵和原理)

-

了解事实:LLM 没有单独的信息检索和创造性写作模式,它只会预测最有可能的下一个标记。(例如有些回答是胡说八道)

-

了解礼仪、情感或道德:LLM 不能展示拟人观或理解伦理。 基础模型的输出是训练数据和提示的组合。(不具备情绪,现阶段不回答是因为设置了后台规则)

参考链接: