热门标签

热门文章

- 1Redis面试题-先更新数据库还是先更新缓存_先更新数据库,再更新缓存

- 2自然语言处理(NLP)实验——比较各大翻译系统_自然语言机器翻译实验结果

- 3“抖音”命名是靠它?解码字节跳动如何做A/B测试

- 4运算放大器工作原理

- 5机器学习---LDA代码(在二维平面上对数据进行分类,并通过可视化展示分类结果)_lda模型代码

- 6NLP考点_symbolic approach

- 7Stable Video Diffusion(SVD)安装和测试_stable video diffusion 安装

- 8解决mac pro 装 win10以后 蓝牙 卡顿的问题_双系统电脑蓝牙听歌一顿一顿的

- 9pytong之语音环境:edge-tts and edge-playback

- 10使用纹理对比度检测检测AI生成的图像_ai 对比度

当前位置: article > 正文

神经网络:GRU基础学习

作者:小丑西瓜9 | 2024-03-27 23:37:24

赞

踩

gru

1、GRU 简介

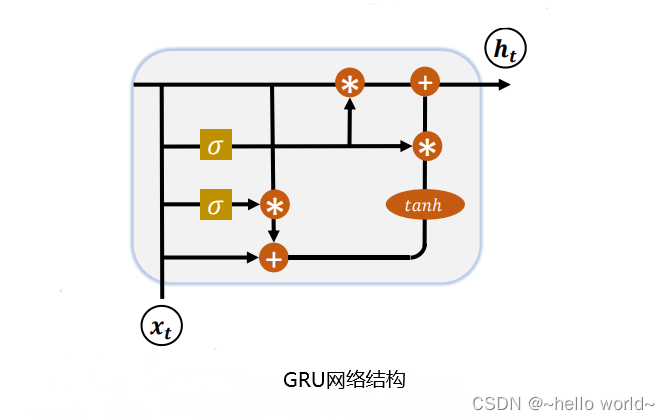

LSTM 具有更长的记忆能力,在大部分序列任务上面都取得了比基础的 RNN 模型更好的性能表现,更重要的是,LSTM 不容易出现梯度弥散现象。但是 LSTM 结构相对较复杂,计算代价较高,模型参数量较大。研究发现,遗忘门是 LSTM 中最重要的门控,甚至发现只有遗忘门的简化版网络在多个基准数据集上面优于标准 LSTM 网络。在众多的简化版 LSTM 中,门控循环网络(Gated Recurrent Unit,简称 GRU)是应用最广泛的 RNN 变种之一。GRU 把内部状态向量和输出向量合并,统一为状态向量 ,门控数量也减少到 2 个:复位门(Reset Gate)和更新门(Update Gate),如图下所示:

2、复位门

复位门用于控制上一个时间戳的状态 h声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/小丑西瓜9/article/detail/327577

推荐阅读

相关标签

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。