- 1关于学生课堂行为识别算法_课堂行为睡觉行为识别

- 2用vue-router开发权限中碰到的坑:addRoutes使用遇到的坑_“router.addroutes”的签名“(routes: routeconfig[]): voi

- 3百度网址安全中心怎么取消拦截的详细解决办法_百度安全验证被屏蔽怎么解除

- 4VUE 不同语言使用不同 CSS_vue项目国际化后各个语种样式不同解决方法

- 5Android Jetpack Compose基础之组件的帧渲染

- 6华为OD机试真题-最小矩阵宽度-2023年OD统一考试(C卷_最小宽度矩阵

- 7Transformer的前世今生 day11(Transformer的流程)

- 8浅析linux中的read和write函数_linux read write

- 9pikachu靶场第十二关——XSS(跨站脚本)之xsshtmlspecialchars(附代码审计)

- 10故障诊断模型 | 基于LSTM长短期记忆神经网络的滚动轴承故障诊断(Pytorch)

【论文精读03】Drag Your GAN: Interactive Point-based Manipulation on the Generative Image Manifold

赞

踩

【论文精读03】Drag Your GAN: Interactive Point-based Manipulation on the Generative Image Manifold

论文下载链接:https://vcai.mpi-inf.mpg.de/projects/DragGAN/data/paper.pdf

代码地址:https://github.com/XingangPan/DragGAN

本文是近期被SIGGRAPH 2023 Conference Proceedings所接收的一篇文章,因为研究的主题比较有意思,并且代码也已经开源,因此对这篇文章做一个精读,学习一下作者模型的设计思路和技巧,如有解读不当,请批评指正。

领域关键词:计算方法;计算机视觉;GANs,交互式图像操作,点跟踪

1. 摘要

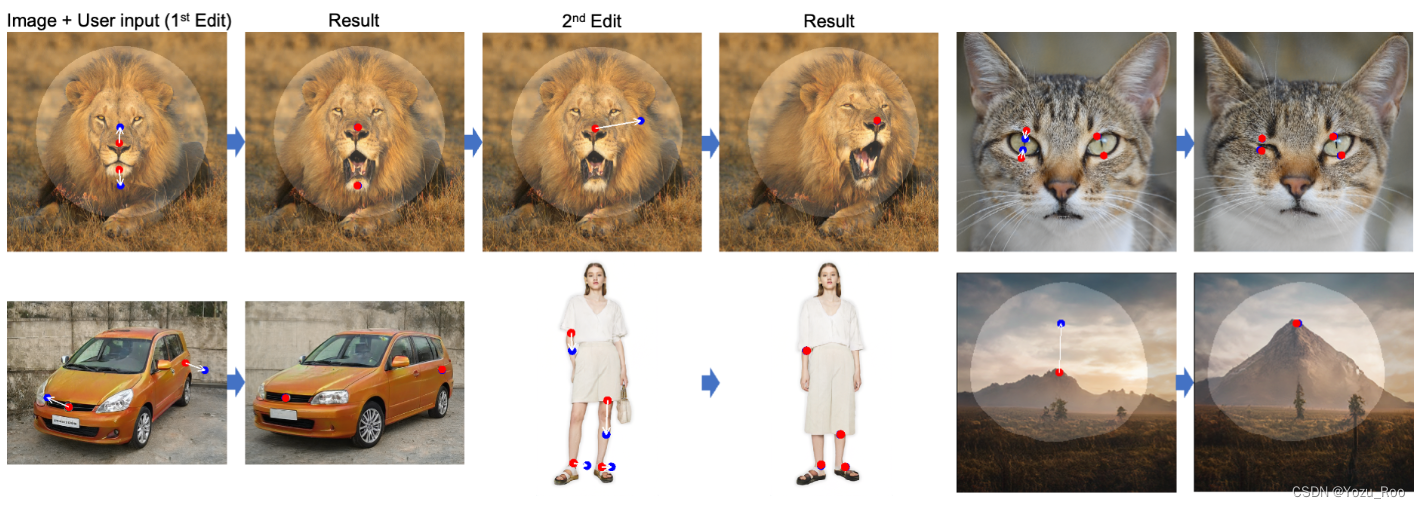

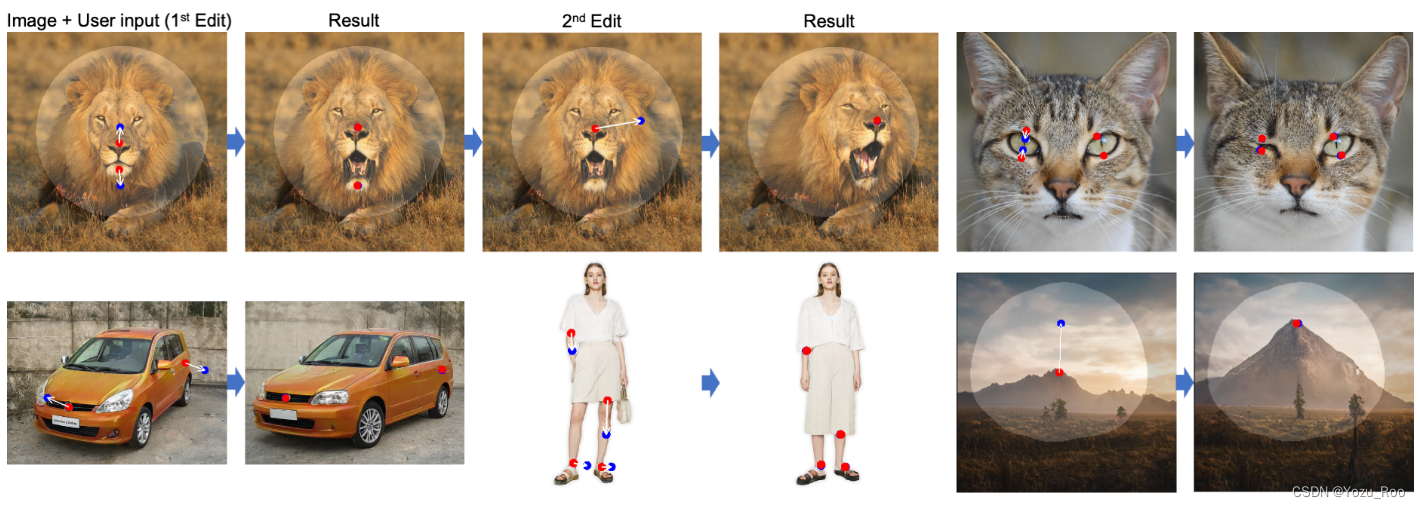

合成满足用户需求的视觉内容通常需要对生成对象的姿态、形状、表达和布局的灵活性和可控性有着一定的要求。现有的方法是通过手动标注的训练数据或先前的三维模型来获得生成对抗网络(GANs)的可控性,这些方法往往缺乏灵活性、精度和通用性。在这项工作中,我们研究了一种强大但浅探索的控制GANs的方法,即“拖动”图像中的任何点,以用户交互的方式精确到达目标点,如图1所示。

图1。DragGAN允许用户“拖动”任何GAN生成的图像的内容。用户只需点击图像上的几个手柄点(红色)和目标点(蓝色),我们的方法将移动手柄点,精确地到达相应的目标点。用户可以选择画一个灵活的区域(更亮的区域)的掩模,保持图像的其余部分不变。这种灵活的基于点的操作可以控制许多空间属性,如姿态、形状、表达式和布局。项目页面: https://vcai.mpi-inf.mpg.de/projects/DragGAN/.

为了实现这一点,我们提出了DragGAN,它由两个主要组件组成: 1)一种基于特征的移动监督,驱动手柄点向目标位置移动;2)一种新的点跟踪方法,利用鉴别生成器特性来保持定位手柄点的位置。由于这些操作是在可学习GAN生成的图像上执行的,它们倾向于产生现实的输出,即使是在具有挑战性的场景下,如幻觉遮挡的内容和变形的形状,也会一致地遵循物体的刚性。定性和定量的比较都表明,DragGAN在图像处理和点跟踪的任务中比以前的方法具有优势。我们还展示了通过GAN反演对真实图像的操作。

在摘要部分,作者指出了目前采用手动标注数据集和三维模型来获取GAN的操控能力是缺乏灵活性的,因此提出了一种交互式的、灵活的、可操作的模型,它能够与用户交互从而达到实时编辑图像的目的。该模型包括两个组件:基于特征的移动监督方法和点跟踪方法;前者用于驱动点的移动,后者用于跟踪轨迹以便于对像素进行实时调整。最后,作者概况说明了一下DragGAN模型的优势。

2. 结论

结论这里的内容和摘要的差不多,作者先说明了模型达到了一个怎样的效果,然后说了一下模型的组成结构(两个组件),最后阐述了一下模型的优点,这里不再赘述了,详见论文

3. 引言

引言部分,这里只提炼了要点,完整内容可以看原论文。

与先前的研究相比,本文研究的问题还有两个挑战: 1)我们考虑一个点以上的控制,然而他们的方法不能很好地处理这一问题;2)我们要求操纵点能够精确到达目标点,而他们的方法没有实现这一功能。正如我们将在实验中展示的那样,用精确的位置控制来处理多个点可以实现更加多样化和精确的图像操作。

为了实现这种基于点的交互式操作,我们提出了DragGAN,它解决了两个子问题,包括:1)监督手柄点向目标移动;2)跟踪手柄点,以便在每个编辑步骤中都知道它们的位置。

具体来说,运动监督是通过一个移动的特征块损失来实现优化潜在编码。每个优化步骤都会使得手柄点更接近目标;那么,点跟踪就会通过在特征空间中的最近邻搜索实现。重复此优化过程,直到手柄点到达目标为止。DragGAN还允许用户选择性地绘制感兴趣的区域来执行特定于区域的编辑在大多数情况下,在一个RTX 3090 GPU上只需要几秒钟。这允许实时的交互式编辑会话,其中用户可以在不同的布局上快速迭代,直到达到所需的输出。

我们的编辑是在学习的图像流形上执行的,它倾向于服从底层的对象结构例如,我们的方法可以产生幻觉、咬合的内容,比如狮子嘴里的牙齿,也可以随着物体的刚性而变形,比如马腿的弯曲。

我们还开发了一个GUI,用户可以通过简单地单击图像来交互式地执行操作。此外,我们的基于gan的点跟踪算法也优于现有的点跟踪算法,如RAFT [Teed和Deng 2020]和PIPs [Harley et al. 2022]。此外,通过结合GAN反演技术,我们的方法也可以作为一个强大的真实图像编辑工具。

4. 相关工作

略,详见论文。。。。

5. 方法

本工作旨在开发一种GANs交互式图像处理方法,用户只需要点击图像来定义一些对(手柄点,目标点),并驱动手柄点到达相应的目标点。我们的研究基于StyleGAN2体系结构[Karras等人,2020]。这里我们简要介绍这个体系结构的基础知识。

StyleGAN。在StyleGAN2架构中,一个512维的潜在码

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。