- 1Linux 编译安装Python 和 pip换源 教程_linux 修改python源

- 2vue3+ts antd上传组件调用多次接口问题_customrequest多次调用接口

- 3github项目记录_mayfly-go

- 4Cocos Creator Editor 执行场景脚本

- 5人工智能与金融科技:新的商业机遇

- 6当cin要求输入数字却提供字符串时,cin.fail()置1_设置cinfail为1

- 7字节跳动19春招_字节跳动20春招

- 8综合实验(简单版)配置_stp region-configuration instance 10 vlan 10 insta

- 9统计给定整数M和N区间内质数的个数并对它们求和。_在一行中顺序输出m和n区间内素数的个数以及它们的和,数字间以空格分隔

- 10Elasticsearch8.x版本Java客户端Elasticsearch Java API Client中常用API练习_elasticsearch java版本

数据库|基于TiDB Binlog架构的主备集群切换操作手册_tidb主从同步

赞

踩

目录

//2、使用sync-diff-inspector校验主从库数据是否一致

//3、关停主库到灾备库drainer同步链路后记录当前drainer同步TSO

//4、使用dumpling/BR对灾备库进行数据全量备份(备份期间可继续进行下一步操作)

最近手头有个系统,刚做完灾备建设及数据同步(文章链接在这 ),需要进行灾备切换演练,验证灾备库建设是否符合预期。需要做相关测试并准备操作手册,供日后切换演练及主备切换使用。

环境准备:需要分别部署一主一备两套tidb集群,并搭建TiDB Binlog用于主备集群间数据同步,可以参考前一篇文章:基于TiDB Binlog架构的主备集群部署及数据同步操作手册

环境准备完成后,就可以开始主备切换操作了。

一、具体操作过程

//1、停业务,待drainer追平主、备库数据

停止业务程序,确认业务不再有数据库写入操作。之后查询Drainer status 接口,如果返回 "Synced": true 表示主从同步完成。

- curl 'http://10.3.65.141:8249/status'

- {"PumpPos":{"10.3.65.141:8250":440717746593595393},"Synced":true,"LastTS":440717747379765249,"TsMap":""}

![]()

//2、使用sync-diff-inspector校验主从库数据是否一致

编辑配置文件:

- [tidb@localhost tidb-community-toolkit-v6.5.1-linux-arm64]$ vim sync.toml

- ######################### Global config #########################

- check-thread-count = 4

- export-fix-sql = true

- check-struct-only = false

-

-

- ######################### Datasource config #########################

- [data-sources]

- [data-sources.tidb1]

- host = "10.3.65.141"

- port = 4000

- user = "root"

- password = ""

-

- [data-sources.tidb2]

- host = "10.3.65.142"

- port = 4000

- user = "root"

- password = ""

-

- ######################### Task config #########################

- [task]

- output-dir = "./output"

- source-instances = ["tidb1"]

- target-instance = "tidb2"

- target-check-tables = ["test.t1","test.t2","test.t3"]

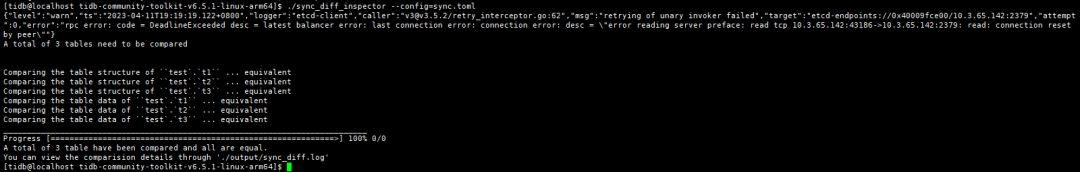

运行sync-diff,校验上下游数据是否一致:

[tidb@localhost tidb-community-toolkit-v6.5.1-linux-arm64]$ ./sync_diff_inspector --config=sync.toml

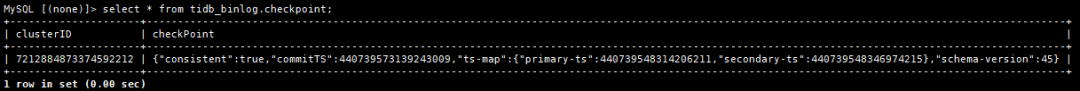

//3、关停主库到灾备库drainer同步链路后记录当前drainer同步TSO

- [tidb@localhost ~]$ tiup cluster stop tidb-1 -R drainer

-

-

- MySQL [(none)]> select * from tidb_binlog.checkpoint;

//4、使用dumpling/BR对灾备库进行数据全量备份(备份期间可继续进行下一步操作)

- ./dumpling -u root -P 4000 -h 127.0.0.1 \

- --filetype sql \

- -t 8 \

- -o $dumpdir \

-

- ./br backup full \

- --pd "127.0.0.1:2379" \

- --storage "local://$/brbackup" \

- --ratelimit 128 \

- --log-file backupfull.log

//5、启动应用并将访问入口切换为灾备集群负载均衡设备

将业务连接的负载均衡后端地址设置为灾备集群 TiDB 地址

//6、搭建灾备库-->主库的数据同步链路

6.1 编辑搭建从灾备机房到主机房的复制链路所需拓扑文件

- [tidb@cips1 ~]$ vim scale-out-drainer_bak.yaml

-

- drainer_servers:

- - host: 10.3.65.142

- port: 28249

- deploy_dir: /tidb-deploy/drainer-28249

- data_dir: /tidb-data/drainer-28249

- config:

- initial-commit-ts: 440739573139243009(查询上游checkpoint表tso)

- syncer.db-type: "tidb"

- syncer.to.host: "10.3.65.141"

- syncer.to.user: "drainer"

- syncer.to.password: "XXX"

- syncer.to.port: 4000

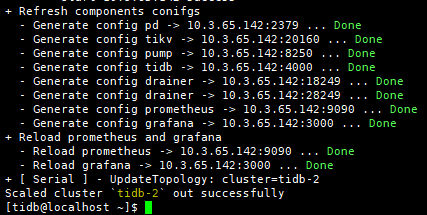

6.2 扩容灾备库到主库的drainer同步链路

[tidb@cips1 ~]$ tiup cluster scale-out cips ./scale-out-drainer_bak.yaml --user tidb -p

//7、切换完成,进行简单验证

登录灾备库grafana页面,查看QPS、connection count等指标,是否符合预期,相关日志是否正常输出。

//注意事项

整个切换过程并不是特别复杂,但需要注意以下几点:

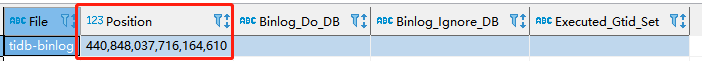

1、查看drainer同步TSO时,不只是通过tidb_binlog.checkpoint表查看,还可以查看drainer日志中write save point对应的TS:["write save point"] [ts=440739573139243009]或登录数据库,执行show master status;,查看Position列对应的TSO:

2、将灾备库数据全量备份,并不是必做选项,只是考虑到如果主库已经故障,业务切换到灾备库的情况下,将数据全量备份以防出现灾备库也故障等极端情况。实际操作过程中,可根据实际情况决定是否需要全量备份。

3、搭建灾备-->主的drainer同步链路时,需注意initial-commit-ts参数只可在新建的时候指定,如果该参数设置有误或需要调整,只能重新部署。

二、总结与思考

灾备切换需要注意的有两点:

1)确保切换前主备数据一致,业务切换到灾备库后,可正常运行。

2)业务切换至灾备库后,增量数据可以在主库恢复后,正常同步至主库,不会有数据丢失。

后续业务回切至主库的操作步骤,与业务切换至备库操作过程一致,按步骤依次进行操作即可。

作者:刘昊| 数据库开发工程师

版权声明:本文由神州数码云基地团队整理撰写,若转载请注明出处。

公众号搜索神州数码云基地,后台回复数据库,加入数据库技术交流群。