- 1AI2019下载Adobe Illustrator CC2019安装教程

- 2基于Springboot的旅游管理系统(有报告)。Javaee项目,springboot项目。

- 3经典网络解(三) 生成模型VAE | 自编码器、变分自编码器|有监督,无监督_vae生成网络详解

- 4如何在 macOS 上安装 Rust 编程语言_rust mac

- 5谈薪谈蹦了,阿里HR说我不配21K...._阿里谈薪

- 6【感受C++的魅力】:用C++演奏歌曲《起风了》——含完整源码_c++演奏起风了

- 7git的分支及标签使用结合全网最详细的情景演示

- 8分布式事务数据一致性解决方案_分布式事务一致性解决方案

- 9uniapp视频播放器(h5+app)_uniapp video @controlstoggle

- 10【免费题库】华为OD机试 - 员工派遣(Java & JS & Python & C & C++)

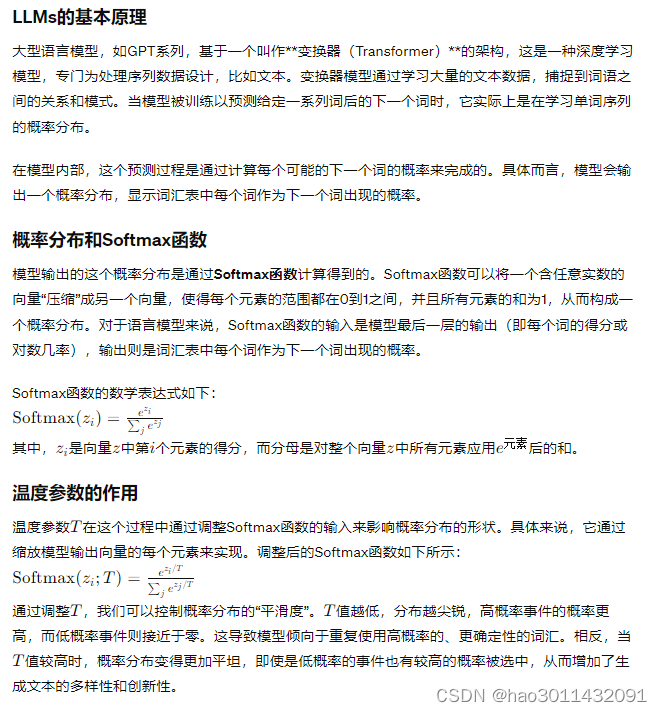

【llm模型-参数解释】-temperature(基于GPT4的返回理解)_llm temperature

赞

踩

在谈论机器学习和人工智能的世界中,"温度"这个术语经常与语言模型(LLMs,Large Language Models)一同出现。今天,我要带你深入了解这一概念,首先从技术细节入手,然后再用大白话解释给你听。

技术细节解释

温度(Temperature),在语言模型的上下文中,是控制模型生成文本多样性的一个参数。具体来说,它影响的是模型在做出下一个词预测时的确定性和随机性程度。

大型语言模型(如GPT系列)在预测下一个词时,实际上是在计算一个概率分布,这个分布覆盖了词汇表中的每一个词。温度参数会对这个概率分布进行调整。其工作原理如下:

温度 = 1:不对概率分布进行任何调整,保持原始输出。这时模型的预测既不会过于保守也不会过于冒险,保持中性状态。

温度 < 1:让概率分布更加尖锐,增加高概率事件的概率,同时降低低概率事件的概率。这会使模型在生成文本时倾向于选择更确定、更常见的词汇,从而生成的文本看起来更加流畅和合理,但可能牺牲一些创意和多样性。

温度 > 1:让概率分布更加平坦,减少高概率事件的概率,同时提高低概率事件的概率。这种调整让模型在生成文本时更愿意冒险,尝试新颖或不常见的词汇组合,从而增加文本的多样性和创新性,但同时也可能降低文本的连贯性和合理性。

补充LLM 的基本原理:

大白话解释

想象你正在和朋友玩一个猜词游戏,你需要根据已有的提示猜下一个词。如果游戏的"温度"设置得低,那就好比你非常谨慎,总是选择最安全、最明显的答案。这样玩游戏虽然稳妥,但有时候可能会显得有点无聊,因为你总是走老路。

相反,如果游戏的"温度"调得高,那就意味着你在游戏中愿意大胆猜测,即便是一些看起来不太可能的词也敢于尝试。这样的游戏充满了惊喜和创新,虽然有时候会猜错,但过程绝对刺激有趣。

而将"温度"设为1,就好比是保持了一种中庸之道,既不会太保守也不会太冒险,试图找到既合理又有趣的平衡点。

在大型语言模型中,调整"温度"参数实际上就是在调节模型生成文本时的"猜词策略"。较低的温度使得模型更加保守,倾向于生成大家都能想到的、平滑流畅的内容。而较高的温度则让模型变得大胆,愿意尝试新奇的表达,给我们带来意想不到的创意。