- 1CLIP 浅析

- 2【多目标进化优化】NSGAII 算法原理与代码实现_hsga-ii 多目标优化算法代码实现

- 33.Spring Security实现JWT token验证_spring security 验证token

- 4mac如何实现升级node版本、切换node版本_node升级

- 5input的type为number时,过滤符号的方法_input number 符号

- 6突破大型语言模型上下文限制的前沿技术_超过大模型上下文限制的例子

- 7Ambari(一) ----Ambari安装遇到的问题及解决方案_安装ambari数据库常见问题

- 8树莓派Pico-Raspberry Pi Pico安装及使用_respberry pi pico

- 9Stable Diffusion学习记录

- 10【单片机毕业设计】【jk-007】口罩识别及红外测温_基于stm32的口罩识别与体温检测

LLama2 CPU Windows 部署-小白踩坑合集_windowsllama 部署

赞

踩

关于Llama下载相关-小白踩坑

1、直接在官网申请(需要梯子):https://ai.meta.com/llama/![]() https://ai.meta.com/llama/

https://ai.meta.com/llama/

申请的时候注意一定要点击下一步,我在这个上面踩过坑,申请过九九八十一次,一直没有收到邮件,结果就是因为…没有点击下一步(没文化真可怕,对英语单词不敏感)

2、huggingface上面也是有很多链接

meta-llama (Meta Llama 2) (huggingface.co)![]() https://huggingface.co/meta-llama

https://huggingface.co/meta-llama

这个里面是通过Cmake+MinGW来编译:

但是这个期间我遇到了非常多的困难,于是我就开始换教程,寻求更详细的解答。

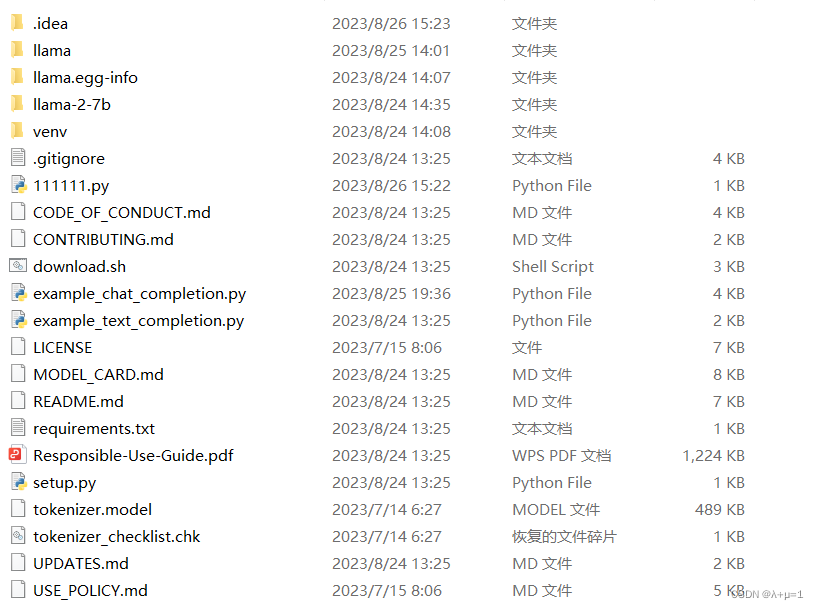

后来我得知,通过这个方法所谓的本地部署出来就是一个llama文件夹:

也就是一个python项目文件,这个时候如果要运行,可以参考一下llama中文社区:

Streamlit![]() https://chinese.llama.family/

https://chinese.llama.family/

里面有很多详细的代码。但是需要GPU。于是我就去搜索CPU的部署方式。

4、如何在低配Windows上部署原版llama.cpp

关于llama.cpp是什么,可以去搜。作为一个小白,我也是在不断探索,我也不懂,我只知道它可以在CPU上面运行,OK,开动!

但是一开始我没有看,因为emm比较抗拒英文。

初期安装参考链接:

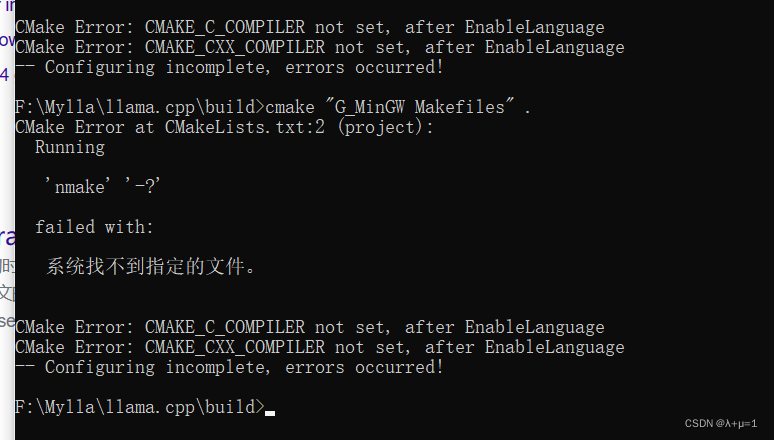

我很执着地安装了Cmake+MinGW,但是遇到了很多很多的问题:

问题1 cmake语句不生效,检查后是因为安装mingw发现bin目录下没有mingw32-make.exe

问题2 如图

问题3 intrin.h mingw error : No such file or directory

解决方案:这个问题我也找了很久,最后我采取的方法是去寻求intrin.h这个头文件然后手动复制到相应文件夹下面(MinGW\include)

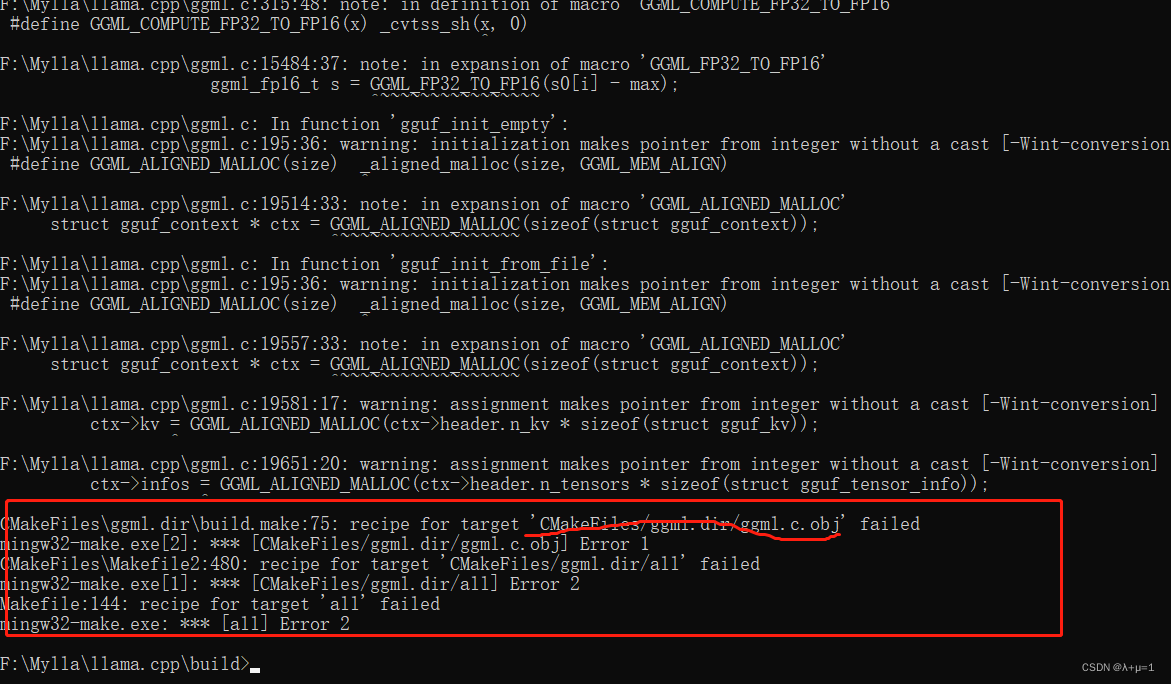

Github地址:GitHub - yuikns/intrin: Compatibility header for GCCCompatibility header for GCC. Contribute to yuikns/intrin development by creating an account on GitHub.![]() https://github.com/yuikns/intrin问题4 最后遇到一个编译问题我一直没有解决

https://github.com/yuikns/intrin问题4 最后遇到一个编译问题我一直没有解决

在执行cmake –build . –config Release遇到的

最后我放弃了这个办法,开始向他人求助,我还是回到了官方文档:

https://github.com/ggerganov/llama.cpp![]() https://github.com/ggerganov/llama.cpp

https://github.com/ggerganov/llama.cpp

然后准备利用w64devkit的方法,最后我需要一个什么Object C,不知道是不是因为没装好Visual Studio的原因,反正我放弃了,,,最后用了别人编译好的llama.cpp文件,是同学分享给我的。里面模型文件我去掉了,如果可以的话我把它分享出来:

链接:https://pan.baidu.com/s/1NUeZNT3SlT5ZeSaW1WNvEA

提取码:hbib

(这个是编译好的)

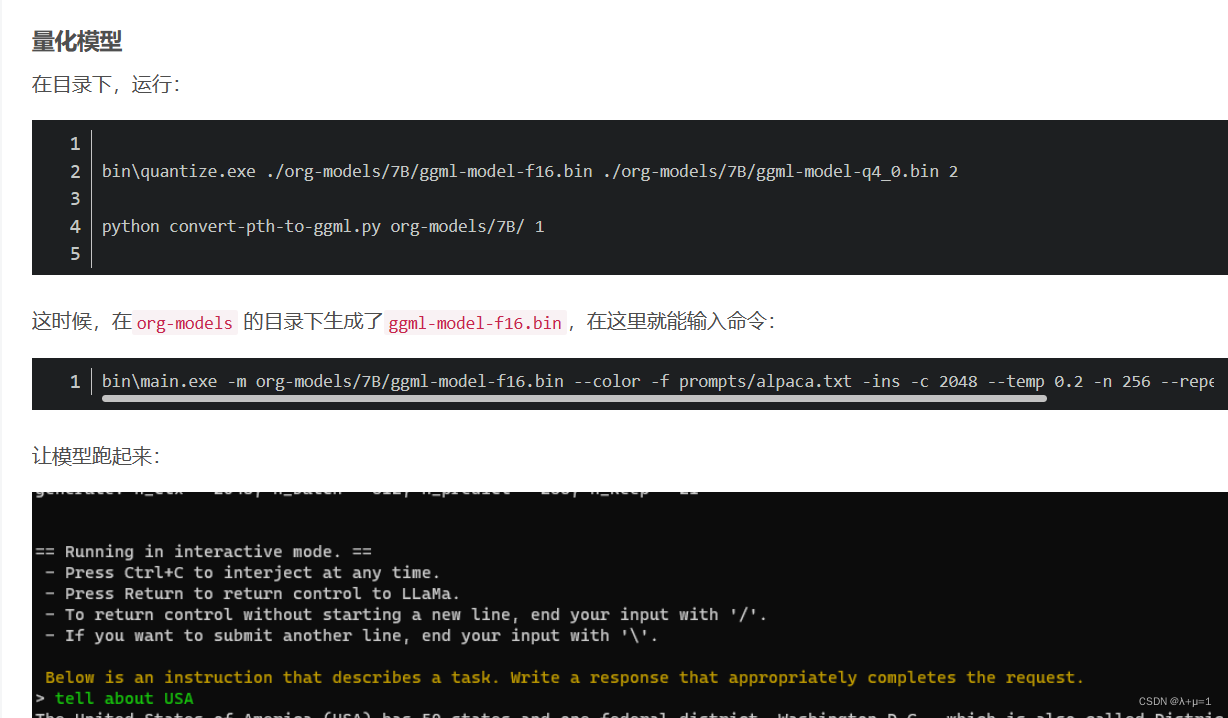

的“量化模型”步骤:

最后就成功啦!

但是注意一定要装以下Visual Studio:

我因为之前安装失误就遇到这个问题,最后我重新安装了一下,建议Visual Studio 2022

5、llama-python-cpp:

https://github.com/abetlen/llama-cpp-python

https://www.bilibili.com/video/BV1H14y1X7kD/?spm_id_from=333.337.search-card.all.click

https://www.bilibili.com/video/BV1H14y1X7kD/?spm_id_from=333.337.search-card.all.click