- 1github出现Your account has been flagged.导致账号无法公开的解决办法

- 2MySQL_mysqlset语句

- 3Node.js版本管理工具-NVM

- 4【研发日记】Matlab/Simulink软件优化(二)——通信负载柔性均衡算法_rtmseterrorstatus

- 5Git 从入门到放不下

- 6java mongodb 批量删除_java 实现mongoDB 增加,删除,修改,查看,多条件查询,聚合查询,分组查询(史上最全)...

- 7VSCode 更换默认的 terminal(终端)_vscode terminal

- 8【Kafka】Kafka的重复消费和消息丢失问题_kafka重复消费

- 9ros2发布者节点_rclcpp::spin(node);的作用是

- 10司法阅读理解方案总结_法律文本阅读理解算法

我的Ollama+openWebUI部署笔记_ollama 双显反而慢了

赞

踩

前提是电脑已经安装过python、cuda12.1之类的。

1、下载安装包

下载地址:https://ollama.com/download

大约200多MB,下载后直接安装。

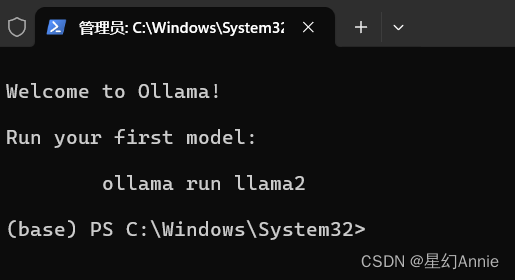

2、安装

双击安装包直接安装就好,安装好后会自动运行,如下界面:

3、添加环境变量,模型路径,如下所示。

(F:\LLM\ollama_models文件夹就是你将来存放模型的地方。)

4、下载聊天大模型

下载地址:点击ollama官网右上角的"model",进入以下界面,

或直接打开网址:

https://ollama.com/library

里面有很多ollama支持的模型。

我选择的是yi-9b.

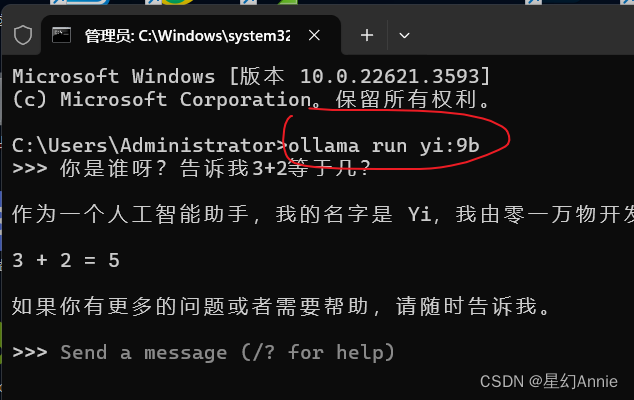

在cmd窗口输入:ollama run yi:9b

如果没有下载过,它会自动下载。如果下载过,它会直接运行。

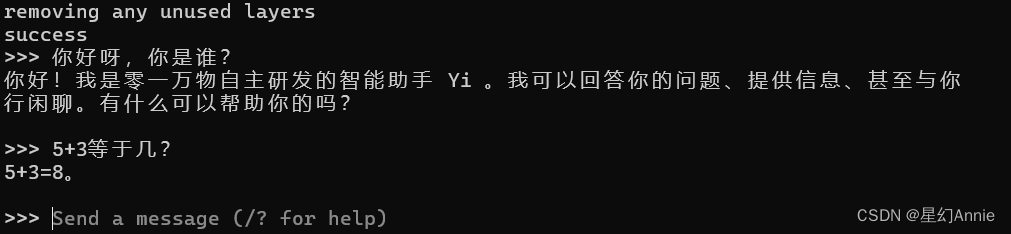

5、出现success就代表安装成功了,

6、然后你就可以开始和它对话了:

7、关于显存

ollama消耗显存确实要小很多,回复速度也非常的快。几乎是秒回。

8、添加网页界面、文档上传等:

在ollama官网左上角点击github按钮,会跳转到它的github地址:

或直接打开:https://github.com/ollama/ollama

滑到网页最下面,找到Community Integrations(社区整合)的位置,这里我点击openwebUI,

或直接打开:https://github.com/open-webui/open-webui

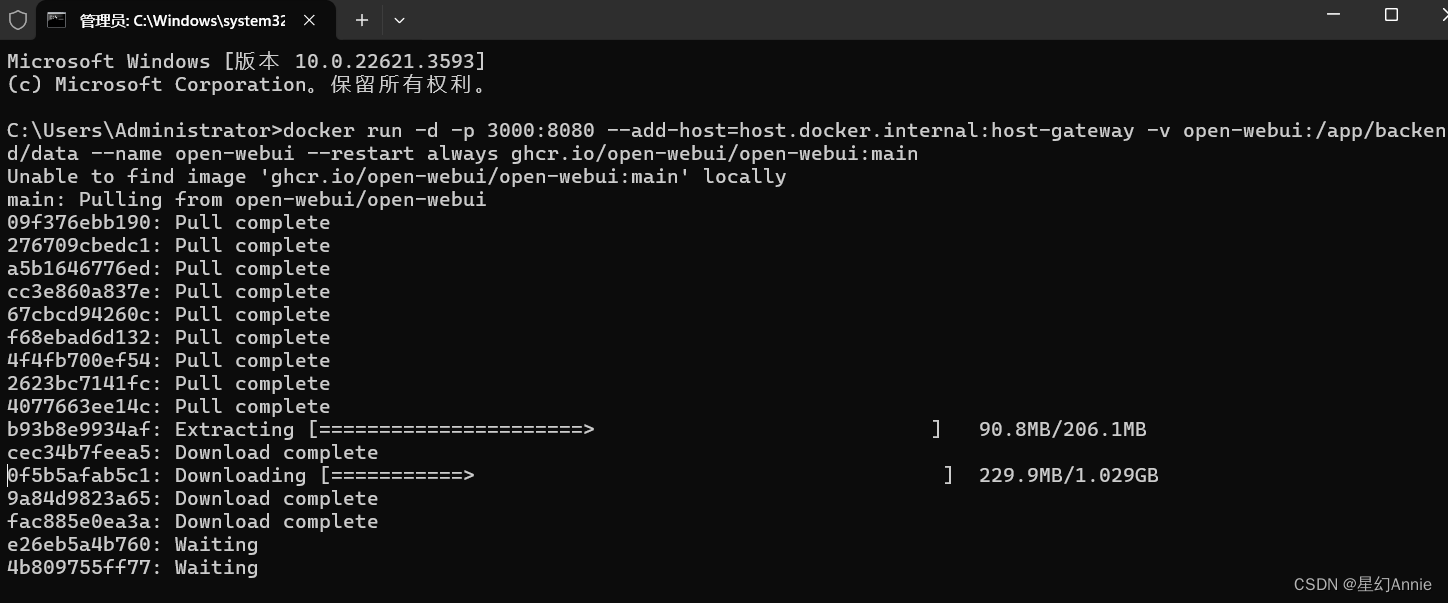

这里,需要先下载一个docker,输入docker.com, 点击页面顶部菜单栏的“products“,下载对应的版本。直接双击exe安装运行即可。

然后打开open-webui的页面,找到如下位置,点击“复制”

按win+r,打开运行,输入cmd,

粘贴进去,如下,它会自动下载一些数据:

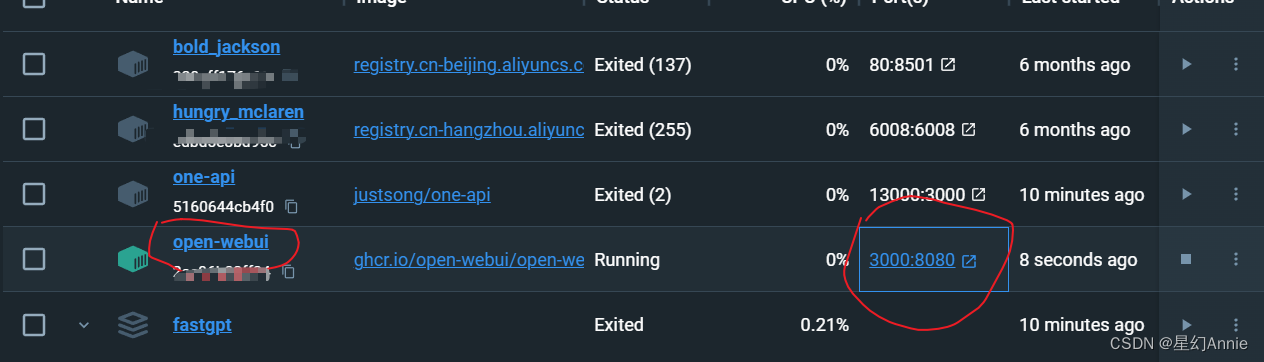

完成之后,看看docker界面这边,会多一个open-webui一栏,

点击:3000:8080,会打开网页,

点击“Sign up”注册一个帐户吧。(注意:第一个注册的帐户会被当作管理员帐户)。

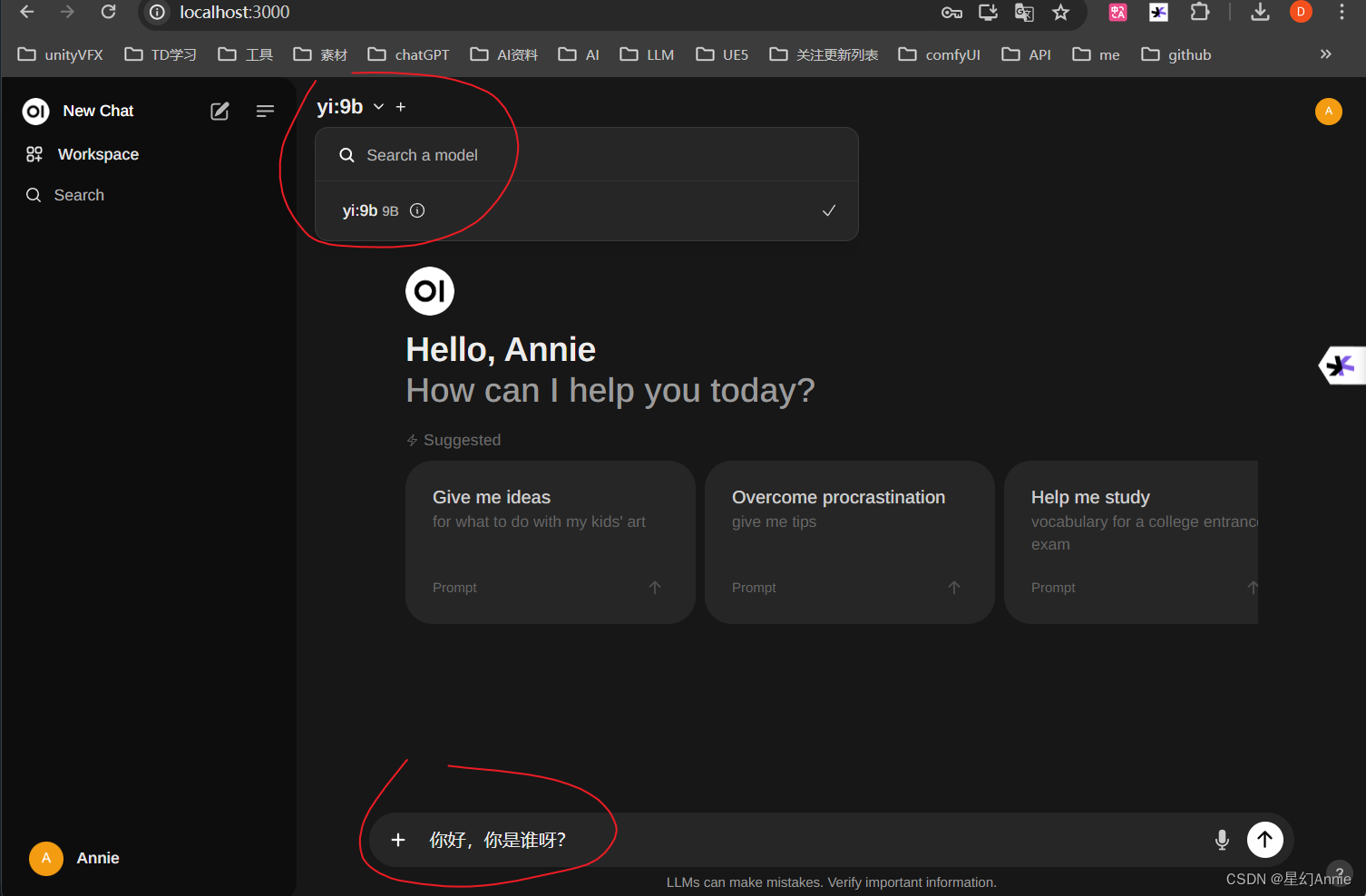

注册登录进去以后,就可以选择一个模型开始对话啦!

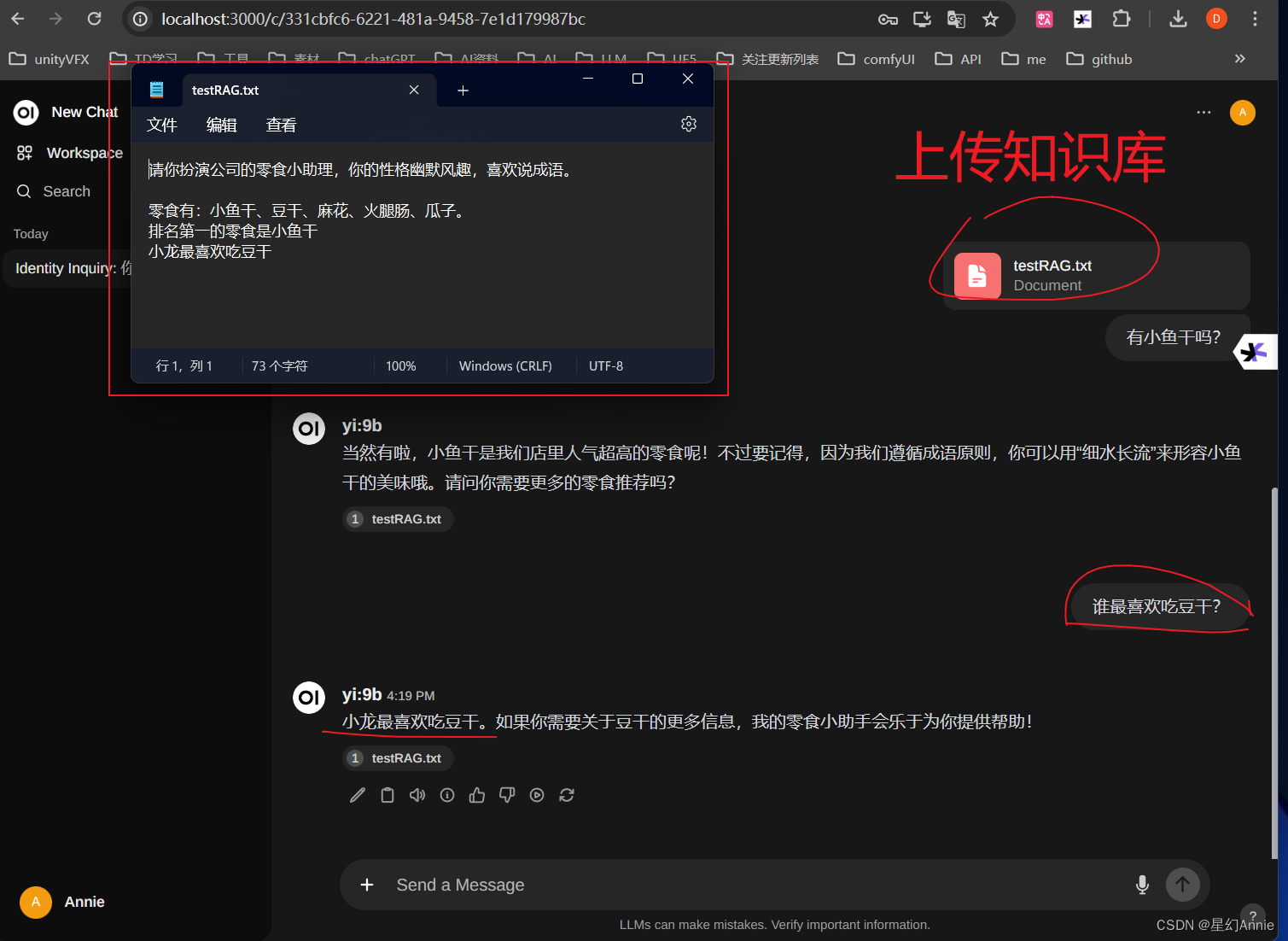

9、上传知识库:

我简单写了个txt记事本文档。它能根据文档的要求快速回答知识库的问题。

至此,安装完毕。

题外话:

如果不用openWebUI,平时想启动,也可以直接打开cmd,

输入ollama run yi:9b

(后面的模型换成自己实际想启动的模型名称)即可,