- 1RK3568 OpenHarmony3.2 音频Audio之MIC调试_openharmony 麦克风

- 2LangChain - 01 - 快速开始_to install langchain-community run `pip install -u

- 3Python缺失值处理_python连续变量缺失值

- 4nn.MultiheadAttention详解 -- forward()中维度、计算方式_multi_head_attention_forward

- 5在pycharm中导入pytorch项目 | 10-10-2020_pycharm导入pytorch没有python.exe

- 6零基础HTML入门教程(21)——无序列表_web无序列表代码

- 7自然语言处理 - Language model和RNN_rnn language model

- 8深度学习-GRU_深度学习中的gru

- 9Android Jetpack:简化开发、提高Android App质量的利器

- 10个人记录jenkins编译ios过程 xcode是9.4.1_jenkins xcodebuild' requires xcode, but active dev

大模型应用开发框架【LLM】_dust.tt

赞

踩

随着人工智能的能力,特别是大型语言模型 (LLM) 的不断发展和演变,开发人员正在寻求将 AI 功能整合到他们的应用程序中。 虽然文本完成和摘要等简单任务可以通过直接调用 OpenAI 或 Cohere 提供的 API 来处理,但构建复杂的功能需要付出努力和工具。

推荐:用 NSDT场景设计器 快速搭建3D场景。

Jon Turow 和他在 Madrona 的团队首先指出了这一点,他们指出

开发人员必须为提示工程、微调、蒸馏以及组装和管理将查询引用到适当端点的管道等步骤发明自己的工具。

- “Foundation Models: The future isn’t happening fast enough — Better tooling will make it happen faster ” Madrona Ventures

在本文中,我们将探索三个开源 AI 框架,它们可以帮助开发人员更快地构建 AI 功能但首先,让我们仔细看看这些框架需要提供哪些功能才能有效。

- 基础模型抽象:要构建 AI 驱动的应用程序,开发人员需要访问最新最好的基础模型。 然而,随着新模型的出现,跟上升级和变化可能具有挑战性。

- 提示管理:提示在 AI 中变得越来越重要,它是我们用来与基础模型进行交流的语言。 然而,开发和管理提示对于开发人员来说可能是一项复杂的工作。

- 上下文管理:由于开发人员将多个调用链接到 LLM,管理上下文和协调调用之间的数据可能是一个重大障碍,尤其是在构建复杂的 AI 驱动的应用程序时。

那么谁是 AI 框架领域的新玩家? 它们会成为 Rails、Laravel 和 Express 在 Web 开发中的地位吗?

1、dust.tt

Dust.tt 是最早的开源人工智能框架之一。 它是用 Rust 编写的,允许开发人员使用其他工具链接调用 LLM,以提取所需的输出。 Dust.tt 使用 OpenAI、AI21 和 Cohere 等语言模型,并具有用于 Google 搜索、curl 和网络抓取(包装 browserless.io)的集成块。

关键概念:Dust.tt 应用程序包含一系列按顺序执行的块。 每个块都会产生输出,并且可以引用先前执行的块的输出。 Dust.tt 应用程序开发人员定义每个块的规范和配置参数。

例子:在下面的示例中(来自 Dust 文档),Dust 应用程序使用 AI 为结婚礼物编写个性化的感谢信。

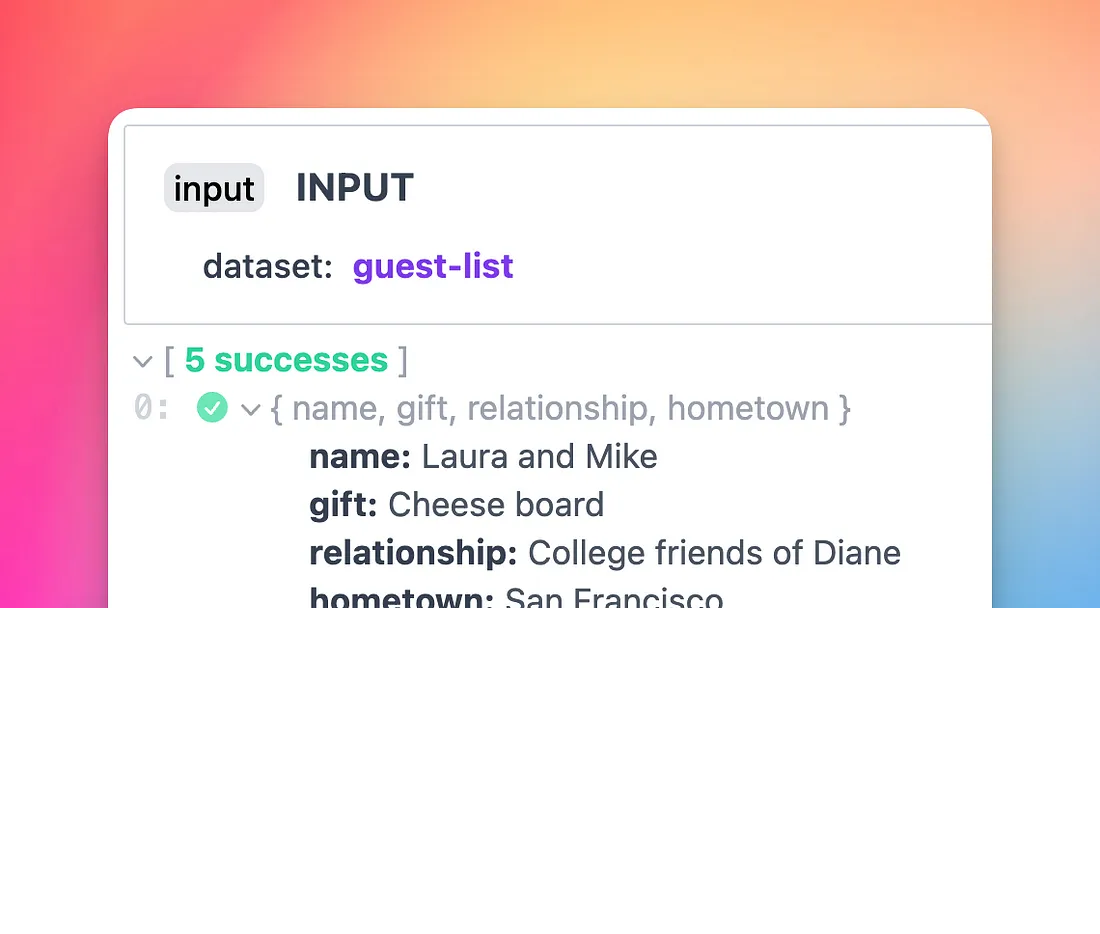

首先我们设置一个带有客人列表的输入块:

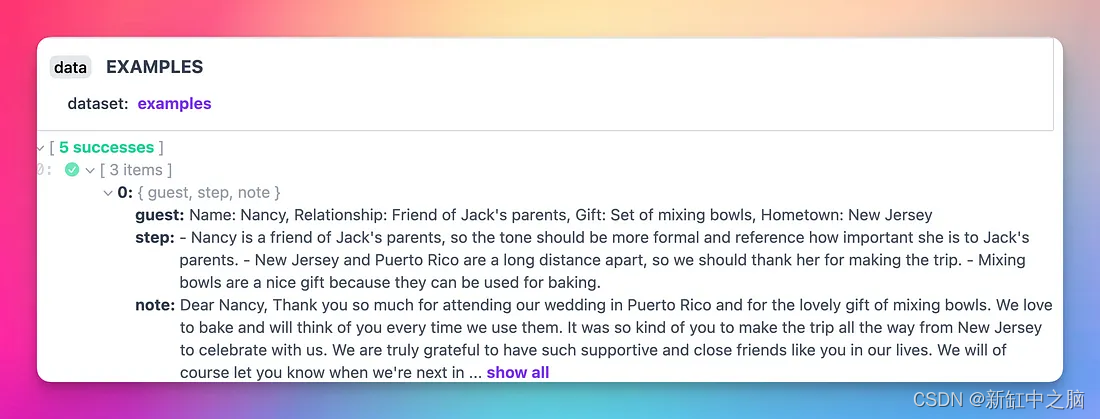

然后我们设置一个带有示例的训练块。

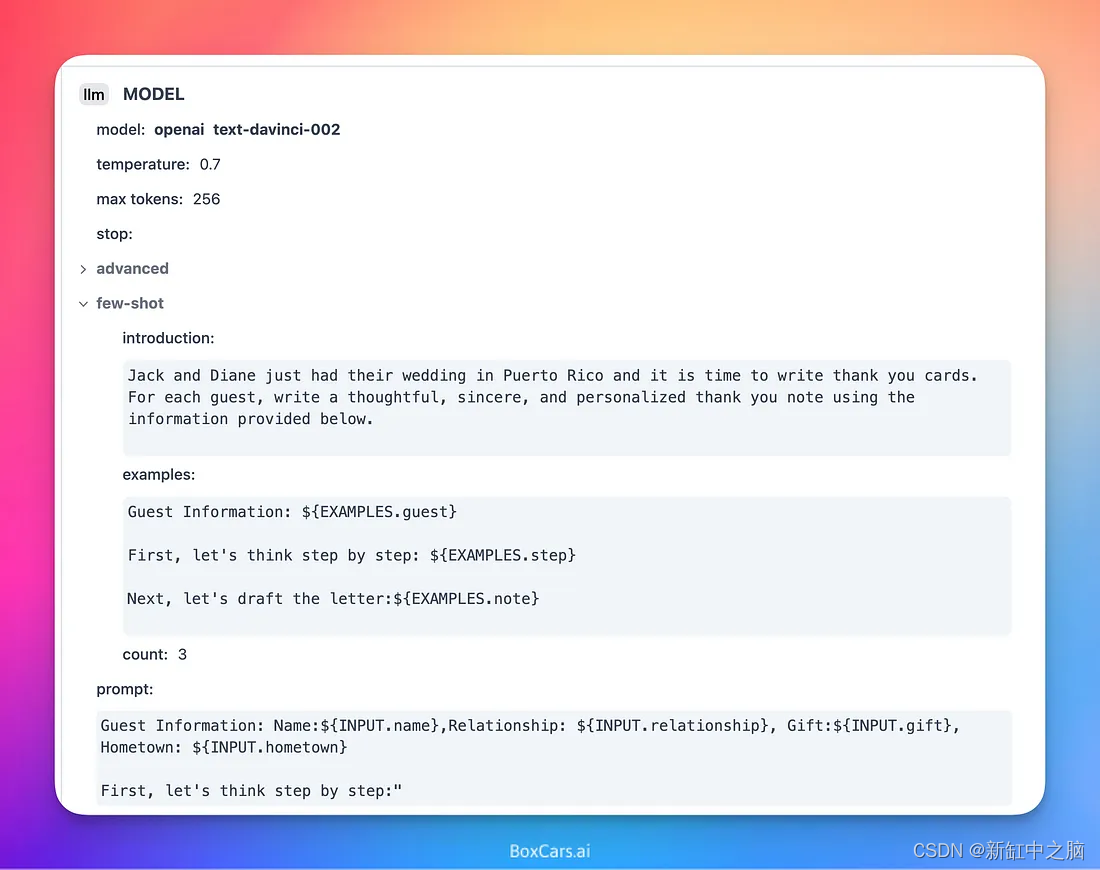

然后我们用输入和训练示例调用 LLM。

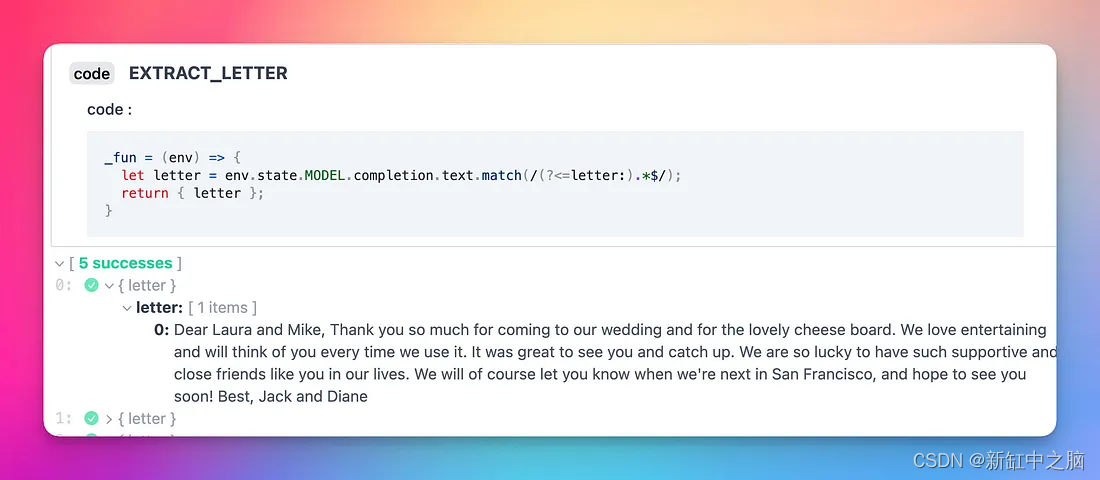

最后,我们提取结果。

2、LangChain

Langchain 是一个开源 Python 库,允许开发人员以可组合的方式使用语言模型 (LLM) 构建 AI 驱动的应用程序。 借助 Langchain,可以创建聊天机器人、问答系统和其他人工智能代理。

关键概念:开发人员使用“链”连接组件来构建他们的 AI 应用程序。 该库提供了一组构建块,包括输入/输出、处理和实用程序块,可以将它们组合起来创建自定义链。

例子:在这个例子中(来自他们的文档),代码要求 LLM 命名一家生产产品的公司,然后它要求 LLM 为公司写一个标语。

from langchain.prompts import PromptTemplate from langchain.llms import OpenAI from langchain.chains imporpt LLMChain from langchain.chains import SimpleSequentialChain llm = OpenAI(temperature=0.9) prompt = PromptTemplate( input_variables=["product"], template="What is a good name for a company that makes {product}?", ) chain = LLMChain(llm=llm, prompt=prompt) # Run the chain only specifying the input variable. print(chain.run("colorful socks")) second_prompt = PromptTemplate( input_variables=["company_name"], template="Write a catchphrase for the following company: {company_name}", ) chain_two = LLMChain(llm=llm, prompt=second_prompt) overall_chain = SimpleSequentialChain(chains=[chain, chain_two], verbose=True) # Run the chain specifying only the input variable for the first chain. catchphrase = overall_chain.run("colorful socks") print(catchphrase)LangChain also has agents. An Agent enables you to dynamically build chains based on user input and the tools you provide.

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

在下面的代码中(来自 Langchain 文档),代理被初始化并提供了搜索和运行数学运算的工具。

from langchain.agents import load_tools

from langchain.agents import initialize_agent

from langchain.llms import OpenAI

llm = OpenAI(temperature=0)

tools = load_tools(["serpapi", "llm-math"], llm=llm)

agent = initialize_agent(tools, llm, agent="zero-shot-react-description", verbose=True)

agent.run("Who is Leo DiCaprio's girlfriend? What is her current age raised to the 0.43 power?")

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

"Camila Morrone is Leo DiCaprio's girlfriend and her current age raised to the 0.43 power is 3.991298452658078."

- 1

Langchain 已经流行起来,现在拥有大量的集成。 一个新项目正在进行中,将其移植到 TypeScript,从而可以构建 AI 驱动的 JavaScript 应用程序。

目前可用的一些集成包括 OpenAI、Cohere、GooseAI、Hugging Face Hub、Petals、CerebriumAI、PromptLayer、SerpAPI、GoogleSearchAPI、WolframAlphaAPI、NatBot、Wikipedia、Elasticsearch、FAISS、Manifest、OpenSearch、DeepLake。

3、BoxCars

披露:BoxCars是我的开源项目。

BoxCars 是受 Langchain 启发的开源 gem,可简化向 Ruby-on-Rails 应用程序添加 AI 功能的过程。

关键概念:在 BoxCars 中,train包括引擎 (LLM) 和 Boxcars(工具)。 train使用指定的工具协调对 LLM 的调用。 例如,以下代码使用 LLM、Google 搜索和计算器。

boxcars = [Boxcars::Calculator.new, Boxcars::Serp.new]

train = Boxcars.train.new(boxcars: boxcars)

puts train.run "What is pi times the square root of the average temperature in Austin TX in January?"

- 1

- 2

- 3

BoxCars 的设计理念与 Ruby on Rails 相同。 它包括一个 ActiveRecord BoxCar,使得与 Rails 应用程序的本地集成变得容易。 在下面的示例中,ActiveRecord BoxCar 设置了模型(Ticket、User、Comments),然后跨模型提问。 LLM 生成返回结果的 ActiveRecord 代码。

helpdesk = Boxcars::ActiveRecord.new(name: 'helpdesk', models: [Ticket, User, Comment])

helpdesk.run "how many comments do we have on open tickets?"

- 1

- 2

**`> Entering helpdesk#run**how many comments do we have on open tickets?

Comment.where(ticket: Ticket.where(status: 0)).count

Answer: 4

**< Exiting helpdesk#run**`

Out[7]:

`"Answer: 4"`

- 1

- 2

- 3

- 4

- 5

- 6

4、结束语

这些框架还不到一年的历史,并且发展迅速; 毫无疑问,未来还会有更多。 好消息是,如果你正在考虑将 AI 功能添加到您的应用程序中,帮助就在路上。

原文链接:LLM应用开发框架 — BimAnt

![[转]深度学习 Transformer架构解析_transformer架构拆解](https://img-blog.csdnimg.cn/img_convert/cdbc0514f5d80c18acf428c9dc8863c1.png?x-oss-process=image/resize,m_fixed,h_300,image/format,png)