- 1前端面试笔记随笔---kalrry

- 2前端小白入门区块链系列04

- 3如何写好简历_工作经历由近至远

- 4Backend - Django Swagger

- 5[NAS]MCUNet: Tiny Deep Learning on IoT Devices

- 6(一)RecycleView 复用机制onCreateView和onBindView调用关系_android onbindviewholder oncreateviewholder

- 7【Python】Django、Flask、Tornado的框架性能分析_flask 性能

- 8PostgreSQL日志管理

- 9【洛谷 P9241】[蓝桥杯 2023 省 B] 飞机降落 题解(深度优先搜索+暴力枚举+剪枝)_蓝桥杯飞机降落

- 10JDK各个版本安装以及配置,超详细_jdk老版本

大模型学习路线(3)——知识检索增强(RAG)_大模型知识引擎

赞

踩

目录

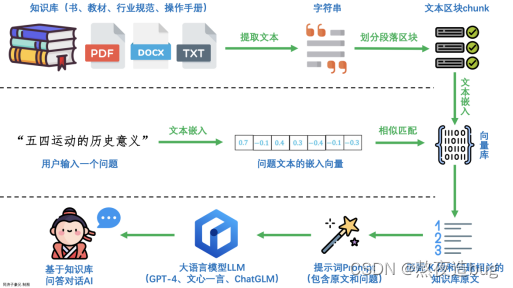

上图为LLM+RAG运行的整体流程。如果想对RAG有系统化的理论认知,基本看如下三篇技术概览足矣,其它不再多做赘述了,毕竟没必要重复造轮子(bushi。

章节一的三篇技术概览了RAG理论部分,从RAG整体流程介绍,到RAG流程涉及每一步骤的细节详解、常用技术,再到总结、当下发展、未来展望。章节二为进阶部分,介绍了RAG的关键技术。章节三介绍了RAG的实践,RAG之前跑的demo忘保存了,找时间补回来,留个坑位先......(饼先搁这画上了)。

RAG内容为LLM岗重点考察内容,涉及知识点多的嘞!!!

一、 RAG理论篇(基础)

- RAG技术概览(一)高级检索增强生成技术(RAG)全面指南:原理、分块、编码、索引、微调、Agent、展望 - 知乎 (zhihu.com)

- RAG技术概览(二)深度好文!最全的大模型 RAG 技术概览 - 知乎 (zhihu.com)

- RAG技术概览(三)RAG实战全解析:一年探索之路 - 知乎 (zhihu.com)

二、RAG理论篇(进阶)

1. Token分词

2. Embedding技术

3.知识向量库

4.相似性搜索/向量检索

5.知识召回

5.1. 知识召回流程

(此处cue一下推荐系统的知识召回。针对推荐系统,后续也会进行系统的学习+实践+专栏整理,埋个坑先......)

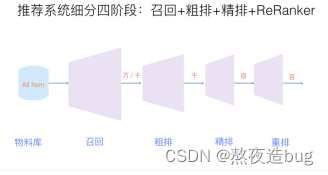

图5.1 知识召回+Rank排序

(1)物料库经过Tokensize、Embedding后,得到Vectors,扔进向量数据库进行初步检索和知识召回(对称召回和非对称召回);

(2)初步召回得候选集进行粗排;

(3)粗排后,对候选集进行精排,根据Q & A的匹配程度/相似度进行Rank排序,挑选Top K个答案。涉及多种技术,包括文本召回、向量召回、推荐召回、标签召回、Embedding召回、协同召回、图召回等,以及多种召回算法混合的多路召回;(召回方法如何选择,一看具体的业务场景,二看准确率和召回速度上的平衡。一般来说,多路召回效果好、但召回和推理速度很慢,单路召回速度快,但准确率可能会有所损失。)

(4)Rerank,得到Top K检索结果,以及各检索项的得分。

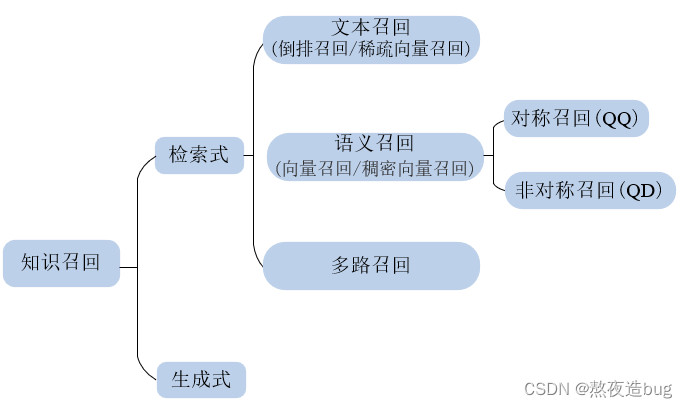

5.2. RAG知识召回分类

分生成式和检索式召回(文本召回、语义召回、多路召回)召回两个角度。重点分析检索式召回和文本召回、语义召回的优缺。

图5.2 LLM常用知识召回分类

| 召回分类 | 文本召回(/倒排召回/稀疏向量召回) | 语义召回(/向量召回/稠密向量召回) |

| 优点 | (1)检索速度更快; (2)可解释能力强; (3)精确匹配能力强; (4)支持自定义停用词表,同义词表。 | (1)考虑语义相似性,更加智能; (2)语义相近即可召回,无需寻找同义词替换; (3)无需考虑复杂的传统倒排的调优手段; (4)具备支持跨模态召回的潜力。 |

| 缺点 | (1)无语义信息,对“一词多义”不友好; (2)语义偏移。 | 需要模型训练,对垂直领域落地支持有限: (1)垂直领域泛化性不足(不理解专有词汇;易出现语义相似但主题不相似的情况); (2)对精准匹配支持不足,难以用专业词汇精准召回; (3)可解释能力弱; (4)需要更多的计算资源; (5)对”多词一义”情况的支持不如倒排召回中的同义词表简单直接。 |

三、RAG实践篇

蹲坑ing......

(下班!!!明天再补剩余内容!!!)