热门标签

热门文章

- 1Python小白学习:超级详细的字典介绍(字典的定义、存储、修改、遍历元素和嵌套)_python 定义字典

- 2C语言排序算法之冒泡排序_冒泡算法c语言程序

- 3extcon驱动及其在USB驱动中的应用

- 4(建议收藏)OpenHarmony系统能力SystemCapability列表

- 5ios微信浏览器App下载链接怎样跳转到苹果App Store_ios在微信浏览器跳转appstore

- 6Ardupilot代码学习笔记

- 7Bert生成句向量(tensorflow)_max_seq_len

- 82023最新AI绘画Midjourney注册使用教程_midjourney 2023 mac

- 9使用YOLOv8和Grad-CAM技术生成图像热图_yolov8 gradcam

- 10jmeter+ant+jenkins进行结合,实现Web HTTP请求的接口自动化测试_jmeter+jenkins+ant的测试报告获取请求接口

当前位置: article > 正文

Spark学习之路——5.Spark UI_如何通过spark ui查看spark任务执行过程

作者:小小林熬夜学编程 | 2024-04-19 00:08:59

赞

踩

如何通过spark ui查看spark任务执行过程

一、Spark UI解读

Jobs页面可以看到所有Jobs的执行情况,job的数量取决于action算子的数量。

Stages页面列出所有Stage的执行情况。Spark stage切分是按照宽依赖来区分的,因此粒度上要比job更细一些。

Storage页面显示所做的cache persist等操作。

Environment页面里面展示了当前spark所依赖的环境,比如jdk,lib等等

Executors页面显示executor运行情况,这里可以看到执行者申请使用的内存以及shuffle中input和output的内存等数据。

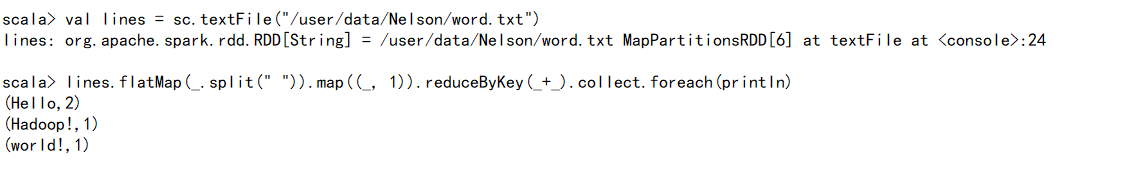

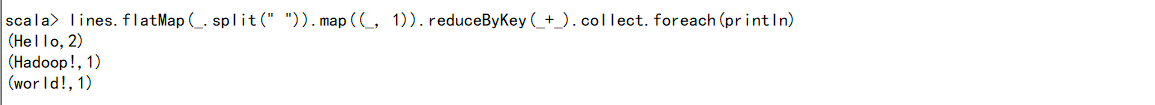

二、分别用local/standalone/yarn模式运行workcount

1.通过Spark UI来查看执行进度:

①Local模式:

②standalone模式

③yarn模式

2.截取执行成功后输出的结果

①local模式

②standalone模式

③yarn-client模式

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/小小林熬夜学编程/article/detail/448991

推荐阅读

相关标签