热门标签

热门文章

- 1C++快速排序算法_快速排序算法c++代码

- 2centos开启ssh服务命令

- 3Flutter学习之路由传参_flutter有状态组件怎么使用路由接参

- 4生成式 AI 的发展方向:Chat 还是 Agent?_agent是生成式ai

- 51厘米?RTK怎样才能达到1厘米的精度!?_rtk厘米级定位

- 6zookeeper集群及消息队列kafka_zk查看kafka信息

- 7OPPO芯片子公司ZUKU说散就散,打工人太难了

- 8Unity3d笔记2-Rigidbody和CharacterController的区别_charactercontroller和rigidbody的区别

- 9Java的特点和优势

- 10网络基础以及Nginx实现反向代理_nginx反向代理配置

当前位置: article > 正文

如何在huggingface上申请下载使用llama2/3模型

作者:小舞很执着 | 2024-08-19 00:28:34

赞

踩

如何在huggingface上申请下载使用llama2/3模型

1. 在对应模型的huggingface页面上提交申请

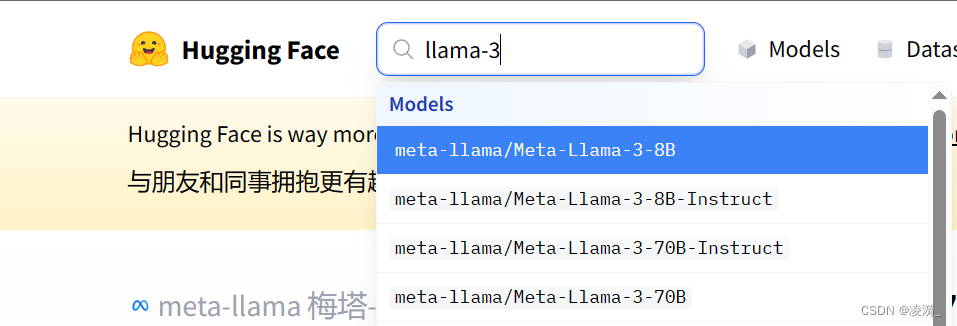

搜索对应的模型型号

登录huggingface,在模型详情页面上,找到这个表单,填写内容,提交申请。需要使用梯子,country填写梯子的位置吧(比如美国)

等待一小时左右,会有邮件通知。

- 创建access token

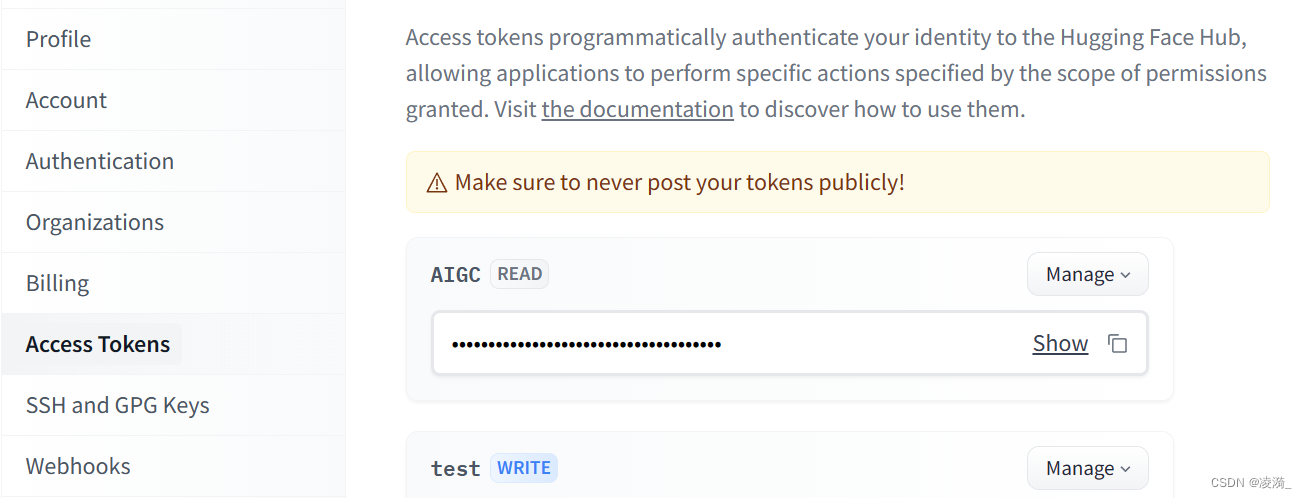

在huggingface上登录后,点击头像,选择setting,点击左侧的access tokens,新建一个token,注意勾选权限为llama3模型

然后复制token。注意,由于其只会出现一次,所以记得保存在其他安全的地方

3. 使用huggingface cli下载模型

pip install -U huggingface_hub

- 1

export HF_ENDPOINT=https://hf-mirror.com

- 1

huggingface-cli download --resume-download 模型名称 --local-dir 存放模型的位置 --local-dir-use-symlinks False --resume-download --token token序列号xxxxxxx

比如

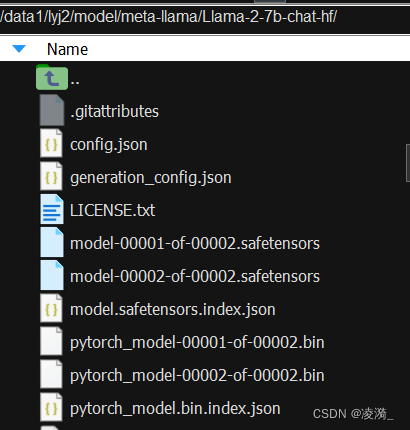

huggingface-cli download --resume-download meta-llama/Llama-2-7b-chat-hf --local-dir /data1/user/model/meta-llama/Llama-2-7b-chat-hf/ --local-dir-use-symlinks False --resume-download --token xxxxx

- 1

这样就可以下载好啦

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/小舞很执着/article/detail/999904

推荐阅读

相关标签