- 1Python学生管理系统

- 2计算机组成与设计实验二:单周期CPU设计_实验二:单周期cpu设计

- 3frp内网穿透搭建-宝塔版

- 4信息安全毕业设计题目汇总 网络安全毕设选题_信息安全选题

- 5k8s中 分布式存储器longhorn的安装_longhorn 安装

- 6git 报错--unable to access ‘https://XXX/imooc-visualization.git_git unable to access

- 7gensim提取一个句子的关键词_HanLP《自然语言处理入门》笔记--9.关键词、关键句和短语提取...

- 8Kubernetes 持久卷_volumeclaimtemplates

- 9如何在centos8中安装中文输入法(系统自带中文输入法)_centos8中文输入法

- 10signature=48af92c80b14d6f07db6ad0b6715c38e,api-sdk/yarn.lock at 45ab63baf852b160338d58e36cfed960ae7d...

全网最全python爬虫+数据分析资源整理_python数据分析资源

赞

踩

4.29(第二天)

开篇词

你为什么需要数据分析能力?

第一模块:数据分析基础篇 (16讲)

01丨数据分析全景图及修炼指南

02丨学习数据挖掘的最佳路径是什么?

03丨Python基础语法:开始你的Python之旅

04丨Python科学计算:用NumPy快速处理数据

05丨Python科学计算:Pandas

06 | 学数据分析要掌握哪些基本概念?

07 | 用户画像:标签化就是数据的抽象能力

08 | 数据采集:如何自动化采集数据?

09丨数据采集:如何用八爪鱼采集微博上的“D&G”评论

10丨Python爬虫:如何自动化下载王祖贤海报?

11 | 数据科学家80%时间都花费在了这些清洗任务上?

12 | 数据集成:这些大号一共20亿粉丝?

13 | 数据变换:考试成绩要求正态分布合理么?

14丨数据可视化:掌握数据领域的万金油技能

15丨一次学会Python数据可视化的10种技能

16丨数据分析基础篇答疑

第二模块:数据分析算法篇 (20讲)

17 丨决策树(上):要不要去打篮球?决策树来告诉你

18丨决策树(中):CART,一棵是回归树,另一棵是分类树

19丨决策树(下):泰坦尼克乘客生存预测

20丨朴素贝叶斯分类(上):如何让机器判断男女?

21丨朴素贝叶斯分类(下):如何对文档进行分类?

22丨SVM(上):如何用一根棍子将蓝红两色球分开?

23丨SVM(下):如何进行乳腺癌检测?

24丨KNN(上):如何根据打斗和接吻次数来划分电影类型?

25丨KNN(下):如何对手写数字进行识别?

26丨K-Means(上):如何给20支亚洲球队做聚类?

27丨K-Means(下):如何使用K-Means对图像进行分割?

28丨EM聚类(上):如何将一份菜等分给两个人?

29丨EM聚类(下):用EM算法对王者荣耀英雄进行划分

30丨关联规则挖掘(上):如何用Apriori发现用户购物规则?

31丨关联规则挖掘(下):导演如何选择演员?

32丨PageRank(上):搞懂Google的PageRank算法

33丨PageRank(下):分析希拉里邮件中的人物关系

34丨AdaBoost(上):如何使用AdaBoost提升分类器性能?

35丨AdaBoost(下):如何使用AdaBoost对房价进行预测?

36丨数据分析算法篇答疑

第三模块:数据分析实战篇 (7讲)

37丨数据采集实战:如何自动化运营微博?

38丨数据可视化实战:如何给毛不易的歌曲做词云展示?

39丨数据挖掘实战(1):信用卡违约率分析

40丨数据挖掘实战(2):信用卡诈骗分析

41丨数据挖掘实战(3):如何对比特币走势进行预测?

42丨当我们谈深度学习的时候,我们都在谈什么?

43丨深度学习(下):如何用Keras搭建深度学习网络做手写数字识别?

第四模块:数据分析工作篇 (2讲)

44丨如何培养你的数据分析思维?

45丨求职简历中没有相关项目经验,怎么办?

加餐 (1讲)

加餐丨在社交网络上刷粉刷量,技术上是如何实现的?

结束语 (1讲)

当大家都在讲知识和工具的时候,我更希望你重视思维和实战

结课测试 (1讲)

结课测试 | 数据分析的这些知识,你真的掌握了吗?

开篇词 | 你为什么需要数据分析能力?

你好,我是陈旸,清华大学计算机系博士毕业。清华有一门课,叫数据挖掘,正是通过这门课,我学会了如何从海量的数据中找到关联关系,以及如何进行价值挖掘。那时候感觉自己掌握了一门利器,就特别想找到一个钉子,来试试自己手里的这把锤子。

当时恰好赶上 2009 年微博的热潮。我用 3 个月的时间就积累了 4 万粉丝,一年的时间积累了上百万粉丝。这是怎么做到的呢?

通过数据采集,我收集了每天的微博热点,然后对热点进行抓取、去广告,再让机器定时自动进行发布。同时我让账号每天都去关注明星的粉丝列表,这样可以获得 15% 的回粉概率。久而久之,就会有源源不断的粉丝。

你看,其实就是数据分析帮我做到了微博的自动化运营。这还只是一个小例子,数据分析的影响已经渗透到了我们工作生活的方方面面。

通过数据分析,我们可以更好地了解用户画像,为企业做留存率、流失率等指标分析,进而精细化产品运营。

如果你关注比特币,数据分析可以帮助你预测比特币的走势。

面对生活中遇到的种种麻烦,数据分析也可以提供解决方案,比如信用卡反欺诈,自动屏蔽垃圾邮件等。

- 1

- 2

- 3

- 4

- 5

可以说,我们生活在数据驱动一切的时代,数据挖掘和数据分析就是这个时代的“淘金”,从国家、企业、组织到个人,都一定会关注各种数据,从这些数据中得到价值。

也正是这个原因,数据分析人才成了香饽饽,不管是数据分析师,数据分析工程师,还是数据产品经理,有数据思维的运营人员,都变得越来越抢手。你是不是也已经摩拳擦掌,做好了了解这一领域的准备呢?

我想在接下来的 15 周时间里,把自己在清华学习数据挖掘的体会和工作实践中对数据分析的理解,重新梳理整合呈现给你,和你一起在数据分析这个领域来一场急行军。

说了这么多数据分析的重要性,你是不是有这样的疑问:我也知道数据分析能力很重要,但是数据分析是不是很难?到底该怎么学呢?

其实这里有一些误区,数据分析并非遥不可及,它不难,掌握高效的学习方法很重要;但是它也不简单,需要你耐下性子,跟我一起来慢慢掌握数据分析的核心知识点和工具操作。

我招聘过一个实习生,很普通的本科学校。最开始他只会简单的 PHP 语法,实习期间薪水也就只有 3000 元,但到后来他不仅可以做爬虫抓取,还可以做数据分析,薪水就涨到了税后 1.3 万,这个进步用了不到一年的时间。

他的成长速度非常快,这是怎么做到的呢?

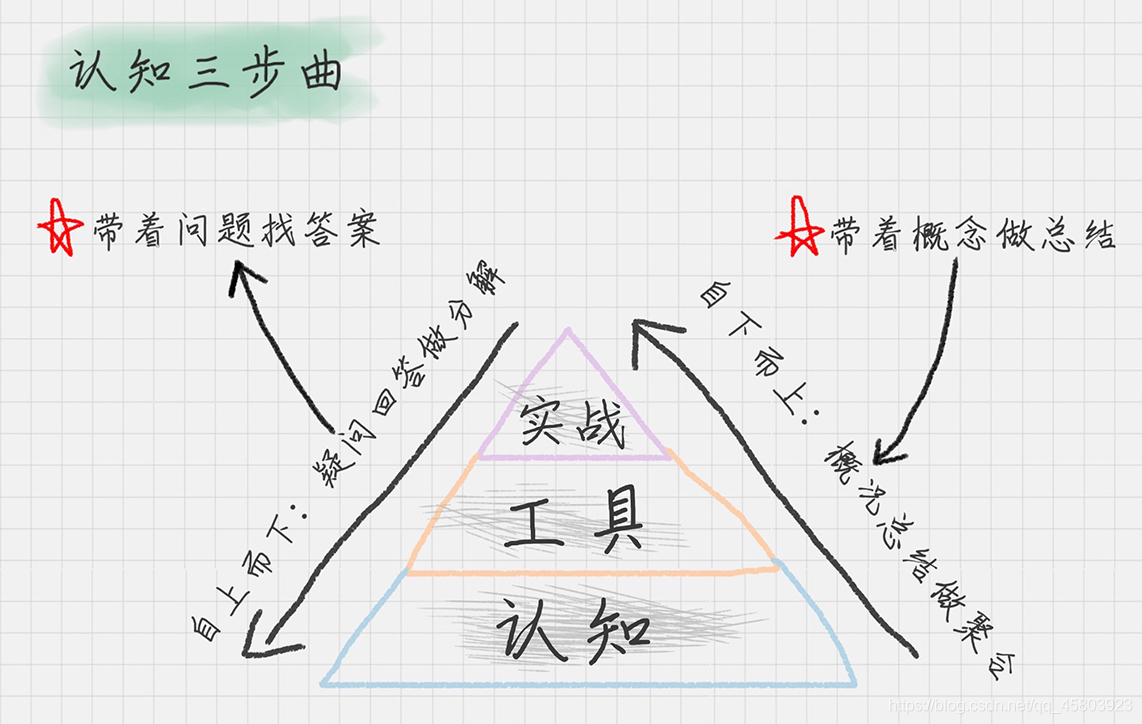

总结一下,就是他找到了高效的学习方法,我把它称为 MAS 方法。

怎么和数据分析建立多维度连接呢?我特意把内容分成了三个大类。

第一类是基础概念。这是我们学习的基础,一定不能落下。

第二类是工具。这个部分可以很好地锻炼你的实操能力。

第三类是题库。题库的作用是帮你查漏补缺,在这个过程中,你会情不自禁地进行思考。

- 1

- 2

- 3

- 4

- 5

这个连接的过程,也是我们从“思维”到“工具”再到“实践”的一个突破过程。如果说重要性,一定是“思维”最重要,因为思维是底层逻辑和框架,可以让我们一通百通,举一反三,但是思维修炼也是最难的。所以,我强调把学习重心放在工具和实践上,即学即用,不断积累成就感,思维也就慢慢养成了。

说到底,学习数据分析的核心就是培养数据思维,掌握挖掘工具,熟练实践并积累经验。为了能带给你更好的学习效果,我在专栏里设计了五大模块。

1. 预习篇

我会给你介绍数据分析的全景图,和你进一步探讨最佳的学习路径。我还专门准备了 3 篇 Python 入门内容,如果你还没有 Python 基础,希望能帮你快速上手,如果你已掌握了 Python,可以当作一个复习。这么安排是因为 Python 是数据科学领域当之无愧的王牌语言,很多数据分析利器也是基于 Python 的。

2. 基础篇

我会带你修炼数据思维,从数据分析的基础概念,到数据采集、数据处理以及数据可视化。我们一起从数据准备的整个流程上了解数据的方方面面。

3. 算法篇

算法是数据挖掘的精华所在,也是我们专栏的重点内容。我精选了 10 大算法,包括分类、聚类和预测三大类型。每个算法我们都从原理和案例两个维度来理解,达到即学即用的目的。

4. 实战篇

项目实战是我们学习的一个重要关卡。我准备了 5 个项目带你真实体验。比如在金融行业中,如何使用数据分析算法对信用卡违约率进行分析?现在的互联网产品都进入到千人千面的人工智能阶段,如何针对一个视频网站搭建视频推荐算法?

5. 工作篇

我选择了几个大家最关心的职场问题,比如面试时注意什么,职位晋升路径是怎样的等等,助你一臂之力。

我希望,通过这个专栏,你将有如下收获。

1. 数据和算法思维

这不仅是在技术上的思维模式,更是我们平时看待问题解决问题的思维方式。如果你将数据视为财富,将数据分析视为获得财富的工具,那么在大数据时代,你将获得更宽广的视野。

2. 工具

用好工具,你将拥有收集数据、处理数据、得到结果的能力,它会让你在工作中游刃有余。

3. 更好的工作机会和价值

无论是当前火爆的人工智能,还是数据算法工程师的市场,都很看重数据分析和数据处理的能力。从“思维”到“工具”再到“实践”,沿着这个路径拓展自己的能力边界,拥有更强的竞争力。

在你面前,即将开始一场数据科学之旅。我们一起用 15 周的时间,从算法原理、分析工具和实战案例三个维度体会数据科学之美。

在专栏学习的过程中,如果你遇到问题,不论是概念不懂,还是工具使用遇到 error,你都可以来找我。也希望你可以把自己的学习笔记分享出来,它不仅是最好的自我学习方法,也是最好的交流语言。

我愿意跟你一起,将这些看似“高大上”的内容琢磨得通俗易懂。当你完成这段旅程,你将会发现这个世界从来不缺少“石油”,而它们,正在等着你的勘探。

正式启程之前,我想邀请你聊聊自己对课程的期待,你如何看待数据挖掘和数据分析?你的工作和生活中有什么事情用到过数据思维吗?

加餐

在社交网络上刷粉刷量,技术上是如何实现的?

我们都知道很多社交网络上可以刷粉,也可以刷阅读量,这已经形成了一个“产业链”,我们也经常会看到很多记者报道过这样的灰色产业链。

你也许很好奇,这些技术都是怎么实现的?

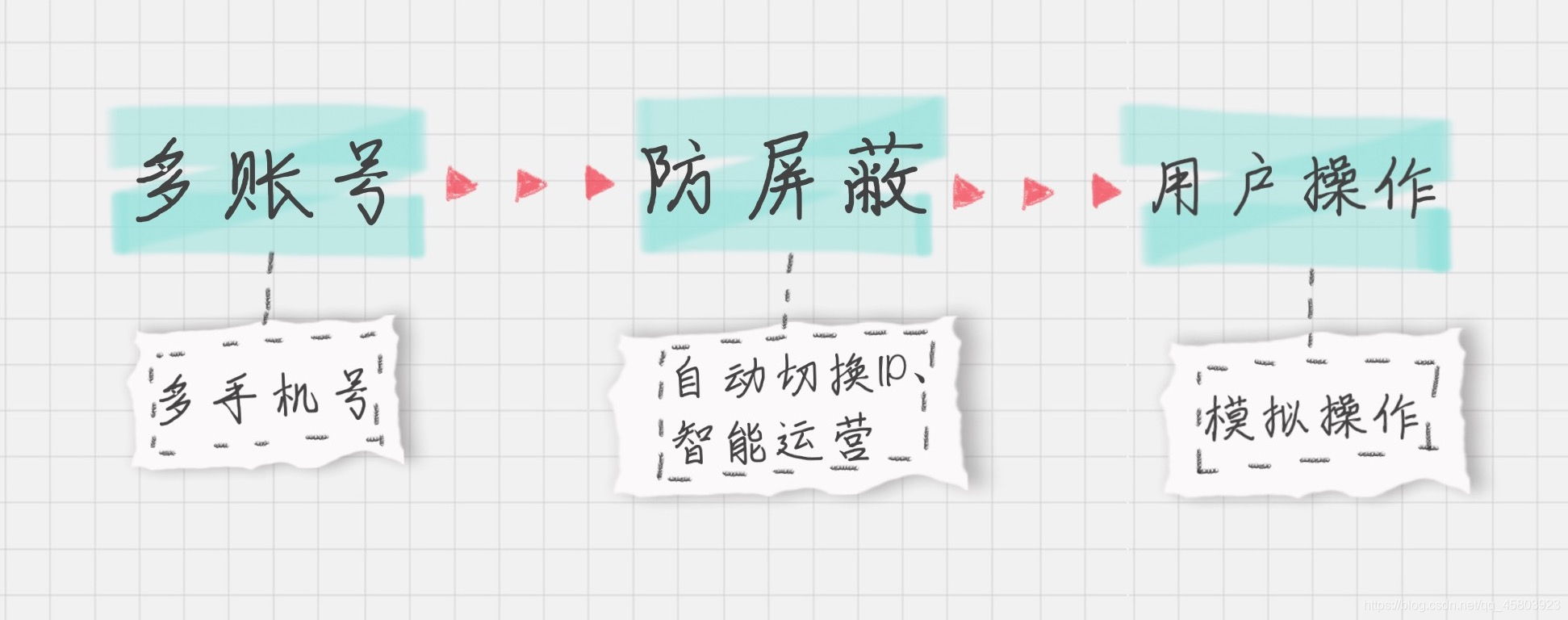

首先我梳理了一下整个流程,可以分成 3 个步骤。

在这个流程里,需要有下面三个准备。

1. 多个手机号

尽管早期注册只需要邮箱就可以,但现在账号注册都是需要绑定手机号的,所以手机号是必备的。

2. 多个 IP

因为很多社交网站都会有反垃圾的措施。共用同一个 IP,一定会被封号。

3. 模拟操作

因为我们的需求是个性化的。所以在这一步,可以封装出一些基本的操作,比如关注、发布动态、转发、阅读文章等。

那么多手机号从哪弄?

于是问题来了,从哪里弄这么多手机号?比如说 1 万个!

虚拟手机号:被歧视的号码段

很多从事相关产业的人首先想到的,便是虚拟手机号,因为虚拟手机号不限数量,其他号码段都需要绑定身份证。不过虚拟手机号有个最大的问题,就是“会被歧视”。在社交网络里,虚拟手机号注册的账号被封的概率远超其他账号,比如说以“170”开头的手机号。

阿里小号:一个看似可行的解决方案

既然虚拟手机号容易被封,那怎样才能找到既不会被封,还便宜的号码呢?阿里小号是个选择。阿里小号的价格比较亲民,5 元 / 月。可以自己选择号码段,这些号码段很多都不是 170 号码段的。但是阿里小号有个问题,就是需要用身份证来绑定。

国外号码,贵但价值明显

那有没有既不会被封,又不用绑定身份证的办法呢?国外的手机号是可以的,但最大的问题就是贵,差不多 5 美金一个月,相当于一个账号就要 35 元。

我调查了一下,其实国外也有类似的刷量刷粉的操作,比如刷 Facebook、Twitter、YouTube 等。这些网站刷粉、刷量的收费更高,所以相比之下,手机号带来的成本其实不算什么。

一个手机号就相当于你雇了一个工人,在雇佣的这段期间里,你需要让它的任务“充实”起来。一般的做法都是先从高价值的网站开始刷,在完成后,再来刷国内的 APP。如果有足够多的刷粉刷量的任务,这个“工人”就会 7X24 小时不间断地工作。

这些号码各有特点,根据实际情况,不同人手里用到的号码是不同的。我总结了一下。

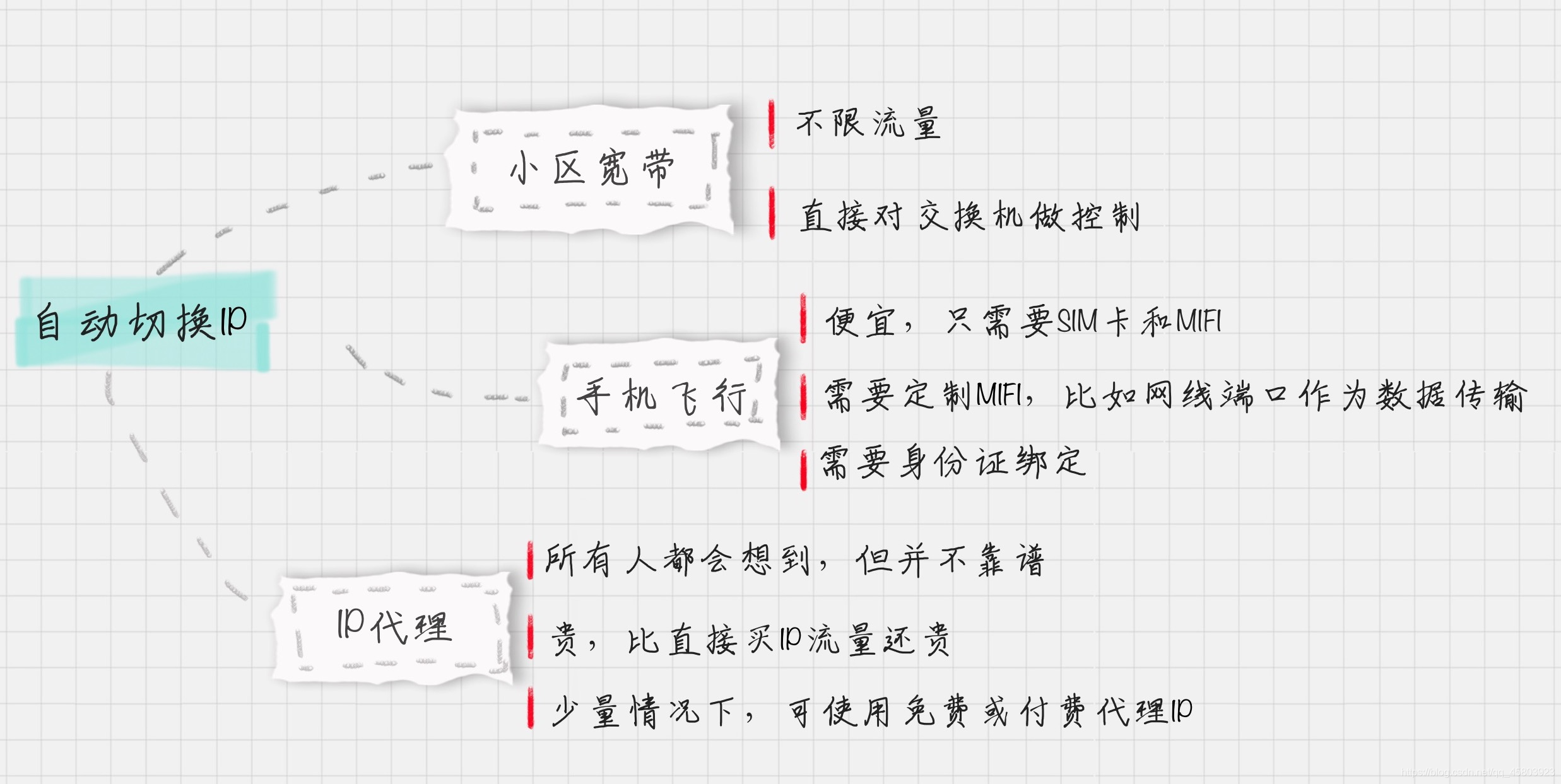

如何自动切换 IP?

在解决多个手机号的情况后,那下个问题就来了,如何自动切换 IP 呢?这是一个自动化运营绕不开的问题。

有三种方式可以选择。

1.IP 代理。

2.飞行模式。

3.小区宽带。

- 1

- 2

- 3

IP 代理:所有人都能想到,但并不靠谱的方案

IP 代理应该是很多人首先想到的解决方案,因为在编写 Python 爬虫的时候,是可以使用代理机制的。网上就有很多做 IP 代理的。但这里有两个认知,你需要注意。

1.IP 代理没有你想得那么便宜。以不重复的 100 万 IP 为例,单日价格在 2700 元,相当于 1 万 IP=27 元。所以你会有这样一个疑惑:那些刷网站流量的,1 万流量只需要几元的是怎么做到的?

2.免费 IP 比你想象得要好用。实际上,有很多免费 IP 代理可以使用,它们主要的问题在于数量比较少。

- 1

- 2

- 3

所以在量少的情况下,IP 代理是可以使用的。在量大的情况下,IP 代理就没那么好用了,因为成本太高,并不是一个靠谱的方案。

飞行模式,一个让人飞起来的 idea!

当你发现,购买 IP 代理的价格比淘宝上售卖流量的还要贵的时候,你就知道他们用的根本不是 IP 代理。换个思维,有没有免费的 IP 呢?这里会用到手机的飞行模式,它和路由器断开重连一样完美!

这是为什么呢?

当我们的手机采用飞行模式后再关闭,你会发现手机的 IP 发生了变化。同样,当你断开路由器后,再进行重连,IP 也自动发生了变化。这个就是动态 IP。

WIFI 和 MIFI

那么问题来了,怎样写程序来控制手机呢?这里你可以使用 MIFI 设备,MIFI 其实就是 Mobile WIFI 的意思。MIFI 设备最大的好处,就是脱离了手机,你不需要一台手机,而只需要一台 MIFI 设备和一张 SIM 卡。

MIFI 设备集成了路由器和调制解调器的功能,使用的流量还是 SIM 卡的流量。所以当我们断开 MIFI 设备重连的时候,就相当于自动换了 IP。当然,这个过程需要定制 MIFI 设备,也就是多一个网线接口,把数据传输出来,这样就可以自动进行控制了。

MIFI 可能存在的问题

MIFI 可以说是个很方便的解决方案,但是依然存在一个问题,就是当流量大的时候,手机的流量费是很高的。那这样的话,就不能采用 MIFI 的方式了,可以考虑使用小区宽带。小区宽带最大的好处,就是不限流量。

当然除了控制 MIFI 设备外,还需要控制交换器,才能做到自动切换 IP。所以在流量较小的情况下,MIFI 是个好的解决方案。流量大的情况,比如要访问视频网站,小区宽带是更好的方案。

在自由切换 IP 这个部分,我整理了以下的 3 种方案,一般来说手机飞行适合轻度的并发访问,而重度的流量访问方式还需要采用小区宽带的方案。

如何模拟操作,是一个技术活

模拟操作,就是文章开头中,我提到的流程中的最后一步。

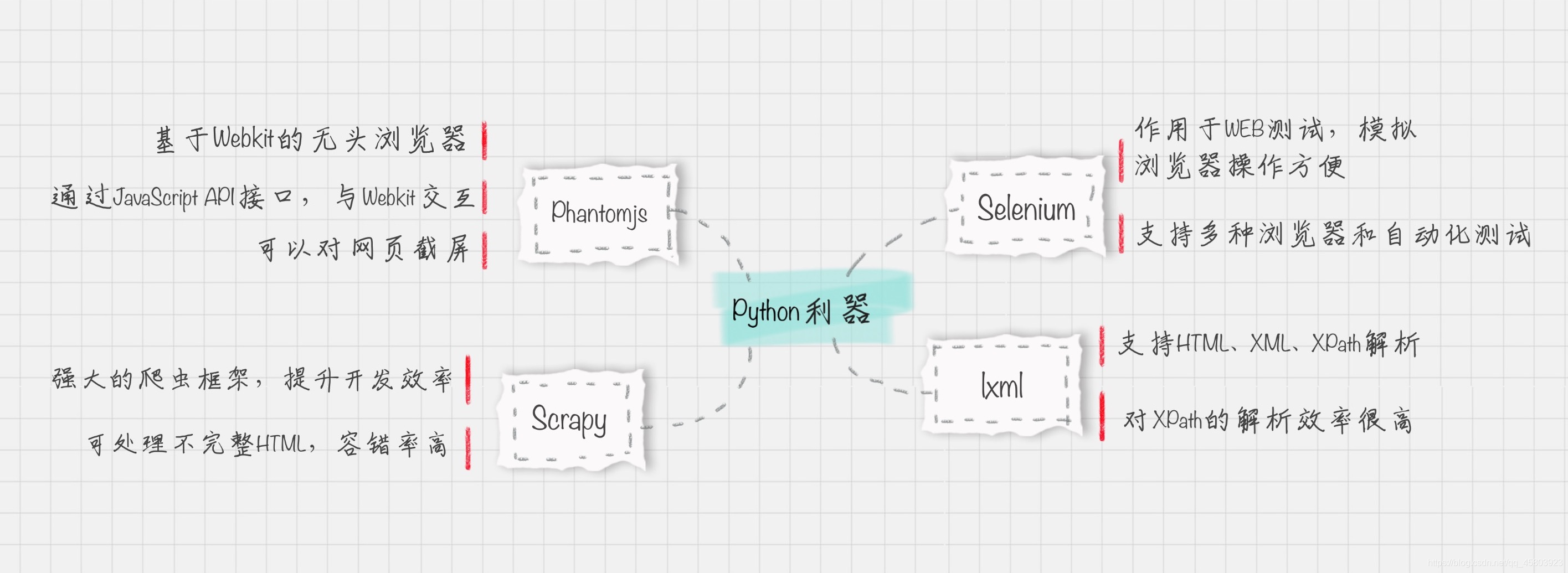

所有的流程,如果想要实现机器自动化,就需要一个利器。这里 Python 最适合不过。那么该怎么做呢?

首先这里需要用到 Python 的几个工具。在做自动化运营的过程中,会经常使用这些工具,我简单给你介绍下。

Selenium:用于 Web 测试的工具,支持多种浏览器和自动化测试。

lxml:网页解析利器,支持 HTML、XML、XPath 解析,而且解析效率很高。

Scrapy:强大的爬虫框架,提升开发效率。

PhantomJS:基于 WebKit 的无头浏览器,无头就是没有 UI 界面的意思。同时 PhantomJS 提供了 JavaScript API 接口,可以直接与 WebKit 内容交互。通过它,你可以完成无界面的自动化测试、网页截屏等。通过网页截屏,就可以帮水军做结案报告。通过结案报告,就可以看到刷量的直观数据结果。

- 1

- 2

- 3

- 4

- 5

- 6

- 7

通过以上的工具,我们就可以达到实时抓取,实时刷量的目的。当然这些工具只是表象,更重要的是模块化的思维。也就是如何使用这些工具,具体都做哪些事。一般来说,我们可以把自动化运营拆解成不同的模块。

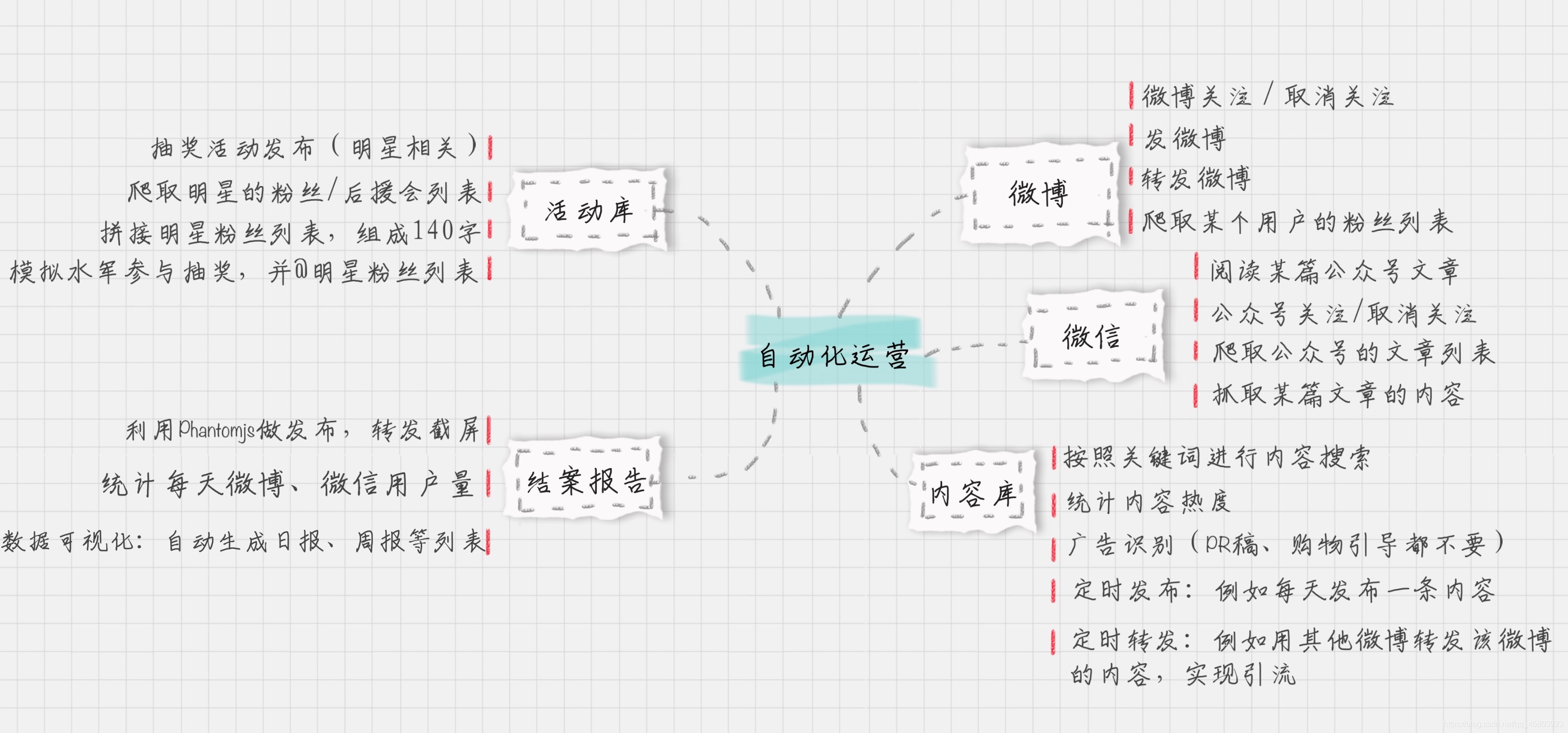

下图是我以微信、微博为例,整理的自动化运营所需模块的全景图,这些模块都需要编写相应的代码来实现,从而打造整个社交网络上自动化运营的机器人团队。

虽然这篇文章给你讲了这个灰色地带,但我还是想强调一下,我只想通过这篇文章让你直观地体验数据思维是什么样的以及实现的方式是什么,这样才能更好地帮助你解决工作或者生活中遇到的问题。

作为技术出身的从业人员,我倡导不作恶的理念。所以我不建议你去购买这么多的手机号和 MIFI 设备,我希望你把重点放到如何掌握 Python 中数据分析的工具上,以及慢慢培养你的数据化思维。

我是一个数据分析爱好者,总是被各种问题吸引,带着好奇心,脑海中提出各种问题,然后通过思考一步一步进行解决。所以,我希望你能在实际工作中,和我一样具有数据思维,以及数据分析的解决能力,这也是我们在《数据分析实战 45 讲》这个专栏里想要讨论的内容。

而我也希望你能通过这个专栏获得这样的能力。如果你觉得这篇文章有帮助,欢迎点击“请朋友读”,把它分享给你的朋友或者同事。

关于爬虫我有些经验和疑问:

1. 近期,我能够成功爬取淘宝,天猫的数据,我是直接用requests库直接抓取的,但是,需要伪装headers,cookies,当然还要有自己的proxy池,cookies池。先要分析淘宝网页结构,因为淘宝网页是动态的,很多结果和数据是JS渲染后的结果,直接看源代码看不到,所以,需要找到需要数据对应的url。此种方法同样适用于阿里妈妈

2. 我有一个疑问,就是selenium,我实验无数次,淘宝(我没试过微博,头条,抖音之类的,但是其反爬机制应该不会比淘宝差多少)会探测出你在用selenium,例如用chrome+selenium,你会发现,淘宝能探测出你的webdriver是true,所以,会出现跳出登陆窗口,尤其他那个验证滑动条很难搞定。我尝试过反编译webdriver,去掉一些关键字,可是还是不成功,好像有一种解决办法,就是中间人,把淘宝检测webdriver的js中的关键字屏蔽掉,但是这么做了以后,如何再加上proxy,我还没有想明白。所以,这就是我还在用朴素的requests,伪装报头,分析网页这些办法,很麻烦的爬淘宝数据的原因。

所以作者是用selenium,我觉得如果只是教大家如何用selenium,意义不大,因为很多网站都有反爬机制,能探测出你在用selenium,从而防止你爬数据,如此一来,selenium还有什么用?所以,这里,恳求作者针对现在大部分网站反爬机制出现的情况,如果不让网站侦测出我们在用selenium的办法,万分感谢

- 1

- 2

- 3

- 4

- 5

- 6

还没太理解与数据思维有什么关系,可能不太懂?

作者回复: 我说下自己的体会,数据是一种能力,它可以帮我们做很多事。不是用人工来完成,而是数据本身存在规律,可以让我们去发现和使用。

我自己编写过Python爬虫,也做过定时发布、转发和互动的机器人。通过编写的微博机器人,粉丝从0积累到100万(当时自动化运营了2000个微博账号,其中@每天学点经济学 和@每天学点心理学 是比较知名的)

当然要做自动化的机器人,需要先把流程都梳理出来。而且社交网络也有很多反垃圾的措施,这就好比是矛和盾的较量。不过大部分都可以找到规律,从而帮我们进行解决

- 1

- 2

- 3

- 4

- 5

- 6

01丨数据分析全景图及修炼指南

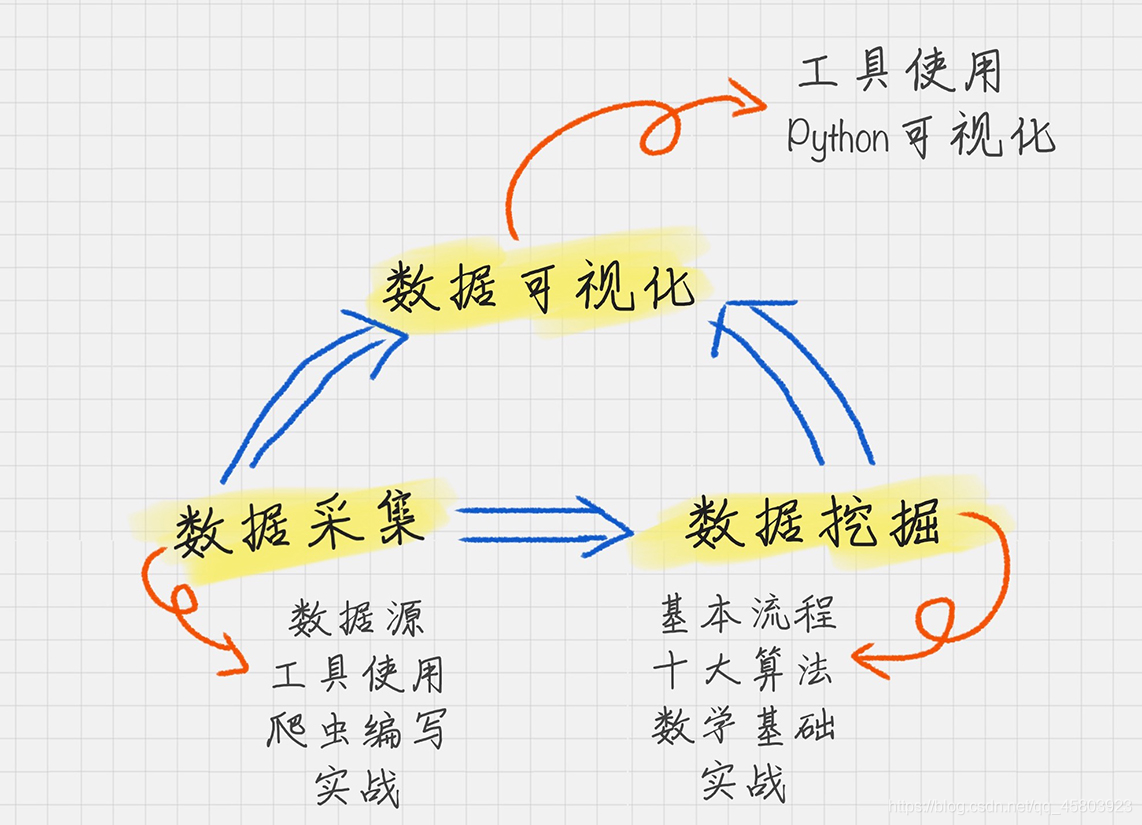

今天我们的学习正式开始,我想先给你一张数据分析的全景图,让你对后面的学习做到心中有数。

现在,你已经知道了数据分析在现代社会中的重要地位。掌握数据,就是掌握规律。当你了解了市场数据,对它进行分析,就可以得到市场规律。当你掌握了产品自身的数据,对它进行分析,就可以了解产品的用户来源、用户画像等等。所以说数据是个全新的视角。数据分析如此重要,它不仅是新时代的“数据结构 + 算法”,也更是企业争夺人才的高地。

1.数据采集。它是我们的原材料,也是最“接地气”的部分,因为任何分析都要有数据源。

2.数据挖掘。它可以说是最“高大上”的部分,也是整个商业价值所在。之所以要进行数据分析,就是要找到其中的规律,来指导我们的业务。因此数据挖掘的核心是挖掘数据的商业价值,也就是我们所谈的商业智能 BI。

3.数据可视化。它可以说是数据领域中万金油的技能,可以让我们直观地了解到数据分析的结果。

- 1

- 2

- 3

- 4

- 5

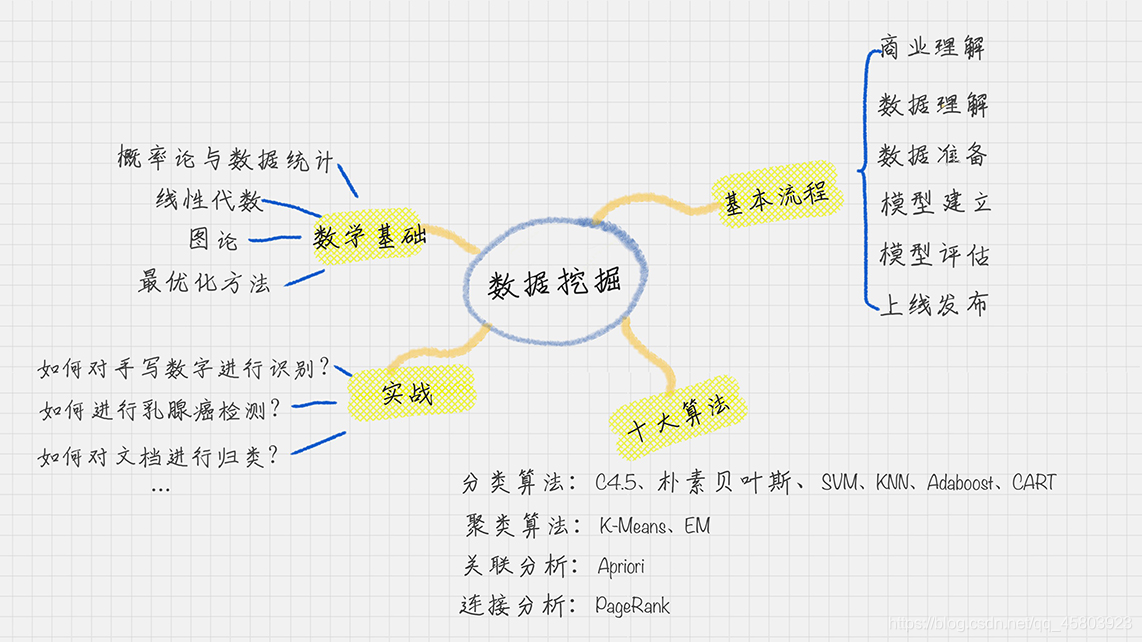

数据挖掘

第二个部分是数据挖掘,它可以说是知识型的工程,相当于整个专栏中的“算法”部分。首先你要知道它的基本流程、十大算法、以及背后的数学基础。

这一部分我们会接触到一些概念,比如关联分析,Adaboost 算法等等,你可能对这些概念还是一知半解,没有关系,我会详细为你介绍这些“朋友”。

每讲完一个算法原理,我都会带你做一个项目的实战,我精选了一些典型的、有趣的项目,比如对泰坦尼克号乘客进行生存预测、对文档进行自动分类、以及导演是如何选择演员的等等。

掌握了数据挖掘,就好比手握水晶球一样,它会通过历史数据,告诉你未来会发生什么。当然它也会告诉你这件事发生的置信度是怎样的,置信度这个词你先记住就可以了,后面我们来学习它具体代表什么。

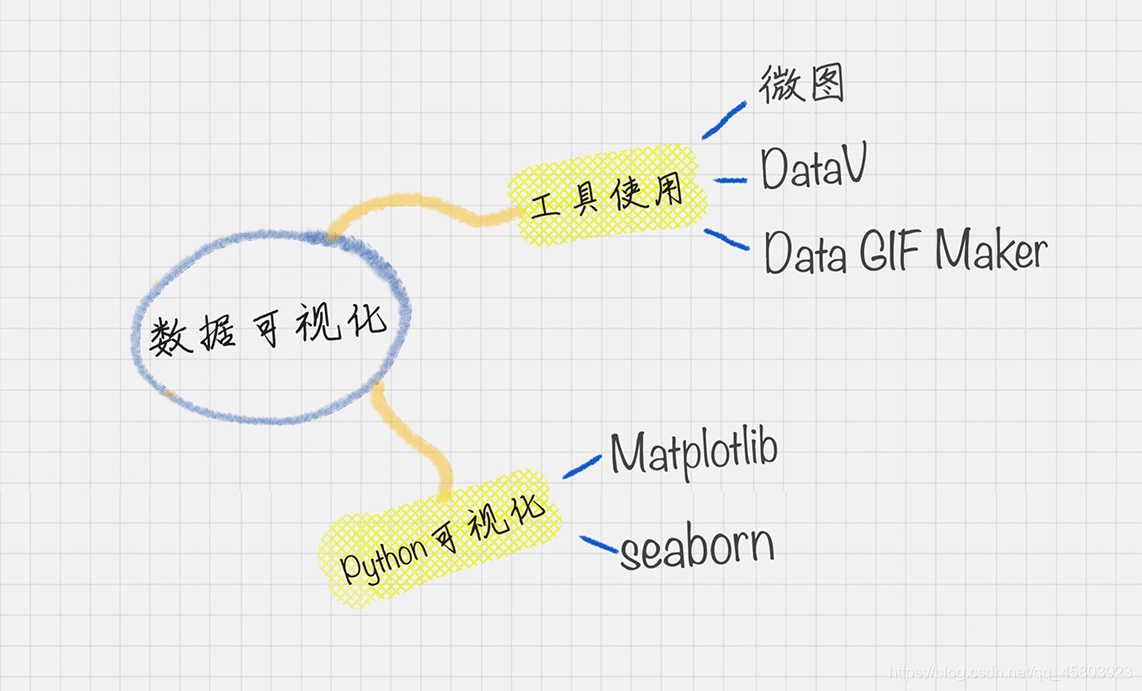

数据可视化

第三个就是数据可视化,这是一个非常重要的步骤,也是我们特别感兴趣的一个步骤。数据往往是隐性的,尤其是当数据量大的时候很难感知,可视化可以帮我们很好地理解这些数据的结构,以及分析结果的呈现。

如何进行数据可视化呢?有两种方法。

第一种就是使用 Python。在 Python 对数据进行清洗、挖掘的过程中,我们可以使用 Matplotlib、Seaborn 等第三方库进行呈现。

第二种就是使用第三方工具。如果你已经生成了 csv 格式文件,想要采用所见即所得的方式进行呈现,可以采用微图、DataV、Data GIF Maker 等第三方工具,它们可以很方便地对数据进行处理,还可以帮你制作呈现的效果。

- 1

- 2

- 3

- 4

数据采集和数据可视化的原理简单,容易理解。这两个部分注重的是工具的掌握,所以我会把重点放在讲解工具以及应用实战上。

虽然这些理论我会给你一一讲解,但纸上得来终觉浅,绝知此事要躬行。手拿地图,我们知道要去哪里,但是怎么去呢?我认为学习数据分析最好的方法是:在工具中灵活运用,在项目中加深理解。

总结:

数据分析三个重要组成部分:

1. 数据采集:获取数据源

2. 数据挖掘:核心是挖掘数据的商业价值

3. 数据可视化:使用python或者第三方工具

学习数据分析最好的方法是:在工具中灵活运用,在项目中加深理解

两条准则:

1. 不重复造轮子。能够很快的知道一个模型有哪些类库可以使用。

2. 工具决定效率。选择使用者最多的工具。

以后的每周做到以下几点:

1. 记录下每天的认知。

2. 这些认知对应工具的哪些操作。

3. 做更多练习来巩固认知。

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

对于自己喜欢的文章记笔记的

记笔记我用到3个工具,Evernote(笔记)、Xmind(导图)、Anki(卡片),

——印象笔记是用来费曼喜欢的文章,方便搜索和迭代。费曼过程会有两个产出:文章结构和细碎知识点。文章结构用思维导图来呈现,细碎知识点用Q&A笔记法整理成经过拆分、提炼的一问一答形式。

——思维导图是整理树干,Q&A笔记是整理树叶

——Anki卡片是克服遗忘,把肢解的导图和一条条的Q&A,放到(黏贴复制)Anki的正反面。因为只有把知识点记住,内化到脑子里了,才能给碎片知识建立连接的可能。

--以上对应的方法论是 收集→加工、整理→内化、迭代

- 1

- 2

- 3

- 4

- 5

02丨学习数据挖掘的最佳路径是什么?

数据挖掘的过程可以分成以下 6 个步骤。

1.商业理解:数据挖掘不是我们的目的,我们的目的是更好地帮助业务,所以第一步我们要从商业的角度理解项目需求,在这个基础上,再对数据挖掘的目标进行定义。

2.数据理解:尝试收集部分数据,然后对数据进行探索,包括数据描述、数据质量验证等。这有助于你对收集的数据有个初步的认知。

3.数据准备:开始收集数据,并对数据进行清洗、数据集成等操作,完成数据挖掘前的准备工作。

4.模型建立:选择和应用各种数据挖掘模型,并进行优化,以便得到更好的分类结果。

5.模型评估:对模型进行评价,并检查构建模型的每个步骤,确认模型是否实现了预定的商业目标。

6.上线发布:模型的作用是从数据中找到金矿,也就是我们所说的“知识”,获得的知识需要转化成用户可以使用的方式,呈现的形式可以是一份报告,也可以是实现一个比较复杂的、可重复的数据挖掘过程。数据挖掘结果如果是日常运营的一部分,那么后续的监控和维护就会变得重要。

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

思维导图总结:

体会:

①学渣与学霸最大的区别不是智商,而是学习方法和学习态度。作为一名计算机出身的工科女,曾经差点溺死在各类算法的海洋里,目前初入社会做产品,又差点迷失在数据的大山。个人还需要调整自己的学习方法和学习态度。

②当前个人接触的仅仅是数据收集、数据处理、数据分析、数据展现,看到老师的数据挖掘6步骤,感觉深奥许多,期待老师后续的详细讲解。

课后思考:

对于思考题,我想到了沃尔玛 “啤酒和尿布” 经典案例。沃尔玛正是将Apriori算法引入到POS机数据分析中,从而获得了营销上奇迹。简单说来就是在一个数据集中,找到经常出现的商品组合。当然Apriori算法的计算量很大,当商品数据量大时效率低,FP-Tree算法优化了该算法。

重点:

(1)数据挖掘学习方法体会:有了知识清单,相当于有了一个系统思维在那,对快速识别问题的确很有帮助~很好的方法方便实践,就像巴菲特和芒格的投资是使用的公司尽调清单一样,MECE的解决问题

(2)基于电商商品的关联进行推荐从而提高销售的话,个人认为是Apriori算法,其为了提取频繁项集和一定置信度的关联规则,即用户购买了X产品有多大概率去买Y,根据置信度高的原则推荐

- 1

- 2