热门标签

热门文章

- 1史上最强鸿蒙教程来袭!Android学习路线指南,先收藏了_鸿蒙 android auto

- 2最全Linux Shell详细教程

- 3ElasticSearch之通过update_by_query和_reindex重建索引

- 4Android方案需求,Android 三种适配方案

- 5C# WinForm开发系列之chart控件画折线图和柱形图并自定义鼠标移动到数据标记点显示提示信息_winform的chart显示控件中如何添加shown事件

- 6pytorch创建tensor_torch 创建tenor

- 7使用OpenVINO实现人体动作识别

- 8vue3.x 二次封装axios_vue3二次封装axios

- 9java.lang.ClassNotFoundException: org.apache.commons.logging.LogFactory_java.lang.noclassdeffounderror:org/apa

- 10Android总结:命名空间_namespace declaration is never used

当前位置: article > 正文

FlashAttention2 安装;报错 RuntimeError: FlashAttention only supports Ampere GPUs or newer.

作者:小蓝xlanll | 2024-03-20 03:14:28

赞

踩

runtimeerror: flashattention only supports ampere gpus or newer.

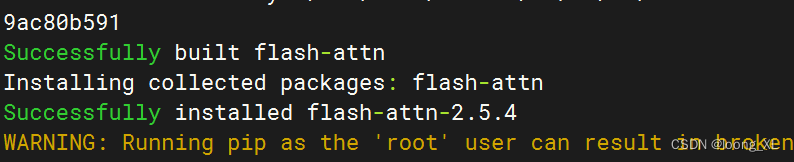

1、FlashAttention2 安装

cuda12.0环境;pytorch 2.1.2+cu118;transformers 4.38.0

pip install flash-attn --no-build-isolation --use-pep517

- 1

2、报错 RuntimeError: FlashAttention only supports Ampere GPUs or newer.

参考:

https://github.com/Dao-AILab/flash-attention

FlashAttention2暂时不支持 T卡,后续支持,如果要使用先用1.X版本

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/小蓝xlanll/article/detail/270264

推荐阅读

相关标签