- 1VSCode下载

- 2如何解决ssh登录报错WARNING: REMOTE HOST IDENTIFICATION HAS CHANGED!_hashknownhosts 设置成false

- 3【SpringBoot】24、SpringBoot中实现数据字典_springboot 数据字典

- 4无需懂技术,3分钟幻兽帕鲁服务器搭建教程_幻兽帕鲁 内网穿透

- 5HarmonyOS4.0从零开始的开发教程08构建列表页面_harmony 列表界面

- 6【Fastadmin/ThinkPHP5】使用Queue队列方法详细步骤

- 7mysql 3021 (HY000) 主从复制错误解决办法_error 3021 (hy000): this operation cannot be perfo

- 8华为HCIP Datacom H12-831 卷15_datacom hcip h12-831战报

- 9搭建linux服务器详细教程_linux文件服务器搭建

- 10NAT地址转换(又称为网络地址转换,用于实现私有网络和共有网络之间的互相访问)_nat转换

ICCV 2023 接收结果出炉!再创历史新高!录用2160篇!(附6篇最新论文)

赞

踩

点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

2023 年 7 月 14 日13:03,ICCV 2023 顶会论文接收结果出炉!这次直接放出论文 Accepted Paper ID List。这也意味着:The ICCV2023 social media ban is over.

根据 ID List 可知 ICCV 2023一共 收录 2160 篇(List中最大的ID是12782,但目前并不清楚所有ID数量,以及有效投稿数量)。

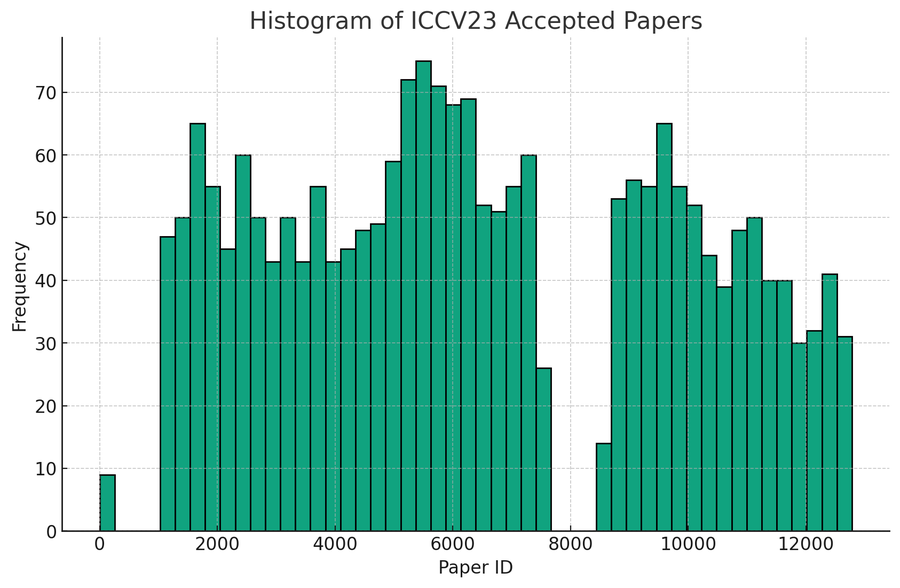

有网友统计了 ID List 中ID分布的直方图,其中有两个大段空白跨越:32直接跳至1029,以及7588直接调至8592。

ICCV 2023 会议将于 2023 年 10 月 2 日至 6 日在法国巴黎(Paris)举行。这次线下会议将会有一大波国内的学者线下参加学术交流(公费旅游bushi)。

PS:论文已收录的同学可以添加微信:CVer333,备注ICCV 2023中奖+昵称,或者联系CVer小助手,她会拉你进ICCV 2023巴黎开会群。仅限论文收录的同学加入!非诚勿扰!

Amusi 简单预测一下,ICCV 2023 收录的工作中 " 扩散模型、多模态、预训练、大模型、基础模型、AIGC" 相关工作的数量会显著增长。

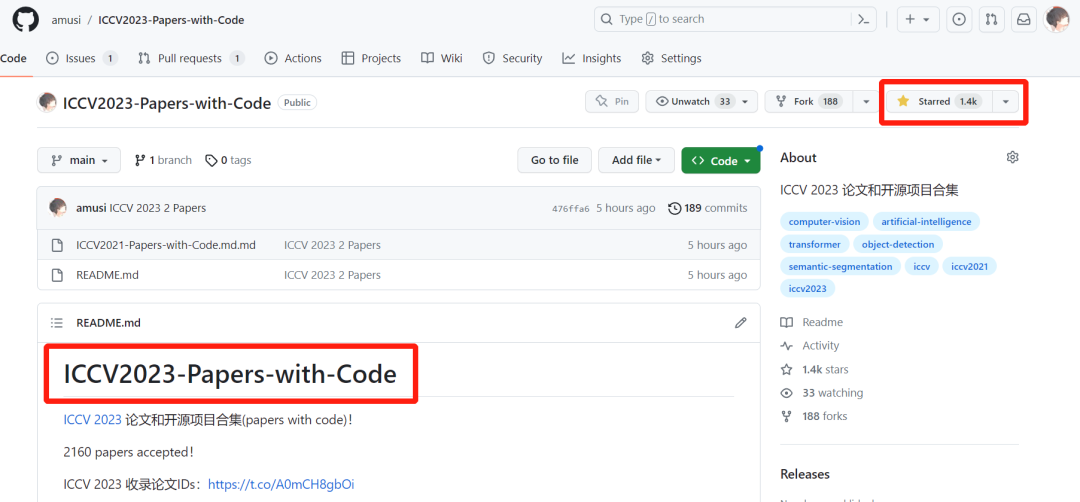

本文快速整理了6篇 ICCV 2023 最新工作,内容如下所示。如果你想持续了解更多更新的 ICCV 2023 论文和代码,大家可以关注CVer计算机视觉知识星球以及ICCV2023-Papers-with-Code,在CVer公众号后台回复:ICCV2023,即可下载,链接如下:

https://github.com/amusi/ICCV2023-Papers-with-Code

这个项目是从2021年开始,累计提交了很多次!Star数已经破千+!很开心能帮助到一些同学。

如果你的 ICCV 2023 论文接收了,欢迎提交 issues~

NeRF

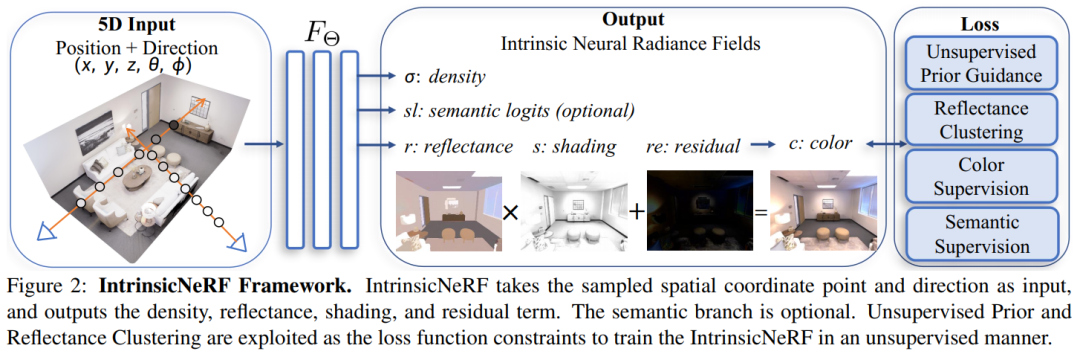

1. IntrinsicNeRF: Learning Intrinsic Neural Radiance Fields for Editable Novel View Synthesis

单位:浙江大学(章国锋团队), ETH Zurich, 微软

Homepage: https://zju3dv.github.io/intrinsic_nerf/

Paper: https://arxiv.org/abs/2210.00647

Code: https://github.com/zju3dv/IntrinsicNeRF

本文将本征( intrinsic)分解引入神经渲染中,并提出了IntrinsicNeRF本征神经辐射场,可以将场景分解为反射层、shading层和残差层,可获得高保真新颖的视图合成,代码即将开源!

语义分割(Semantic Segmentation)

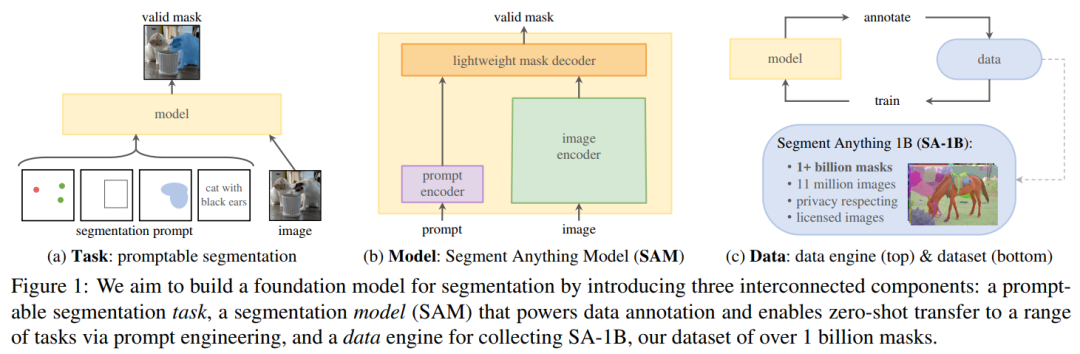

2. Segment Anything

单位:Meta AI

Homepage: https://segment-anything.com/

Paper: https://arxiv.org/abs/2304.02643

Code: https://github.com/facebookresearch/segment-anything

截止2023年7月14日,SAM的被引用量高达300+!github stars数突破36000+!数据集和代码已开源!这是要提前预定 Best Paper?

3D目标检测(3D Object Detection)

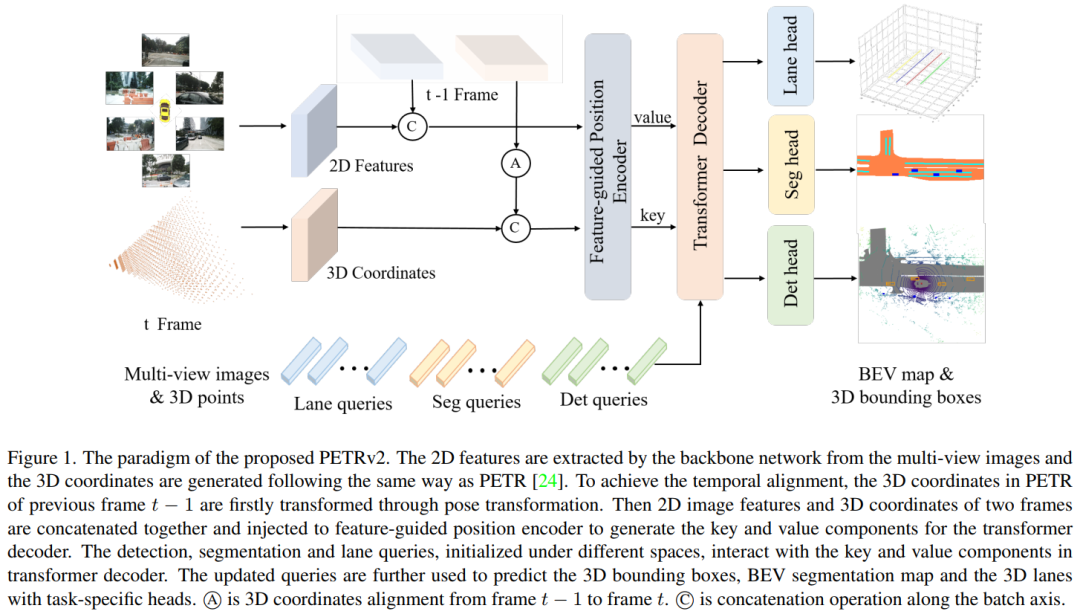

3. PETRv2: A Unified Framework for 3D Perception from Multi-Camera Images

单位:旷视科技(张祥雨等人)

Paper: https://arxiv.org/abs/2206.01256

Code: https://github.com/megvii-research/PETR

PETRv2:一个从多摄像头图像中进行 3D 感知的统一框架,其通过时序建模和多任务学习扩展了 PETR 基线,在3D目标检测和BEV分割上表现出色!代码已开源!

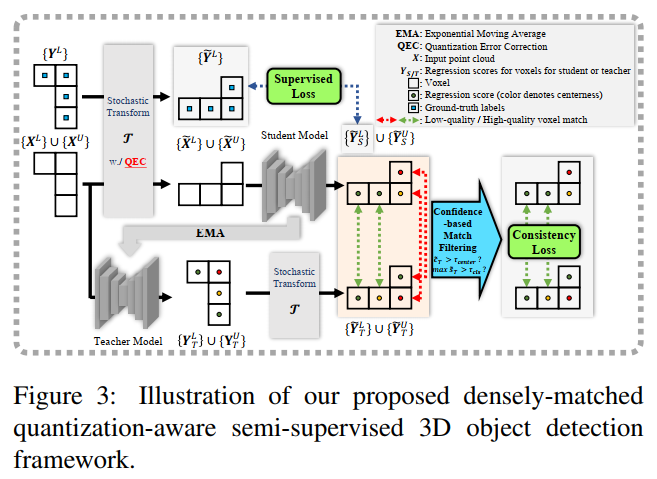

4. DQS3D: Densely-matched Quantization-aware Semi-supervised 3D Detection

单位:清华大学

Paper: https://arxiv.org/abs/2304.13031

Code: https://github.com/AIR-DISCOVER/DQS3D

DQS3D:一种用于半监督3D目标检测的密集匹配量化感知框架,通过利用密集匹配而非proposal匹配,并通过解决量化误差问题,在ScanNet v2和SUN RGB-D两个基准上实现了显著性能改进,代码已开源!

视频理解(Video Understanding)

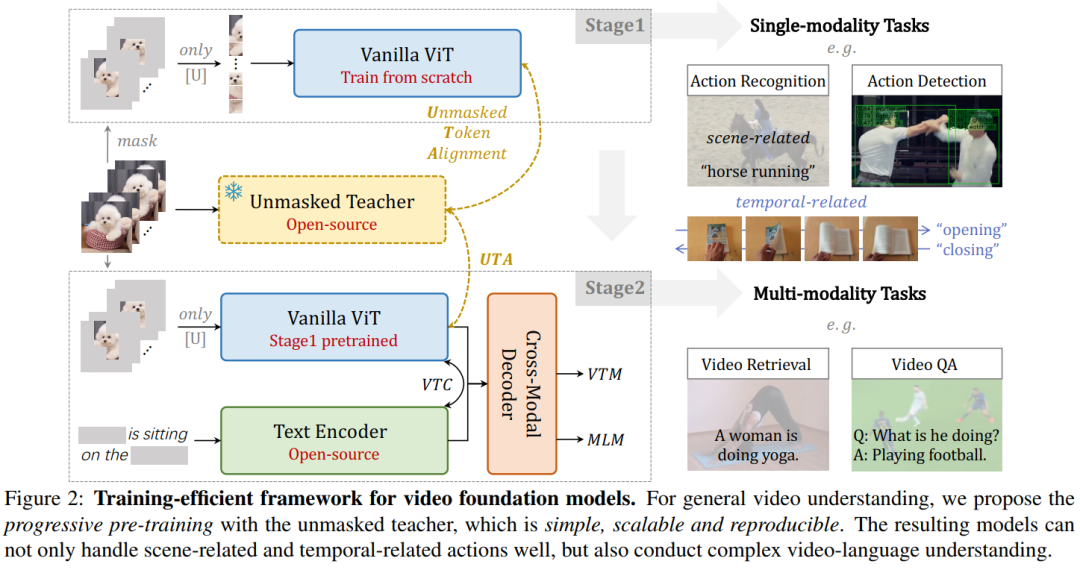

5. Unmasked Teacher: Towards Training-Efficient Video Foundation Models

单位:中科院, 国科大, 上海AI Lab, 港大, 南大

Paper: https://arxiv.org/abs/2303.16058

Code: https://github.com/OpenGVLab/unmasked_teacher

UMT:一个高效训练视频基础模型的新方法,充分利用图像基础模型作为教师,通过掩码学习的方式节省视频训练开销。仅用32张A100从头训练6天,ViT-L/16在多个单模态和多模态视频任务上表现优异!代码即将开源!

低光照图像增强(Low-light Image Enhancement)

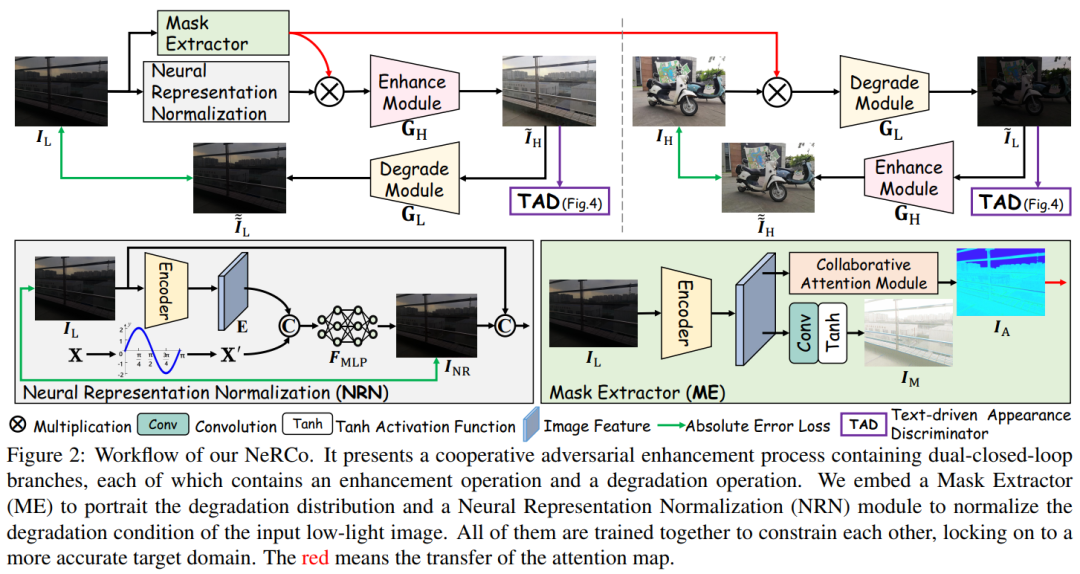

6. Implicit Neural Representation for Cooperative Low-light Image Enhancement

单位:北大(深圳), 鹏城实验室, 大连理工, UIUC

Paper: https://arxiv.org/abs/2303.11722

Code: https://github.com/Ysz2022/NeRCo

NeRCo:一种用于协作低光照图像增强的隐式神经表示方法,其将现实场景的多种退化因素与可控的拟合函数结合起来,从而具有更好的鲁棒性和卓越的有效性,代码即将开源!

CVPR 2023 / ICCV 2023论文和代码下载

后台回复:CVPR2023,即可下载CVPR 2023论文和代码开源的论文合集

后台回复:ICCV2023,即可下载ICCV 2023论文和代码开源的论文合集- 目标检测和Transformer交流群成立

- 扫描下方二维码,或者添加微信:CVer333,即可添加CVer小助手微信,便可申请加入CVer-目标检测或者Transformer 微信交流群。另外其他垂直方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch、TensorFlow和Transformer等。

- 一定要备注:研究方向+地点+学校/公司+昵称(如目标检测或者Transformer+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群

-

- ▲扫码或加微信号: CVer333,进交流群

- CVer计算机视觉(知识星球)来了!想要了解最新最快最好的CV/DL/AI论文速递、优质实战项目、AI行业前沿、从入门到精通学习教程等资料,欢迎扫描下方二维码,加入CVer计算机视觉,已汇集数千人!

-

- ▲扫码进星球

- ▲点击上方卡片,关注CVer公众号

整理不易,请点赞和在看![]()