- 1Github 令牌(Personal access tokens )申请及使用

- 2transformer详解:transformer/ universal transformer/ transformer-XL_transformer_xl用于图像

- 32023 工业 AR 关键词:纵深和开拓

- 4农业智能化灌溉系统_智慧农业灌区设备生产执行标准有哪些

- 5M1芯片Mac book pro部署stable diffusion模型_m1 stable diffusion

- 6MySQL面试题系列-8

- 7什么是CDC?

- 8使用LoRA和QLoRA微调LLMs:数百次实验的见解

- 9设备如何使用go sdk轻松连接华为云IoT平台_device-sdk-go集成

- 10每日论文速递 | 苹果发文:VLMs离视觉演绎推理还有多远

Baichuan-13B:130亿参数的开源语言模型,引领中文和英文benchmark_beichuan语言模型开源

赞

踩

Baichuan-13B: 一个强大的开源大规模语言模型

标题:Baichuan-13B:130亿参数的开源语言模型,引领中文和英文benchmark

Baichuan-13B是由百川智能开发的一个开源大规模语言模型项目,包含了130亿参数。该模型在中文和英文的权威benchmark上达到了同尺寸模型的最佳效果。这个项目发布了两个版本,包括预训练版本(Baichuan-13B-Base)和对齐版本(Baichuan-13B-Chat)。

Baichuan-13B具有以下几个特点:首先,它比之前的Baichuan-7B模型参数更多、尺寸更大,达到了130亿参数,并在高质量的语料上进行了1.4万亿tokens的训练,比LLaMA-13B模型多出了40%的训练数据量,是目前开源的13B尺寸模型中训练数据量最大的。其次,Baichuan-13B支持中英双语,并且使用了ALiBi位置编码,上下文窗口长度为4096。再次,该项目同时开源了预训练模型和对齐模型,预训练模型作为开发者的基础模型,而对齐模型则具备强大的对话能力,可以直接使用且部署简单。最后,为了支持更广大用户的使用,该项目还同时开源了int8和int4量化版本,这些版本在几乎没有效果损失的情况下大大降低了部署所需机器资源,甚至可以在消费级显卡(如Nvidia 3090)上进行部署。

Baichuan-13B是免费开源且可商用的,无论是学术研究还是开发者都可以自由使用。只需进行官方商用许可的邮件申请,即可免费商用。

在各个权威的中英文benchmark上,Baichuan-13B进行了5-shot评测,其结果如下:

○ STEM:Baichuan-7B:38.2,Chinese-Alpaca-Plus-13B:35.2,Vicuna-13B:37.8

○ Social Sciences:Baichuan-7B:52.0,Chinese-Alpaca-Plus-13B:45.6,Vicuna-13B:48.2

○ Humanities:Baichuan-7B:46.2,Chinese-Alpaca-Plus-13B:40.0,Vicuna-13B:42.6

○ Others:Baichuan-7B:39.3,Chinese-Alpaca-Plus-13B:38.2,Vicuna-13B:39.9

○ Average:Baichuan-7B:42.8,Chinese-Alpaca-Plus-13B:38.8,Vicuna-13B:42.1

通过这些benchmark结果可以看出,Baichuan-13B相比其他模型,在多个领域的测试中取得了更好的效果。

Baichuan-13B项目的目标是提供一个强大的开源大规模语言模型,以帮助学术研究和开发者进行自然语言处理任务。无论是处理中文还是英文,Baichuan-13B都可以提供高质量的语言建模和对话功能。该项目的开源和免费商用政策,使得更多的人可以充分利用这个强大的资源,加速他们的研究和开发工作。

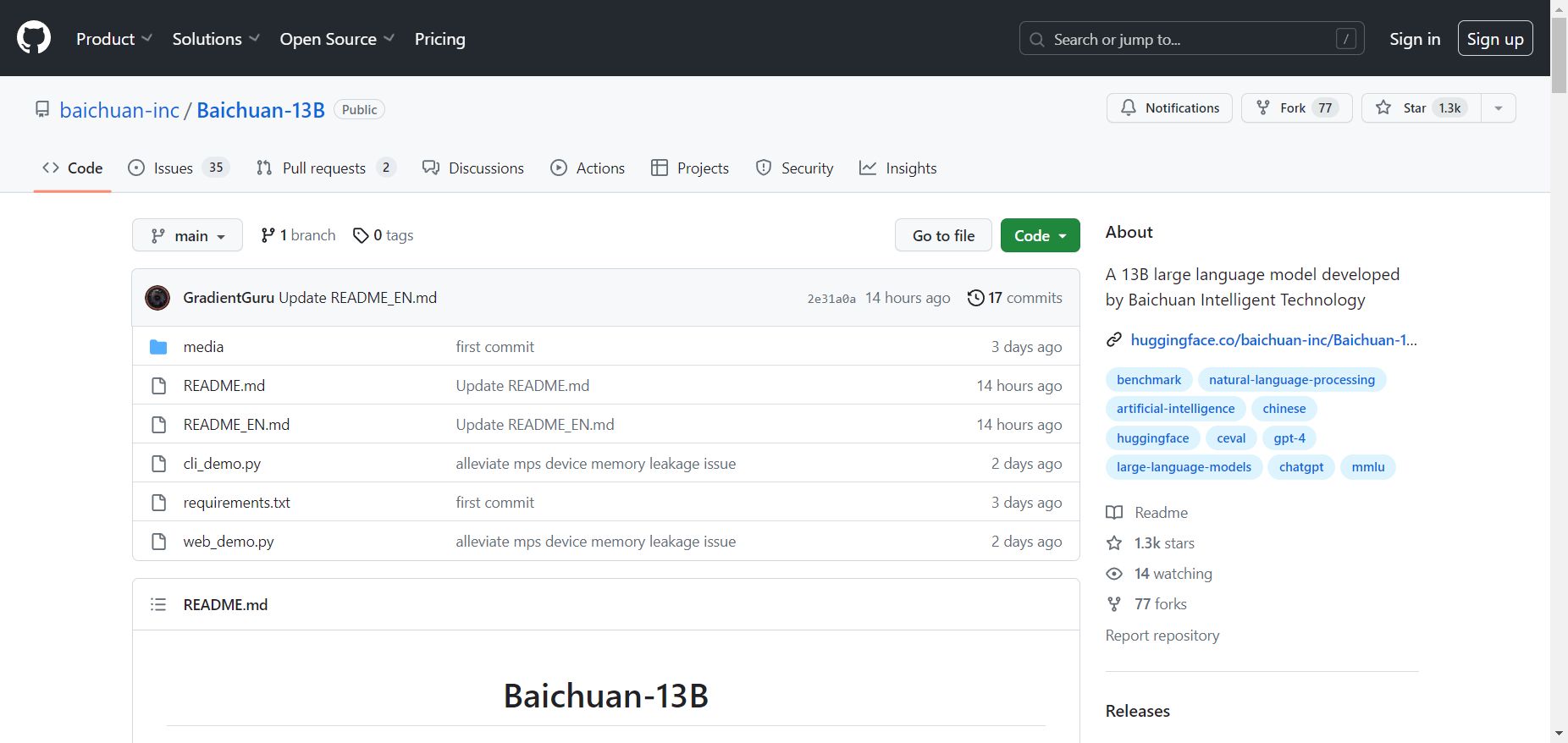

项目:baichuan-inc/Baichuan-13B