- 1Java最新深入理解Java虚拟机:(一)Java代码是如何运行的?,聊聊Java开发的现状和思考

- 2Baidu Comate智能编码助手:AI编程时代提升效率的好帮手_百度智能编码助手

- 3docker启动镜像报错的解决方案_docker 启动镜像 报错 409 confli

- 4史上最全的iOS开源项目分类汇总没有之一

- 5自己做量化交易软件(43)小白量化实战16--利用小白量化金融模块在恒生PTrade交易系统(交易端)上仿大智慧指标回测及实战交易设计_ptrade量化回测策略

- 6(五)将YOLOv5 PyTorch模型权重转换为TensorFlow Lite格式_yolov5 tensorflow

- 7OneNET平台物联网硬件的配置和应用_onenet实例对象

- 8Android Profiler使用详解

- 9VSCode中如何查看EDI报文?_用什么查看edi文件

- 10多重共线性问题及问题总结_多重共线性可能导致的问题有

大数据 - 第二课 : CentOS最小安装版 & 确定Spark、Hadoop、Java版本_centos7 spark版本选择

赞

踩

先讲一下今天上课前的情况,午睡到18.32才行,立马从床上跳起来开电脑,我人傻了5555555迟到俩分钟不算迟到

还有个很重要的事情就是下星期我一定用手机看老师操作,在这里保证

(每次都不能跟上老师操作的我像一个憨憨不知所措甚至还有些暴躁

可恶.

接下来开始正文

-

安装CentOS7最小安装版

这渣渣画质我吐了………………dbq看博客的各位)

硬盘容量不小于30G

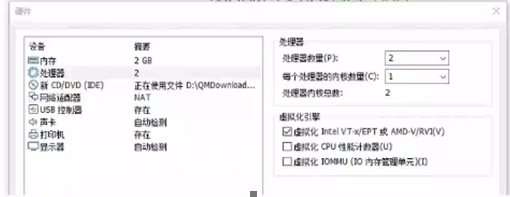

然后是 自定义硬件设置,同上节课,按照自己电脑的规格来设置,

要记得勾选“虚拟化 Intel VT-x/EPT” 或AMD-V/RVI(V)

在此界面中,“SOFTWAE SELECTION”保持默认,因为默认就是最小安装

安装完成后配置网络,进入/etc/sysconfig/network-scripts目录,使用命令,cd/etc/sysconfig/network-scripts,使用ls命令查看于网卡号相关的文件,使用ip a命令查看网卡号。

Vi编辑器的使用:有三种命令模式,刚进入时时一般命令模式,还有编辑模式和底行命令模式。

一般命令模式下,按i或s进入编辑模式,按ESC进入一般命令模式。在一般命令模式下,按冒号键进入底行命令模式。

在相应目录下,执行sudo vi ifcfg-ens33,进入编辑页面,按i键,进入编辑模式,修改“ONBOOT=no”改成“ONBOOT=yes”,然后按ESC进入一般命令模式,再按冒号,进入底行命令模式,输入wq,回车退出,重启虚机:sudo reboot

“ONBOOT=no”启动时不激活,改成yes后,就变成启动时激活

重启后用ping命令检查十分能够上网,例如:ping www.baidu.com

:q!(回车)按上箭头,调用历史命令,sudo提权,输入密码,下方提示—INSERT–,修改yes,按ESC,按:xq存盘退出(回车)sudo reboot 回车

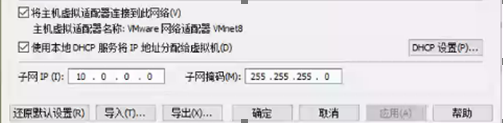

VMware虚拟机网络配置:打开编辑菜单里的“虚拟网络编辑器”,正常情况是这样的,如果异常,确定是否以管理员身份启动的VMware。如果是,点击“还原默认设置”,如果不是,以管理员身份重启VMware

如果要在NAT模式修改配置静态IP地址,需要选种NAT模式,在子网IP栏里输入自己想要的网络地址,如:10.0.0.0

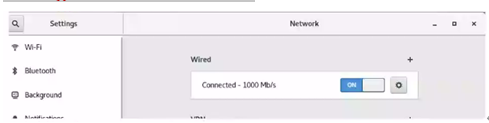

设置静态ip(在GUI下打开Network界面),

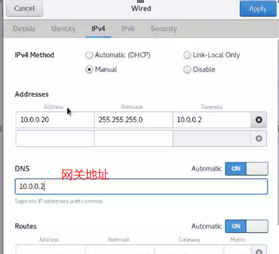

点击齿轮,进入设置页面,选中IPV4:

按图示输入apply,回到“Network”界面,关闭网络再重新打开/.20(主网地址

同样的我们要改黑色的没有图形界面的虚拟机,下面五行是需要修改的,改过来重新测试一下就结束了:)))

TYPE=Ethernet

PROXY_METHOD=none

BROWSER_ONLY=no

BOOTPROTO=none

DEFROUTE=yes

IPV4_FAILURE_FATAL=no

IPV6INIT=yes

IPV6_AUTOCONF=yes

IPV6_DEFROUTE=yes

IPV6_FAILURE_FATAL=no

IPV6_ADDR_GEN_MODE=stable-privacy

NAME=ens33

UUID=3dd2830c-d514-48b5-8166-177593b89e1f

DEVICE=ens33

ONBOOT=yes

IPADDR=10.0.0.20

PREFIX=24

GATEWAY=10.0.0.2

DNS1=10.0.0.2 -

确定Spark、Hadoop、Java版本

不能百度,要去官网

进入Spark官网 : http://spark.apache.org/

官网首页没有版本信息,根据经验,点击 “ download “,加入下载页面

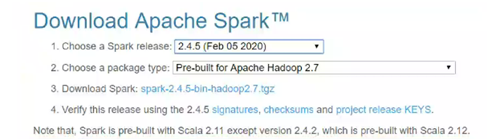

进入下载页面,页面信息如下:http://spark.apache.org/downloads.html

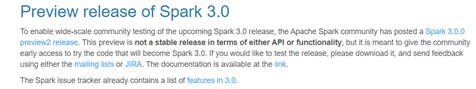

从此页面上看,似乎要下载Spark3.0.0,但此版本标识preview2.0,应该不是稳定版,作为初次学习只用,必须安装稳定版。需要确定此信息。

在此页面:http://spark.apache.org/news/spark-3.0.0-preview2.html

确定Spark3.0.0不是稳定版本。回到下载页面,选择其他版本(Spark2.4.5)。

从此页面上可以看到,Spark2.4.5对应Hadoop2.7,下面核实Spark2.4.5是否是稳定版。

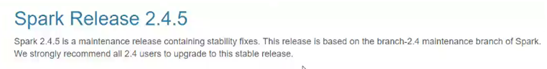

点击页面下部的Spark2.4.5的链接,进入到页面:http://spark.apache.org/releases/spark-release-2-4-5.html

页面上明确Spark2.4.5是正在维护的稳定版,所以得出结论:选择Spark2.4.5,Hadoop2.7

接下来

进入Hadoop官网:http://hadoop.apache.org/

按照经验点击“download”按钮进入下载页面:https://hadoop.apache.org/releases.html

下载页面中没有我们需要的2.7版本,也没有相关信息,所以回到主页。

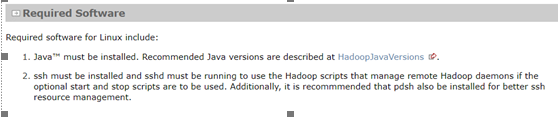

点击“Getting start”按钮,进入页面:https://hadoop.apache.org/docs/stable/hadoop-project-dist/hadoop-common/SingleCluster.html

在此项目上有Java版本说明

点击链接:https://cwiki.apache.org/confluence/display/HADOOP2/HadoopJavaVersions

从页面说明上,需要Java7版本

得出最终结论:Spark2.4.5,Hadoop2.7,Java7

下载Hadoop2.7,由于下载页面上没有此版本,打开页面上的“mirror sit”链接,进入镜像网站https://www.apache.org/dyn/closer.cgi/hadoop/common 下载2.7版本