热门标签

热门文章

- 1xgboost 特征 模型 调参 保存 部署 推理_xgboost 模型加载与预测

- 2架构之争:数用一体VS数用分离,谁才是永远滴神

- 3[AI绘图教程]提示词prompt的基本使用_负向提示词

- 4Elasticsearch环境搭建详细教程_elasticsearch 搭建

- 5【Git小白使用教程,一看就会用,快速上手Git(二——建立本地仓库和对Gitee或GitHub远程仓库的拉取和推送】_git创建本地仓库

- 6点击按钮弹出模态框实现_怎么函数通过点击图片显示模态框

- 7Python机器学习库sklearn几种回归算法建模及分析(实验)_sklearn中都有哪些回归算法regression

- 8威纶通触摸屏模板,直接打开就可以用 威纶通触摸屏,全部图库_威纶通模板

- 9opencv(14):error: expected type-specifier operator cv::_InputOutputArray()

- 10尾递归(Tail Recursion)

当前位置: article > 正文

【书生·浦语大模型实战营04】《(4)XTuner 大模型单卡低成本微调实战》学习笔记

作者:我家小花儿 | 2024-02-18 06:00:04

赞

踩

【书生·浦语大模型实战营04】《(4)XTuner 大模型单卡低成本微调实战》学习笔记

《(4)XTuner 大模型单卡低成本微调实战》

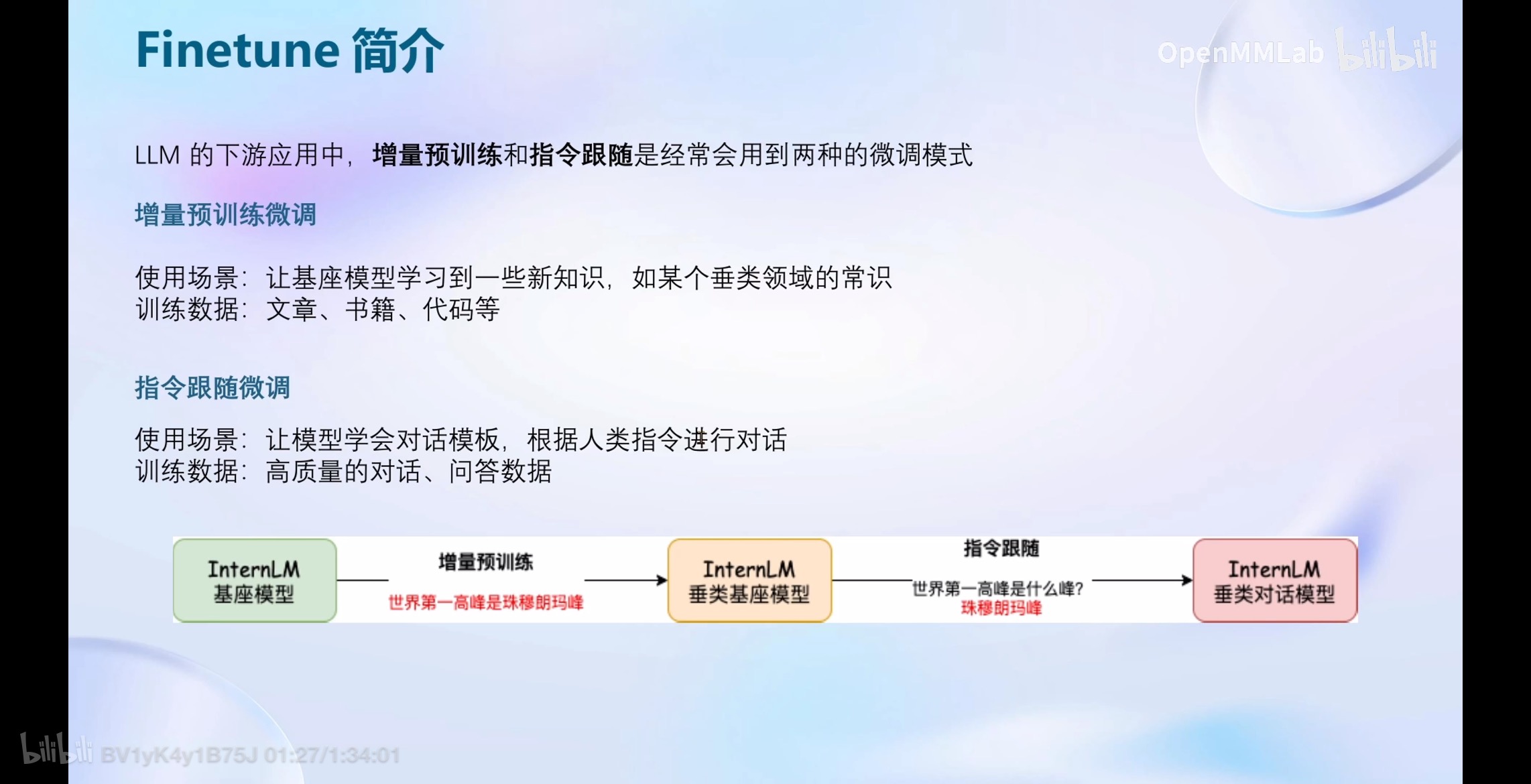

1 Finetune简介

LLM的下游应用中,增量预训练和指令跟随是经常会用到两种的微调模式

LLM的下游应用中,增量预训练和指令跟随是经常会用到两种的微调模式

1.1 增量预训练微调

使用场景:让基座模型学习到一些新知识,如某个垂类领域的常识

训练数据:文章、书籍、代码等

1.2 指令跟随微调

使用场景:让模型学会对话模板,根据人类指令进行对话

训练数据:高质量的对话、问答数据

1.2.1 对话角色

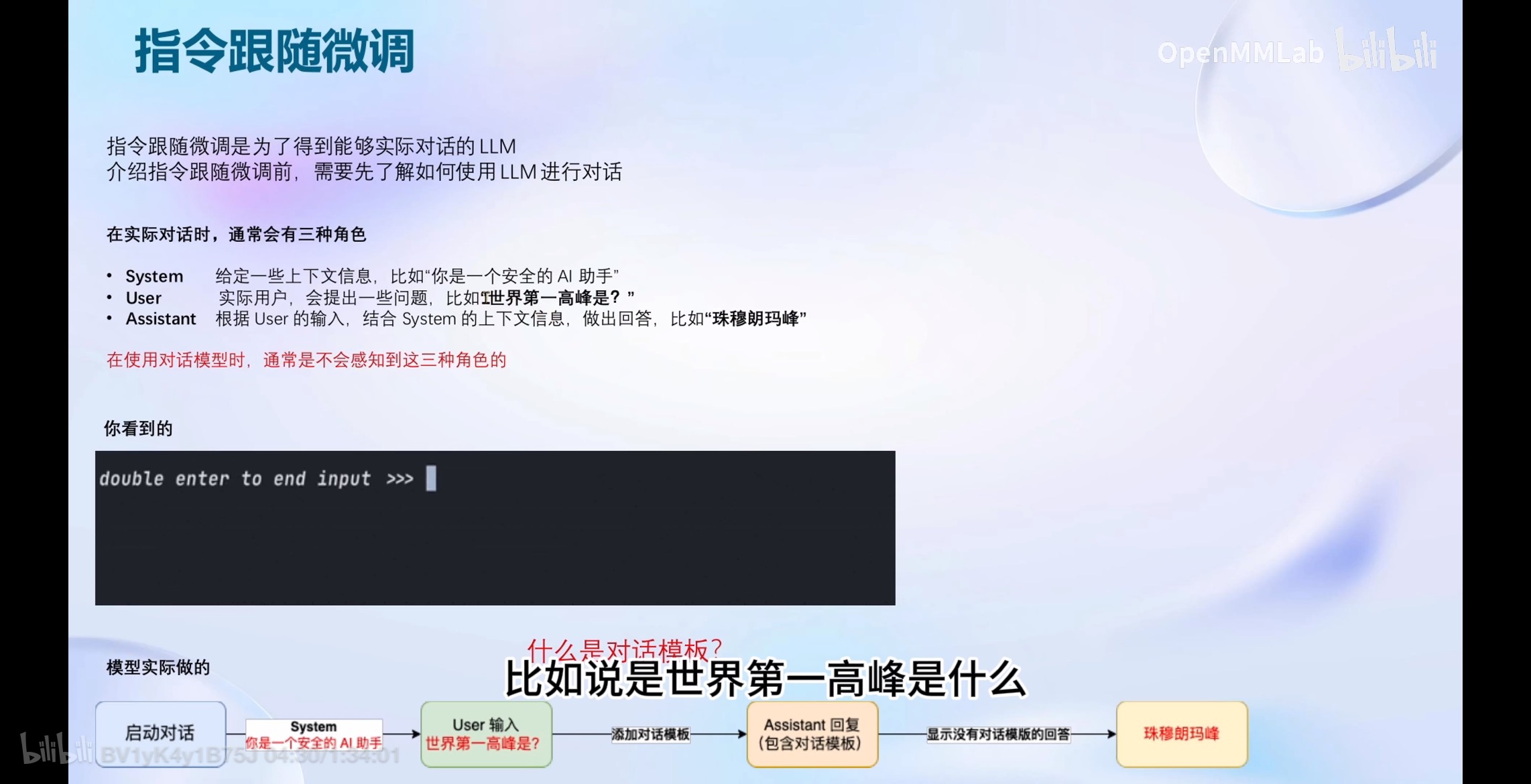

指令跟随微调是为了得到能够实际对话的LLM;

介绍指令跟随微调前,需要先了解如何使用LLM进行对话;

在实际对话时,通常会有三种角色

- System:给定一些上下文信息,比如“你是一个安全的AI助手”

- User:实际用户,会提出一些问题,比如T世界第一高峰是?”

- Assistant:根据User的输入,结合System的上下文信息,做出回答,比如“珠穆朗玛峰”

在使用对话模型时,通常是不会感知到这三种角色的;

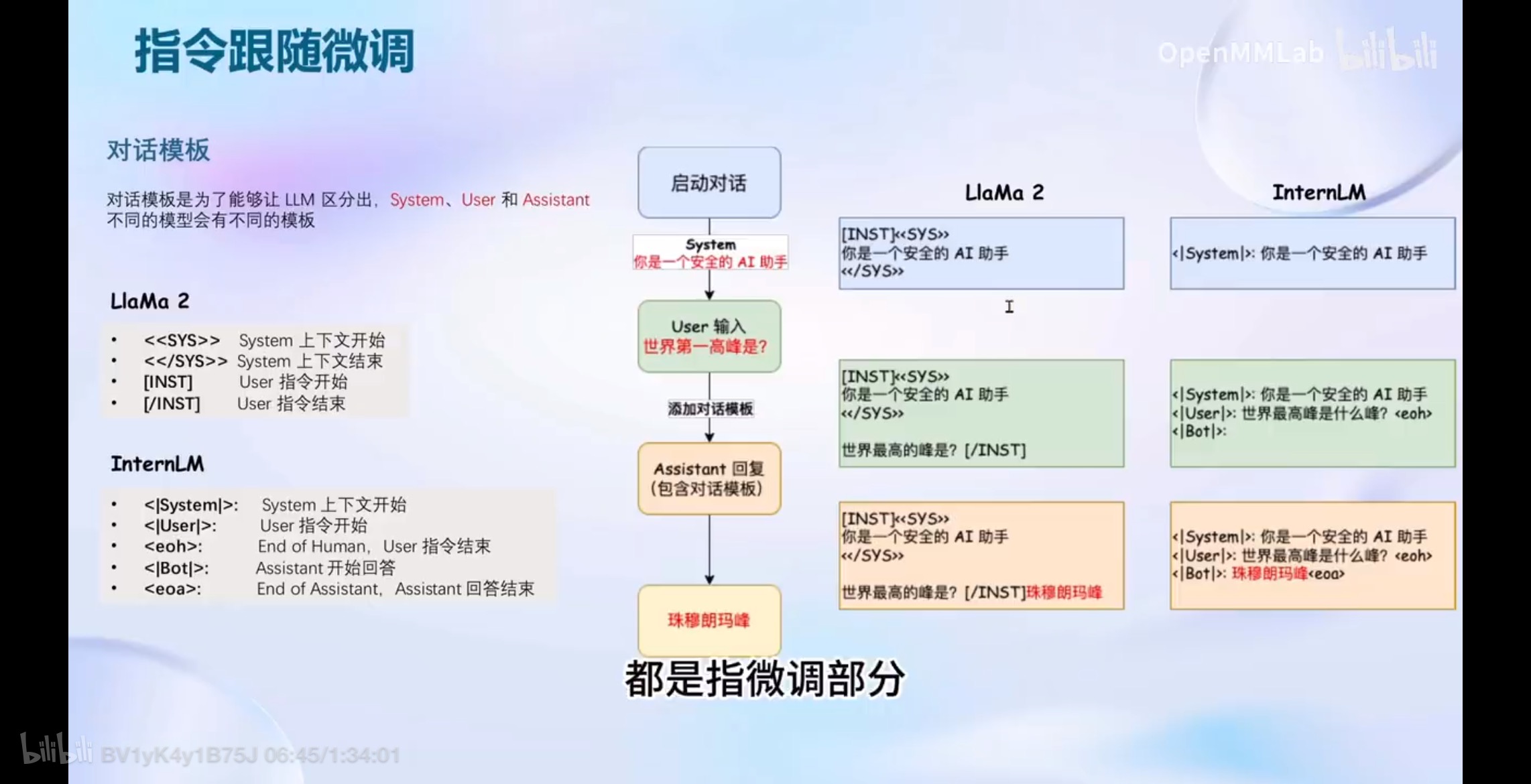

1.2.2 对话模板

对话模板是为了能够让LLM区分出,System、User和Assistant;

不同的模型会有不同的模板;

LlaMa 2 模板

- <<SYS>>: System上下文开始

- <</SYS>>: System上下文结束

- [INST]: User指令开始

- [/INST]: User 指令结束

InternLM模板

- <|System|>: System上下文开始

- <|User|>: User指令开始

- <eoh>: End of Human,User 指令结束

- <|Bot|>: Assistant开始回答

- : End of Assistant,Assistant 回答结束

4 动手实战环节

在InternStudio平台中选择 A100(1/4) 的配置,镜像选择 Cuda11.7-conda;

5 XTuner InternLM-Chat 个人小助手认知微调实践

5.2.2 数据准备

对话数据要复制很多份,直到训练后出现效果才可以;

5.2.3 配置准备

Note:修改示例代码中的每一行都要进行替换,包括

evaluation_inputs属性。

5.2.4 微调启动

cd /root/personal_assistant/config && xtuner train /root/personal_assistant/config/internlm_chat_7b_qlora_oasst1_e3_copy.py

- 1

5.2.5 微调后参数转换/合并

Note:如果是重复测试,微调前需要删除

hf和hf_merge文件夹。

5.2.6 网页DEMO

请介绍一下你自己

- 1

Troubleshooting

(1)“在 Windows-PS 终端上执行ssh-keygen -t rsa卡住无响应”

在 Windows-PS 终端上执行ssh-keygen -t rsa命令,PS终端显示:

Generating public/private rsa key pair.

Enter file in which to save the key (C:\Users\xxx/.ssh/id_rsa):_

- 1

- 2

然后提示符在闪烁,不过10分钟左右之后却一直没有任何响应;

开启pig导致无法正常使用ssh命令;

关闭pig软件再使用ssh命令;

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/我家小花儿/article/detail/105440

推荐阅读

相关标签