- 1还不懂 ConcurrentHashMap ?这份源码分析了解一下_concurrenthashmap源码分析

- 2非常实用的log调试工具:logcat

- 3Springboot网上租车系统的设计与实现 计算机毕设源码64297_基于spring boot的车辆租赁管理系统设计与实现流程图

- 4分布式锁初探--redis锁_sessioncallback

sessioncallback = new ses - 5前端学习(20):无序列表_前段无序

- 6FPGA/IC秋招经典100题(含详解)_对11.916无损定点化

- 7使用hping3网络工具构造TCP/IP数据包和进行DDos攻击

- 8若将瑞星比Borland 刘旭略胜Anders_anders delphi4.0

- 9CSS知识点汇总(第三篇:为网页添加列表)_请简要描述,使用背景图像定义列表项目符号的好处。

- 10xxx cannot be cast to xxx_cannot cast xx to xx

国产开源中文大语言模型再添重磅玩家:清华大学NLP实验室发布100亿参数规模的开源可商用大语言模型CPM-Bee_清华大语言模型在哪访问

赞

踩

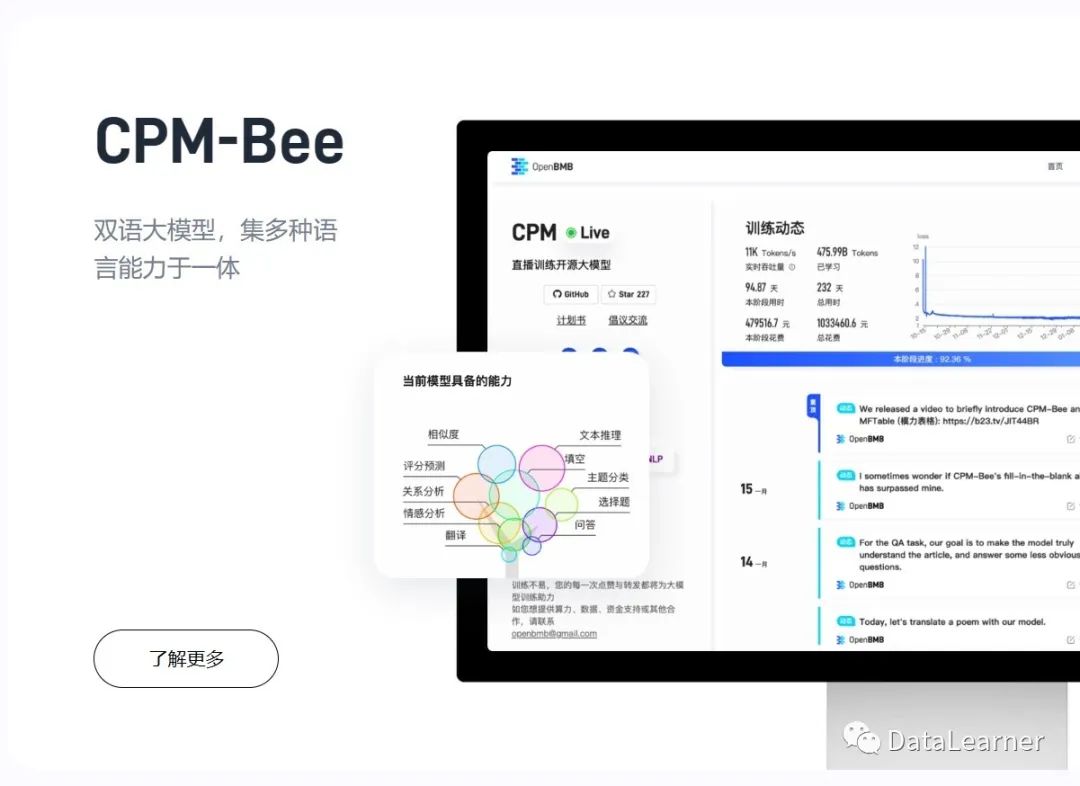

5月27日,OpenBMB发布了一个最高有100亿参数规模的开源大语言模型CPM-BEE,OpenBMB是清华大学NLP实验室联合智源研究院成立的一个开源组织。该模型针对高质量中文数据集做了训练优化,支持中英文。根据官方的测试结果,其英文测试水平约等于LLaMA-13B,中文ZeroCLUE评测结果仅次于人类水平。

开源地址:OpenBMB/CPM-Bee: 百亿参数的中英文双语基座大模型 (github.com)

此前,国产开源大语言模型最强的应该是ChatGLM-6B(https://www.datalearner.com/ai-models/pretrained-models/ChatGLM-6B ),这也是清华大学研究成果,是清华大学KEG小组发布的,在国内外都有很好的反响,截止5月26日,ChatGLM-6B 全球下载达到200万。相比较ChatGLM-6B,CPM-Bee的主要特点如下:

- 开源协议更加友好,只要获取书面授权即可商用。代码、预训练结果均开源,训练过程也是全球直播。

- 从评测结果看,CPM-Bee模型效果也很优秀,中文ZeroCLUE评测中远超其它模型,仅次于人类,英文多个任务评测结果也与LLaMA-13B差不多,部分任务上的表现超越GPT-3。

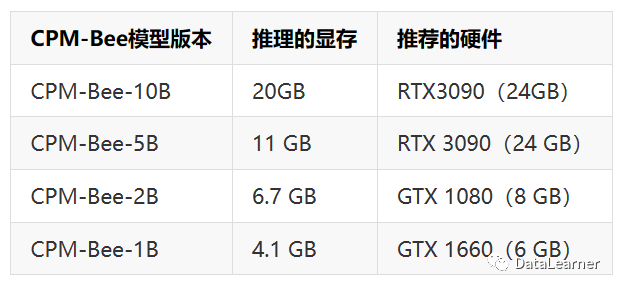

- 推理成本与ChatGLM-6B差不多,最低10亿参数规模的模型仅需要4.1GB显存可做推理,而100亿参数规模的推理仅需20GB显卡,单张消费级显卡即可。

总的来说,CPM-Bee是值得大家关注的模型,如果商用协议未来保持友好,且不断升级迭代,那也许会是一个可以和ChatGLM-6B模型竞争的一个国产替代好选择~

CPM-Bee简介

CPM全称Chinese Pretrained Model,Bee是该系列模型的第二个里程碑版本。

CPM-Bee模型是基于CPM-Ant模型继续训练得到。后者是2022年5月到9月训练的大语言模型。而CPM-Bee则是从2022年10月13日开启训练,相比之前,模型在很多任务上做了优化,包括文字填空、文本生成、问答等。

这是一个基于transformer架构的自回归模型,在高质量的中英文数据集上训练了半年左右的时间。包含4个系列的预训练结果,参数分别是10亿、20亿、50亿和100亿。CPM-Bee模型的相关信息如下:

根据官方的描述,CPM-Bee的中文数据集原始数据有1TB左右,做了预处理清洗之后有200GB的高质量中文数据集结果。并加入了400GB的多语言数据集,但没有透露数据集的具体信息。

CPM-Bee训练时间230天,成本85万左右。训练的tokens数量约6380亿左右(本部分数据与GitHub介绍有冲突)。

此外,CPM-Bee的一个特点是在推理上占用的资源很小:

可以看到,最小的10亿参数版本的模型仅需要4.1GB显存即可运行!50亿参数规模版本需要11GB显存。另一个清华大学著名的开源模型ChatGLM-6B版本的推理需要13GB显存。

CPM-Bee的效果

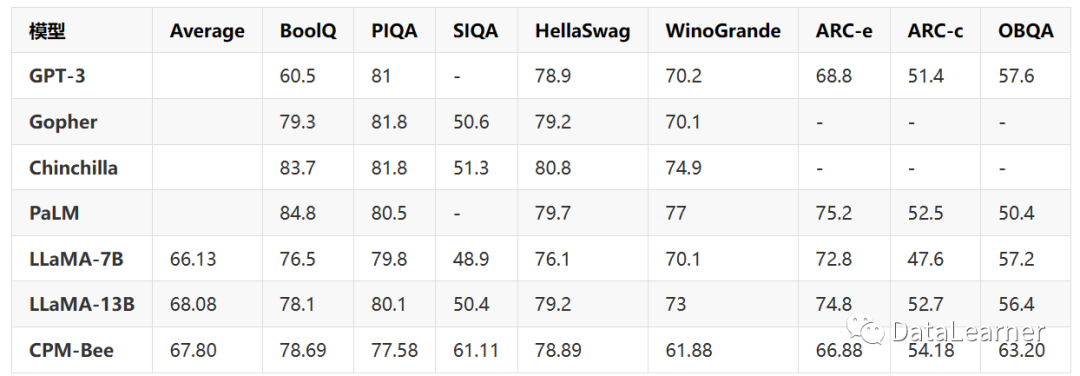

为了测试CPM-Bee的训练效果,官方在中英文的数据集上做了多项测试。

首先是在中文的ZeroCLUE上的测试结果。这是一个专门针对中文大语言模型的评测排行。CPM-Bee的评测得分排行第二,仅次于人类。超过了百度、阿里云等相关模型。

在英文评测上,其测试结果也超过了LLaMA-7B,与LLaMA-13B的得分相当。甚至在BooQ、ARC-c和OBQA的任务上超过了GPT-3!可以说是十分不错。

CPM-Bee的开源协议

CPM-Bee作为一个完全开源的中文大语言模型,不仅测试结果很好,在开源方面也十分“大方”。

官方使用了自己的一个自定义开源协议,不过限制较为宽松。代码和模型预训练结果均开源,而模型的预训练结果的商用也只是需要获取官方书面授权即可(官方未说明是否收费)。

另一个比较有意思的是CPM-Bee模型的训练过程也是一个完全开放的过程,官方在社区上公布了完整的模型训练过程,目前最新的训练停留在2023年3月27日,loss结果0.691974,成本85万,时间230天。

除此之外,官方公布了训练过程中遭遇到的一系列问题,包括显存不足、磁盘空间不足等一系列问题,也是大家观察大模型训练最好的方法。

具体的模型信息和下载地址大家参考CPM-Bee模型的模型信息卡信息:

程中遭遇到的一系列问题,包括显存不足、磁盘空间不足等一系列问题,也是大家观察大模型训练最好的方法。

具体的模型信息和下载地址大家参考CPM-Bee模型的模型信息卡信息:

https://www.datalearner.com/ai-models/pretrained-models/CPM-Bee