热门标签

热门文章

- 1现在公司都在用的CI/CD框架到底是什么?_cicd用的什么

- 2共享负载均衡后端的主机健康检查状态是异常的解决

- 3DSP与FPGA的技术特点和区别是什么?_dsp芯片与fpga区别

- 4【攻防世界】bug

- 5第五届河南省CCPC河南省省赛题解+复盘_河南省第五届ccpc

- 6最新AI创作系统ChatGPT网站源码Midjourney-AI绘画系统,Suno-v3-AI音乐生成大模型。

- 7国产Ai代码助手,通义灵码IDEA安装教程_通义灵码idea下载

- 8Python小游戏:100行代码实现贪吃蛇小游戏

- 9Python淘宝体育用品销售数据可视化分析大屏全屏系统

- 10Spring Boot 3跨域方案详解:告别CORS烦恼_spring boot 3.0 增加cores 跨域配置

当前位置: article > 正文

第五课课程笔记 LMDeploy 量化部署 LLM-VLM 实践

作者:我家小花儿 | 2024-04-17 15:21:05

赞

踩

第五课课程笔记 LMDeploy 量化部署 LLM-VLM 实践

大模型部署背景

- 部署:指的是将开发完毕的软件投入使用的过程

- 人工智能模型部署:是将训练好的深度学习模型在特定环境中运行的过程

- 大模型部署面临的挑战

- LLM参数量巨大,前向推理inference需要大量计算

- GPT3有175B,20B的算小模型了

- 内存开销巨大

- FP16,20B模型加载参数需要显存40G+,175B模型需要350G+

- 20B模型kv缓存需要显存10G,合计需要50G显存

- RTX 4060X消费级独显,显存8G

- 访存瓶颈。数据交换速度不够,显存带宽比起访存量偏小,无法发挥GPU的计算能力。

- 动态请求。请求量不确定,GPU计算能力发挥不足。

- LLM参数量巨大,前向推理inference需要大量计算

大模型部署方法

- 三种:模型剪枝

- 模型剪枝 pruning

- 减少模型中的冗余参数

- 知识蒸馏

- 用大模型作为teacher,用teacher去训练一个student的小模型

- 早期用于计算机视觉任务

- 量化 Quantization

- 把浮点数转换为整数或其他离散形式,减轻存储和计算负担

- 可以提升计算速度。因为可以降低访存量,显著降低数据传输时间,提升计算效率。

LMDeploy简介

- 是涵盖LLM任务的全套轻量化、部署和服务的解决方案

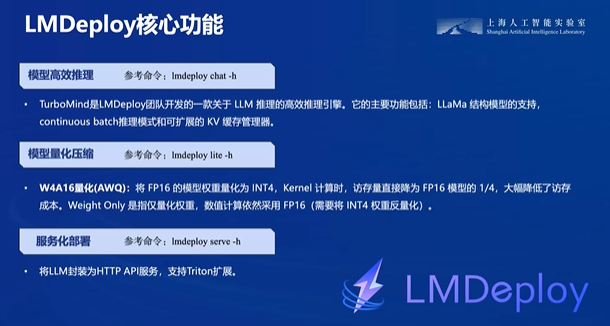

- 三大核心功能

- 模型高效推理。

- 模型量化压缩

- 服务化部署

- 性能表现优异,有突出优势

- 支持语言模型,也支持多模态大模型,视觉任务,可以使用pipeline便捷运行

动手实践环节

- 安装、部署、量化

- 参考文档说明

- 一共6个章节

- 注意点

- cuda12.2环境

- terminal操作

- internstudio内安装比较方便

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/我家小花儿/article/detail/440894

推荐阅读

相关标签