热门标签

热门文章

- 1C语言--数据结构:单链表

- 2hbase 列族 版本数,TTL和二级索引_hbase最大版本数为什么是1

- 3Spring Boot+Redis 扛住,瞬间千次重复提交_springboot利用redis防止数据重复提交

- 4DFS和BFS(广度优先搜索和深度优先搜索)5个经典例子_深度优先搜索例子

- 5汽车最强大脑ECU和单片机是什么关系_ecu单片机

- 6机器人学环境配置(VM-16 + Ubuntu-20.04 + ROS-noetic)

- 7C++算法 —— 动态规划(1)斐波那契数列模型_c用动态规划法求解斐波那契问题

- 8反向传播算法推导过程(看一篇就够了)_神经网络反向传播算法推导

- 9vivado使用方法(初级)_vivado使用教程

- 10中国IT工作者35岁后的发展出路调查报告(转载)_35岁以后失业的出路

当前位置: article > 正文

LMDeploy 量化部署 LLM&VLM 实践

作者:盐析白兔 | 2024-04-17 14:06:49

赞

踩

LMDeploy 量化部署 LLM&VLM 实践

第五节课作业

基础作业(结营必做)

完成以下任务,并将实现过程记录截图:

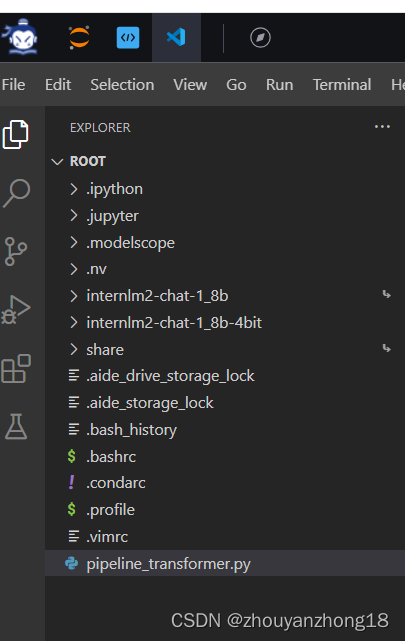

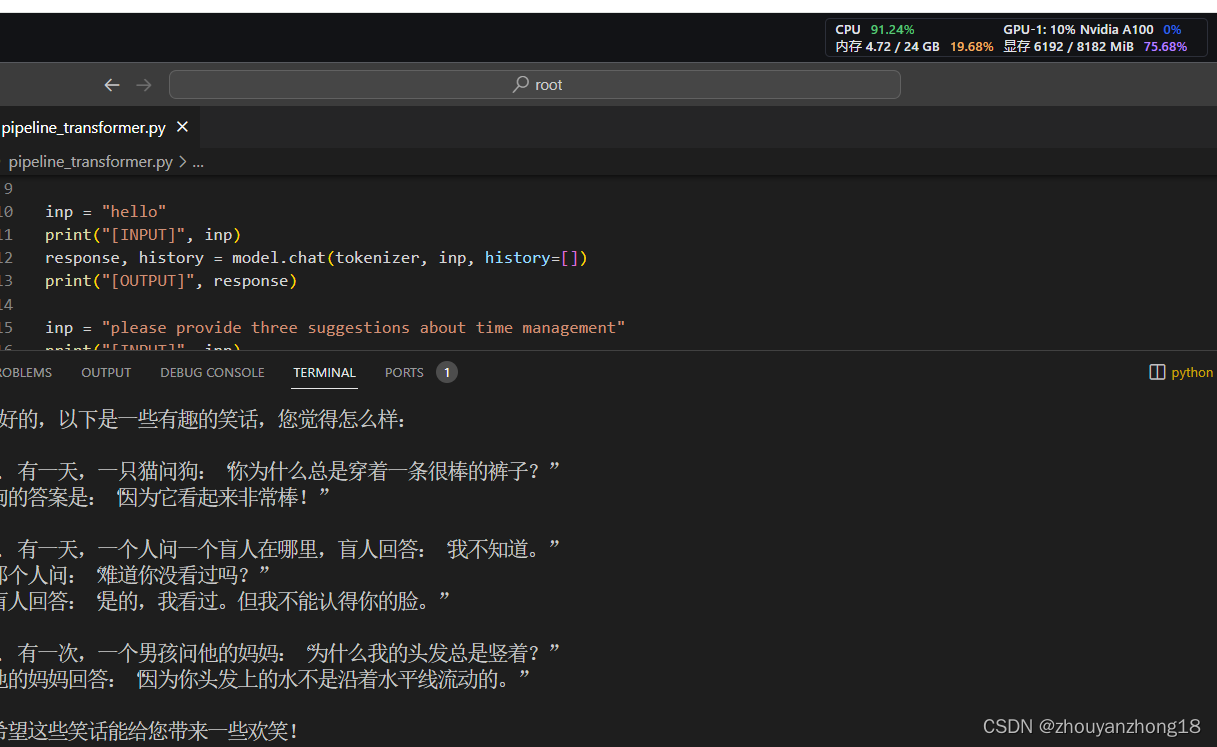

- 配置lmdeploy运行环境,下载internlm-chat-1.8b模型,以命令行方式与模型对话

图 1下载模型

图 2模型命令行对话

进阶作业

完成以下任务,并将实现过程记录截图:

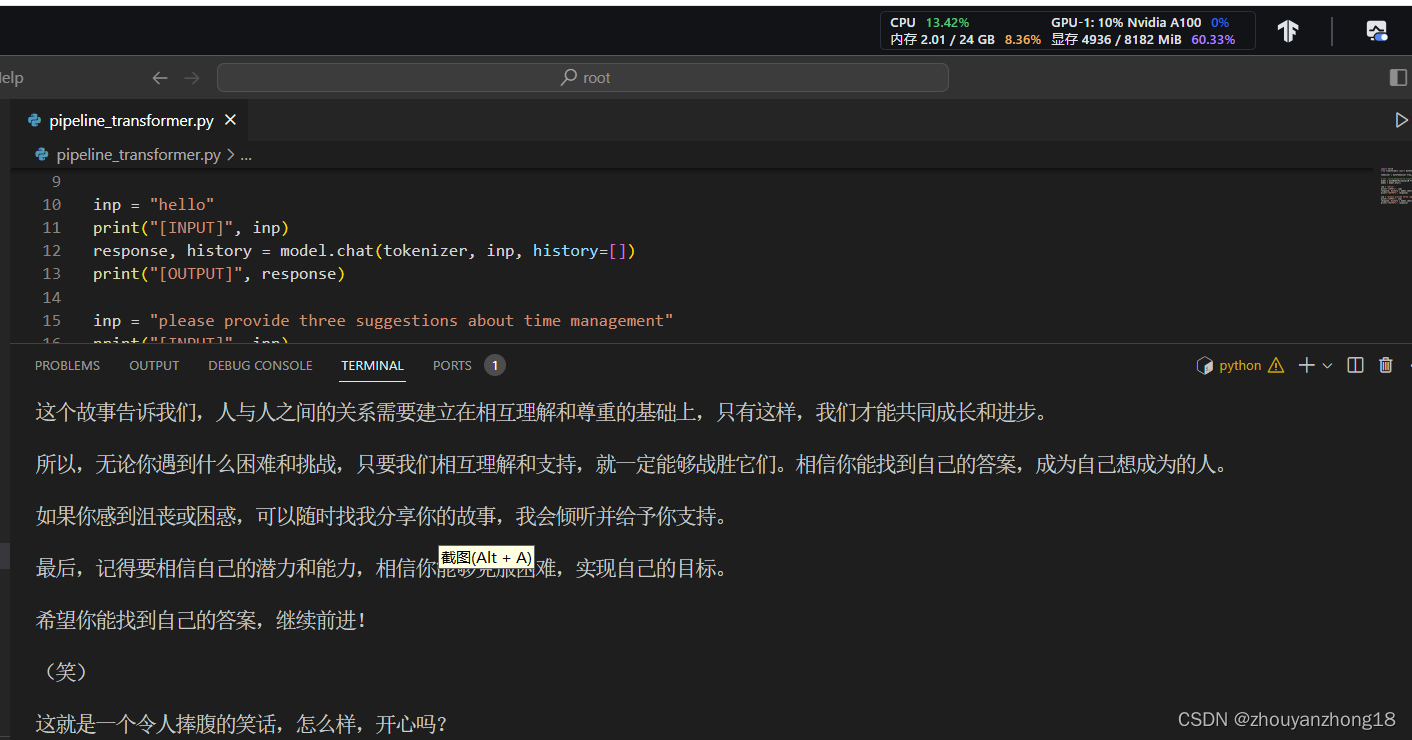

2.设置KV Cache最大占用比例为0.4,开启W4A16量化,以命令行方式与模型对话。(优秀学员必做)

图 3量化对话

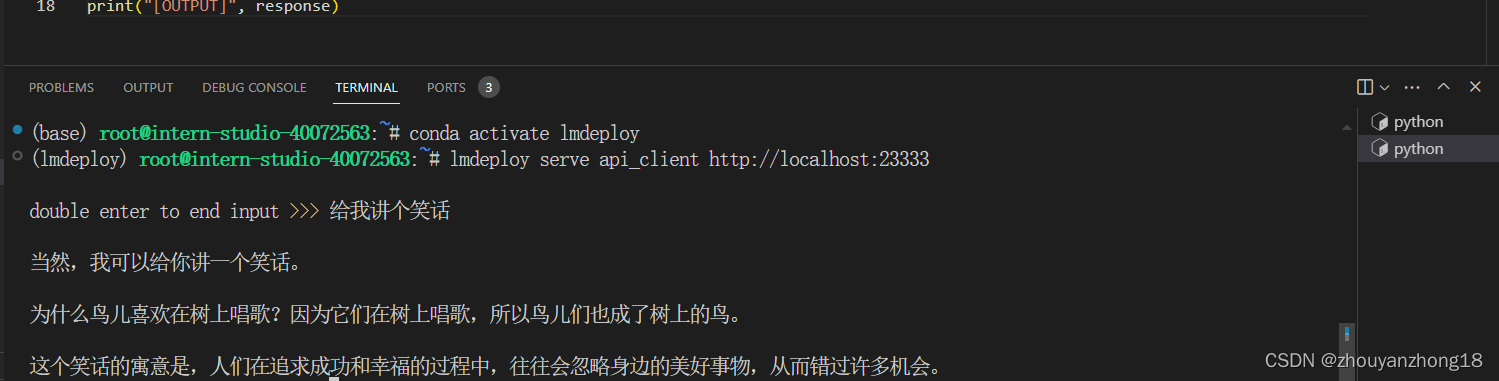

3.以API Server方式启动 lmdeploy,开启 W4A16量化,调整KV Cache的占用比例为0.4,分别使用命令行客户端与Gradio网页客户端与模型对话。(优秀学员)

图 4命令行客户端

图 5Gradio网页客户端

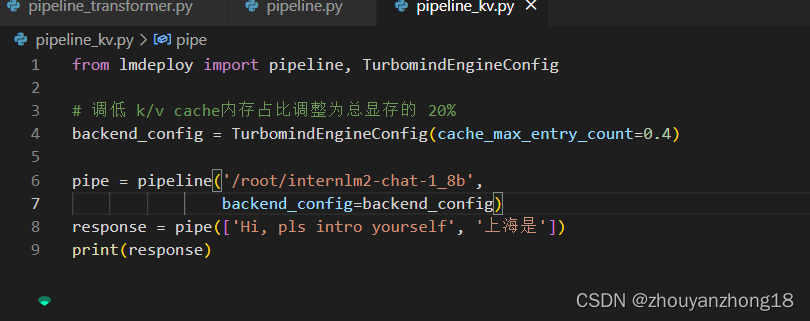

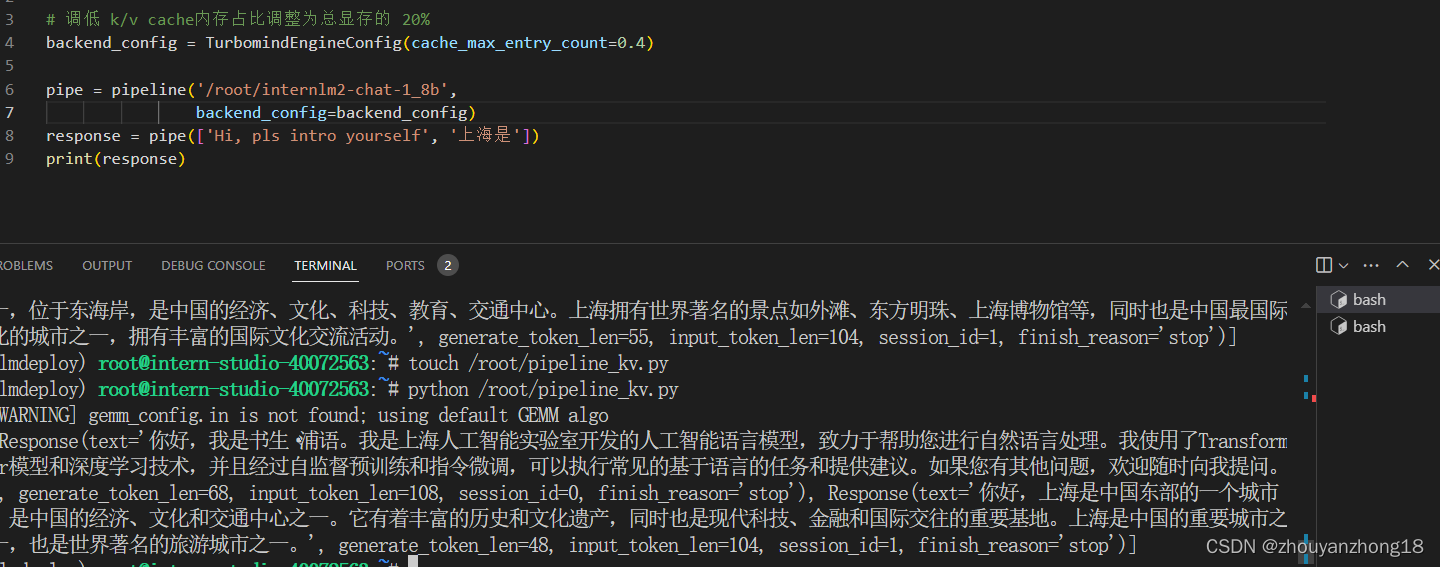

4.使用W4A16量化,调整KV Cache的占用比例为0.4,使用Python代码集成的方式运行internlm2-chat-1.8b模型。(优秀学员必做)

图 6 代码集成对话

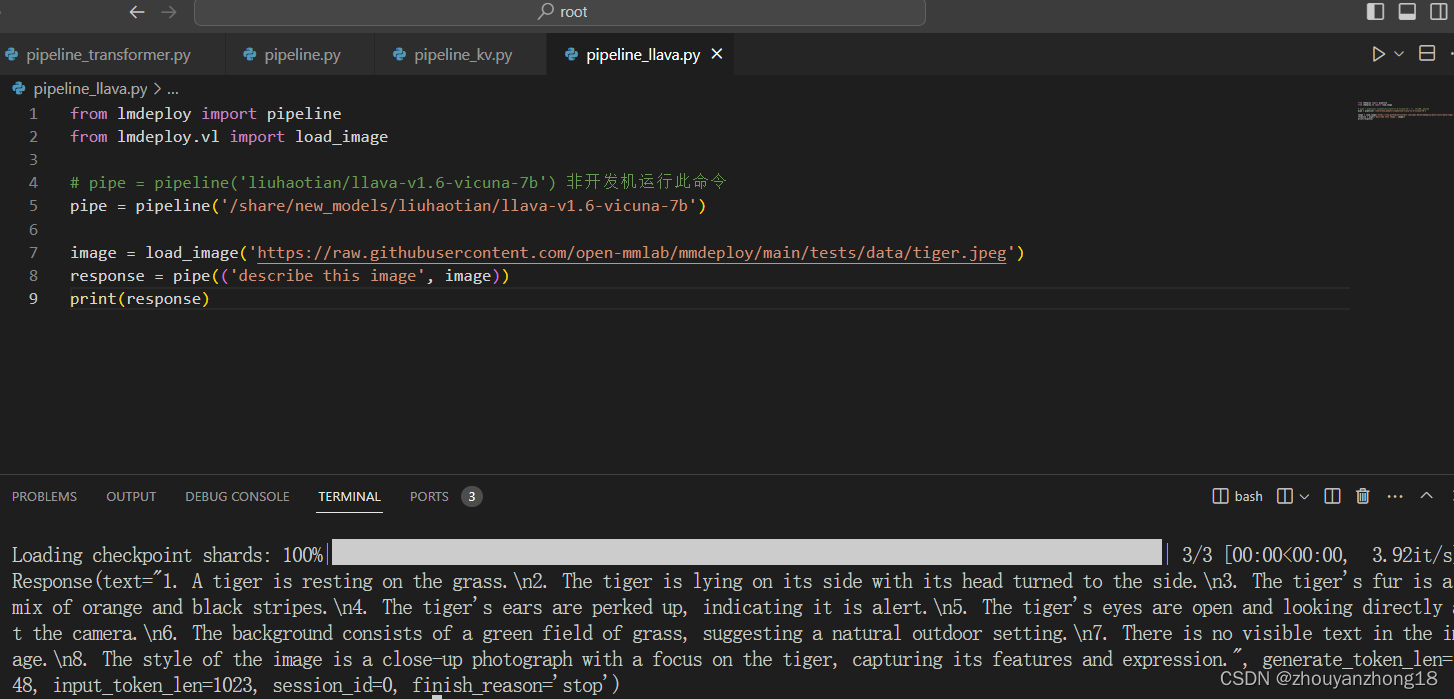

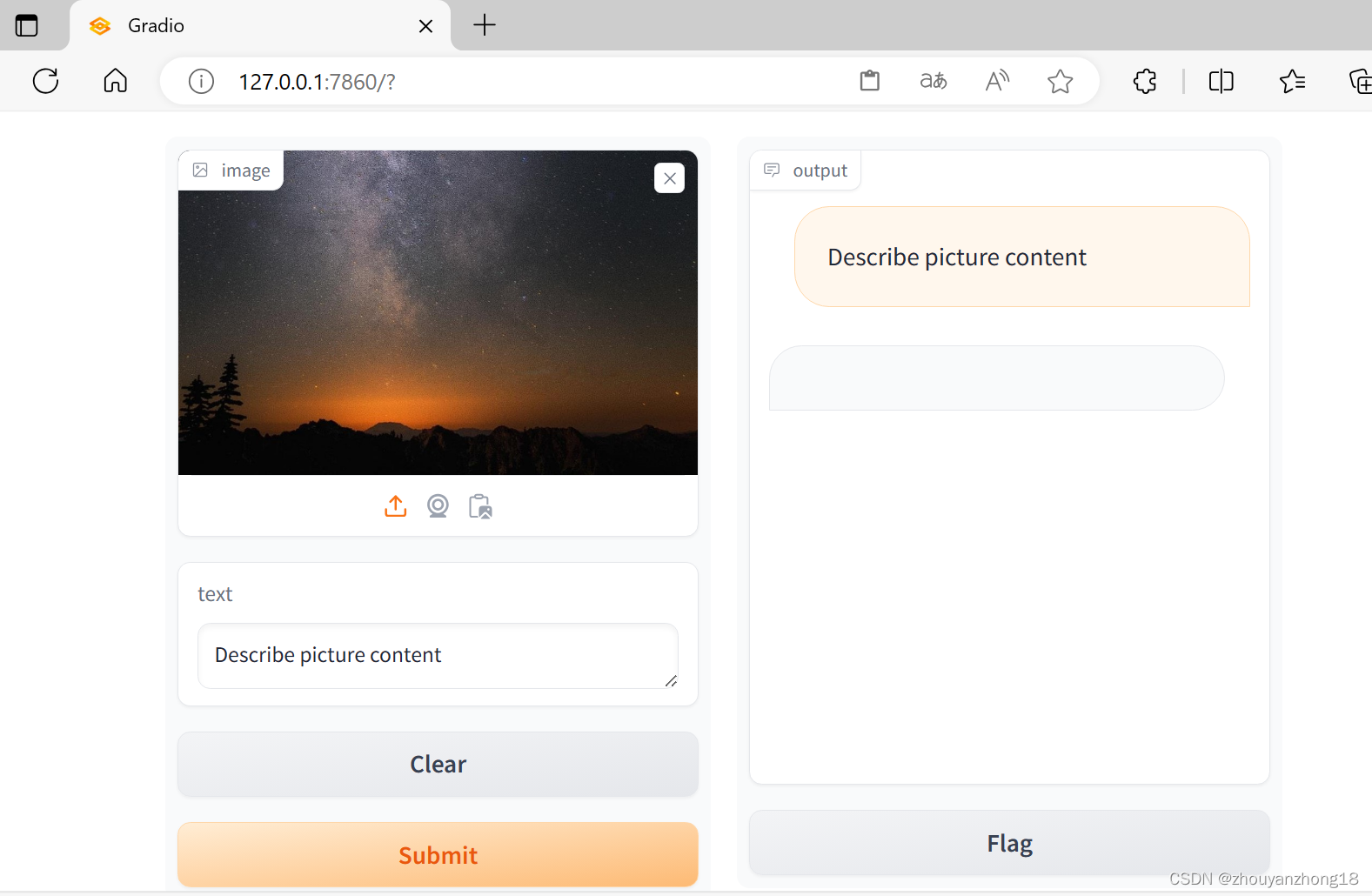

5.使用 LMDeploy 运行视觉多模态大模型 llava gradio demo (优秀学员必做)

图 7gradio demo展示

不知道为什么最后的网页版VLM为啥没回复,等了十分钟左右也没输出错也没输出结果,不知道为什么。

本文内容由网友自发贡献,转载请注明出处:【wpsshop博客】

推荐阅读

相关标签