- 1ChatGPT 究竟在做什么?它为何能做到这些?(2)

- 2python暂停和恢复游戏_pygame游戏之旅 添加游戏暂停功能

- 339.利用matlab寻找素数(matlab程序)_if(~mod(i,j))

- 4华为手机如何升级鸿蒙系统_华为手机如何开启鸿蒙系统?

- 5字节跳动2022校招研发提前批宣讲会,同学们最关心的10个问题

- 6java调用oracle删除,使用IDEA对Oracle数据库进行简单增删改查操作

- 7C语言-啤酒饮料问题_c语言的啤酒饮料问题。

- 8pytorch实现 CNN_LSTM_Attention_DNN网络模型_cnn_lstm_attention python代码

- 9Linux 之 用户、用户组以及权限_添加名为helloworld一般用户

- 10使用树梅派将设备通过Link SDK接入阿阿里云IoT物联网平台_怎么使用sdk将树莓派和云平台连接

常见的机器学习算法与人工神经网络_机器学习和神经网络算法

赞

踩

目录

2. 图神经网络Graph Neural Networks (GNN)

3. 卷积神经网络Convolutional Neural Network (CNN)

3.6 全连接层Fully-connected layer (FC)

1. 邻近算法K-NearesNeighbor (KNN)

KNN(K- Nearest Neighbor)法即K最邻近法,最初由 Cover和Hart于1968年提出,是一个理论上比较成熟的方法,也是最简单的机器学习算法之一。该方法的思路非常简单直观:如果一个样本在特征空间中的K个最相似(即特征空间中最邻近)的样本中的大多数属于某一个类别,则该样本也属于这个类别。该方法在定类决策上只依据最邻近的一个或者几个样本的类别来决定待分样本所属的类别。

1.1 KNN算法核心思想

KNN算法的核心思想是,如果一个样本在特征空间中的K个最相邻的样本中的大多数属于某一个类别,则该样本也属于这个类别,并具有这个类别上样本的特性。该方法在确定分类决策上只依据最邻近的一个或者几个样本的类别来决定待分样本所属的类别。KNN方法在类别决策时,只与极少量的相邻样本有关。由于KNN方法主要靠周围有限的邻近的样本,而不是靠判别类域的方法来确定所属类别的,因此对于类域的交叉或重叠较多的待分样本集来说,KNN方法较其他方法更为适合。

1.2 KNN算法步骤

总体来说,KNN分类算法包括以下4个步骤:

①准备数据,对数据进行预处理。

②计算测试样本点(也就是待分类点)到其他每个样本点的距离。

③对每个距离进行排序,然后选择出距离最小的K个点。

④对K个点所属的类别进行比较,根据少数服从多数的原则,将测试样本点归入在K个点中占比最高的那一类。

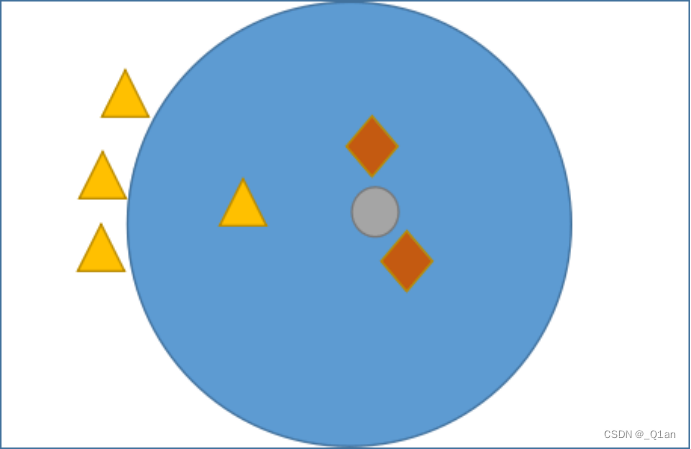

1.3 KNN预测分类

如图 1 所示,有三角形和菱形两个类别,而“灰色圆”是一个未知类别,现在通过 KNN 算法判断“灰色圆”属于哪一类。如果当 K 的取值为 3 时,按照前面讲述的知识,距离最近且少数服从多数,那“灰色圆”属于菱形类,而当 K= 6 时,按照上述规则继续判断,则“灰色圆”属于三角形类。

2. 图神经网络Graph Neural Networks (GNN)

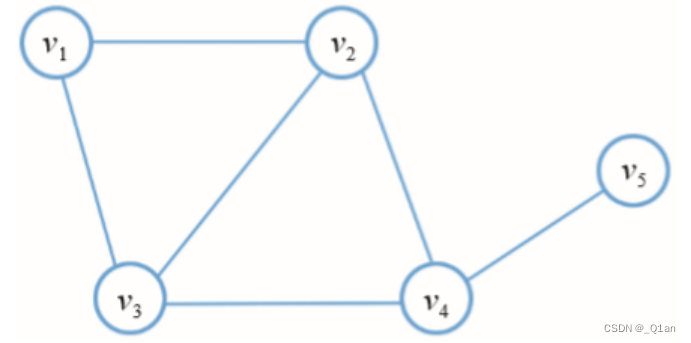

2.1图的基本定义

在计算机科学中,图是由顶点和边两部分组成的一种数据结构。图G可以通过顶点集合V和它包含的边E来进行描述。

![]()

根据顶点之间是否存在方向依赖关系,边可以是有向的,也可以是无向的。

2.2 图神经网络模型

图神经网络是一种直接作用于图结构上的神经网络。GNN的一个典型应用是节点分类,本质上,图中的每个节点都与一个标签相关联,我们希望预测未标记节点的标签。

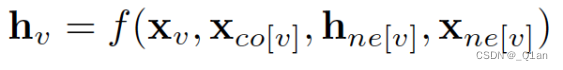

在节点分类问题中,每个节点v都可以用其特征x_v表示并且与已标记的标签t_v相关联。给定部分标记的图G,目标是利用这些标记的节点来预测未标记的节点标签。它通过学习得到每个节点的d维向量(状态)表示为h_v,同时包含其相邻节点的信息。

x_co[v] 代表连接顶点v的边的特征,h_ne[v]代表顶点v的邻居节点的嵌入表示,x_ne[v]代表顶点v的邻居节点特征。f是将输入投影到d维空间的转移函数,由于要求出h_v的唯一解,我们应用Banach不动点理论重写上述方程进行迭代更新。

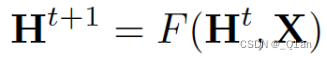

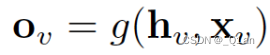

H和X分别表示所有h和x的连接,通过将状态h_v以及特征x_v传递给输出函数g来计算GNN的输出。

这里的f和g都可以解释为全连接前馈神经网络,L1损失可以直接表述为如下函数:

它可以通过梯度下降进行优化

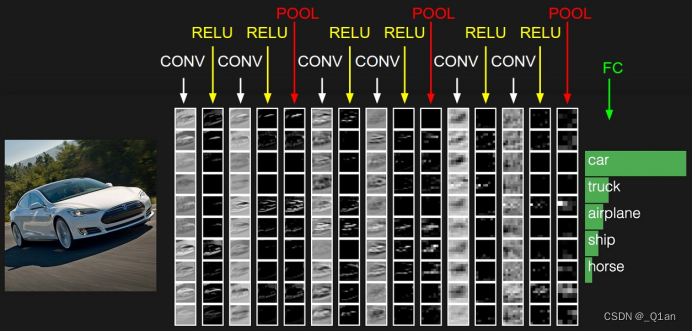

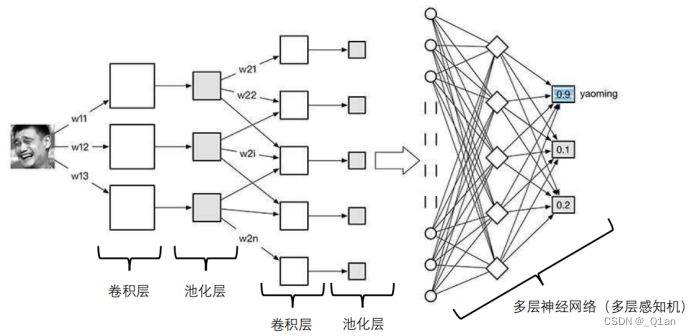

3. 卷积神经网络Convolutional Neural Network (CNN)

卷积神经网络(Convolutional Neural Network, CNN)是一种前馈神经网络,它的人工神经元可以响应一部分覆盖范围内的周围单元,对于大型图像处理有出色表现。

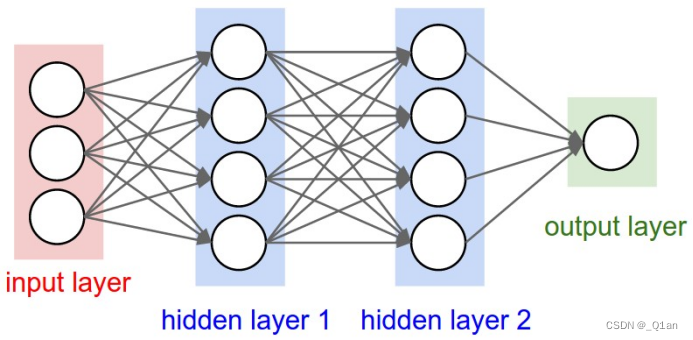

3.1 CNN的结构

卷积神经网络通常包含以下几种层:

卷积层(Convolutional layer),卷积神经网路中每层卷积层由若干卷积单元组成,每个卷积单元的参数都是通过反向传播算法优化得到的。卷积运算的目的是提取输入的不同特征,第一层卷积层可能只能提取一些低级的特征如边缘、线条和角等层级,更多层的网络能从低级特征中迭代提取更复杂的特征。

线性整流层(Rectified Linear Units layer, ReLU layer),这一层神经的活性化函数(Activation function)使用线性整流(Rectified Linear Units, ReLU)f(x)=max(0,x)f(x)=max(0,x)。

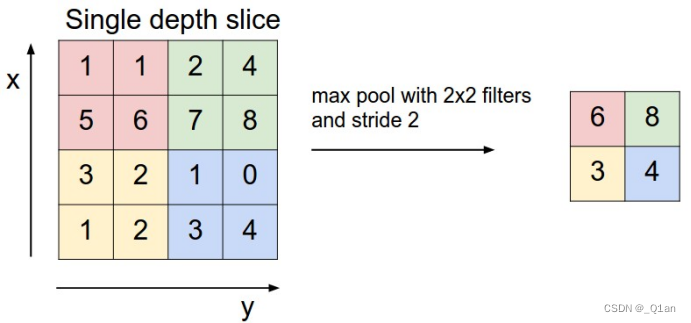

池化层(Pooling layer),通常在卷积层之后会得到维度很大的特征,将特征切成几个区域,取其最大值或平均值,得到新的、维度较小的特征。

全连接层( Fully-Connected layer), 把所有局部特征结合变成全局特征,用来计算最后每一类的得分。

一个卷积神经网络各层应用实例:

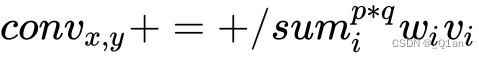

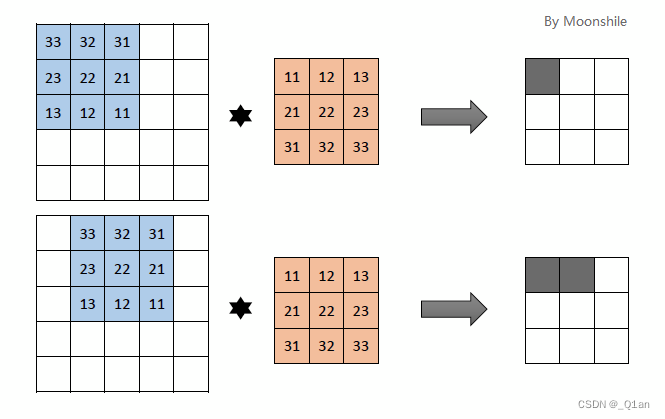

3.2 卷积

CNN中最基础的操作是卷积convolution,再精确一点,基础CNN所用的卷积是一种2-D卷积。也就是说,kernel只能在x,y上滑动位移,不能进行深度 (跨通道) 位移。这可以根据图1来理解,对于图中的RGB图像,采用了三个独立的2-D kernel,如黄色部分所示,所以这个kernel的维度是

在基础CNN的不同stage中,kernel的深度都应当一致,等于输入图像的通道数。

卷积需要输入两个参数,实质是二维空间滤波,滤波的性质与kernel选择有关,CNN的卷积是在一个2-D kernel 和输入的 2-D input map 之间,RGB中各图像通道分别完成。

我们假设单一通道输入图像的空间坐标为(x,y),卷积核大小是p * q,kernel权重为w,图像亮度值是v,卷积过程就是kernel所有权重与其在输入图像上对应元素亮度之和,可以表示为

在CNN中,滤波器filter(带着一组固定权重的神经元)对局部输入数据进行卷积计算。每计算完一个数据窗口内的局部数据后,数据窗口不断平移滑动,直到计算完所有数据。这个过程中,有这么几个参数:

a. 深度depth:神经元个数,决定输出的depth厚度。同时代表滤波器个数。

b. 步长stride:决定滑动多少步可以到边缘。

c. 填充值zero-padding:在外围边缘补充若干圈0,方便从初始位置以步长为单位可以刚好滑倒末尾位置,通俗地讲就是为了总长能被步长整除。

举一个例子:

有32*32*3的图像 (高度、宽度、深度),5*5*3的卷积核,每次移动一个像素,此时

output size = (N-F) / stride + 1

此时N=32,F=5,stride=1

relu激活后得到一个28*28*1的图像,这里WT+b,b是偏置,如果6个卷积核,就得到一个28*28*6的图像,可以对其进行5*5*6的处理,又得到......

3.3 卷积层Convolutional Layer

卷积神经网络中每层卷积层(Convolutional layer)由若干卷积单元组成,每个卷积单元的参数都是通过反向传播算法最佳化得到的。卷积运算的目的是提取输入的不同特征,第一层卷积层可能只能提取一些低级的特征如边缘、线条和角等层级,更多层的网路能从低级特征中迭代提取更复杂的特征。

卷积层接收一个三维输入,此时需要给出4个参数(hyperparameters):

1) 卷积核数量Number of filters

2) 卷积核大小their spatial extent

3) 卷积核移动的幅度大小the stride

4) 边缘填充的数量the amount of zero padding

然后输出一个三维单元

3.4 激活

卷积之后,通常会加入偏置(bias), 并引入非线性激活函数(activation function),这里定义bias为b,activation function 是h(),经过激活函数后,得到的结果是

3.5 池化层Pooling Layer

池化有快速降维、采样的作用

池化(pool)即下采样(downsamples),目的是为了减少特征图。池化操作对每个深度切片独立,相对于卷积层进行卷积运算,池化层进行的运算一般有以下几种:

* 最大池化(Max Pooling)。取4个点的最大值。这是最常用的池化方法。

* 均值池化(Mean Pooling)。取4个点的均值。

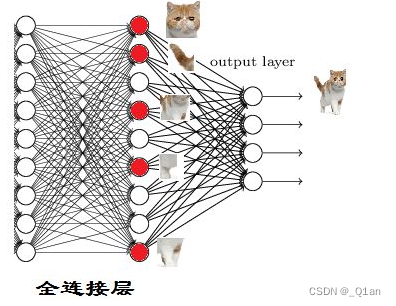

3.6 全连接层Fully-connected layer (FC)

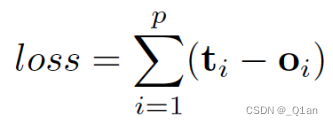

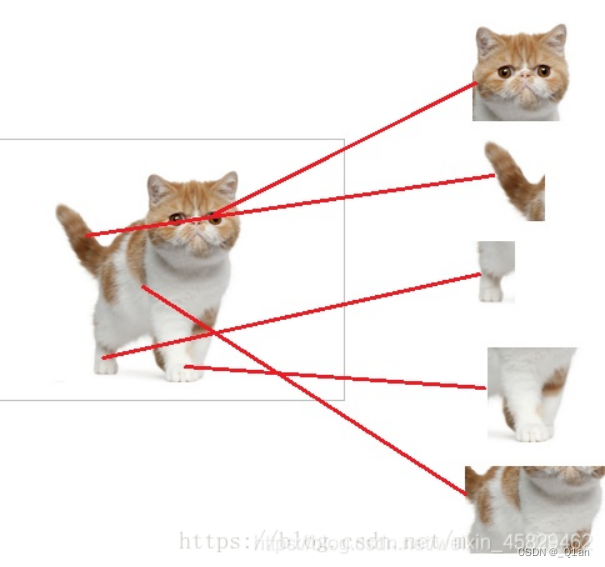

全连接层,是每一个结点都与上一层的所有结点相连,用来把前边提取到的特征综合起来。由于其全相连的特性,一般全连接层的参数也是最多的。

这里使用全连接层通过特征提取,实现分类。

在 CNN 结构中,经多个卷积层和池化层后,连接着1个或1个以上的全连接层.与 MLP 类似,全连接层中的每个神经元与其前一层的所有神经元进行全连接.全连接层可以整合卷积层或者池化层中具有类别区分性的局部信息.为了提升 CNN 网络性能,全连接层每个神经元的激励函数一般采用 ReLU 函数。最后一层全连接层的输出值被传递给一个输出,可以采用 softmax 逻辑回归(softmax regression)进行 分 类,该层也可 称为 softmax 层(softmax layer).对于一个具体的分类任务,选择一个合适的损失函数是十分重要的,CNN 有几种常用的损失函数,各自都有不同的特点.通常,CNN 的全连接层与 MLP 结构一样,CNN 的训练算法也多采用BP算法。

3.7 CNN的应用

一维卷积神经网络常应用于序列类的数据处理;

二维卷积神经网络常应用于图像类文本的识别;

三维卷积神经网络主要应用于医学图像以及视频类数据识别。

3.8 CNN的优缺点

优点:

共享卷积核,优化计算量。

无需手动选取特征,训练好权重,即得特征。

深层次的网络抽取图像信息丰富,表达效果好。

缺点:

需要调参,需要大样本量, GPU等硬件依赖。