- 1鸿蒙真机调试流程_鸿蒙调试profile申请

- 2Spingboot集成Redis之踩坑(二)序列化问题_at org.springframework.data.redis.serializer.strin

- 3完全免费的基于区块链和 IPFS 的去中心化博客平台_crossbell

- 4Matlab训练2_matlab找孪生素数并计数

- 5shell脚本循环执行任务的脚本_shell script 连续任务

- 6详细教程 - 从零开发 Vue 鸿蒙harmonyOS应用 第一节_vue项目移植到鸿蒙上

- 7wireshark绿色便携版 v3.4.2.0_wiresharkportable

- 8首篇Transformer在3D点云中的应用综述(检测/跟踪/分割/降噪/补全)_transformer在点云学习领域的应用及实现

- 9[ICASSP 2024] CDNMF: 一个可信且高效的社区检测(社区发现,图聚类,Community Detection)方法

- 10利用ChatGPT撰写人工智能与劳动力相关的文献综述教程_chat gpt人工智能引用文献

通往AGI之路:揭秘英伟达A100、A800、H800、V100在高性能计算与大模型训练中的霸主地位_a800和h800对于模型训练

赞

踩

AGI | NLP | A100 | H100 | Nvidia | Aurora

GPT| LLM | A800 | V100 | Intel | ChatGPT

日前,随着深度学习、高性能计算、大模型训练等技术的保驾护航,通用人工智能时代即将到来。各个厂商也都在紧锣密鼓的布局,如英伟达前段时间发布GH 200包含 36 个 NVLink 开关,将 256 个 GH200 Grace Hopper 芯片和 144TB 的共享内存连接成一个单元。除此之外,英伟达A100、A800、H100、V100也在大模型训练中广受欢迎。AMD MI300X 其内存远超120GB的英伟达GPU芯片H100,高达192GB。

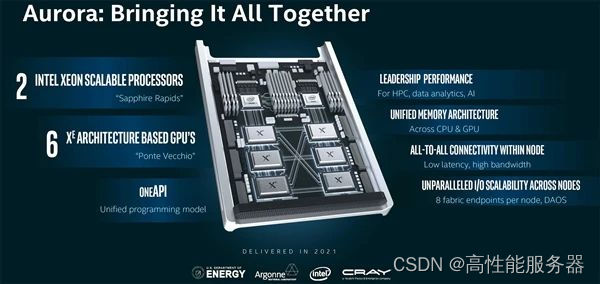

6月22日,英特尔(Intel)宣布,美国能源部阿贡国家实验室已完成新一代超级计算机"Aurora"的安装工作。这台超级计算机基于英特尔的CPU和GPU,预计在今年晚些时候上线,将提供超过2 exaflops的FP64浮点性能,超越美国能源部橡树岭国家实验室的"Frontier",有望成为全球第一台理论峰值性能超过2 exaflops的超级计算机。

Aurora超级计算机是英特尔、惠普(HPE)和美国能源部(DOE)的合作项目,旨在充分发挥高性能计算(HPC)在模拟、数据分析和人工智能(AI)领域的潜力。该系统由10624个刀片服务器组成,每个刀片由两个英特尔Xeon Max系列CPU(至强Max 9480)和六个英特尔Max系列GPU组成。

GPT-4作为一款先进的AI技术,其六项技术的引入将为人工智能领域带来巨大的突破和变革。GPU作为算力核心服务器的重要载体扮演着至关重要的角色。GPU的高效处理能力与并行计算能力,使其成为实现大型语言模型训练的优秀选择。然而,数据中心算力瓶颈成为限制其发展的主要因素之一。

在中国,各大公司也在争夺AI入场券,竞逐GPU的先机。这一竞争正迅速推动着中国在人工智能领域的发展。GPU的广泛应用将为中国企业提供更多机会,从而在AI大模型训练场上取得更加优势的地位。

本文将深入探讨GPU在AI大模型训练场上的重要性和优势,并分析当前面临的挑战和机遇。同时,将探讨如何优化GPU服务器适配,以实现大型语言模型训练的突破。在接下来的内容中,我们将探索如何解决数据中心算力瓶颈、加速AI技术的进步、优化GPU服务器的适配以及推动中国企业在AI领域的竞争力。这将引领我们进入一个全新的AI时代,为人工智能的发展开创更加广阔的前景。

GPT-4六项技术创新

一、大参数+大数据+算法创新

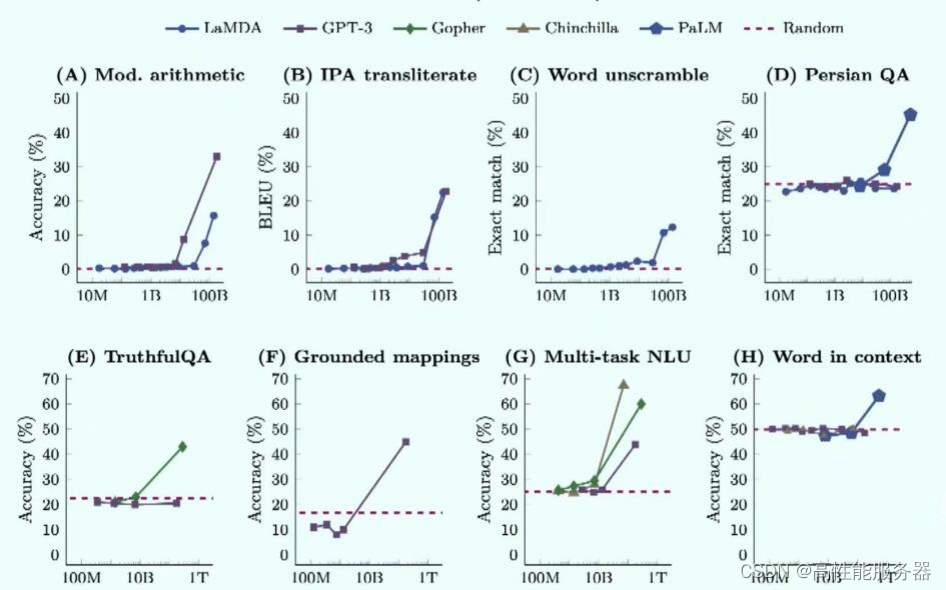

参数扩大是提升大语言模型(LLM)能力的关键因素。GPT-3首次将模型大小扩展到175B参数规模。在语言模型的早期阶段性能与模型规模大致呈线性关系,但当模型规模达到一定程度时,任务性能会出现明显的突变。大语言模型的基础具有很强的可扩展性,可以实现反复自我迭代。

参数对大模型性能起到明显作用

模型能力不仅取决于模型大小,还与数据规模和总计算量有关。此外,预训练数据质量对于实现良好性能至关重要。

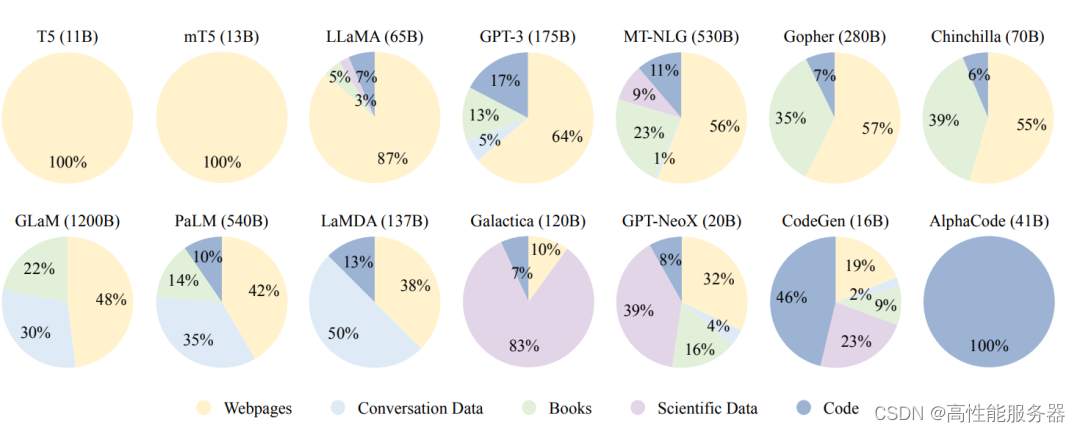

大模型主要利用各种公共文本数据集做预训练

大模型主要利用各种公共文本数据集做预训练

预训练语料库来源可以大致分为两类:通用数据和专业数据。通用数据包括网页、书籍和对话文本等,由于其规模庞大、多样化且易于获取,被广泛用于大型语言模型,可以增强语言建模和泛化能力。专业数据则包括多语言数据、科学数据和代码等,使得语言模型具备解决特定任务的能力。

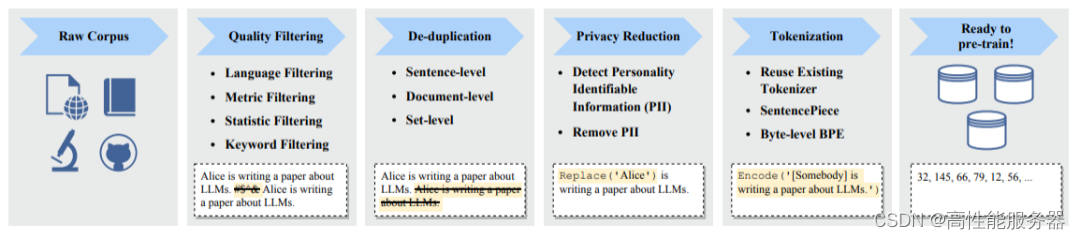

预训练大语言模型典型的数据处理过程

成功训练一个强大的大语言模型(LLM)是具有挑战性的。为了实现LLM的网络参数学习,通常需要采用多种并行策略。一些优化框架如Transformer、DeepSpeed和Megatron-LM已经发布,以促进并行算法的实现和部署。此外,优化技巧对于训练的稳定性和模型性能也至关重要。

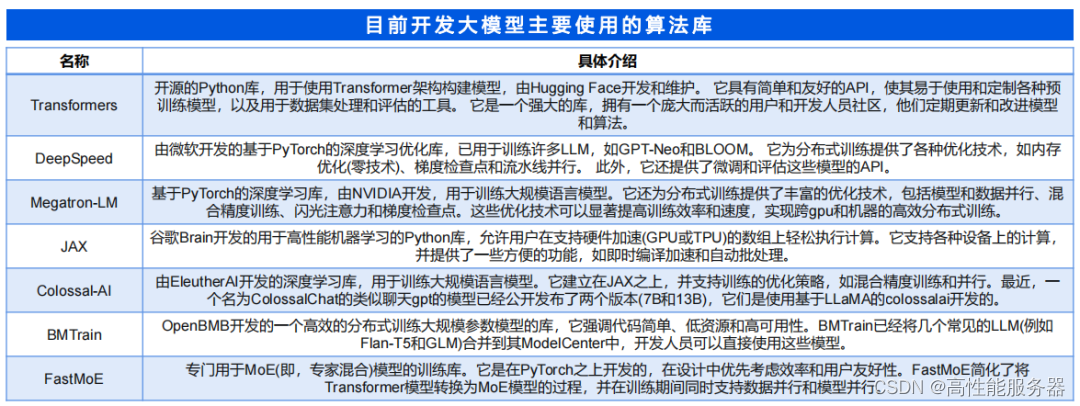

目前,常用于训练LLM的库包括Transformers、DeepSpeed、Megatron-LM、JAX、Colossal-AI、BMTrain和FastMoe等。此外,现有的深度学习框架如PyTorch、TensorFlow、MXNet、PaddlePaddle、MindSpore和OneFlow也提供对并行算法的支持。

二、Transformer

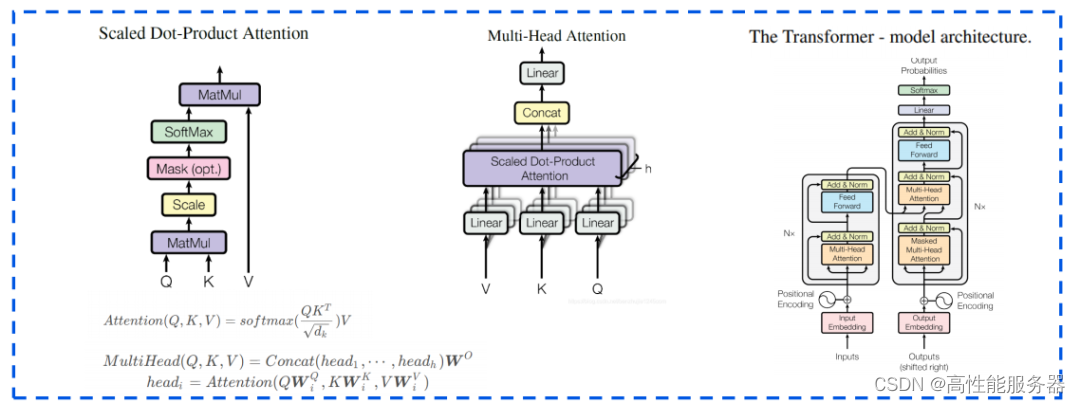

Transformer是由Google在2017年的论文《Attention is All You Need》中提出的,GPT和BERT都采用Transformer模型。Transformer基于显著性的注意力机制为输入序列中的任何位置提供上下文信息,使得它具有强大的全局表征能力、高度并行性、位置关联操作不受限,通用性强,可扩展性强等优势,从而使得GPT模型具有优异的表现。

自注意力机制(Self-Attention)允许模型在处理每个词(输入序列中的每个位置)时,不仅关注当前位置的词,还能关注句子中其他位置的词,从而更好地编码这个词。这种机制使得模型能够记住单词与哪些单词在同一句话中共同出现。Transformer模型基于自注意力机制,学习单词之间共同出现的概率。在输入语料后,Transformer可以输出单词与单词共同出现的概率,并且能够捕捉到长距离上下文中词与词之间的双向关系。

三、RLHF

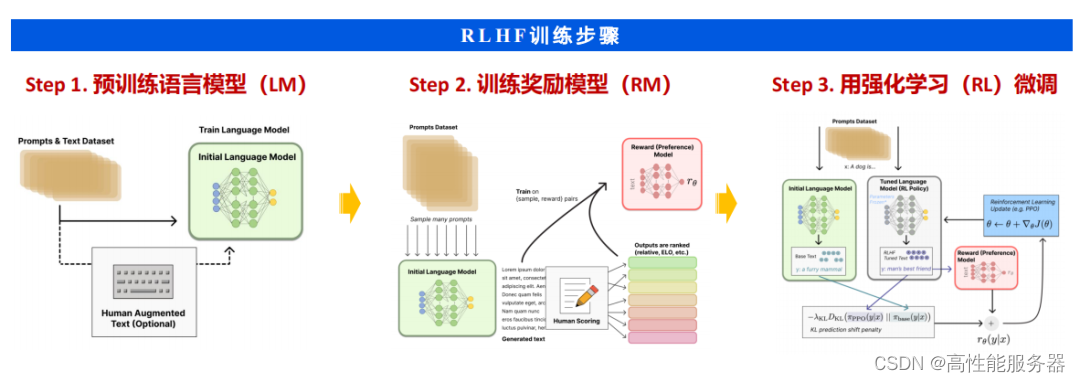

RLHF(Reinforcement Learning with Human Feedback)是ChatGPT所采用的关键技术之一。它是强化学习(RL)的一个扩展分支,将人类的反馈信息融入到训练过程中。通过利用这些反馈信息构建一个奖励模型神经网络,RLHF为RL智能体提供奖励信号,以帮助其学习。这种方法可以更加自然地将人类的需求、偏好和观念等信息以交互式的学习方式传达给智能体,以对齐人类和人工智能之间的优化目标,从而产生与人类行为方式和价值观一致的系统。

四、Prompt

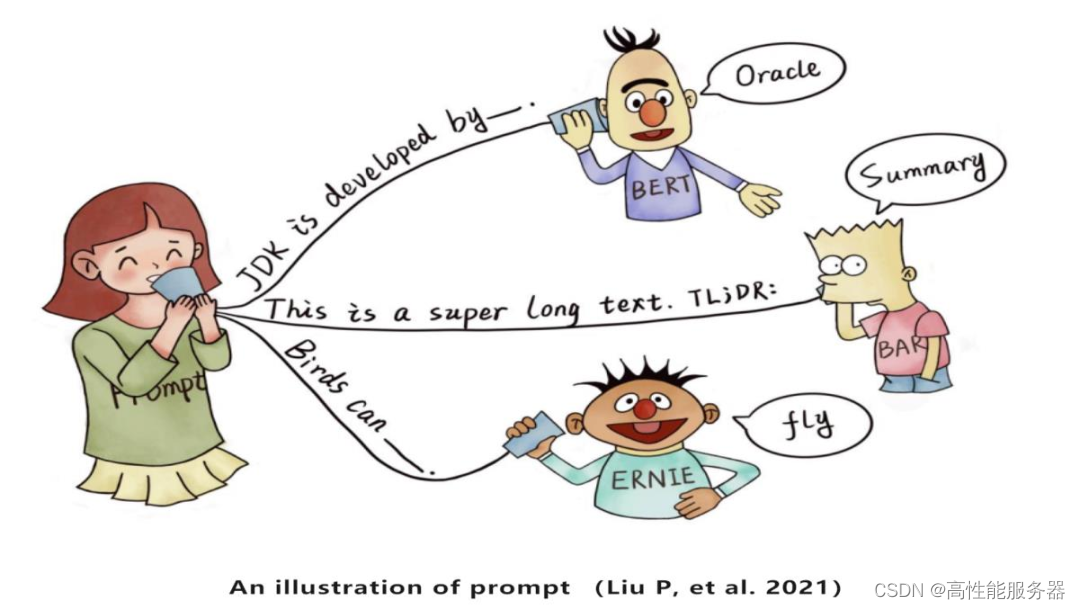

"提示"是一种给予预训练语言模型的线索,旨在帮助其更好地理解人类的问题。通过在输入中添加额外的文本(clue/prompt),可以更充分地利用预训练模型中的知识。

Prompt的案例演示

提示学习的基本流程包括四个步骤:提示构造、答案构造、答案预测和答案-标签映射。提示学习的优势主要体现在以下几个方面:1)对预训练模LM的利用率高;2)小样本场景训练效果提升;3)fine-tune成本大幅度下降等。

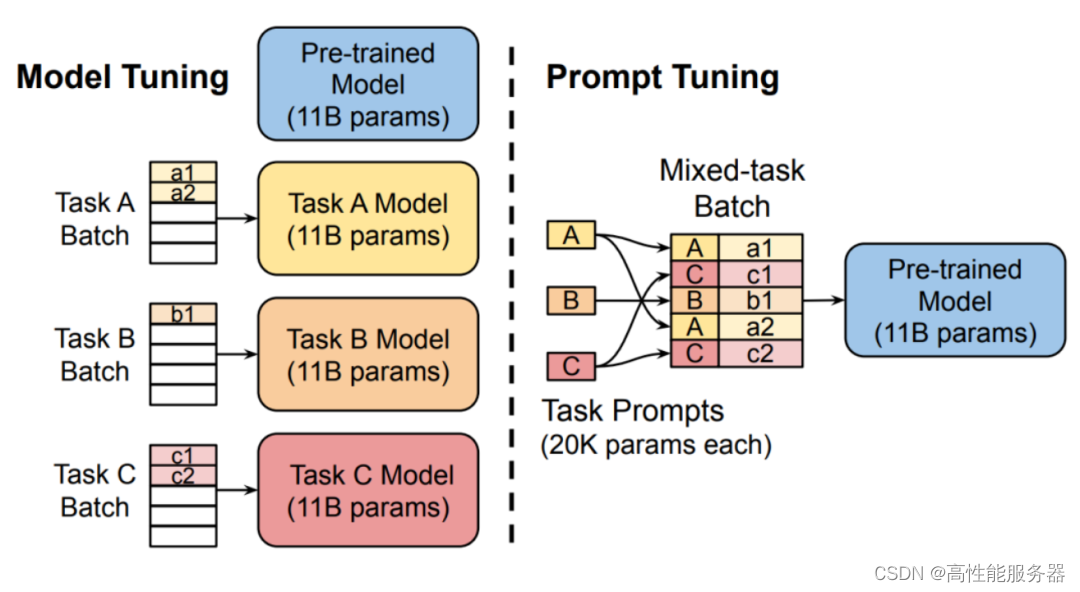

Promtptuning 与 pre-trainandfine-tune 对 比

语境学习(in-context learning, ICL)是一种特殊的提示形式,首次与GPT-3一起提出,并已成为一种典型的利用预训练语言模型的方法。在语境学习中,首先从任务描述中选择一些示例作为演示。然后,将这些示例按照特定的顺序组合起来,形成具有特殊设计模板的自然语言提示。最后,测试实例被添加到演示中,作为预训练语言模型生成输出的输入。基于这些任务演示,预训练语言模型可以在不需要显式梯度更新的情况下识别并执行新任务。

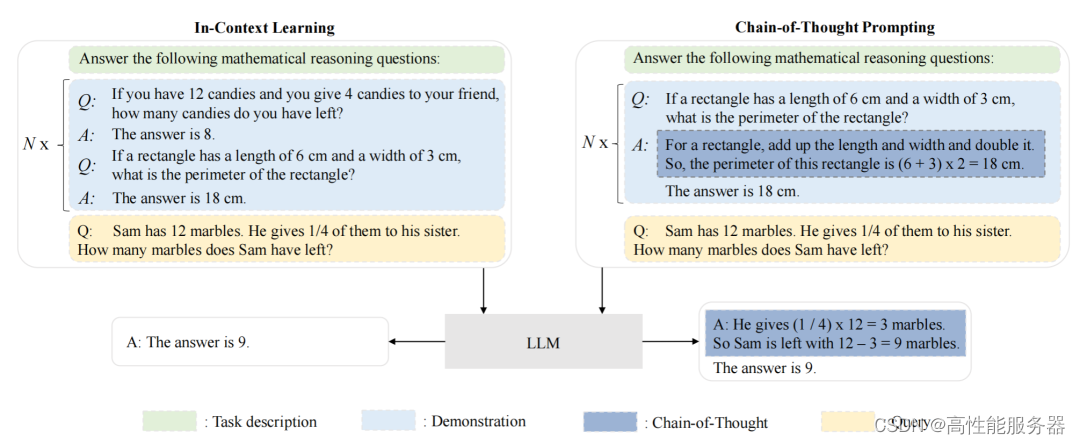

情境学习 ( ICL ) 与思维链 ( CoT ) 提示的比较研究

五、插件

由于预训练语言模型(LLM)是在大量纯文本语料库上进行训练,因此在非文本生成方面(如数值计算)的表现可能不佳。此外,LLM的能力受限于预训练数据,无法捕捉最新信息。为了解决这些问题,ChatGPT引入了外部插件机制,以帮助ChatGPT获取最新信息、进行计算或使用第三方服务,类似于LLM的"眼睛和耳朵",从而广泛扩展LLM的能力范围。

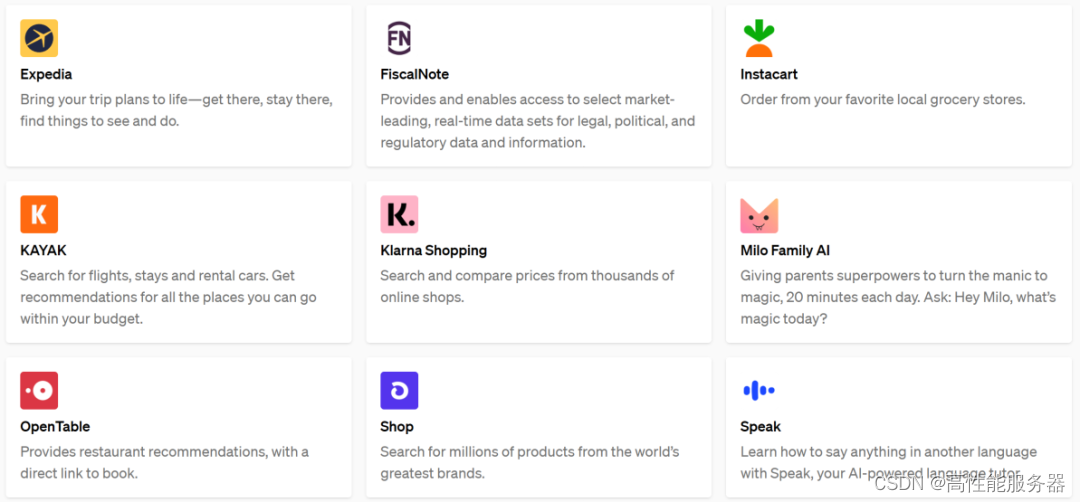

截至2023年5月,ChatGPT进行更新,包括网络浏览功能和70个测试版插件。这一更新有望彻底改变ChatGPT的使用方式,涵盖从娱乐和购物到求职和天气预报等各个领域。ChatGPT建立了一个社区,供插件开发者构建ChatGPT插件,并在语言模型显示的提示符中列出启用的插件,并提供指导文档,以指导模型如何使用每个插件。

ChatGPT插件部分展示

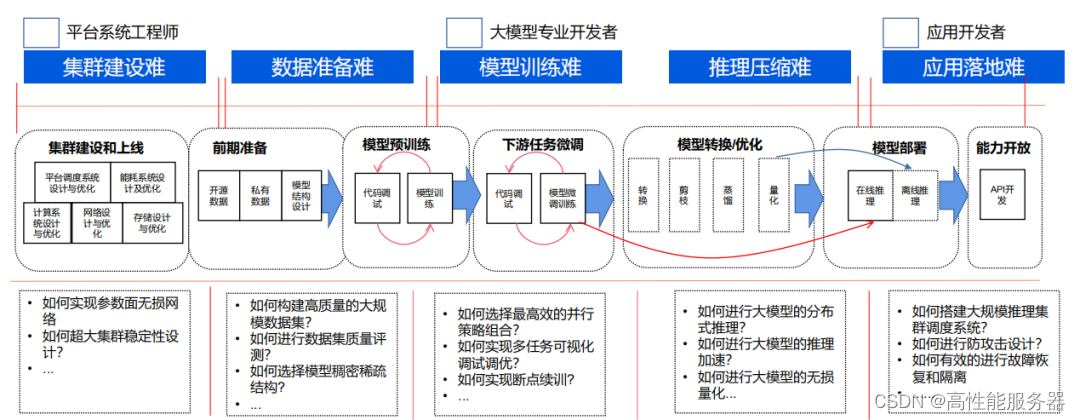

六、系统工程

OpenAI联合创始人兼首席执行官Sam Altman表示,GPT-4是迄今为止人类最复杂的软件系统。随着预训练语言模型(LLM)的发展,研发和工程之间的界限变得模糊不清。LLM的训练需要广泛的大规模数据处理和分布式并行训练经验。开发LLM的研究人员必须解决复杂的工程问题,并与工程师紧密合作或成为工程师本身。

GPU为算力核心服务器为重要载体

一、服务器:AI算力的重要载体

服务器是指具备较高计算能力的计算机,可以为多个用户提供服务。与个人电脑不同,个人电脑通常只为一个用户提供服务。服务器与主机也有所不同,主机是通过终端设备提供给用户使用,而服务器则通过网络给客户端用户提供服务。

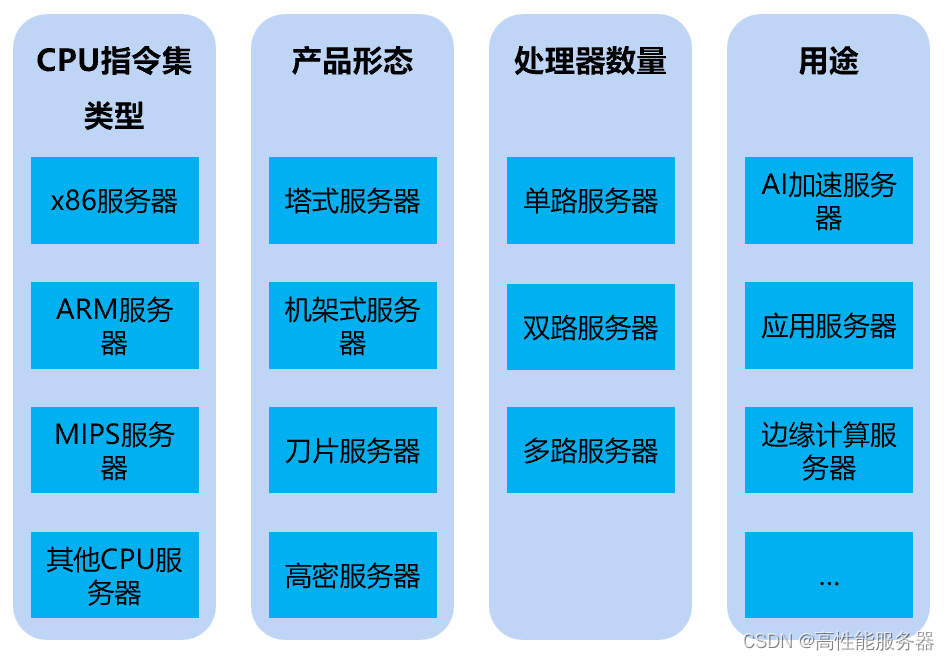

服务器的主要分类

AI服务器是专门用于进行人工智能(AI)计算的服务器。既可以支持本地应用程序和网页,也可以为云和本地服务提供复杂的AI模型和服务。其主要作用是为各种实时AI应用提供实时计算服务。根据应用场景的不同,AI服务器可以分为训练和推理两种类型。训练型服务器对芯片算力要求更高,而推理型服务器对算力的要求相对较低。

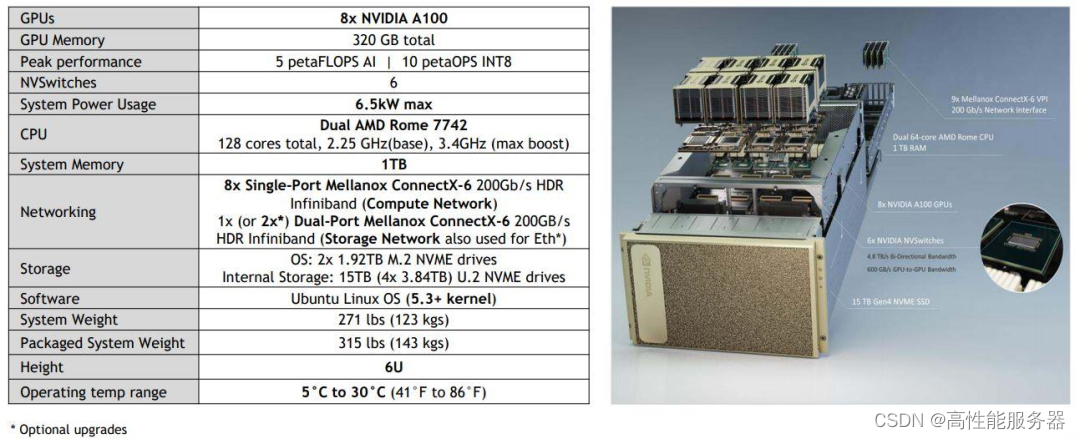

NVIDIA A100服务器

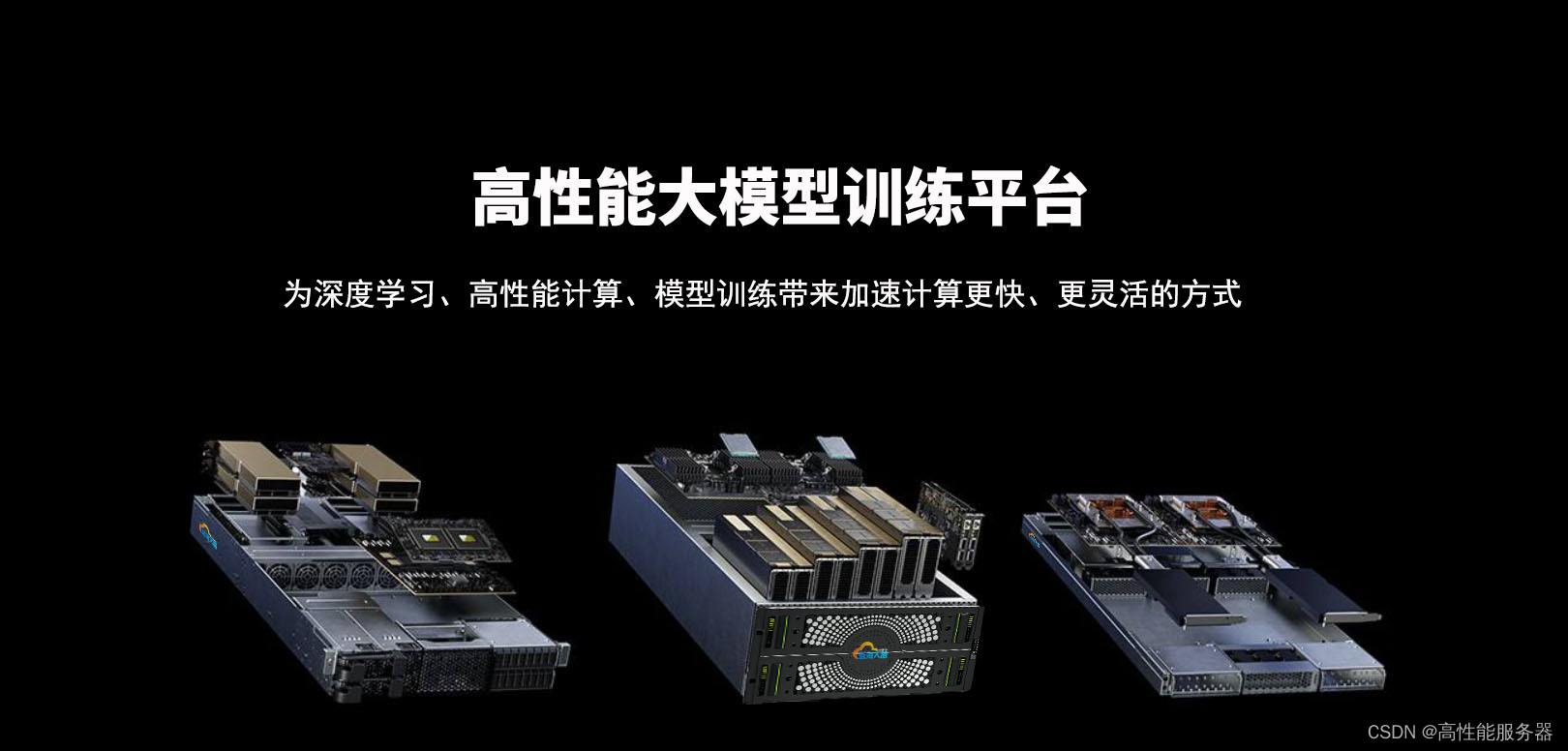

蓝海大脑高性能大模型训练平台利用工作流体作为中间热量传输的媒介,将热量由热区传递到远处再进行冷却。支持多种硬件加速器,包括CPU、GPU、FPGA和AI等,能够满足大规模数据处理和复杂计算任务的需求。采用分布式计算架构,高效地处理大规模数据和复杂计算任务,为深度学习、高性能计算、大模型训练、大型语言模型(LLM)算法的研究和开发提供强大的算力支持。具有高度的灵活性和可扩展性,能够根据不同的应用场景和需求进行定制化配置。可以快速部署和管理各种计算任务,提高了计算资源的利用率和效率。

1、全球服务器市场

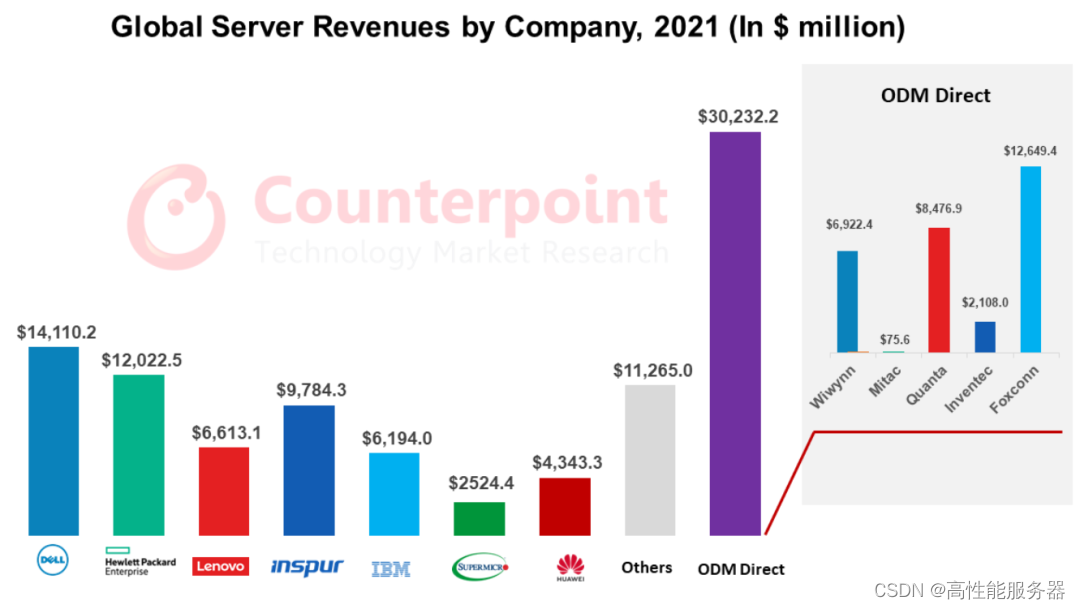

根据Counterpoint的报告,预计到2022年,全球服务器市场的收入将同比增长17%,达到1117亿美元。在该市场中,主要的服务器公司包括戴尔、惠普、联想、浪潮和超微以及ODM厂商如富士康、广达、纬创和英业达。ODM Direct的增长速度比整体市场高出3个百分点,因此ODM Direct将成为大规模数据中心部署的硬件选择。根据IDC的数据预测,2022年市场规模约为183亿美元,而2023年市场规模将达到211亿美元。在市场份额方面,浪潮信息占据了20.2%的份额,其次是戴尔、HPE、联想和华为,它们的市场份额分别为13.8%、9.8%、6.1%和4.8%。

2021年全球各服务器公司收入(单位:百万美元)

2、中国服务器市场

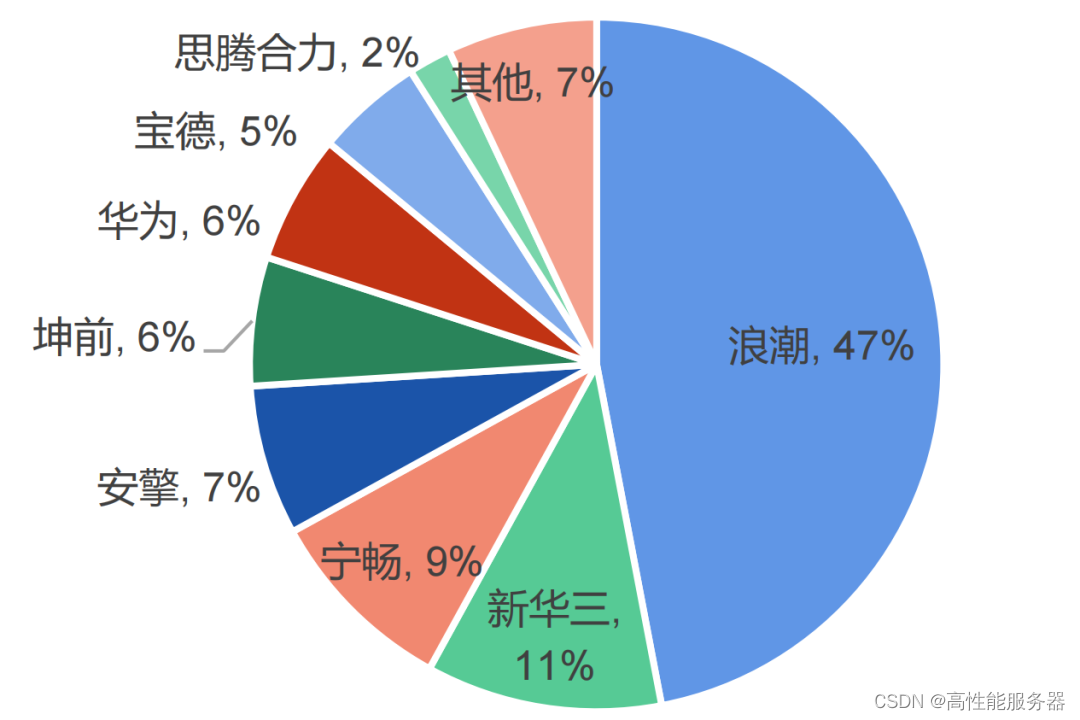

据数据显示,2022年中国服务器市场规模达到273.4亿美元。在这个市场中,浪潮以28.1%的市场份额位居第一,收入达到530.63亿美元。根据IDC的数据,2022年中国加速服务器市场规模达到67亿美元,同比增长24%。浪潮、新华三和宁畅是市场中的前三名,它们占据了市场份额的60%以上。互联网行业仍然是采购加速服务器的最大行业,占据了整体市场接近一半的份额。

2022年中国AI服务器市场份额

二、GPU:AI算力的核心

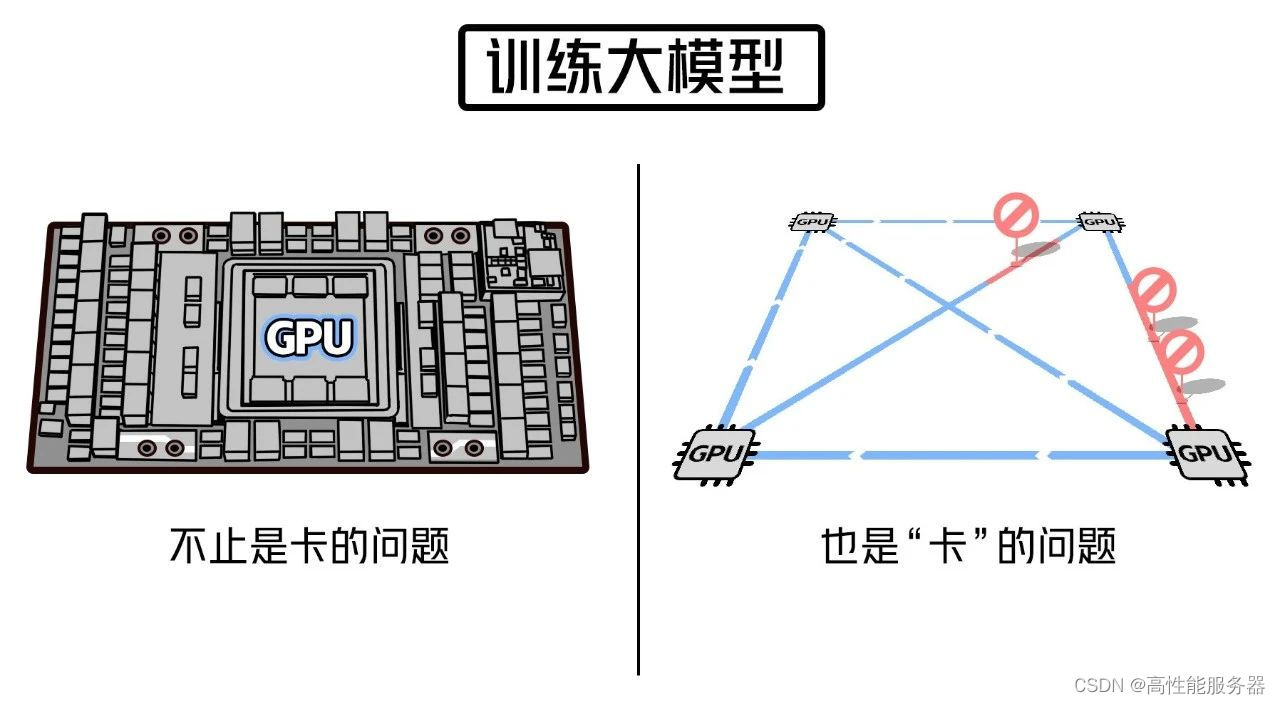

在训练大型模型时,超大规模的计算能力是必不可少的,而GPU是其中的核心。没有GPU卡,训练大型模型几乎是不可能的。

AI芯片是算力的核心也被称为AI加速器或计算卡,专门用于处理人工智能应用中的大量计算任务(而其他非计算任务则由CPU负责)。随着数据量的急剧增长、算法模型的复杂化以及处理对象的异构性,对计算性能的要求也越来越高。

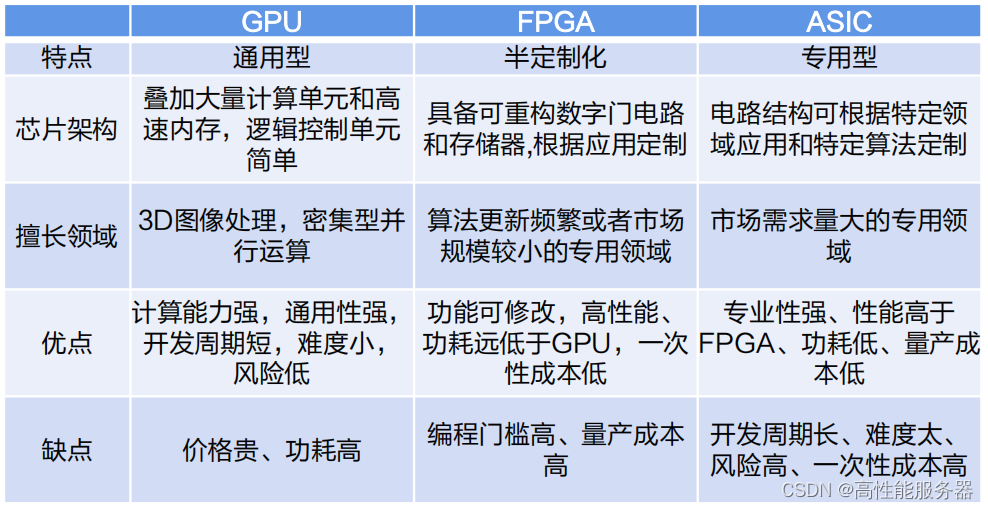

据数据显示,2022年我国的AI服务器中,GPU服务器占据89%的份额。目前,GPU是最广泛应用的AI芯片之一。除了GPU,AI芯片还包括现场可编程门阵列(FPGA)、专用集成电路(ASIC)和神经拟态芯片(NPU)等。GPU是一种通用型芯片,而ASIC是一种专用型芯片,而FPGA则处于两者之间,具有半定制化的特点。

不同AI芯片之间对比

图形处理器(GPU)是一种专门用于执行绘图运算的微处理器,也被称为显示核心、视觉处理器、显示芯片或图形芯片。它拥有数百或数千个内核,并经过优化,能够并行执行大量计算任务。尽管GPU在游戏中以3D渲染而闻名,但它们在运行分析、深度学习和机器学习算法方面尤为有用。相比传统的CPU,GPU可以使某些计算速度提高10倍至100倍。GPGPU是一种将GPU的图形处理能力应用于通用计算领域的处理器。

英伟达数据中心GPU类别

在2023年,英伟达的全球收入达到269.7亿美元。其中,图形业务部门的收入约为119亿美元,而计算与网络部门的收入为151亿美元。在2023年第一季度(Q1 FY24),英伟达的数据中心业务营收达到42.8亿美元,创下历史新高,同比增长14%,环比增长18%。

三、英伟达大模型训练GPU全系列介绍

自OpenAI发布ChatGPT以来,生成式人工智能技术一直是备受关注的热门趋势。这项技术需要强大的算力来生成文本、图像、视频等内容。在这个背景下,算力成为人工智能领域的必备条件,而英伟达作为芯片巨头所生产的人工智能芯片在其中扮演着至关重要的角色。英伟达先后推出V100、A100和H100等多款用于AI训练的芯片,并为了符合美国标准,推出了A800和H800这两款带宽缩减版产品,在中国大陆市场销售。

V100是英伟达公司推出的高性能计算和人工智能加速器,属于Volta架构系列。它采用16nm FinFET工艺,拥有5120个CUDA核心和16GB到32GB的HBM2显存。V100还配备Tensor Cores加速器,可提供高达120倍的深度学习性能提升。此外,V100支持NVLink技术,实现高速的GPU到GPU通信,加速大规模模型的训练速度。V100被广泛应用于各种大规模AI训练和推理场景,包括自然语言处理、计算机视觉和语音识别等领域。

A100是英伟达推出的一款强大的数据中心GPU,采用全新的Ampere架构。它拥有高达6,912个CUDA核心和40GB的高速HBM2显存。A100还包括第二代NVLink技术,实现快速的GPU到GPU通信,提升大型模型的训练速度。此外,A100还支持英伟达自主研发的Tensor Cores加速器,可提供高达20倍的深度学习性能提升。A100广泛应用于各种大规模AI训练和推理场景,包括自然语言处理、计算机视觉和语音识别等领域。

在大模型训练中,V100和A100都是非常强大的GPU。以下是它们的主要区别和优势:

1、架构

V100和A100在架构上有所不同。V100采用Volta架构,而A100则采用全新的Ampere架构。Ampere架构相对于Volta架构进行一些改进,包括更好的能源效率和全新的Tensor Core加速器设计等,这使得A100在某些场景下可能表现出更出色的性能。

2、计算能力

A100配备高达6,912个CUDA核心,比V100的5120个CUDA核心更多。这意味着A100可以提供更高的每秒浮点运算数(FLOPS)和更大的吞吐量,从而在处理大型模型和数据集时提供更快的训练速度。

3、存储带宽

V100的内存带宽约为900 GB/s,而A100的内存带宽达到了更高的1555 GB/s。高速内存带宽可以降低数据传输瓶颈,提高训练效率,因此A100在处理大型数据集时可能表现更出色。

4、存储容量

V100最高可拥有32GB的HBM2显存,而A100最高可拥有80GB的HBM2显存。由于大模型通常需要更多内存来存储参数和梯度,A100的更大内存容量可以提供更好的性能。

5、通信性能

A100支持第三代NVLink技术,实现高速的GPU到GPU通信,加快大模型训练的速度。此外,A100还引入Multi-Instance GPU (MIG)功能,可以将单个GPU划分为多个相互独立的实例,进一步提高资源利用率和性能。

总的来说,A100在处理大型模型和数据集时可能比V100表现更优秀,但是在实际应用中,需要结合具体场景和需求来选择合适的GPU。

数据中心算力瓶颈光模块需求放量

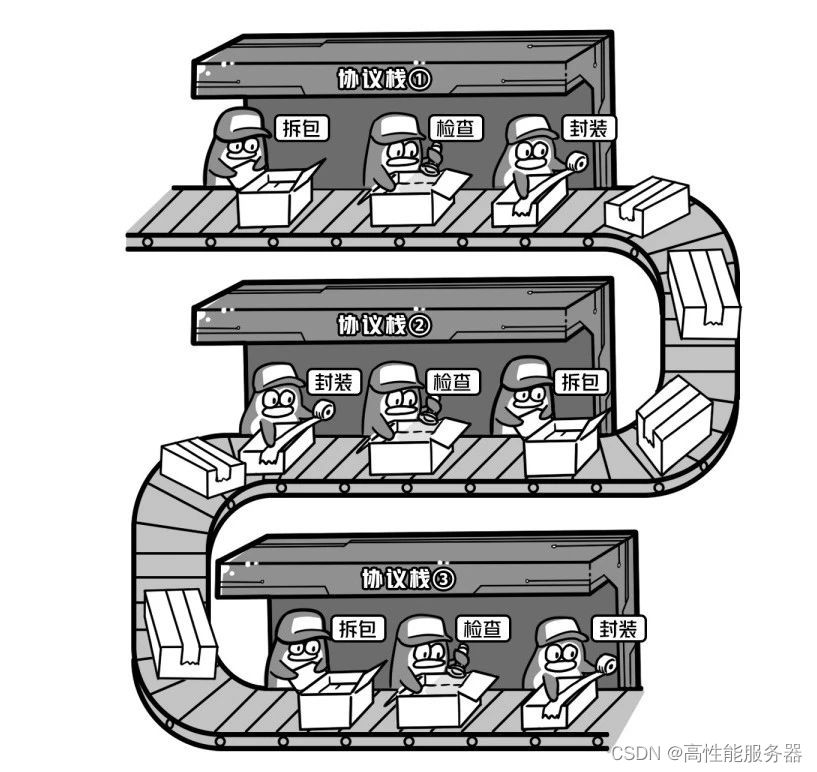

即使单卡的性能再强大,如果网络性能无法跟上,也只能无奈地等待。而且,随着集群规模的扩大,网络带来的算力损耗也会变得更加明显。传统的网络架构在传输数据时需要经过多层协议栈的处理:需要反复停下来检查、分拣和打包数据,这使得通信效率非常低下。

一、英伟达布局InfiniBand

数据通信设备是指能够实现IP网络接入终端、局域网、广域网间连接、数据交换以及提供相关安全防护功能的通信设备,包括交换机、路由器和WLAN等。交换机和路由器是其中最重要的设备。这些网络设备构成了互联网基础的物理设施层,是信息化建设所必需的基础架构产品。

网络设备制造服务行业的上游主要包括芯片、PCB、电源和各类电子元器件等生产商。直接下游是各网络设备品牌商。而终端下游涵盖了运营商、政府、金融、教育、能源、电力、交通、中小企业、医院等各个行业。

2017-2024年中国网络设备市场规模统计(亿美元)

在网络设备行业中,竞争格局呈现出高度集中的情况。思科、华为、新华三等少数几家企业占据绝大部分的市场份额,形成寡头竞争的市场格局。随着人工智能和高性能计算需求的不断增长,对多节点、多GPU系统的高速通信需求也日益提升。为构建强大、能够满足业务速度要求的端到端计算平台,快速且可扩展的互连网络变得至关重要。

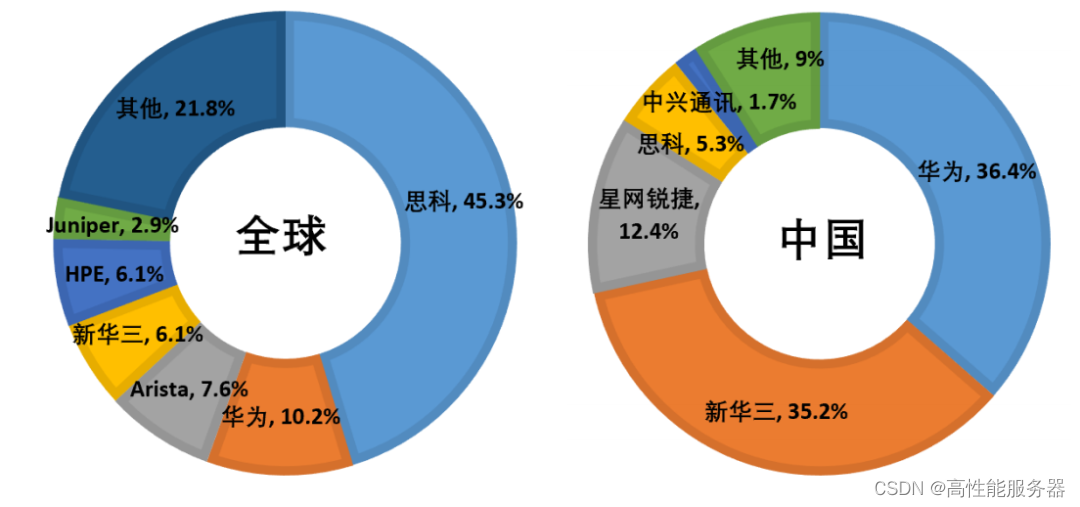

2021年全球及中国交换机行业市场份额情况

在人工智能领域中,通信已经成为算力的瓶颈。尽管AI加速器可以通过简化或删除其他部分来提高硬件的峰值计算能力,但却难以解决内存和通信方面的难题。不论是芯片内部、芯片间还是AI加速器之间的通信,都已经成为AI训练过程中的限制因素。

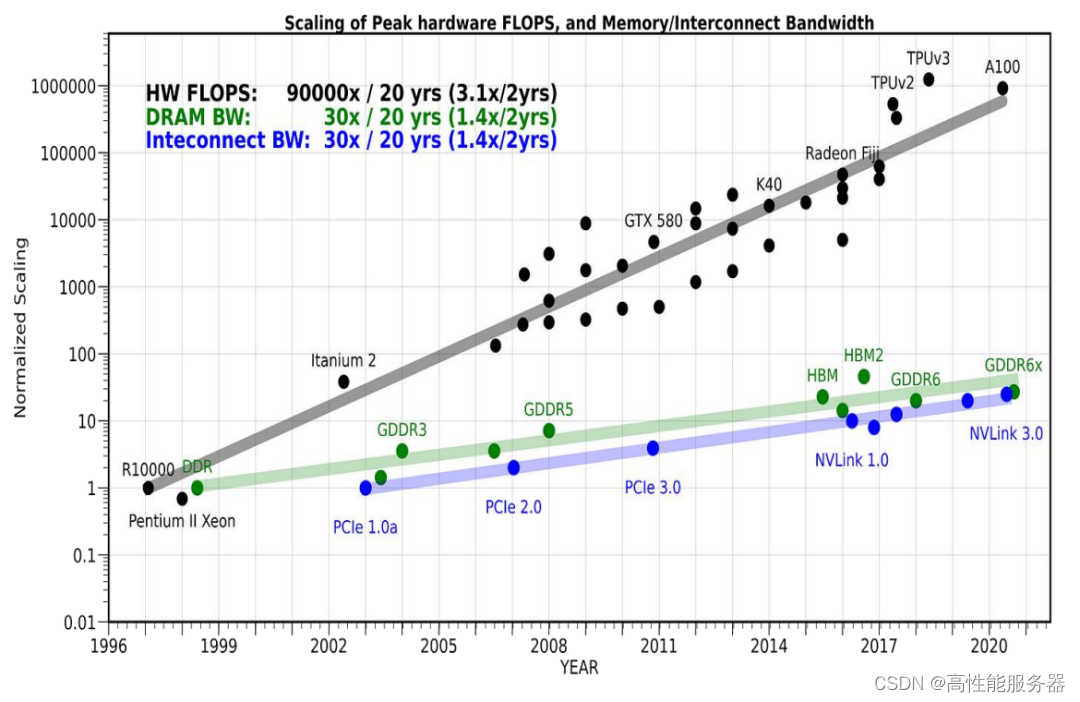

在过去的20年中,计算设备的算力提高了90,000倍,存储器从DDR发展到GDDR6x,接口标准从PCIe1.0a升级到NVLink3.0。然而,与此相比,通信带宽的增长只有30倍。

通信带宽的提升速度远低于计算提升的速度

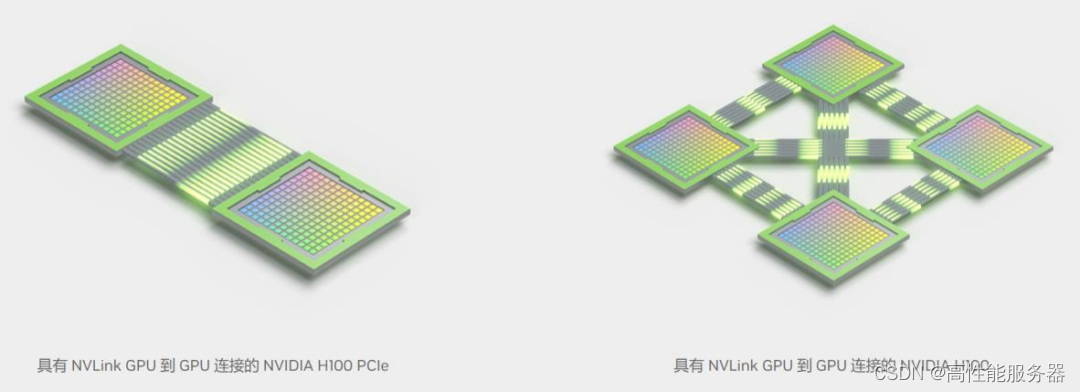

NVLink是NVIDIA开发的一种高带宽、高能效、低延迟、无损的GPU到GPU互连技术。它具备弹性特性,包括链路级错误检测和数据包回放机制,确保数据的可靠传输。

与上一代相比,第四代NVLink可将全局操作的带宽提升3倍,并提高通用带宽50%。单个NVIDIA H100 Tensor Core GPU最多支持18个NVLink连接,多GPU之间的总带宽可达900GB/s,是PCIe 5.0的7倍。

NVLink 链接图

NVSwitch是英伟达开发的一种技术,包括位于节点内部和外部的交换机,用于连接多个GPU在服务器、集群和数据中心环境中的使用。每个节点内的NVSwitch具有64个第四代NVLink链路端口,可以加速多个GPU之间的连接。新一代的NVSwitch技术将交换机的总吞吐量从上一代的7.2Tb/s提升到13.6Tb/s。

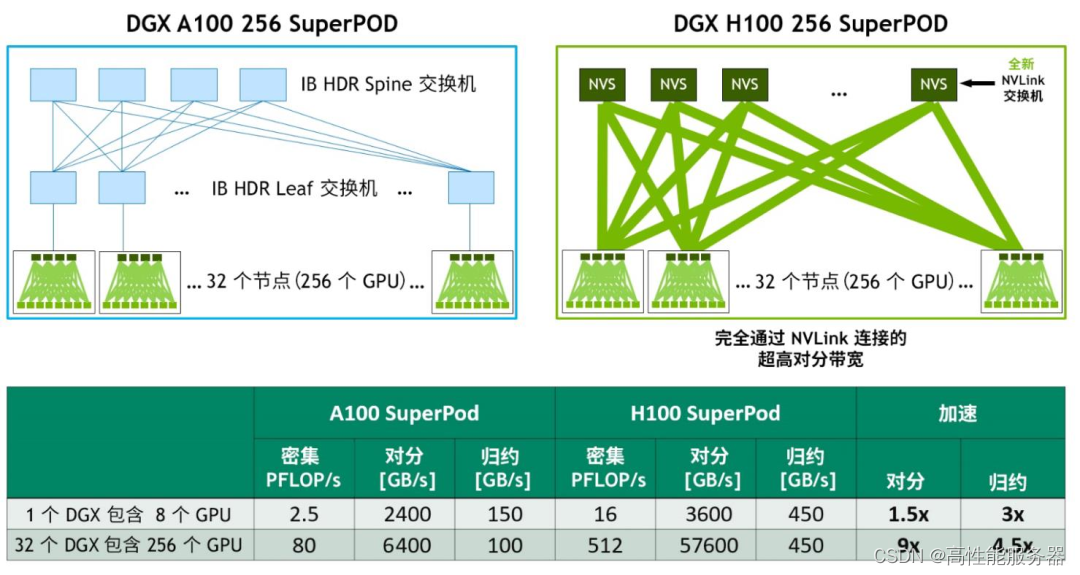

英伟达结合全新的NVLink和NVSwitch技术,构建了大型的NVLink Switch系统网络,实现了前所未有的通信带宽水平。该系统最多支持256个GPU,并且互连节点能够提供57.6TB的多对多带宽,为高达1 exaFLOP级别的FP8稀疏计算提供了强大的计算能力。

基于 DGX A100 与 DGX H100 的 32 节点、256 GPU NVIDIA SuperPOD对比

InfiniBand是一种用于高性能计算的计算机网络通信标准,具有高带宽和低延迟的特点。主要应用于高性能计算、高性能集群应用服务器和高性能存储等领域。为了加强在InfiniBand领域的投入,英伟达在2019年以69亿美元收购了Mellanox。这一新架构为AI开发者和科学研究人员提供了超强的网络性能和丰富的功能。通过这一技术,用户可以获得更快速、更可靠的网络连接,以支持他们在人工智能领域的工作和研究。

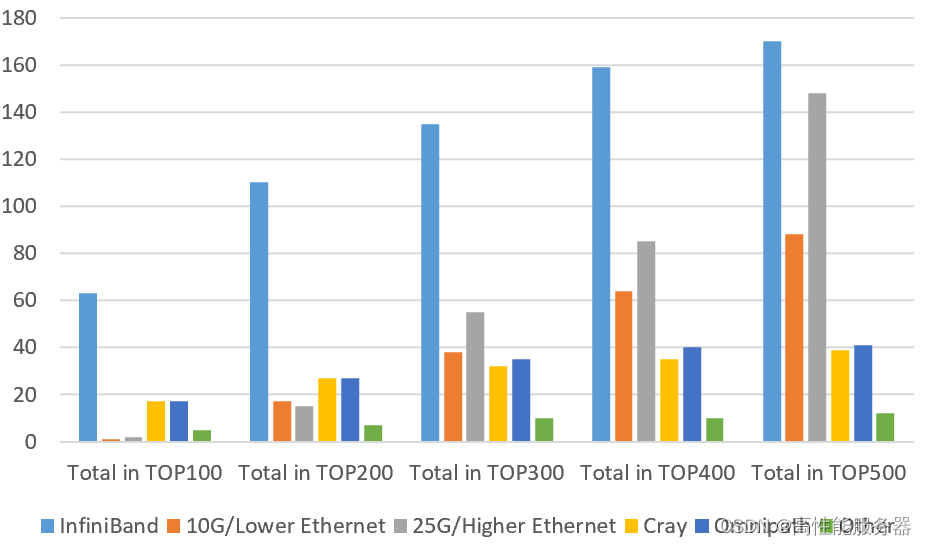

InfiniBand广泛应用于全球超算中心

二、光模块:网络核心器件,AI训练提振800G需求

预计英伟达的H100 GPU与800G光模块在计算力网络中的比例将根据不同层级而有所不同。在服务器层,预计GPU与800G光模块的比例将为1:1;在交换机层,预计该比例将为1:2。考虑到核心层交换机、管理网络、存储网络等因素,以及安装率的相关考虑,整体而言,预计英伟达H100 GPU与800G光模块的比例将大约在1:2至1:4之间。这种配置将确保在计算力网络中实现高效的通信和数据传输。

DGX H100 数据网络配置图

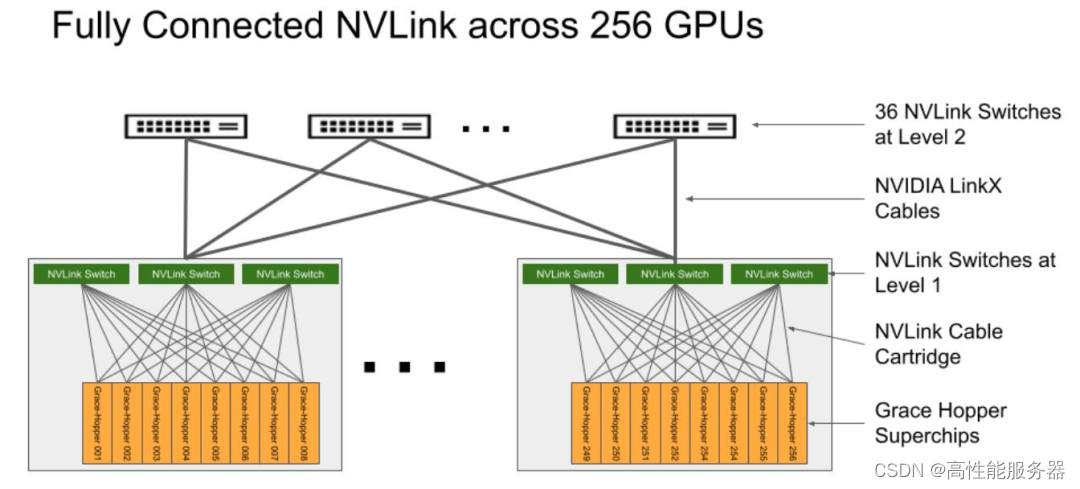

2023年5月,英伟达推出DGX GH200,GH200是将 256 个NVIDIA Grace Hopper超级芯片完全连接,旨在处理用于大 规模推荐系统、生成式人工智能和图形分析的太字节级模型。NVLink交换系统采用两级、无阻塞、胖树结构。如下图:L1和L2层分为96和32台交换机,承载Grace Hopper超级芯片 的计算底板使用NVLink fabric第一层的定制线缆连接到NVLink交换机系统。LinkX电缆扩展了NVLink fabric的第二层连 接。我们预计GH200的推出将进一步促进800G光模块的需求增长。

DGX GH200通过NVLink将256个GPU完全联接

争夺AI入场券

中国大公司竞逐GPU

全球范围内,英伟达GPU的竞争非常激烈。然而,海外巨头在GPU采购方面比较早,并且采购量更大,近年来的投资也相对连续。中国的大型公司对于GPU的需求和投资动作比海外巨头更为急迫。以百度为例,今年向英伟达下单的GPU订单数量高达上万块。尽管百度的规模要小得多,去年的营收仅为1236亿元人民币,相当于Google的6%。然而,这显示出中国大公司在GPU领域的迅速发展和巨大需求。

据了解,字节、腾讯、阿里和百度是中国投入最多的AI和云计算科技公司。在过去,它们累计拥有上万块A100 GPU。其中,字节拥有的A100数量最多。不计算今年的新增订单,字节拥有接近10万块A100和前代产品V100。成长期的公司商汤也宣称,其“AI大装置”计算集群中已经部署了2.7万块GPU,其中包括1万块A100。即使是看似与AI无关的量化投资公司幻方,也购买1万块A100。

从总数来看,这些GPU似乎足够供各公司训练大型模型使用。根据英伟达官方网站的案例,OpenAI在训练具有1750亿参数的GPT-3时使用了1万块V100,但训练时间未公开。根据英伟达的估算,如果使用A100来训练GPT-3,需要1024块A100进行一个月的训练,而A100相比V100性能提升4.3倍。

中国的大型公司过去采购的大量GPU主要用于支撑现有业务或在云计算平台上销售,不能自由地用于开发大模型或满足客户对大模型的需求。这也解释了中国AI从业者对计算资源估算存在巨大差异。清华智能产业研究院院长张亚勤在4月底参加清华论坛时表示:“如果将中国的算力加起来,相当于50万块A100,可以轻松训练五个模型。”

AI公司旷视科技的CEO印奇在接受《财新》采访时表示,中国目前可用于大型模型训练的A100总数只有约4万块。这反映了中国和外国大型公司在计算资源方面的数量级差距,包括芯片、服务器和数据中心等固定资产投资。最早开始测试ChatGPT类产品的百度,在过去几年的年度资本开支在8亿到20亿美元之间,阿里在60亿到80亿美元之间,腾讯在70亿到110亿美元之间。

与此同时,亚马逊、Meta、Google和微软这四家美国科技公司的自建数据中心的年度资本开支最低也超过150亿美元。在过去三年的疫情期间,海外公司的资本开支持续增长。亚马逊去年的资本开支已达到580亿美元,Meta和Google分别为314亿美元,微软接近240亿美元。而中国公司的投资在2021年后开始收缩。腾讯和百度去年的资本开支同比下降超过25%。

中国公司若想长期投入大模型并赚取更多利润,需要持续增加GPU资源。就像OpenAI一样,他们面临着GPU不足的挑战。OpenAI的CEO Sam Altman在与开发者交流时表示,由于GPU不够,他们的API服务不够稳定,速度也不够快。

在获得更多GPU之前,GPT-4的多模态能力无法满足每个用户的需求。同样,微软也面临类似的问题。微软与OpenAI合作密切,他们的新版Bing回答速度变慢,原因是GPU供应跟不上用户增长的速度。

微软Office 365 Copilot嵌入了大型模型的能力,目前还没有大规模开放,只有600多家企业在试用。考虑到全球近3亿的Office 365用户数量,中国大公司如果想利用大型模型创造更多服务,并支持其他客户在云上进行更多大型模型的训练,就需要提前储备更多的GPU资源。

AI大模型训练常用显卡

目前,在AI大型模型训练方面,A100、H100以及其特供中国市场的减配版A800、H800几乎没有替代品。根据量化对冲基金Khaveen Investments的测算,到2022年,英伟达在数据中心GPU市场的占有率将达到88%,而AMD和英特尔将瓜分剩下的市场份额。

英伟达GPU目前的不可替代性源于大模型的训练机制,其中关键步骤包括预训练和微调。预训练是为模型打下基础,相当于接受通识教育直至大学毕业;微调则是为了优化模型以适应具体场景和任务,提升其工作表现。

预训练阶段特别需要大量计算资源,对单个GPU的性能和多卡之间的数据传输能力有非常高的要求。目前只有A100和H100能够提供预训练所需的高效计算能力,尽管价格昂贵,但实际上是最经济的选择。在AI商业应用仍处于早期阶段,成本直接影响着服务的可用性。

过去的一些模型,如VGG16可以识别猫是猫,其参数量仅为1.3亿,当时一些公司会使用消费级显卡(如RTX系列)来运行AI模型。然而,随着GPT-3等大型模型的发布,参数规模已经达到1750亿。由于大型模型需要巨大的计算资源,使用更多低性能的GPU来组合计算力已经不再可行。

在使用多个GPU进行训练时,需要在芯片之间传输数据并同步参数信息,这导致部分GPU处于闲置状态,无法充分发挥工作能力。因此,使用性能较低的GPU越多,计算力的损耗就越大。OpenAI在使用1万块V100 GPU进行GPT-3训练时,算力利用率不到50%。而A100和H100既具有单卡高算力,又具备提升卡间数据传输的高带宽能力。A100的FP32算力达到19.5 TFLOPS(1 TFLOPS相当于每秒进行一万亿次浮点运算),而H100的FP32算力更高,达到134 TFLOPS,是竞争对手AMD MI250的约4倍。

A100、H100 还提供高效数据传输能力,尽可能减少算力闲置。英伟达的独家秘籍是自 2014 年起陆续推出的 NVLink、NVSwitch 等通信协议技术。用在 H100 上的第四代 NVLink 可将同一服务器内的 GPU 双向通信带宽提升至 900 GB/s(每秒传输 900GB 数据),是最新一代 PCle(一种点对点高速串行传输标准)的 7 倍多。

去年美国商务部对GPU的出口规定主要限制了算力和带宽两个方面:算力上限为4800 TOPS,带宽上限为600 GB/s。A800和H800的算力与原版相当,但带宽有所降低。

A800的带宽从A100的600GB/s降至400GB/s,H800的具体参数尚未公开,据报道,它的带宽仅为H100(900 GB/s)的约一半。执行相同的AI任务时,H800可能比H100多花费10%至30%的时间。一位AI工程师推测,H800的训练效果可能不如A100,但价格更高。

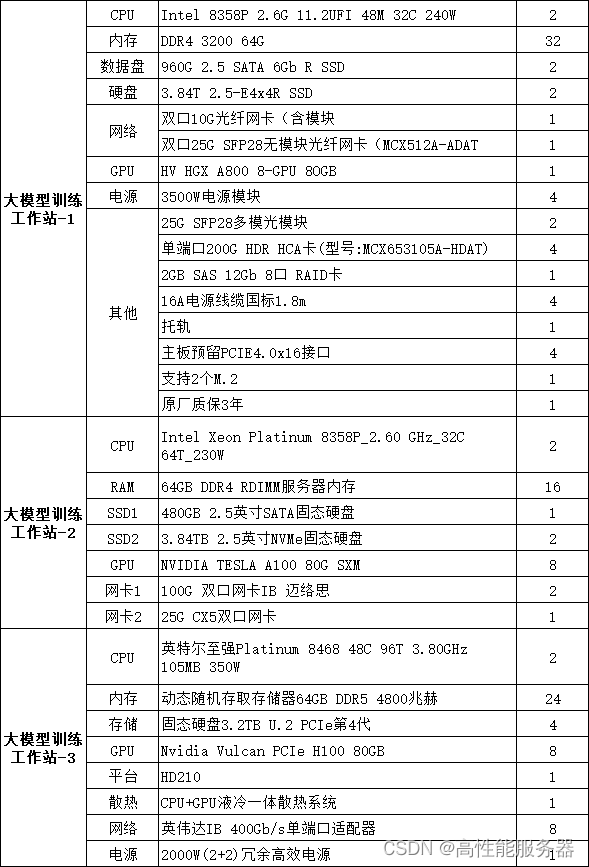

大模型训练工作站常用配置

尽管如此,A800和H800的性能仍然超过其他大公司和创业公司的同类产品。受限于性能和更专用的架构,各公司推出的AI芯片或GPU芯片主要用于AI推理,难以胜任大型模型的预训练任务。简而言之,AI训练是创建模型,而AI推理是使用模型,因此训练对芯片性能的要求更高。

除了性能差距外,NVIDIA的更大竞争优势在于其软件生态系统。早在2006年,NVIDIA推出了计算平台CUDA,它是一个并行计算软件引擎,开发者可以使用CUDA更高效地进行AI训练和推理,充分发挥GPU的计算能力。如今,CUDA已成为AI基础设施的标准,主流的AI框架、库和工具都是基于CUDA进行开发的。

而其他GPU和AI芯片如果要接入CUDA,就需要自己提供适配软件,但它们只能获得部分CUDA的性能,并且更新迭代的速度较慢。一些AI框架如PyTorch正在尝试打破CUDA的软件生态垄断,提供更多的软件功能以支持其他厂商的GPU,但对开发者的吸引力有限。一位AI从业者提到,他所在的公司曾考虑使用一家非NVIDIA的GPU厂商,对方的芯片和服务报价更低,也承诺提供更及时的支持,但他们最终判断,使用其他GPU会导致整体训练和开发成本高于使用NVIDIA,并且还需要承担结果的不确定性和花费更多的时间。“虽然A100的价格高,但实际使用起来是最经济的。”他说道。

对于那些有意抓住大型模型机会的大型科技公司和领先的创业公司来说,金钱通常不是问题,时间才是最宝贵的资源。在短期内,唯一可能影响NVIDIA数据中心GPU销量的因素可能只有台积电的产能。

H100/800和A100/800芯片都采用了台积电的4纳米和7纳米制程。根据台湾媒体报道,今年英伟达向台积电增加了1万片数据中心GPU订单,并且下达了超急件,生产时间可以缩短最多50%。通常情况下,台积电生产A100芯片需要数月时间。目前的生产瓶颈主要在于先进封装的产能不足,缺口达到了10%至20%,需要逐步提升产能,可能需要3至6个月的时间。

自从并行计算适用的GPU被引入深度学习领域以来,硬件和软件一直是推动AI发展的动力。GPU的计算能力与模型和算法的发展相互促进:模型的发展推动了对计算能力的需求增长,而计算能力的增长则使得原本难以实现的大规模训练成为可能。在以图像识别为代表的上一波深度学习热潮中,中国的AI软件能力已经与全球最前沿水平不相上下;而目前的难点在于计算能力——设计和制造芯片需要积累更长的时间,涉及到复杂的供应链和众多的专利壁垒。