- 1鸿蒙应用开发 闹钟实现_鸿蒙开发实现倒计时

- 2yum安装python3_centos 安装python3详细指南

- 3CSS 详解grid布局(网格布局)与应用

- 4吴恩达机器学习-可选实验室:简单神经网络(Simple Neural Network)

- 5Android N Audio: Audio Track play_audio_port_type_t

- 6AI帮忙做论文笔记——高端Prompt技巧——chatGPT时代背景下文献阅读新范式_阅读论文的prompt

- 7平时多看看---前端中小厂一二线城市薪资水平报告_中厂初级前端月薪多少

- 8H3C-Cloud Lab实验-静态路由配置实验_h3c cloud lab

- 9php添加图片水印类,PHP图片水印类的封装

- 10ft232 mac usb串口驱动_【电路“芯”说】聊聊你知道的串口

小红书の4篇论文_小红书论文好看的红绿蓝

赞

踩

ICCV 正式揭晓 2023 年论文接收结果,小红书技术团队共有 4 篇论文入选,其中 1 篇为 Oral 论文(Oral 接收率仅为 1.88%),最新科研成果涵盖了视频目标分割、3D 数字人重建、人体运动预测、视频分析等领域。

国际计算机视觉大会 ICCV 由 IEEE 主办,被誉为“计算机视觉三大顶级会议”之一,每两年召开一次,其论文集代表了计算机视觉领域最新的发展方向和研究水平。ICCV 2023 将于今年 10 月在法国巴黎举行,本届会议共收到全球 8068 篇论文投稿,2161 篇被接收,接收率为 26.78%。

以下为入选论文亮点解读,欢迎大家关注:

01Towards Open-Vocabulary Video Instance Segmentation (Oral)

面向开放任务的视频实例分割( Oral )

论文作者:王昊臣(小红书实习生&阿姆斯特丹大学)、莱戈(小红书)、汤神(小红书)、夏侯(小红书)等

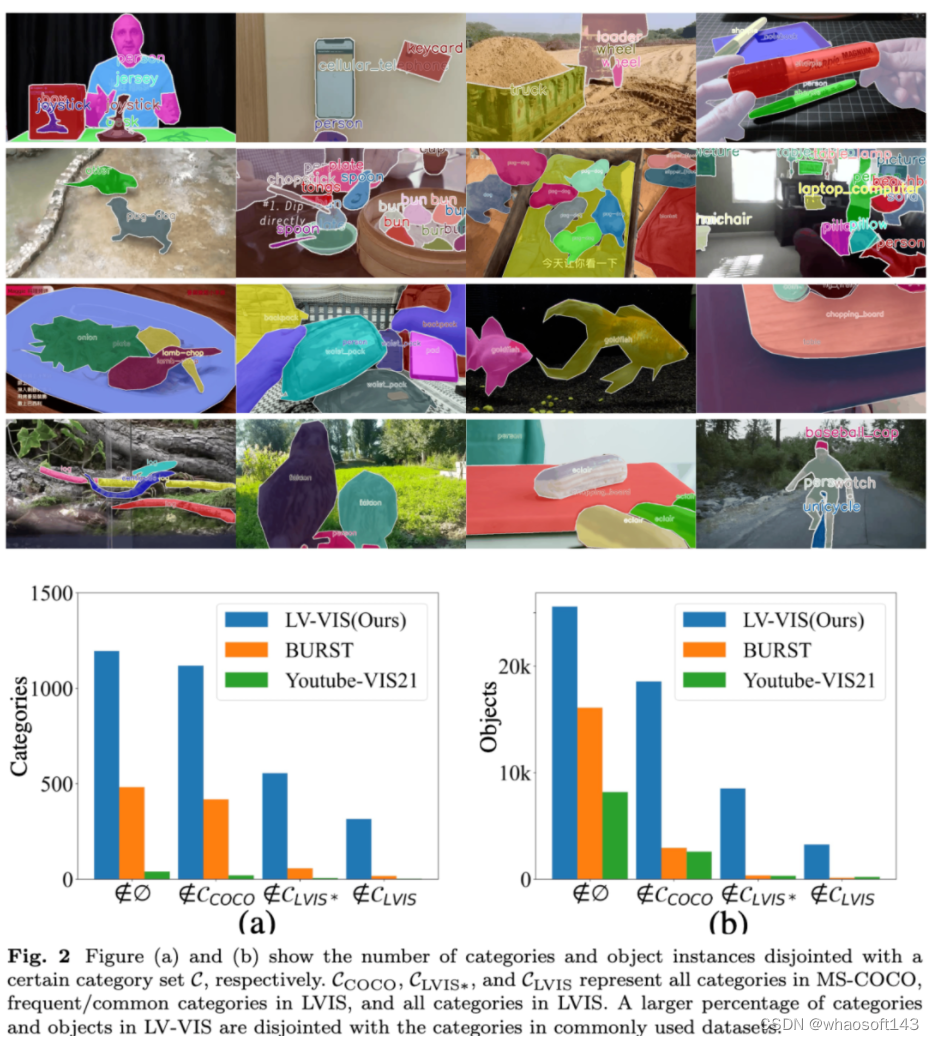

我们首次将视频目标分割能力从少数封闭的训练类别扩展到不受限的开放类别,并为这个全新任务提供了评测 Benchmark 和 Baseline模型,提高了视频目标分割的实用性,为开放类别上的通用视频目标分割研究打下了基础。

“视频目标分割”作为一项基础视频级任务,其目标是识别、分割和跟踪出现在一段视频中的物体。它既是视频内容理解、视频表征学习等上层任务的基础,亦可应用于视频抠图、编辑等创作工具。然而,传统的视频目标分割任务受限于获取训练集困难,仅限于某些特定的常见类别,因此其泛化能力和使用价值较低。

得益于近年来多模态模型的快速发展,计算机视觉领域的各项研究逐渐从封闭类别集合转变为开放类别集合,提高了深度学习模型的泛化能力,并能在不同应用场景下快速部署。受此启发,我们首次提出将视频目标分割任务从少数封闭的训练类别扩展到不受限的开放类别(Open-Vocabulary Video Instance Segmentation),并提供了相应的Benchmark集和Baseline模型。

-

论文引入开放词汇视频实例分割这一全新任务,通过允许对来自开放类别的对象进行分割、跟踪和分类,扩展了现有实例分割方法的能力,包括在训练过程中未见过的新类别。

-

为评估开放词汇视频实例分割,我们提出了一个大规模词汇视频实例分割数据集(LV-VIS),其中包括来自 1,196 个多样化类别的精确注释对象,显著超过现有数据集的类别数量。

-

我们提出了一种高效的内存引导 Transformer 架构(OV2Seg),用于实现端到端的开放词汇视频实例分割,并具有接近实时的推理速度。在 LV-VIS 和四个现有实例分割数据集上进行了大量实验,证明了 OV2Seg 在新类别上具有强大的零样本泛化能力。

论文:https://arxiv.org/abs/2304.01715

代码:https://github.com/haochenheheda/LVVIS

02 One-shot Implicit Animatable Avatars with Model-based Priors

基于模型先验的隐式可动数字人单样本学习

论文作者:黄洋逸(小红书实习生&浙江大学),王浩帆(小红书),张德兵(小红书)等

我们提出了一种从单个图像中学习人类特定神经辐射场的新方法 ELICIT。ELICIT 从 SMPL 模型引入 3D 身体形状几何先验,并使用基于 CLIP 的预训练模型引入视觉语义先验。我们使用两个先验进行联合优化,从而实现在单个图像输入的情况,还原出不可见姿态下的人体。

现有用于创建人类化身的神经渲染方法,通常要么需要密集的输入信号(例如视频或多视图图像),要么利用从大规模特定 3D 人体数据集中学到的先验知识,以便可以使用稀疏视图输入进行重建。然而,当只有一张图像可用时,这些方法大多数都无法实现逼真的重建效果:身体形状不合理,或是背面不可见区域缺乏细节;这使得构建 3D 数字人的数据成本和门槛比较高。

为了能够高效创建逼真可动的 3D 数字化身,我们提出了一种名为 ELICIT 的新方法,用于从单张图像中学习人体特定的神经辐射场,以实现自由视角渲染,而无需依赖额外的训练数据。ELICIT 利用了两个先验知识:基于骨骼顶点的模板模型(即 SMPL )的 3D 几何先验,提供人体几何形状;基于 CLIP 预训练模型的视觉语义先验,补全穿衣人体的全身外观。两个先验共同指导优化过程,以创建不可见区域中的合理内容。

为了进一步提高重建结果的视觉细节,我们还提出了一种基于分割的采样策略,用于局部细化数字化身的不同部分,增加模型的细节和真实感。ELICIT 在多个知名基准数据集上进行了全面评估,包括 ZJUMoCAP、Human3.6M 和 DeepFashion,结果显示:在只有一张图像可用时,ELICIT 优于基线方法,为重建可动 3D 数字人打开了一条无须额外训练数据的新思路。在未来,我们会继续对其重建质量、重建速度进一步地优化探索,让高质量数字人更好、更快、门槛更低地走向应用,服务于3D AIGC、视频、直播等多样化的业务场景。

论文:https://arxiv.org/abs/2212.02469

代码:https://huangyangyi.github.io/ELICIT/

03 Test-time Personalizable Forecasting of 3D Human Poses

面向分布外角色的个性化人体运动预测

论文作者:崔琼杰(小红书实习生&南京理工大学),王浩帆(小红书)等

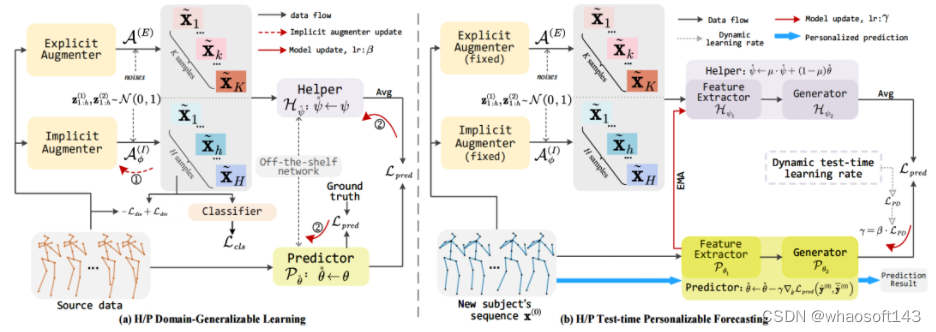

由于数据有限或隐私限制,基于历史行为的运动预测模型往往无法很好地泛化到训练集中没有出现的人物,因此,我们提出一种名为"Helper-Predictor"测试时间个性化的新方法(即 H/P-TTP),在推理阶段根据个性化主体进行定制化,从而实现更准确的运动预测。

传统的运动预测方法,通常是从源域数据中训练一个端到端的深度模型,直接应用于目标对象。然而,出于隐私考虑,目标对象及其自然特性(如行为特征)在训练中是未知的。源预训练模型很难适应这些源外特征,无法针对未见目标人物的特定属性进行个性化处理,从而导致预测结果不可靠。

为了解决这一挑战,我们提出一种名为 “Helper-Predictor” 测试时间个性化的新方法(即 H/P-TTP),用于部署各种未知人物/未知动作样本的 3D 人体运动预测。H/P-TTP 根据各种未知主体的特征获得定制的参数,实现领域通用学习,以获得更真实的预测。具体而言,Helper-Predictor 由显式和隐式增强器组成,前者产生噪声序列以提高鲁棒性,后者采用对抗学习范式生成新领域数据。辅助模型通过增强器处理源之外的样本,获取跨主体的不变上下文,并将这些知识传递给预测模型进行更新。预测模型在测试过程中可以进一步更新,以适应未知的测试对象。

实验证明:通过辅助模型和预测模型的结合,H/P-TTP 在三个大规模人体动作数据集(H3.6M、GRAB、HumanEva-l)上显著超越了传统方法,无论是在精度还是可视化方面。它不仅实现了对未知测试对象的个性化预测,还提高预测性能,具有实际应用的潜力。未来,该方法将有利于各类大规模人体运动分析算法的部署,扩展各种 End-To-End 模型的实际应用边界。

论文主页:https://arxiv.org/pdf/2107.02133.pdf

04 MPI-Flow: Learning Realistic Optical Flow with Multiplane Images

MPI-Flow:从多平面图像中学习更真实的光流

论文作者:梁瑛平(小红书实习生&北京理工大学),刘家铭(小红书),张德兵(小红书)等

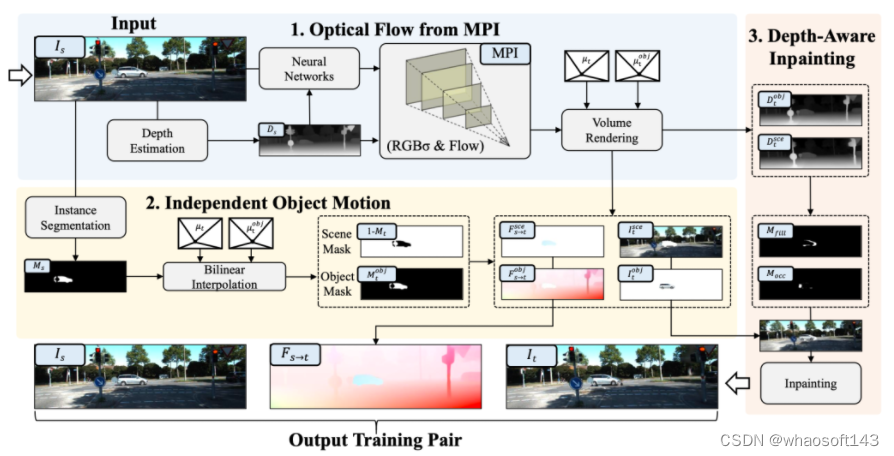

阻碍视频光流模型在业务场景持续优化的一个重要问题是“真实场景下光流数据的缺失”。本文提出 MPI-Flow,仅需单张图像,即可用体渲染的方式生成逼真的光流数据集,为真实世界的高质量光流数据集渲染打开了一扇新的大门。 whaosoft aiot http://143ai.com

基于学习的光流估计模型的准确性,在很大程度上依赖于训练数据集的真实性。目前,生成此类数据集的方法要么使用合成数据,要么以有限的真实性生成图像。然而,这些数据与真实世界场景存在领域差距,限制了训练模型在实际应用中的泛化能力。

为此,我们提出一种无需额外训练数据,从单张真实世界图像生成逼真光流数据集的新方法。

-

为了生成高度逼真的新视角图像,我们从单视图图像中构建分层深度表示,称为多平面图像(MPl)。我们使用相机矩阵和平面深度计算每个平面的光流,以生成与新图像准确对应的光流图。随后利用体积渲染方式,将分层光流投影到输出光流图中。

-

我们提出了一个独立物体运动模块,在 MPI 中分离相机和动态物体运动,以确保运动的真实感。该模块解决了基于 MPI 的单视图方法缺陷,即光流仅有相机的运动产生,而不考虑任何物体移动。

-

我们设计了一个深度感知修复模块,合并新图像与动态对象,解决不自然的运动遮挡问题。

我们通过对真实世界数据集的大量实验,展示了该方法的卓越性能。它以低成本快速从大量单目图像中,构建大规模、运动复杂的成对图像及其光流标签;并基于学习的模型的无监督和监督训练中都取得了最先进的性能,显著提高泛化能力。未来,该方法将为视频理解、3D AIGC 等多样化业务场景提供更精准的光流估计。

论文:https://arxiv.org/pdf/2309.06714.pdf

主页:https://github.com/Sharpiless/MPI-Flow