热门标签

热门文章

- 12024年最新Stable Diffusion下载+安装+使用教程,收藏这一篇就够了!_stable diffusion 最新版本

- 2帆软(FineReport)---- 数据决策系统的基本配置

- 3git 本地链接到远程分支时,部分分支找不到_新拉去的代码不显示分支

- 42023年pmp的考试时间是什么时候?_pmp考试时间

- 5C语言输出100到999之间构成三位数的乘积等于三位数字的和的数字_编写程序输出100~999之间所有对称三位数

- 6【MATLAB】MATLAB向量与矩阵运算编程技巧_ones(m,1)

- 7pmdarima中的pipeline和autoarima_pmdarima.pipeline

- 8联邦学习【分布式机器学习技术】【①各客户端从服务器下载全局模型;②各客户端训练本地数据得到本地模型;③各客户端上传本地模型到中心服务器;④中心服务器接收各方数据后进行加权聚合操作,得全局模型】_联邦学习每个客户端的训练集

- 9【分享笔记】符尧:预训练、指令微调、对齐、专业化——论大语言模型能力的来源

- 10c++ 模板使用详解_c++模板的使用

当前位置: article > 正文

LLama3| 本地 Web Demo 部署

作者:我家自动化 | 2024-05-19 18:53:37

赞

踩

LLama3| 本地 Web Demo 部署

前置工作

课程文档:Llama3-Tutorial/docs/hello_world.md at main · SmartFlowAI/Llama3-Tutorial · GitHub

1.安装vscode

2.安装vscode插件

- Remote SSH

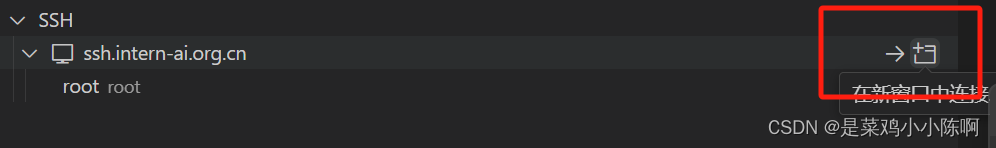

3.配置 VSCode 远程连接开发机

- ssh连接开发机

- 进行端口映射

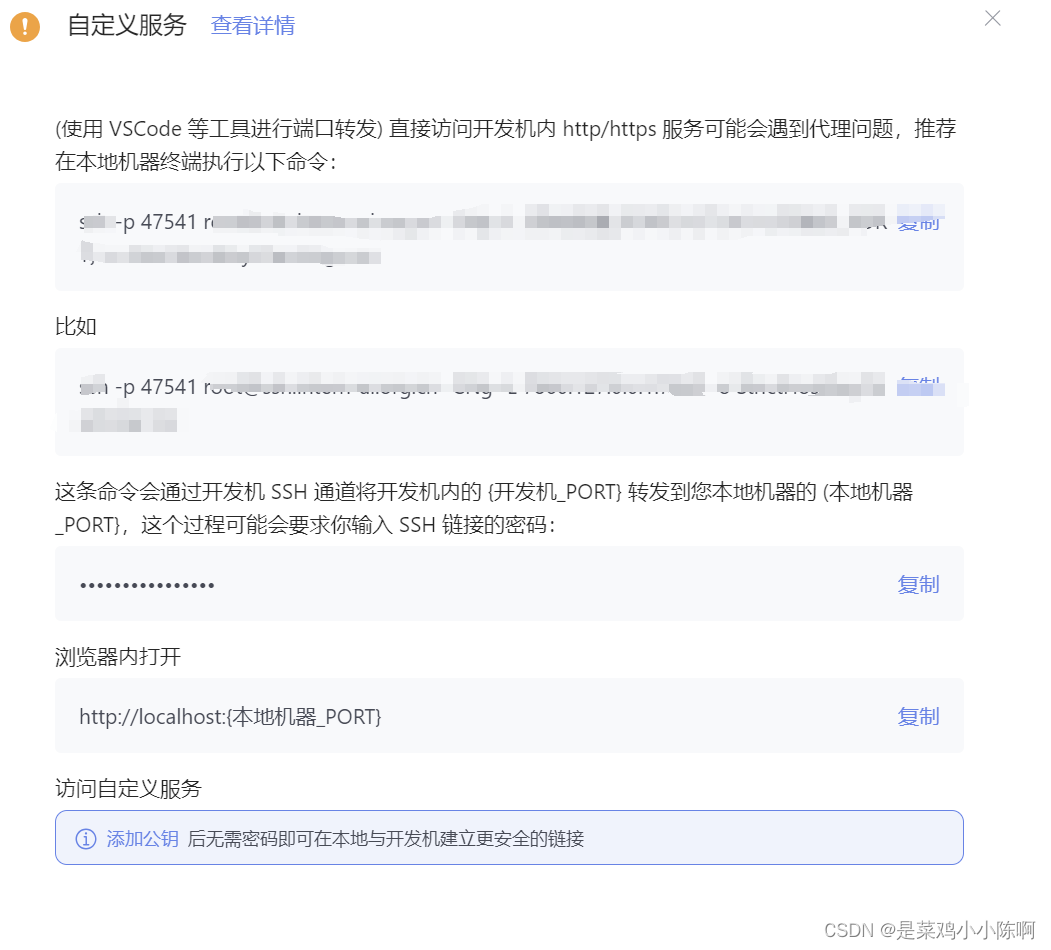

在开发机控制台中点击自定义服务,复制命令粘贴到本机的 powershell 中

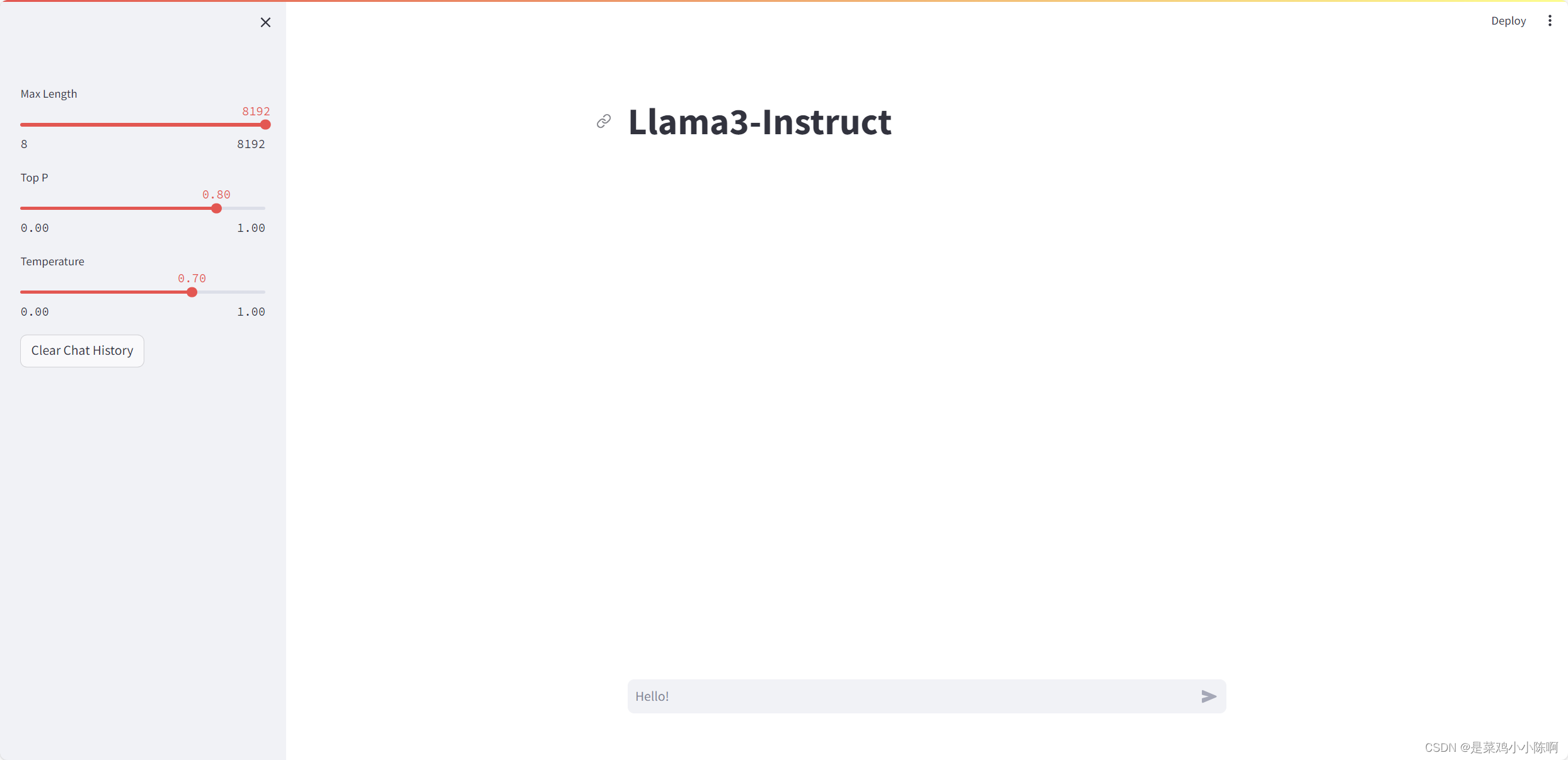

一.本地 Web Demo 部署

1.环境配置

conda create -n llama3 python=3.10

conda activate llama3

conda install pytorch==2.1.2 torchvision==0.16.2 torchaudio==2.1.2 pytorch-cuda=12.1 -c pytorch -c nvidia

- 1

- 2

- 3

2.模型下载

mkdir -p ~/model

cd ~/model

- 1

- 2

安装 git-lfs 依赖

# 如果下面命令报错则使用 apt install git git-lfs -y

conda install git-lfs

git-lfs install

- 1

- 2

- 3

InternStudio软连接

ln -s /root/share/new_models/meta-llama/Meta-Llama-3-8B-Instruct ~/model/Meta-Llama-3-8B-Instruct

- 1

3.Web Demo 部署

下载 Llama3-Tutorial

cd ~

git clone https://github.com/SmartFlowAI/Llama3-Tutorial

- 1

- 2

安装 XTuner

cd ~

git clone -b v0.1.18 https://github.com/InternLM/XTuner

cd XTuner

pip install -e .

- 1

- 2

- 3

- 4

运行 web_demo.py

cd ~

git clone -b v0.1.18 https://github.com/InternLM/XTuner

cd XTuner

pip install -e .

- 1

- 2

- 3

- 4

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/我家自动化/article/detail/594193

推荐阅读

相关标签