热门标签

热门文章

- 1huggingface transformers框架学习_huggingface 二次预训练

- 2Docker07——镜像构建案例_docker制作镜像经典案例

- 3java+junit百科_JUnit介绍

- 4递归应用:二分查找_二分查找法最多查找多少次

- 5HashMap和HashSet

- 6[CVPR 2024] GaussianEditor :第一个基于Gasussian Splatting的3D编辑

- 7RabbitMQ 之 死信队列

- 8基于Verilog的流水灯

- 9LeetCode 刷题 [C++] 第122题. 买卖股票的最佳时机 II (贪心算法与动态规划)_给定一个数组,它的第 i 个元素是一支给定股票第 i 天的价格。 对该股票可以进行多

- 10前端找工作有多难?以后还要入坑学前端吗?_前端找工作难吗

当前位置: article > 正文

《自然语言处理》第二次实验:机器翻译(Seq2Seq中英文翻译实验)_自然语言处理机器翻译测试集

作者:我家自动化 | 2024-06-08 07:20:06

赞

踩

自然语言处理机器翻译测试集

文章目录

在实际生活中,机器翻译是人工智能技术比较广泛的一个应用,在之前的深度学习过程中,我们知道,循环神经网络能将输入序列映射成等长的输出序列,但在机器翻译应用中,输入序列与输出序列的长度通常不一样。序列到序列(Sequence to Sequene, Seq2Seq)的映射框架,就是用来解决这一问题,它能将一个可变长序列映射到另一个可变长序列。本章实验将探索Seq2Seq基础模型在机器翻译中的应用,以及Attention注意力机制、Transformer模型对基础Seq2Seq模型的改进。

本章实验的主要目的是通过中英翻译实验,学员能深入地了解神经网络在NLP机器翻译领域的应用。通过案例代码的学习,重点理解seq2seq解码器-编码器框架、attention注意力机制、transformer架构。

任务一:按照实验手册进行Seq2Seq中英文翻译实验

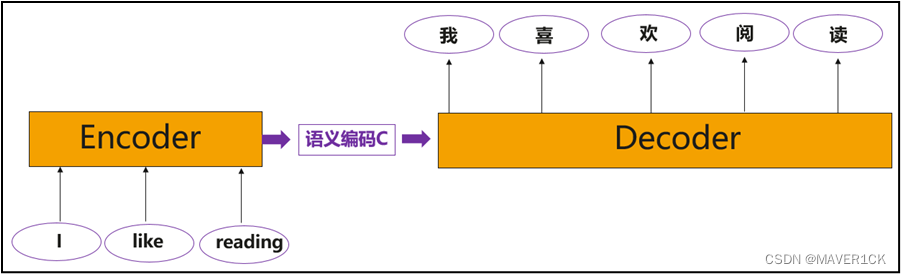

翻译任务在日常生活应用广泛,如手机中有各种翻译软件,可以满足人们交流、阅读的需求。本实验基于Seq2Seq编码器-解码器框架,结合GRU单元实现英文转中文的翻译任务,框架示意图如下:

GRU(门递归单元)是一种递归神经网络算法,就像LSTM(长短期存储器)一样。它是由Kyunghyun Cho、Bart van Merrienboer等在2014年的文章“使用RNN编码器-解码器学习短语表示用于统计机器翻译”中提出的。本文提出了一种新的神经网络模型RNN Encoder-Decoder&#x

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/我家自动化/article/detail/688897

推荐阅读

相关标签