- 1LeetCode刷题:字符串中的第一个唯一字符_已知s是字符串,则s0永远是字符串,第1位字符

- 2WIN7下运行hadoop程序报:Failed to locate the winutils binary in the hadoop binary path_failed to locate the winutis

- 3C语言枚举类型和联合体_c语言枚举类型实际上是int型吗

- 4AES加解密之C++实现_c++ aes加密解密

- 5使用Python进行自然语言处理(NLP):NLTK与Spacy的比较

- 6【Python】从基础到进阶:了解Python语言基础以及变量的相关知识

- 7关于分布式锁的几篇文章_分布式锁 论文

- 8Unity中使用Protobuf_unity protobuf

- 9探秘 PPet:一款强大的Python宠物框架,让开发更有趣

- 10Spring Cloud OAuth2 实现用户认证及单点登录_spring cloud2021 整合oauth2 单点登录

基于深度学习的知识图谱构建(简要综述)_webnlg数据集介绍

赞

踩

1 简介

信息技术的发展不断推动着互联网技术的变革,Web技术作为互联网时的标志性技术,正处于这场技术变的核心。从网页的链接到数据的链接,Web技术正在逐步朝向Web之父Berners-Lee设想中的语义网络演变。语义网络是一张数据构成的网络,语义网络技术向用户提供的是一个查询环境,其核心要义是以图形的方式向用户返回经过加工和推理的知识。而知识图谱技术则是实现智能化语义检索的基础和桥梁。

知识图谱的概念是由谷歌公司在2012年5月17日提出的,谷歌公司将以此为基础构建下一代智能化搜索引擎,知识图谱技术创造出一种全新的信息检索模式,为解决信息检索问题提供了新的思路。本质上,知识图谱是一种揭示实体之间关系的语义网络,可以对现实世界的事物及其相互关系进行形式化地描述。现在的知识图谱已被用来泛指各种大规模的知识库。

知识图谱通常使用三元组的形式来表示,即,其中是知识库中的实体集合,共包含种不同的实体;是知识库中的关系集合,共包含种不同关系;代表知识库中的三元组集合。三元组的基本形式主要包括<实体1,关系,实体2>和<概念,属性,属性值>等,实体是知识图谱中的最基本元素,不同的实体间存在不同的关系。概念主要指集合、类别、对象类型、事物的种类,例如人物、地理等;属性主要指对象可能具有的属性、特征、特性、特点以及参数,例如国籍、生日等;属性值主要指对象指定属性的值,例如中国、1988-09-08等。每个实体(概念的外延)可用一个全局唯一确定的ID来标识,每个属性-属性值对可用来刻画实体的内在特性,而关系可用来连接两个实体,刻画它们之间的关联。

知识图谱的架构主要包括自身的逻辑结构以及体系架构。目前,大多数知识图谱都采用自底向上的方式进行构建,其中最典型就是Google的Knowledge Vault,知识图谱体系架构如下图 1所示:

深度学习可以视为“用深度神经网络来做机器学习”的简称。神经网络并不是一个新的概念,而是一种机器学习的方法,是用类似于大脑神经突触联接的结构进行信息处理的数学模型,用来做分类和聚类。卷积神经网络虽然发布的时间较早,但是受硬件计算能力的约束,一直到2006年Hilton解决它的训练问题之后才焕发生机,尤其是2014年以来才大面积的使用,特别是在计算机视觉和听觉领域里大放异彩。

在自然语言处理的一些领域,循环神经网络(RNN)及其变种长短期记忆网络(简称LSTM)等深度学习算法在处理一些与时间序列相关的文本中,表现卓越。例如,深度学习在中文分词、实体抽取、机器翻译、文档摘要、多轮会话等方面,表现出了强大的能力。只要是对历史时间序列内容进行分析和建模,然后对新数据进行分类预测的问题(例如中文分词和实体抽取),都能转变为对文本中的每一个汉字角色进行分类。在有足够数据积累和训练语料的情况下,深度学习都能以简单粗暴高效的方式解决问题,并且碾压之前的技术手段所取得的效果。

知识图谱的构建包括三个部分:信息抽取、知识融合和知识加工。其中信息抽取指从各种类型的数据源中提取出实体(概念)、属性以及实体间的相互关系;知识融合指获得新知识之后对其进行整合,以消除矛盾和歧义;知识加工指对要融合的新知识进行质量评估,然后加入知识库,并进行新的关系推理。深度学习在自然语言处理中的杰出表现,可以帮助知识图谱完成这些构建工作。

本文中,作者从知识图谱的构建过程出发,引出深度学习在知识图谱构建过程中的应用。

2 相关工作

基于上述介绍,文章在此以实体和关系的表示学习技术为基础,讨论深度学习在实体抽取、关系抽取、实体消歧、关系补全等任务上的应用。

实体抽取

实体抽取,即命名实体识别(NER)。命名实体识别是从文本中提取出和人名、地名等特定的短语或名称的任务。早期的命名实体识别主要基于规则和词典来进行,对规律性较强的文本环境较为适合,但难以摆脱对领域专家的的依赖,费时费力且难以移植。随着语料数据的增长,研究者逐步将机器学习和统计分析技术应用于命名实体识别,其方法可以分为有监督、半监督和无监督的方法。

有监督方法基于序列标注思想,结合大量标注语料,定义一系列实体来训练判别模型。传统模型包括隐马尔科夫模型(HMM)、最大熵马尔科夫模型(MEMM) 、条件随机场(CRF)等。在深度学习领域,针对序列标注的思路,研究者将卷积神经网络(CNN)和循环神经网络用于该任务,结合词语的表示学习,取得了优于传统方法的结果。

半 监 督( 或 弱 监 督) 方 法 主 要 采 用 boot-strapping 技术,只利用很少的标注数据作为种子开始学习,结合大量无标注数据,通过模板、句法分析树等方式迭代地从上下文中发现实体。

无监督方法则在无标注数据集的情况下,采用聚类等方法,利用类似的上下文推测出类似的概念和实例;或者基于外部知识(如 WordNet 等),完成从一个领域到另一领域的迁移学习。随着文本数据资源的不断丰富,研究者结合词的向量表示和已有的词典等信息,利用词向量之间的相对关系 ( 如v (king) -v(queen) = v(man) -v(woman)) 通过训练词向量和评估词语之间的投射关系矩阵,发现新的上下位实体。

关系抽取

关系抽取是指从无结构的自然语言文本中找出实体之间的语义关系。早期主要采用基于规则的方法,提前定义关系所对应的结构规则,进行特定领域的关系抽取。而后,主要采用基于特征和核函数的方法,前者主要通过提取文本的语法特征来构建关系的分类器;后者则利用短语句法、依存语法、实体之间路径关系等信息设计相应的核函数,并通过核函数计算两个实例的关系来完成关系抽取。近期,研究者将循环神经网络等深度学习技术应用于关系抽取中。例如,Xu et al提出一种基于 LSTM 循环神经网络的方法,对自然语言语句的依存树中不同实体间的最短依赖路径进行分析,以确定实体间关系的类别,该方法证实了深度神经网络在关系抽取中的有效性。

实体消歧

实体消歧(Entity Disambiguation)是为了解决实体名的歧义性和多样性问题,在应用中确定出实体名所指向的真实世界实体。实体是文本信息的重要承载,每一段有意义的文本都描述了一组实体及这些实体相互之间的关联和交互。通过识别知识图谱中特定实体在文本中的出现,同时发现文本中知识图谱未覆盖的实体,实体消歧在知识图谱的构建和补全上都起到重要作用。因此,识别并理解文本中的实体信息也就成为了自然语言理解的基础问题之一。

然而,文本中实体信息的理解存在两方面的挑战。首先,文本中的实体名通常具有歧义。例如,给定如下三个包含“苹果”的句子:1)今 天 上 午 苹 果 由 乔 布 斯 发 布 了 新 一 代iPhone;2)我早餐吃了一个苹果;3)范冰冰在苹果中演的不错。上述三个句子中的 “苹果”分别指向实体“苹果公司”、“水果苹果”及“电影苹果”。其次,实体的提及(mention)形式具有多样性,也就是人们可能会用不同的实体名来指向同一个实体。例如,在提到 IBM 公司时,人们可以使用 IBM、Big Blue 或 International Business MachinesCorporation 等不同名字。

对于实体歧义造成的影响,国内外的大多熟研究从两个角度进行解决,分别是寻求更高质量的特征和引入外部资源。在特征选取方面,何正焱利用DNN(深度神经网络)方法,提出了一种文档和实体的相似度为框架的消歧模型;姜丽丽提出了一种基于带权图结构的框架来实现人物实体的消歧工作,并使用实体标签对每个人物实体进行标注;Bagga和Baldwin将不同文档间上下文的相似度作为特征实现实体消歧的;R.Bekkerman和A.McCallum则结合了社交网络的链接信息和聚类两种非监督的框架对社交网络中的人物实体进行消歧。

给定的文档集中所包含的被査询的信息往往是非常有限的,因此网络公共资源经常被用来挖掘更多的信息以提高同名消歧质量。其中,中科院的韩先培使用了在线知识库信息来辅助解决实体歧义的,D.Bollegara通过来对Web搜索引擎中的同名人物实体进行消歧;R.Bunescu尝试使用在线百科全书(Wikipedia)的部分锚文本信息来扩充文档集,从而完成信息检测和同名消歧的任务。这些方法能够非常出色的完成实体消歧的任务,但是由于其需要花费大量的时间进行在线信息采集,因此更适合于服务器端的应用。

关系补全

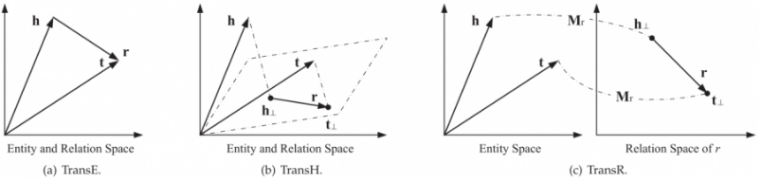

关系补全是基于知识库中已有的知识,进行推理或计算,对知识库中缺少的关系进行填补的任务。根据分析目标的不同可以分为两个方面,一是已知某关系两端的实体,求取两实体之间的关系;二是已知某个实体和与之关联的关系,求取该关系另一端的实体。前者可称为链接预测,后者可称为实体预测。当前,常见的关系补全方法包括基于张量重构的方法和基于翻译模型的方法等。基于张量重构的方法,以 RESCAL 系统为主要代表,将知识库的整个实体关系网络看作三维张量,其中每个二维切片是对一种关系的描述,该方法将整个知识库的信息进行编码整合,推理过程计算量小,但当知识库规模较大时,张量重构的代价较大。基于翻译模型的方法则将知识库中的关系看作实体间的平移向量,即将关系三元组<实体 S,关系 P,实体O> 中的尾部实体 O 看作头部实体 S 经过关系 P 的翻译结果。Trans* 系列模型是这类方法的代表。其中,Bordes等人提出的 TransE 模型通过结合实体和关系的表示学习,对知识库中的 1-1 关系进行补全。在此基础上,为了近一步处理1-N、N-1、N-N等复杂关系,出现了TransII、TransR等模型,为了将孤立三元组关系的语义融合为关系路径的语义,出现了PTransE模型,为了近一步融合知识库三元组关系和外部文本知识,出现了DKRL模型等。

3 方法

在该部分,我们对上述实体抽取、关系抽取、实体消歧、关系补全等任务的主流算法结构进行介绍。

3.1 实体抽取

实体抽取的方法众多,本文主要解读基于LSTM+CRF的实体抽取。

该方法最初由Lample等人于2016年提出,后续经历了许多的改进。在实体抽取过程中,领域内资源(例如地理资源集gazetteers)或特征的获取耗时耗力,而该方法可以避免使用领域内的资源或特征;另外,传统的特征提取过程中会用到复杂的NLP工具,会造成误差传递,而该方法利用神经网络自动从文本中学习特征。

该识别模型有两种识别策略。第一种是:每个句子按照词序逐个输入双向LSTM中,结合正反向隐层输出得到包含每个词类别特征的表示,输入CRF中,优化目标函数,从而得到每个词所属的实体类别。具体的操作流程如图 2所示。第二种是:通过将每个词拆成字符序列,利用双向LSTM得到该词的正反向两种表示(字符级别的特征),并将两种表示串联作为该词的特征表示输入到模型网络中,操作流程如图 3。

3.2 关系抽取

关系抽取任务的类型多种多样,从难度的角度来说,主要包括从非结构化和半结构化的文本中进行抽取。对于非结构文本中的关系抽取,研究界一般又进行了相应的细分,如下图 4所示:

对于预定义关系抽取,本文以关系分类为例进行解释说明。考虑到1)传统方法依赖NLP工具,人工提取特征,造成错误传递;2)句子级语义信息对关系抽取任务至关重要;3)句子中的不同位置的词有不同程度的重要性等原因,Zhou Peng等人于2016年提出了基于LSTM的关系分类。该方法利用双向LSTM编码每个词的表示,并将相应位置的词表示使用Hadamard积进行处理,得到最终的词特征。利用该向量并经下面一系列计算,最终得到Softmax输出的分类关系类别:

图 5 基于LSTM的预定义关系抽取

对于开放式关系抽取,本文以深度学习方法为例进行介绍。开放式关系抽取通过识别表达语义关系的短语来抽取实体之间的关系,同时使用句法和统计数据来过滤抽取出来的三元组。基于深度学习的开放式关系抽取,使用加入拷贝机制的序列到序列模型,从源句子中拷贝句子片段作为抽取出的三元组。具体的操作过程如下所示:

图 6 基于深度学习的开放式关系抽取框架

3.3 实体消歧

当前,实体消歧技术包括基于聚类的实体消歧和基于实体链接的实体消歧,本文主要介绍基于实体链接的方法。基于实体链接的方法包括候选实体的发现和候选实体的链接,其中候选实体的发现包括利用 Wikipedia 信息的方法和利用上下文信息的方法,而候选实体链接的基本方法是计算实体指称项和候选实体的相似度并选择相似度最大的候选实体。候选实体链接的获取过程,包括利用先验知识做初始排序、局部实体链接和协同实体链接,这三个步骤都可以单独进行候选实体链接,但大多数模型是将三者组合使用。使用深度学习方法的实体消歧主要体现在:使用表示学习的方法进行局部实体链接。

使用卷积神经网络的表示学习方法,由Francis-Landau等人于2016年提出。该方法利用卷积网络分别得到实体指称项的表示,实体指称项上下文表示,实体指称项所在篇章的表示;利用卷积神经网络得到目标实体标题表示,和目标实体篇章表示。计算实体指称项的三个表示和目标实体的两个表示之间两两的相似度,得到六维相似度向量。这个向量包含了不同粒度的相似度信息。将这个向量与传统特征拼接,通过逻辑斯蒂回归得到最终相似度得分。将得分最高的候选实体作为实体指称项的链接实体。

图 7 基于CNN的表示学习方法

3.4 关系补全

关系补全,即关系推理。关系推理包括归纳推理(学习推理规则)、演绎推理(推理具体事实)和基于分布式表示的推理。分布式知识表示(Knowledge Graph Embedding)的核心思想是将符号化的实体和关系在低维连续向量空间进行表示,在简化计算的同时最大程度保留原始的图结构。

分布式知识表示的方法有位移距离模型(它们采用基于距离的打分函数来衡量三元组成立的可能性)、语义匹配模型(它们计算实体和关系在隐式向量空间的语义匹配程度,以此来判断三元组成立的可能性)。TransE及其变种是最具代表性的位移距离模型,其核心思想是实体和关系间的位移假设。对于语义匹配模型,RESCAL及其变种将头实体和尾实体的表示进行组合后再与关系的表示进行匹配,而SME、NTN、MLP、NAM等模型利用较为复杂的神经网络结构完成实体和关系的语义匹配。

图 8 TransE及其变种

图 9 RESCAL及其变种

图 10 基于深度神经网络的语义匹配模型

4 数据集介绍

(一)实体抽取

中文实体抽取的标注的数据集规模比较小,两个比较常用的数据集微博数据集和MSRA数据集,样本数分别为1.3k和45k。

(二)关系抽取

1)NYT数据集:选择了Freebase中的四大类关系回标纽约时报。用斯坦福命名实体识别工具识别句子中的实体提,用Freebase三元组中的实体名称与实体提及进行字符串匹配,将三元组中两个实体同时出现的句子收集在一起构成包。

2)WebNLG数据集:该数据集为了自然语言生成任务而构建,使用了DBPedia中的三元组,包括六个类别(宇航员、建筑、纪念碑、大学、运动队、著作)。

(三)基于聚类的实体消歧

基于聚类的实体消歧方法,常用的数据集是WePS数据集,WePS数据来自于网络。对每一个歧义人名,WePS数据集提供其在搜索引擎中的前N个结果,每个结果包括以下信息:在原来搜索引擎中的排序、URL、Snippet和标题等。

(四)基于实体链接的实体消歧

(1) AIDA(AIDA CoNLL-YAGO):由马普研究所公开的数据集,是目前最大的手工标注实体链接数据集。它是基于CoNLL 2013 实体识别数据集上标注的,题材是路透社新闻。

(2) WNED:自动构建的数据,数据规模很大。WEND-CWEB是从ClueWeb中自动构建的,WNED-WIKI是从Wikipedia中自动构建的。由于是自动构建的数据,所以数据中噪音比较大,可信度较低。

(3) TAC KBP数据集2009-2018:TAC (Text Analysis Conference) KBP (Knowledge Base Population)是国际上知名的实体链接评测,由美国国防高级研究计划局(DARPA)资助。数据来源是新闻和论坛,是手工标注的数据集。

5 结论

本文对知识图谱构建过程进行了介绍,主要包括相关技术方法以及数据集。知识图谱是最接近真是世界的数据组织结构,符合人的思维模式,可以为人工智能应用提供基础环境。领域知识图谱目前在很多行业中已经发挥越来越重要的作用,技术上的挑战也有不断地进展,希望有更多地领域知识图谱落地,帮助推动行业应用地智能化。

附Neo4j构建图谱案例的链接:

https://www.jianshu.com/p/d4175930e820

https://www.cnblogs.com/jpfss/p/11282370.html

参考文献

- 刘峤, 李杨, 段宏,等. 知识图谱构建技术综述[J]. 计算机研究与发展, 2016, 53(3):582-600.

- AMIT S. Introducing the Knowledge Graph: things, not strings[R]. America:Official Blog of Google, 2012.

- 徐增林, 盛泳潘, 贺丽荣,等. 知识图谱技术综述[J]. 电子科技大学学报, 2016, 45(4):589-606.

- Dong X , Gabrilovich E , Heitz G , et al. Knowledge vault: a web-scale approach to probabilistic knowledge fusion[J]. 2014.

- Schmidhuber J. A local learning algorithm for dynamic feedforward and recurrent networks[J]. Connection Science, 1989, 1(4): 403-412.

- Hochreiter S, Schmidhuber J. Long short-term memory [J]. Neural Computation, 1997, 9(8):1735-1780.

- Rau L F. Extracting company names from text[C]//Artificial Intelligence Applications, 1991. Proceedings., Seventh IEEE Conference on. IEEE, 1991, 1: 29-32.

- Zhou G D, Su J. Named entity recognition using an HMM-based chunk tagger[C]//proceedings of the 40th Annual Meeting on Association for Computational Linguistics. Association for Computational Linguistics, 2002: 473-480.

- Chieu H L, Ng H T. Named entity recognition: a maximum entropy approach using global information[C]// Proceedings of the 19th international conference on Computational linguistics-Volume 1. Association for Computational Linguistics, 2002: 1-7.

- Settles B. Biomedical named entity recognition using conditional random fields and rich feature sets[C]// Proceedings of the International Joint Workshop on Natural Language Processing in Biomedicine and its Applications. Association for Computational Linguistics, 2004: 104-107.

- Collobert R, Weston J. A unified architecture for natural language processing: Deep neural networks with multitask learning[C]//Proceedings of the 25th international conference on Machine learning. ACM, 2008: 160167.

- Jain A, Pennacchiotti M. Open entity extraction from web search query logs[C]//Proceedings of the 23rd International Conference on Computational Linguistics. Association for Computational Linguistics, 2010: 510518.

- Hammerton J. Named entity recognition with long short-term memory[C]//Proceedings of the seventh conferenceon Natural language learning at HLT-NAACL 2003-Volume 4. Association for Computational Linguistics, 2003: 172-175.

- Lenci A, Benotto G. Identifying hypernyms in distributional semantic spaces[C]//Proceedings of the First Joint Conference on Lexical and Computational Semantics-Volume 1: Proceedings of the main conference and the shared task, and Volume 2: Proceedings of the Sixth International Workshop on Semantic Evaluation. Association for Computational Linguistics, 2012: 75-79.

- Basile P, Caputo A, Semeraro G. Supervised Learning and Distributional Semantic Models for Super-Sense Tagging[M]//AI* IA 2013: Advances in Artificial Intelligence. Springer International Publishing, 2013: 97-108.

- Fu R, Guo J, Qin B, et al. Learning Semantic Hierarchies via Word Embeddings[C]//ACL (1). 2014: 1199-1209.

- Kambhatla N. Combining lexical, syntactic, and semantic features with maximum entropy models for extracting relations[C]//Proceedings of the ACL 2004 on Interactive poster and demonstration sessions. Association for Computational Linguistics, 2004: 22.

- Plank, Barbara, and Alessandro Moschitti. "Embedding Semantic Similarity in Tree Kernels for Domain Adaptation of Relation Extraction." ACL (1). 2013.

- Xu Y, Mou L, Li G, et al. Classifying relations via long short term memory networks along shortest dependency paths[C]//Proceedings of Conference on Empirical Methods in Natural Language Processing. 2015.

- Zhengyan He,Shuji Liu,M u Li,et al.Learning entity representation for entity disambiguation[C].In proceedings of Association of Computational Language,2013: 30-34.

- 姜丽丽.实体搜索与实体解析方法研究[D].兰州: 兰州大学,2012.

- Bagga A, Baldwin B.Entity-based cross-document coreferencing using the vector space model[C].Proceedings of the 36th Annual Meeting of the Association for Computational Linguistics and the 17th International Conference on Computational Linguistics ( COLING-ACL), 1998: 79-85.

- Bekkerman R, McCallum A. Disambiguating web appearances of people in a social network [C].Proceedings of the 14th International World Wide Web Conference( WWW) , 2005: 463-470.

- Han X,Sun L,Zhao J.Collective entity linking in web test: a graph-based method[C].Proceedings of the 34th international ACM SIGIR Conference on Research and development in Information Retrieval,2011: 765-774.

- Bollegara D,Matsuo Y,Ishizuka M. Disambiguating personal names on the web using automatically extracted key phrases[C].Proceedings of the biennial European Conference on Artificial Intelligence(ECAI 2006),2006.

- Bunescu R,Pasca M.Using encyclopedic knowledge for named entity disambiguation[C].Proceedings of EMNLP-CoNLL,2006(6) : 9-16.

- Nickel M, Tresp V, Kriegel H P. A three-way model for collective learning on multi-relational data[C]//Proceedings of the 28th international conference on machine learning (ICML-11). 2011: 809-816.

- Nickel M, Tresp V, Kriegel H P. Factorizing yago: scalable machine learning for linked data[C]//Proceedings of the 21st international conference on World Wide Web. ACM, 2012: 271-280.

- Nickel M, Tresp V. Logistic tensor factorization for multi-relational data C]//Proceedings of ICML, 2013.

- Bordes A, Usunier N, Garcia-Duran A, Translating embeddings for modeling multi-relational data[C]//Advances in Neural Information Processing Systems. 2013: 2787-2795.

- Wang Z, Zhang J, Feng J, Knowledge Graph Embedding by Translating on Hyperplanes[C]//AAAI. 2014: 11121119.

- Lin Y, Liu Z, Sun M, Learning Entity and Relation Embeddings for Knowledge Graph Completion[C]//AAAI. 2015: 2181-2187.

- Lin Y, Liu Z, Sun M. Modeling relation paths for representation learning of knowledge bases[J]. arXiv preprint arXiv:1506.00379, 2015.

- Xie R, Liu Z, Jia J, Representation Learning of Knowledge Graphs with Entity Descriptions[J]. 2016.

- Lample, Guillaume, Ballesteros, Miguel, Subramanian, Sandeep,等. Neural Architectures for Named Entity Recognition[J].

- Zhou P, Shi W, Tian J, et al. Attention-Based Bidirectional Long Short-Term Memory Networks for Relation Classification[C]. meeting of the association for computational linguistics, 2016: 207-212.

- Cui L, Wei F, Zhou M, et al. Neural Open Information Extraction[C]. Meeting of the Association for Computational Linguistics, 2018: 407-413.

- Francis-Landau M , Durrett G , Klein D . Capturing Semantic Similarity for Entity Linking with Convolutional Neural Networks[C]// Proceedings of the 2016 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. 2016.

- Wang Q , Mao Z , Wang B , et al. Knowledge Graph Embedding: A Survey of Approaches and Applications[J]. IEEE Transactions on Knowledge and Data Engineering, 2017, PP(99):1-1.

- A. Bordes, X. Glorot, J. Weston, and Y. Bengio, “A semantic matching energy function for learning with multi-relational data,” Mach. Learn., vol. 94, no. 2, pp. 233–259, 2014.

- R. Socher, D. Chen, C. D. Manning, and A. Y. Ng, “Reasoning with neural tensor networks for knowledge base completion,” in Adv. Neural Inf. Process. Syst., 2013, pp. 926–934.

- X. Dong, E. Gabrilovich, G. Heitz, W. Horn, N. Lao, K. Murphy, T. Strohmann, S. Sun, and W. Zhang, “Knowledge vault: A webscale approach to probabilistic knowledge fusion,” in Proc. 20th ACM SIGKDD Int. Conf. Knowl. Discovery Data Mining, 2014, pp. 601–610.

- Q. Liu, H. Jiang, A. Evdokimov, Z.-H. Ling, X. Zhu, S. Wei, and Y. Hu, “Probabilistic reasoning via deep learning: Neural association models,” in arXiv:1603.07704, 2016.

- http://www.nlpir.org/download/weibo_content_corpus.rar

- https://github.com/guillaumegenthial/sequence_tagging

- Dunietz J , Gillick D . A New Entity Salience Task with Millions of Training Examples[C]// EACL 2014. 2014.

- https://gitlab.com/shimorina/webnlg-dataset

- https://www.dataweps.com/

- Johannes Hoffart, Mohamed Amir Yosef, Ilaria Bordino, Hagen Furstenau, Manfred Pinkal, Marc Span-iol, Bilyana Taneva, Stefan Thater, and Gerhard Weikum. 2011. Robust disambiguation of named entities in text. In Proceedings of the Conference on Empirical Methods in Natural Language Processing, pages 782–792. Association for Computational Linguistics.

- Evgeniy Gabrilovich, Michael Ringgaard, and Amarnag Subramanya. 2013. Facc1: Freebase annotation of clueweb corpora, version 1 (release date 2013-06-26, format version 1, correction level 0). Note: http://lemurproject.org/clueweb09/FACC1/Cited by, 5

- Guo Z , Barbosa D . Robust named entity disambiguation with random walks[J]. Semantic Web, 2017, 9(11):1-21.

- Ikuya Yamada, Hiroyuki Shindo, Hideaki Takeda, and Yoshiyasu Takefuji. 2016. Joint learning of the embedding of words and entities for named entity disambiguation. CoNLL 2016, page 250.

- Amir Globerson, Nevena Lazic, Soumen Chakrabarti, Amarnag Subramanya, Michael Ringgaard, and Fernando Pereira. 2016. Collective entity resolution with multi-focal attention. In ACL (1).

- Yaming Sun, Lei Lin, Duyu Tang, Nan Yang, Zhenzhou Ji, and Xiaolong Wang. 2015. Modeling mention, context and entity with neural networks for entity disambiguation. In IJCAI, pages 1333–1339.