- 1多线程之线程池使用_线程池使用多线程

- 2Deepin20.4安装nodejs、npm、yarn_yarn安装 deepin

- 3kail 安装及卸载 docker【亲测可用】_kali清除所有docker

- 4解密AI的未来:决策式AI与生成式AI的深度解析_决策式ai和生成式ai区别

- 5快速上手文心一言指令_文心一言 的 命令有哪些

- 6普元开源OBS仓颉版客户端,相较于Java实现桶创建接口平均响应时长缩小46.8%

- 7文刻创作ai工具文刻软件怎么用_文刻ai工具

- 8理解Flink算子链

- 9伪元素选择器_伪类选择器_伪元素选择器没访问的颜色

- 10python模拟并发是多线程_Python + Selenium+ HTMLTestRunner 多线程并发执行,并合并报告...

大模型岗位面试总结,靠它轻松拿下offer

赞

踩

节前技术群邀请了一些参加大模型面试(含实习)的同学,分享他们面试算法工程师(大模型方向)的宝贵经验。

之前总结链接如下:

超全总结!大模型算法岗面试真题来了!

面了 5 家知名企业的NLP算法岗(大模型方向),被问麻了。。

今天我继续整理,分享给大家,希望对后续找工作的有所帮助。喜欢记得点赞、收藏、关注。

网易

大模型日常实习就中了,我要去网易做大模型实习生啦。

一面

1.文本生成的几大预训练任务?

2.多模态中常见的sota模型,clip为什么效果好

3.多模态大模型有哪些?介绍一下stable diffusion的原理

4.chatglm的原理,其结构,其训练过程

5.instructGPT的原理,讲讲rlhf和reward

6.手写一个文本生成的生成器

二面

1.讲讲T5和Bart的区别,讲讲bart的DAE任务

2.讲讲Bart和Bert的区别,分析下为什么MLM任务能在预训练任务界占这么重要的地位。

3.讲讲项目中对比学习的应用,解释下什么是曝光偏差

4.对比学习负样本是否重要?负样本构造成本过高应该怎么解决

5.项目中提出的利用对比学习解决曝光偏差问题的想法来源?为什么能想到这么做,这么做带来的收益如何?

6.有没有微调过大模型,介绍一下lora的原理和ptuning的原理

7.讲下自己认为自己做事和学习上的缺点与不足

自我感觉答的不错,面试官在面试过程中频频点头,应该印象不错。面完第二天就收到offer了。

美团

岗位:大模型算法岗(日常实习)

一面

面试官是一名温柔小姐姐吖,下面是面试过程:

1.自我介绍 (让我开一下摄像头)

2.聊聊你自我介绍中提到的自己的论文

3.论文录用概率大吗(论文在投)

4.AI大模型的训练过程

5.大模型的优缺点(以及你自己的角度体验到的)

6.大模型的用户体验感最注重哪几个方面

6-2.你自己使用过程中,大模型你感觉体验感怎么样

7.目前市面上有哪些大模型

8.你的最大优点和缺点

9.你认为这个岗位的职责,以及需要具备哪些能力

10.聊了聊大模型在美团业务中可以用来做什么

11.你用过大模型哪些功能?

12.最快什么时候能入职

我提问:1.岗位待遇 2.有几面 2,业务面和HR面 3.有转正机会吗

理想

大模型面经

一面

自我介绍,讲一下大模型应用项目(我讲的nl2sql的项目)

项目背景,总体思路,解决什么问题,指标是什么

细节拆分:

1.数据集怎么构建的,什么规模,有没有质量评估

2.模型底座是什么,这些不同底座什么区别,什么规模

3.训练方法,用的什么sft,有什么不同,有什么优缺点,原理上解释不不同方法的差别

4.评估指标是什么,这些指标存在哪些问题

5.模型推理是怎么做的,有没有cot,tot等等,还是单轮

6.模型可控性如何实现,怎么保证可控性

7.模型部署的平台,推理效率怎么样,如何提升推理效率

8.有没有上线,面临什么问题,怎么解决

9.给一个总的输入输出样例,每一步包含什么prompt,多轮推理每一步输出什么结果,模拟一下,数据集格式是否要调整成这样,数据形式是什么,怎么拆分成多轮形式等等。。

到这里项目差不多了大概问了45min

然后是八股+开放式问题 1.大模型前景

2.大模型主要存在的问题和解决思路(幻觉,定向编辑,继续训练等等)

3.大模型加速框架了解多少,知不知道原理 如何进行加速优化

4.为什么要用大模型做传统结构化解析任务 你对用大模型做这些事有什么看法

到这差不多1小时

最后是能不能实习,对最新的研究了解多少,看过多少最新论文等等

我本以为结束了,但是,最后我们来做一道题吧

题我忘了,好像是一个迭代法求根的题,反正当时已经神志不清了,好像没ac

二面

很简单,感觉是部门leader,简单问了问项目,普通八股,大模型上线会有什么问题,占用多少资源,怎么优化等等,比一面简单太多

长亭科技

岗位:大模型

面试官挺和蔼的,整体偏向互相交流学习,没答出来的他还说没关系,这是个不断学习的过程。不是压力面真好!

面试内容偏向八股、基础知识,项目和论文问的少。

自我介绍

介绍Transformer

有哪些encoder-only、decoder-only、encoder-decoder结构

介绍BERT(项目、论文、实习里用的都是bert,没用过其他结构)

我目前的研究基本上用BERT+线性层之类的来做,问我LLM出现后分类任务会被取代吗?

BERT、GPT如何分词,有什么区别

常见的位置编码

BERT里的可学习参数矩阵来表示位置编码,对于长文本呢》超过这个长度怎么办?

Attention,为什么有Multi-head,作用是什么。BERT里head数是多少,我说bert-base是12,反问为啥是这个数,是基于啥算法得到的还是经验设计的,我猜测是通过实验观察得到

面试官偏向用GPT系列的decoder结构,对BERT这些记不太清了,所以一直在问这方面的内容,我也表示了确实主要用的还是BERT,但目前的大模型也确实都基于decoder架构来做。

介绍项目的收获与其中的难点。

具体想做算法哪方面,一开始没理解还以为是具体的NLP任务场景,我说都可以做,后来又追问,说是偏数据工程还是模型设计还是模型训练,我脑子一抽说了模型设计,面试官反问说模型设计现在基本上没什么可以改进的了,LLM都基本用decoder结构,然后我说这仨我都可以接受,主要是确实都能做啊,也没啥特别喜爱的QAQ 反问,主要业务场景(安全领域的大模型)、需要具备的技能(追踪最新的SOTA、读paper、理解能力、持续学习能力、动手能力、思考能力)

总体来说 还是一场体验感不错的面试,也没有任何刁难,不会的问题面试官也一直说没关系。像是互相在探讨学习的一个过程~

淘天

大模型(日常实习)

-

llama 7b 为什么比其他基座好,与gpt3比做了什么改进:数据上质量更高,结构上用的RoPE+SwiGLUE

-

GQA可以给训练加速吗

-

检索增强怎么做的

-

长度外推除了ROPE还有什么方法

-

Baichuan和chatglm2有什么不同,数据上,训练上,结构上

-

Visualglm图片怎么处理的:blip-qformer

-

Transformer结构,一层层讲

-

Visualbert什么结构

-

RLHF流程:一个actor,一个critic,一个reward model。将sft后的模型输出后生成回答,回答+答案输入RW得到分数(取最后一个token投影一下)

-

Reward model怎么训练的,损失函数是什么:

-

提示工程的fewshot有什么做法:聚类

-

Chatglm2与1有什么区别

-

Chatglm2对话权重不一样的原因:

-

为什么chatglm系列的用ptuning比lora好

-

Ptuning是怎么样做的大概讲讲:前面cocat可学习参数,多了一个MLP层,代码中在k,v矩阵中concat矩阵参数

-

Lora怎么做的?为什么只调q,v矩阵或者q矩阵?别人实验这样做不代表在你这个场景下这样做就是对的?

-

为什么模型都聚焦于decoder-only而不是encoder-only或者encoder-decoder:

-

Self-consistency是什么

太初

大模型算法

面试内容:

-

自我介绍

-

实习内容介绍

-

数据并行

-

ft框架

-

随机森林

-

gbdt

-

优化器了解哪些

-

bert和gpt

-

transformer结构

-

线上服务推理如何提高吞吐量

-

手撕:链表加法

(完)

附上技术清单

在这里,我们想要强调的是:成功求职并不是一件难事,关键在于你是否做好了充分的准备。通过学习和掌握AI技术的相关知识和技能,了解面试中可能出现的问题和技巧,你就能够在面试中展现出自己的专业素养和实力,赢得面试官的青睐和认可。因此,让我们一起努力,用知识和技能武装自己,迎接AI时代的挑战和机遇吧!

有需要的朋友可以扫描下方二维码,免费获取更多相关资料!

最后,祝愿所有转行、求职的同学都能够在AI产品面试中取得优异的成绩,找到心仪的工作!加油!

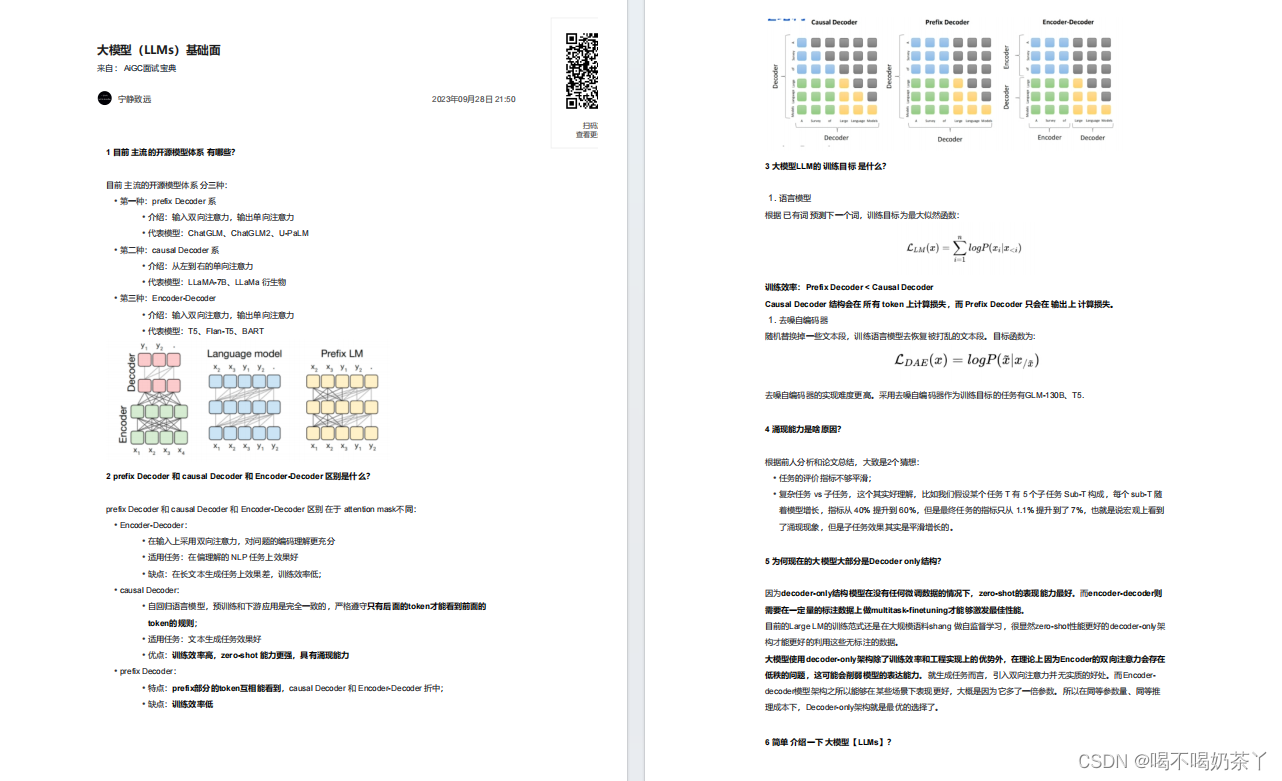

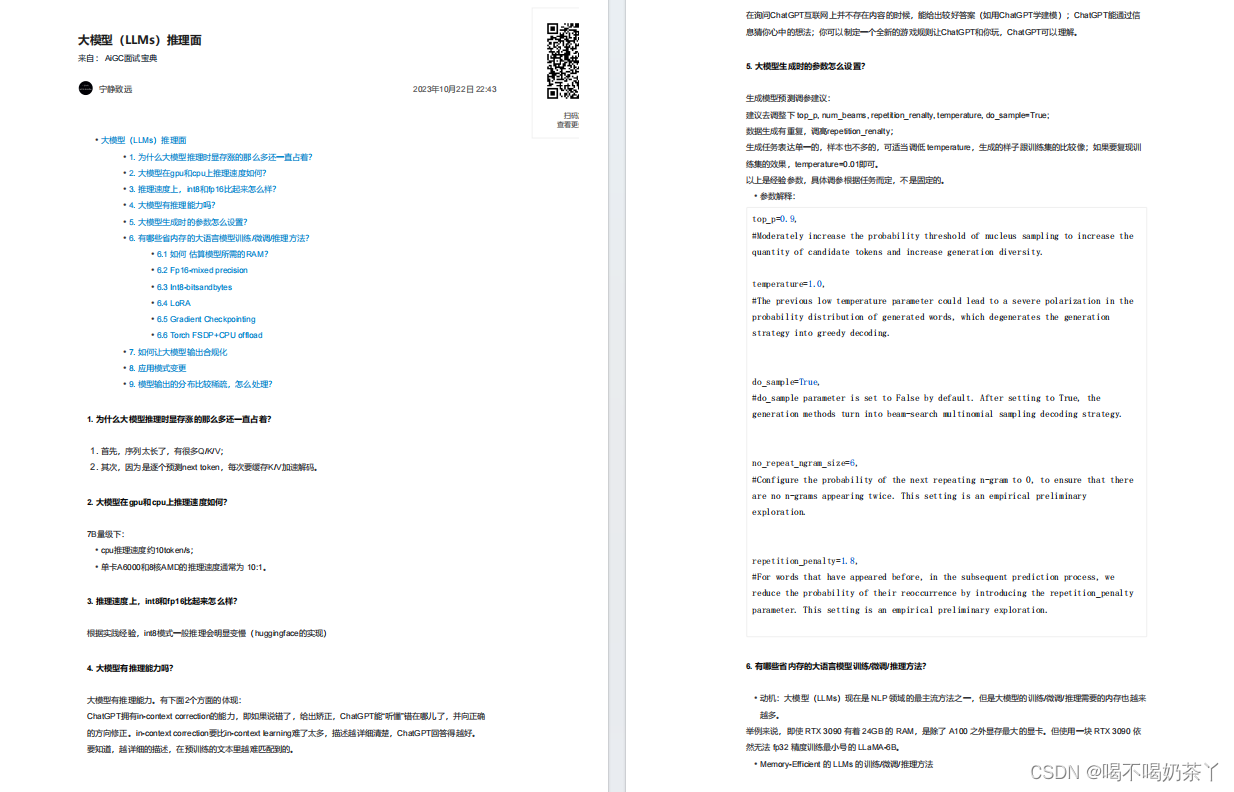

大模型基础面

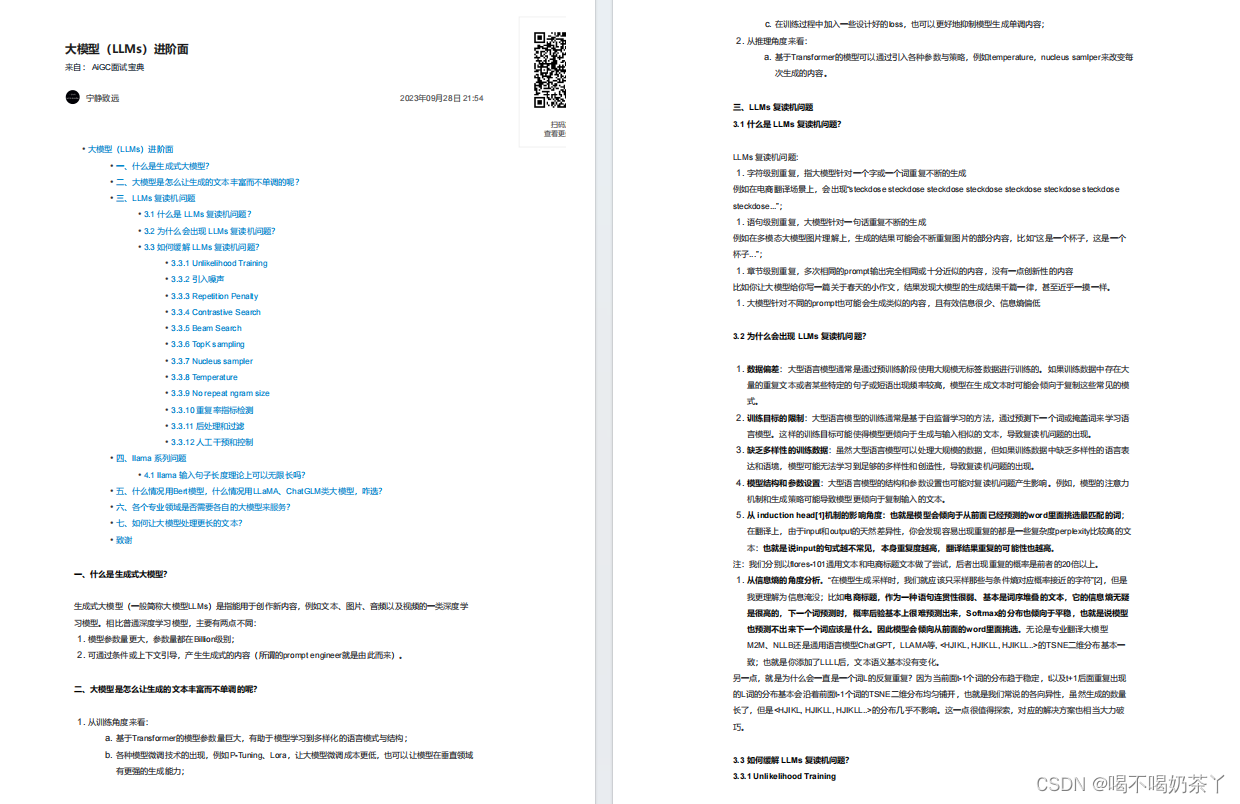

大模型进阶面

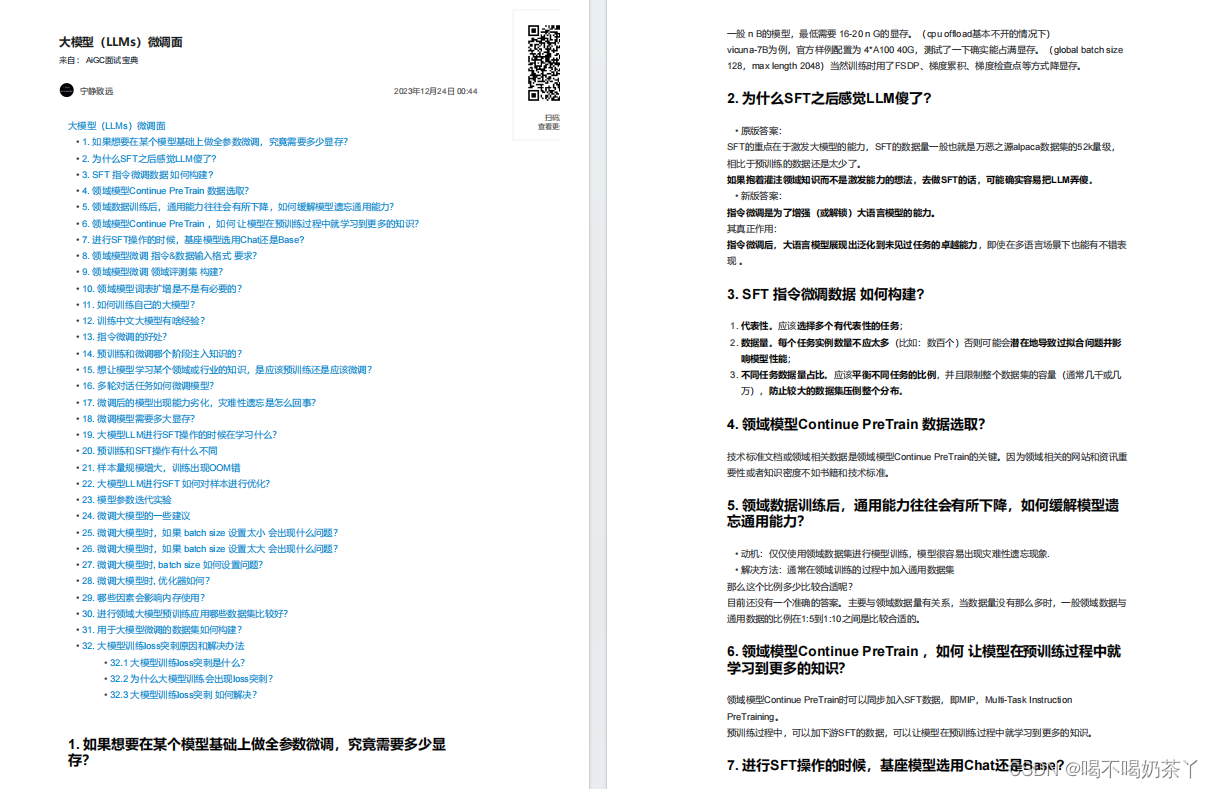

大模型微调面

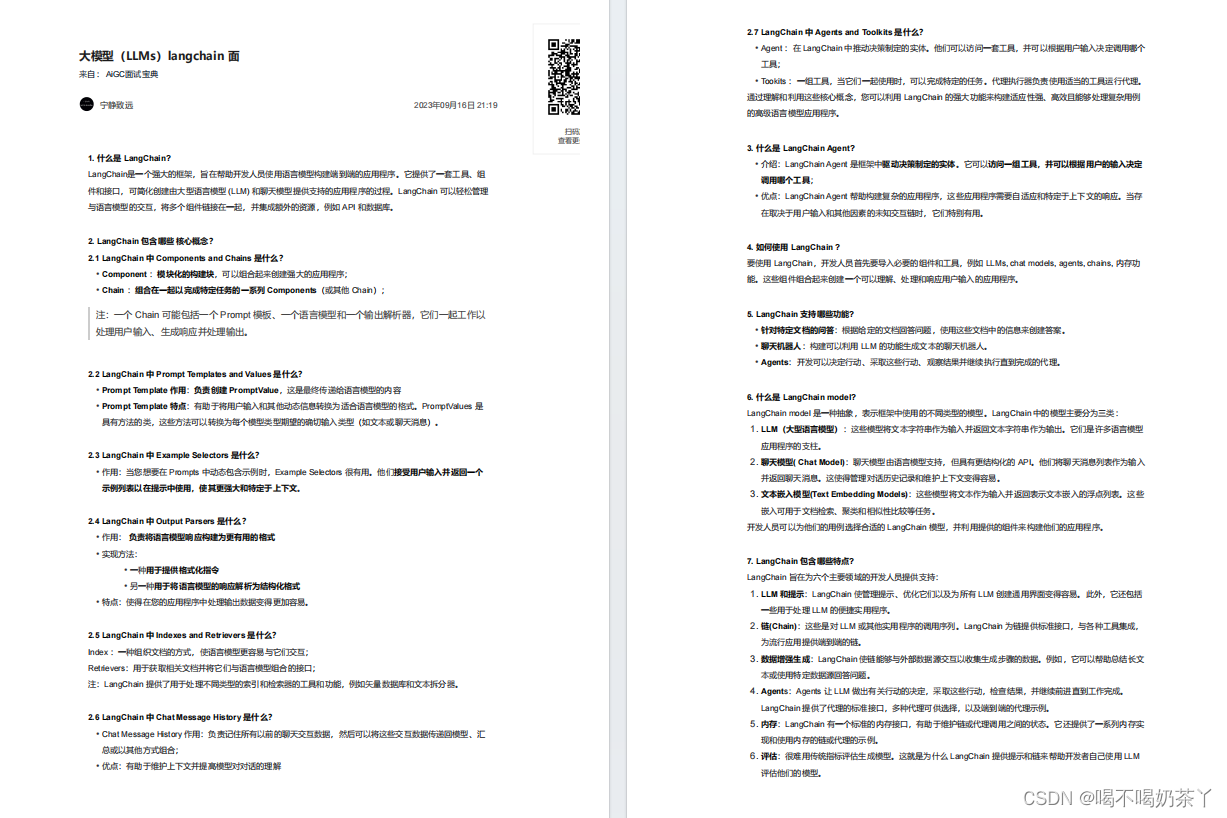

大模型langchain面

大模型推理面

更多面试题分享