- 1同济子豪兄笔记-随机游走-图嵌入表示学习_随机游走嵌入

- 2【SQL】Mysql中一条sql语句的执行过程

- 3动手学深度学习:机器翻译及相关技术,注意力机制与seq2seq模型,Transformer_以下对于加入attention机制的seq2seq模型的陈述正确的是( )。aseq2seq模型不

- 4python美化图形化界面设计,python的tkinter界面美化_tkinter美化

- 5Unity TextMeshPro使用中文字体_unity字体

- 6SystemVerilog中的断言(Assertion)_systemverilog断言

- 7【51单片机系列】74HC595实现对LED点阵的控制_点阵的内部结构

- 8Spark分布式计算期末复习_( )是spark的基本数据结构,基于内存的分布式存储序列,分区存储在worker中。

- 9winutils.exe-系统错误,由于找不到MSVCR120.dll,无法继续执行代码。重新安装程序可能会解决此问题。

- 10FPGA 常见的AXI总线介绍及应用_axi fpga 的

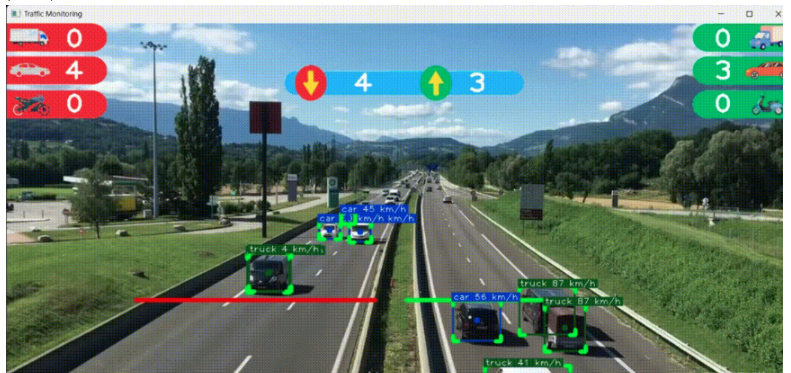

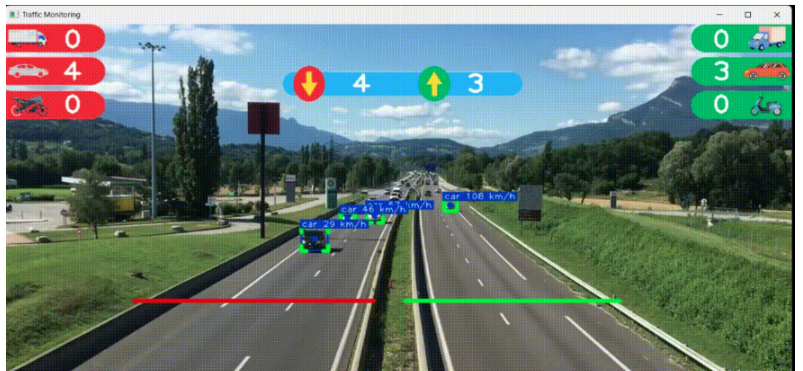

YOLOv8 DeepSORT实现智能交通监控-改进yolo单目测距及速度测量-流量计数_yolov8跟踪测距 单目测距

赞

踩

YOLOv8 DeepSORT是一种基于目标检测和跟踪技术的智能交通监控系统。它基于YOLOv8,通过加入DeepSORT算法实现目标跟踪,同时还改进了YOLOv8的单目测距及速度测量技术和流量计数功能。

该系统可以通过摄像头或视频源实时捕获图像,并自动检测和跟踪交通中的车辆、行人等目标。在检测到目标后,系统会根据目标在图像上的大小进行单目测距,推算出目标与摄像头之间的距离。同时,系统还可以根据目标的运动轨迹和时间间隔计算出目标的速度。这些测量数据可以为交通管理提供有用的参考信息。

此外,该系统还具备流量计数功能,能够统计通过某一区域的车辆数量和车流量,从而帮助交通管理部门更好地了解道路使用情况,并提高道路资源的利用效率。

基于PyTorch框架开发的YOLOv8 DeepSORT智能交通监控系统,具有良好的性能和可扩展性。它可以适用于各种交通场景,如城市道路监控、高速公路监管、机场航站楼监控等。

综上所述,YOLOv8 DeepSORT实现智能交通监控的改进版,新增了单目测距及速度测量和流量计数功能,可以为交通管理部门提供更多有用的信息。同时,该系统还具备良好的性能和可扩展性,是一种具有广泛应用前景的智能交通监控解决方案。

YOLOv8:目标检测算法详解

YOLO(You Only Look Once)系列是一种单阶段、实时的目标检测框架,其最新迭代版本YOLOv8继承并优化了前代YOLO在速度与精度上的优势。YOLOv8的核心思想在于将整幅图像一次性输入到神经网络中,直接输出边界框坐标以及类别概率。

主要模块与算法原理:

Backbone Network(骨干网络):YOLOv8通常会采用一种高效的卷积神经网络结构作为基础特征提取器,如CSPNet或改进后的ResNet等,用于从原始图像中提取多尺度特征图。

Spatial Pyramid Pooling (SPP) 或 Path Aggregation Network (PANet):通过引入空间金字塔池化层或多路径聚合网络设计来捕获不同尺寸目标的上下文信息,从而提高对小目标的检测能力。

Anchor Boxes(锚点框):YOLO模型预测一组预定义大小的矩形区域,并调整这些区域以适应实际物体的形状和大小,减少了需要预测的参数量。

Bounding Box Prediction(边界框预测):每个网格单元负责预测多个候选边界框,包括每个框的中心坐标、宽高及其对应的对象类别概率。

Objectness Score(目标性评分):为每个预测框分配一个置信度分数,表示框内包含对象的可能性以及预测框与真实对象匹配的程度。

Training Loss(训练损失函数):YOLOv8使用了一种结合定位误差、分类误差以及目标性得分的复合损失函数,比如IoU损失(GIOU, CIoU, 或DIoU),旨在更精确地拟合模型。

DeepSORT:多目标跟踪算法解析

DeepSORT是基于在线卡尔曼滤波(KF)和深度学习特征表示的多目标跟踪算法,它是基于最初的Simple Online and Realtime Tracking (SORT)算法而扩展的。

核心组件与工作流程:

Re-Identification (ReID) Features:DeepSORT利用来自深度神经网络的嵌入式特征描述符来实现跨帧之间的行人或车辆重识别,即使目标在视觉上被遮挡或远离相机也能保持追踪连续性。

Kalman Filter Prediction:每个目标都有一个关联的卡尔曼滤波器用于预测下一帧的位置,考虑到目标的速度和加速度变化,有效处理运动状态估计问题。

Distance Metric Learning:采用余弦相似度或其他距离度量方法比较当前帧的检测结果与已有目标的ReID特征,判断是否为同一对象。

Data Association:运用匈牙利算法解决数据关联问题,即将当前帧的检测框与已知目标进行最优匹配,同时处理新出现目标的初始化和消失目标的确认。

Tracking Management:对于长期未匹配的目标,系统会根据一定的阈值和逻辑判断是否结束对该目标的追踪,同时启动对新检测到目标的跟踪。

应用

当YOLOv8与DeepSORT相结合时,首先由YOLOv8快速准确地检测出视频帧中的所有交通对象,然后将这些检测结果传递给DeepSORT,后者通过计算每个检测框的ReID特征和运动状态,进而实现稳定的多目标跟踪。这一套完整的解决方案广泛应用于智能交通监控场景,不仅可以统计车流量,还能识别异常行为(例如越界)、分析行驶轨迹等,大大提升了道路交通管理系统的智能化水平。

单目测距与测速的结合

单目测距结合YOLOv8的方案:

详细可见我的单目测距介绍

在集成YOLOv8与单目测距算法时,具体流程可能如下:

利用YOLOv8实时检测出图像中的车辆或其他目标,并提取每个目标的边界框。

对每个检测到的目标,进一步分析其在图像中的像素坐标。

将上述信息输入到单目测距算法模型中,计算每个目标相对于相机的大概距离。

速度估计原理:

连续帧分析:在YOLOv8成功检测并追踪到目标后,记录下每个时间步长(即连续帧之间的时间间隔)内目标的位置变化。

位置变化计算:由于我们已知相机参数以及目标在图像上的坐标变化,结合之前提到的单目测距得到的目标与相机的实际距离变化。

速度推算:根据物理学的基本公式(速度 = 距离 /

时间),可以通过目标在真实世界中的位移差值除以对应的时间差值来估算其瞬时速度或平均速度。

- # 视频流处理循环

- for frame in video_stream:

- # 进行目标检测

- detections = detector.detect(frame)

-

- # 使用DeepSORT进行追踪并获取当前帧的目标位置

- tracks = tracker.update(detections)

-

- for track in tracks:

- # 获取目标在当前帧的世界坐标位置

- current_position_world = track.current_position_world

-

- # 如果前一帧的位置已知,则计算速度

- if track.previous_position_world is not None:

- # 计算位移

- displacement = current_position_world - track.previous_position_world

-

- # 计算时间差(这里假设为每秒25帧)

- time_interval = 1 / 25 # 单位:秒

-

- # 计算速度

- speed = np.linalg.norm(displacement) / time_interval # 单位:米/秒

-

- print(f"目标ID: {track.id}, 当前速度: {speed} 米/秒")

-

- # 更新上一帧的位置信息

- track.previous_position_world = current_position_world

结合YOLOv8及追踪算法的方案:

首先,使用YOLOv8检测并初始化目标追踪。

在连续帧中保持目标的身份一致性,并记录每帧目标的位置(基于图像坐标系转换为真实世界的三维坐标)。 利用单目测距算法实时更新目标的距离信息。

计算连续时刻两帧之间的目标位置变化,进而推算出目标的速度。

根据实际应用需求,可能需要对噪声数据进行平滑处理或采用更复杂的动态模型(如卡尔曼滤波)来优化速度估计精度。

代码运行

创建一个新的Python虚拟环境并使用pip管理依赖:

virtualenv venv --python=python3.10

激活新创建的虚拟环境:

source venv/bin/activate

安装项目所需的依赖包:

pip install -r requirements.txt

运行应用程序:

python trafficMonitor.py

以上指令是Linux或类Unix系统下的操作步骤。如果你在Windows环境下,激活虚拟环境的命令会稍有不同,应改为:

venv\Scripts\activate.bat

然后按照其他步骤进行操作即可。这些步骤首先创建了一个基于Python 3.10版本的虚拟环境,并在其内部安装了requirements.txt文件中列出的所有依赖项。

运行

python trafficMonitor.py。- 获取整套代码、测试视频、训练好的权重和说明文档(有偿)

- 中科大硕士,技术够硬,也可以指导深度学习毕设、大作业等。

- --------------->qq------------

- 767172261

- ------------------------------