热门标签

热门文章

- 1跟我学Python图像处理丨图像分类原理与案例_图像分类案例

- 2zabbix监控交换机_zabbix添加锐捷交换机

- 3双目项目实战---测距(获取三维坐标和深度信息)_双目相机求解三维坐标点

- 4微信小程序访问webservice(wsdl)+ axis2发布服务端(Java)

- 5chromedriver和selenium的下载以及安装教程(114/116/117.....121版本)_chromedriver 121

- 6Window系统命令行调用控制面板程序_programs|and|features

- 701-Node.js 简史_nodejs历史版本

- 8【STM32】FSMC—扩展外部 SRAM 初步使用 1_stm32 外接 ram

- 9python爬虫爬取淘宝商品并保存至mongodb数据库_tbsearch?refpid=mm_26632258_3504122_32554087

- 10OpenWrt 软路由IPv6 DDNS Socat 端口映射_openwrt socat

当前位置: article > 正文

【机器学习笔记】 6 机器学习库Scikit-learn

作者:盐析白兔 | 2024-02-18 01:03:00

赞

踩

【机器学习笔记】 6 机器学习库Scikit-learn

Scikit-learn概述

Scikit-learn是基于NumPy、 SciPy和 Matplotlib的开源Python机器学习包,它封装了一系列数据预处理、机器学习算法、模型选择等工具,是数据分析师首选的机器学习工具包。

自2007年发布以来,scikit-learn已经成为Python重要的机器学习库了,scikit-learn简称sklearn,支持包括分类,回归,降维和聚类四大机器学习算法。还包括了特征提取,数据处理和模型评估三大模块

Scikit-learn 主要用法

符号标记

基本建模流程

- 导入工具包

from sklearn import datasets, preprocessing

from sklearn.model_selection import train_test_split

from sklearn.linear_model import LinearRegression

from sklearn.metrics import r2_score

- 1

- 2

- 3

- 4

- 加载数据

✓Scikit-learn支持以NumPy的arrays对象、Pandas对象、SciPy的稀疏矩阵及其他可转换为数值型arrays的数据结构作为其输入,前提是数据必须是数值型的

✓sklearn.datasets模块提供了一系列加载和获取著名数据集如鸢尾花、波士顿房价、Olivetti人脸、MNIST数据集等的工具,也包括了一些toy data如S型数据等的生成工具

from sklearn.datasets import load_iris

iris = load_iris()

X = iris.data

y = iris.target

- 1

- 2

- 3

- 4

- 数据划分

将完整数据集的70%作为训练集,30%作为测试集,并使得测试集和训练集中各类别数据的比例与原始数据集比例一致(stratify分层策略),另外可通过设置 shuffle=True 提前打乱数据

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, y, random_state=12, stratify=y, test_size=0.3)

- 1

- 2

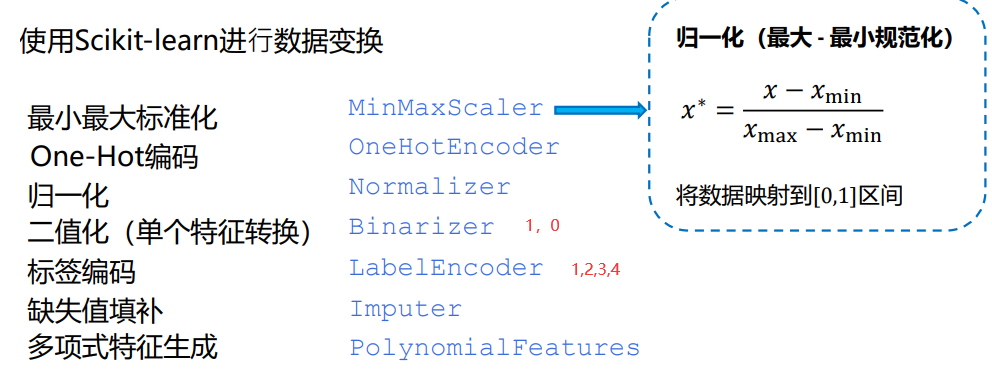

- 数据预处理

#使⽤Scikit-learn进⾏数据标准化

from sklearn.preprocessing import StandardScaler

#构建转换器实例

scaler = StandardScaler()

#拟合及转换

scaler.fit_transform(X_train)

- 1

- 2

- 3

- 4

- 5

- 6

- 特征选择

from sklearn import feature_selection as fs

fs.SelectKBest(score_func, k)

#过滤式(Filter),保留得分排名前k的特征(top k方式)

fs.RFECV(estimator, scoring=“r2”)

#封装式(Wrap- per),结合交叉验证的递归特征消除法,自动选择最优特征个数

fs.SelectFromModel(estimator)

#嵌入式(Embedded),从 模型中自动选择特征,任何具有coef_或者feature_importances_的 基模型都可以作为estimator参数传入

- 1

- 2

- 3

- 4

- 5

- 6

- 7

监督学习算法

- 回归

from sklearn.linear_model import LinearRegression

#构建模型实例

lr = LinearRegression(normalize=True)

训练模型

lr.fit(X_train, y_train)

#作出预测

y_pred = lr.predict(X_test)

#LASSO linear_model.Lasso

#Ridge linear_model.Ridge

#ElasticNet linear_model.ElasticNet

#回归树 tree.DecisionTreeRegressor

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 分类

from sklearn.tree import DecisionTreeClassifier

clf = DecisionTreeClassifier(max_depth=5)

clf.fit(X_train, y_train)

y_pred = clf.predict(X_test)

y_prob = clf.predict_proba(X_test)

- 1

- 2

- 3

- 4

- 5

使用决策树分类算法解决二分类问题, y_prob 为每个样本预测为“0”和“1”类的概率

逻辑回归 linear_model.LogisticRegression

支持向量机 svm.SVC

朴素贝叶斯 naive_bayes.GaussianNB

K近邻 neighbors.NearestNeighbors

- 集成学习

sklearn.ensemble模块包含了一系列基于集成思想的分类、回归和离群值检测方法.

from sklearn.ensemble import RandomForestClassifier

clf = RandomForestClassifier(n_estimators=20)

clf.fit(X_train, y_train)

y_pred = clf.predict(X_test)

y_prob = clf.predict_proba(X_test)

- 1

- 2

- 3

- 4

- 5

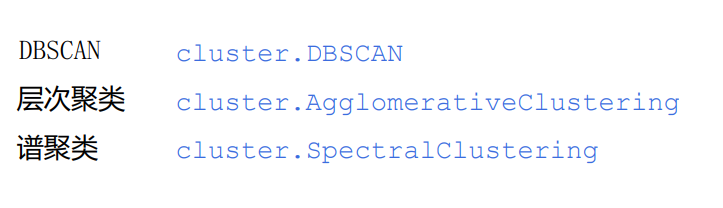

无监督学习算法

- sklearn.cluster模块包含了一系列无监督聚类算法.

from sklearn.cluster import KMeans

#构建聚类实例

kmeans = KMeans(n_clusters=3, random_state=0)

#拟合

kmeans.fit(X_train)

#预测

kmeans.predict(X_test)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- sklearn.decomposition 模块包含了一系列无监督降维算法

from sklearn.decomposition import PCA

#导入PCA库,设置主成分数量为3,n_components代表主成分数量

pca = PCA(n_components=3)

#训练模型

pca.fit(X)

#投影后各个特征维度的方差比例(这里是三个主成分)

print(pca.explained_variance_ratio_)

#投影后的特征维度的方差

print(pca.explained_variance_)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

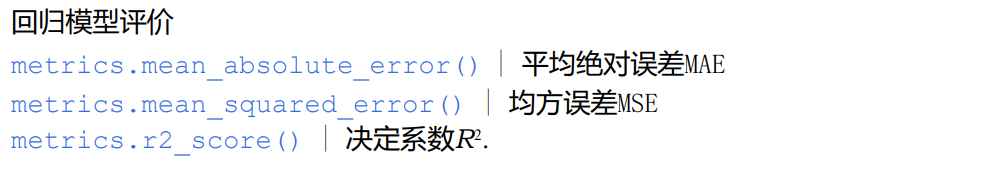

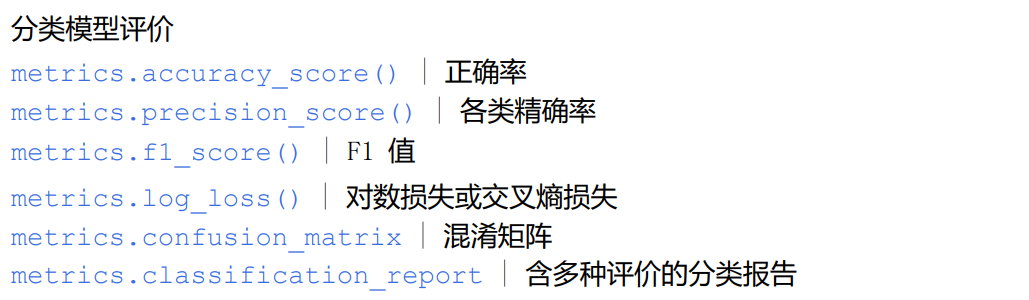

评价指标

sklearn.metrics模块包含了一系列用于评价模型的评分函数、损失函数以及成对数据的距离度量函数.

from sklearn.metrics import accuracy_score

accuracy_score(y_true, y_pred)

#对于测试集而言,y_test即是y_true,大部分函数都必须包含真实值y_true和预测值y_pred

- 1

- 2

- 3

交叉验证及参数调优

sklearn提供了部分带交叉验证功能的模型类如LassoCV、LogisticRegressionCV等,这些类包含cv参数

from sklearn.model_selection import cross_val_score

clf = DecisionTreeClassifier(max_depth=5)

scores = cross_val_score(clf, X_train, y_train, cv=5, scoring=’f1_weighted’)

#使用5折交叉验证对决策树模型进行评估,使用的评分函数为F1值

- 1

- 2

- 3

- 4

#超参数调优⸺网格搜索 from sklearn.model_selection import GridSearchCV from sklearn import svm svc = svm.SVC() params = {‘kernel’:[‘linear’, ‘rbf’], ‘C’:[1, 10]} grid_search = GridSearchCV(svc, params, cv=5) grid_search.fit(X_train, y_train) grid_search.best_params_ #在参数网格上进行穷举搜索,方法简单但是搜索速度慢(超参数较多时),且不容易找到参数空间中的局部最 #超参数调优⸺随机搜索 from sklearn.model_selection import RandomizedSearchCV from scipy.stats import randint svc = svm.SVC() param_dist = {‘kernel’:[‘linear’, ‘rbf’], ‘C’:randint(1, 20)} random_search = RandomizedSearchCV(svc, param_dist, n_iter=10) random_search.fit(X_train, y_train) random_search.best_params_ #在参数子空间中进行随机搜索,选取空间中的100个点进行建模(可从scipy.stats常见分布如正态分布norm、均匀分布uniform中随机采样得到),时间耗费较少,更容易找到局部最优

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/盐析白兔/article/detail/103095

推荐阅读

相关标签