热门标签

热门文章

- 1【LeetCode】螺旋矩阵&&旋转图像_ctf 图片 螺旋矩阵

- 2PreconditionNotMetError: The third-party dynamic library (libcublas.so) that Paddle depends on is no

- 3FastDFS 分布式文件系统 搭建部署

- 4如何写出高质量的Prompt

- 5【华为OD机试真题 C语言】机器人走迷宫_机器人走迷宫问题

- 6华为OD机考题目(自动化测试)_华为软件测试机考题

- 7全国计算机等级考试-Python_python考试

- 8springboot jar包启动访问jar包外的静态文件_springbootjar包外部静态资源

- 9最新信息安全毕业设计题目选题推荐_信安毕业设计选什么题目好

- 10python echo服务器_基于python的一个多线程echo服务器

当前位置: article > 正文

Expected all tensors to be on the same device, but found at least two devices, cuda:0 and cpu!

作者:盐析白兔 | 2024-02-27 02:57:46

赞

踩

expected all tensors to be on the same device, but found at least two device

问题描述:

这类问题属于tensor关于内存的问题,就是说进行运算的tensor放在了不同的设备上。

注意,也有其他的错误表达:

Input type (torch.FloatTensor) and weight type (torch.cuda.FloatTensor)

上述表面意思是:输入类型属于在CPU上,而权重类型属于在GPU上。

解决方案:

就一句话,跟踪步骤指定设备。

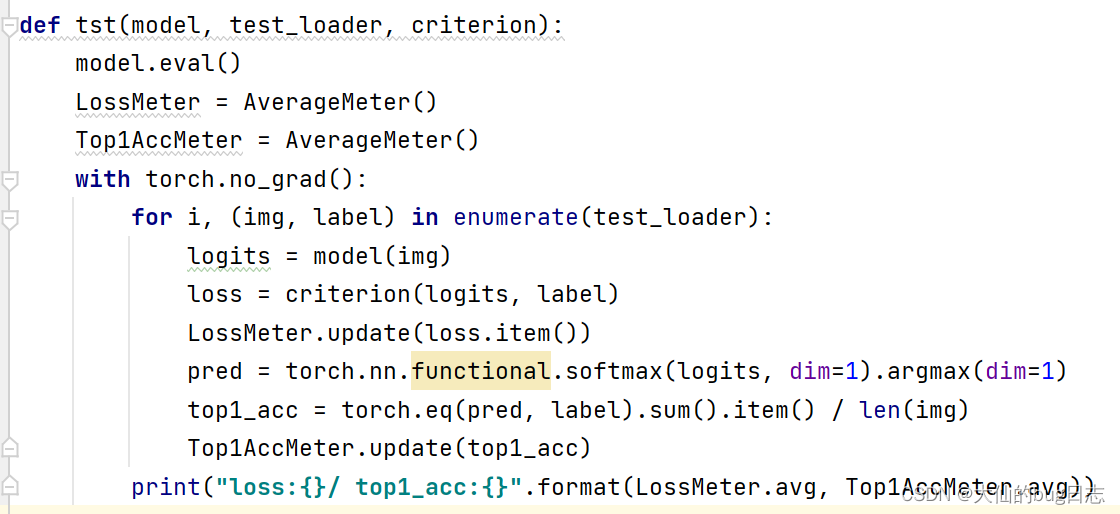

比如现在我有一块代码:

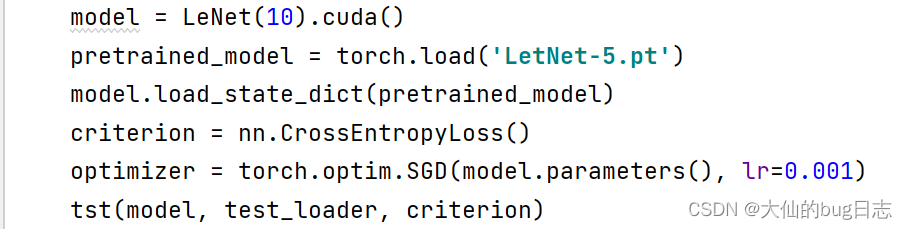

main函数部分:

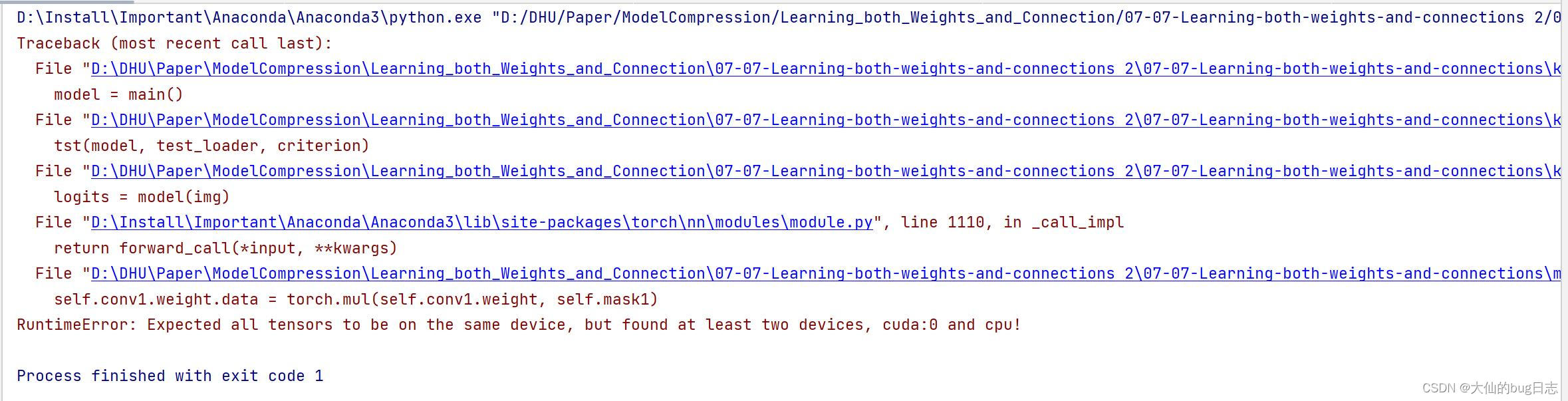

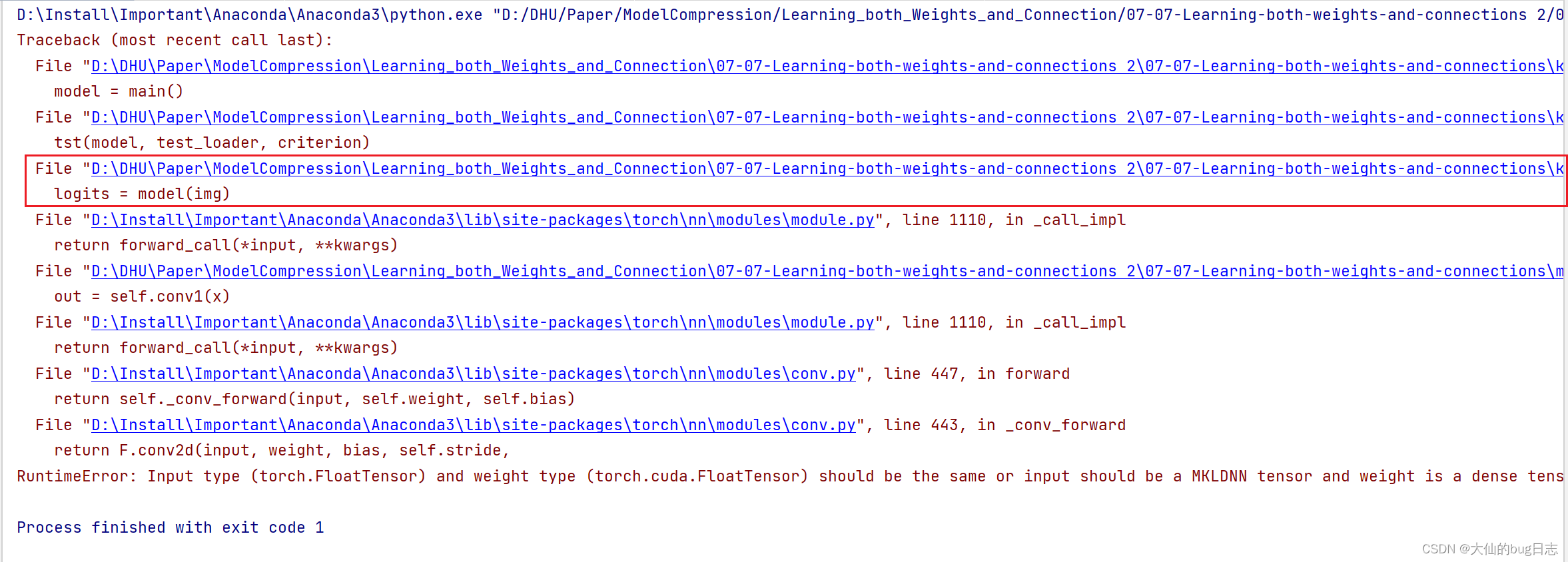

运行报错:

我先在代码最上方加一句:

device = torch.device('cuda:0' if torch.cuda.is_available() else 'cpu')然后怎么跟踪步骤呢?在红框位置单击:

你肯定会问为什么是这里?首先红框底下都是底层运算,先不会考虑这里的运算涉及到不同的设备(麻烦),而上面是先跳到main(),再到tst这个函数里面,运行到logits=model(img)这里出现的问题。

点击,修改输入参数img到GPU设备上,即

logits = model(img.to(device))再运行,报错位置变了,说明上个位置问题解决了,但仍然报错如下:

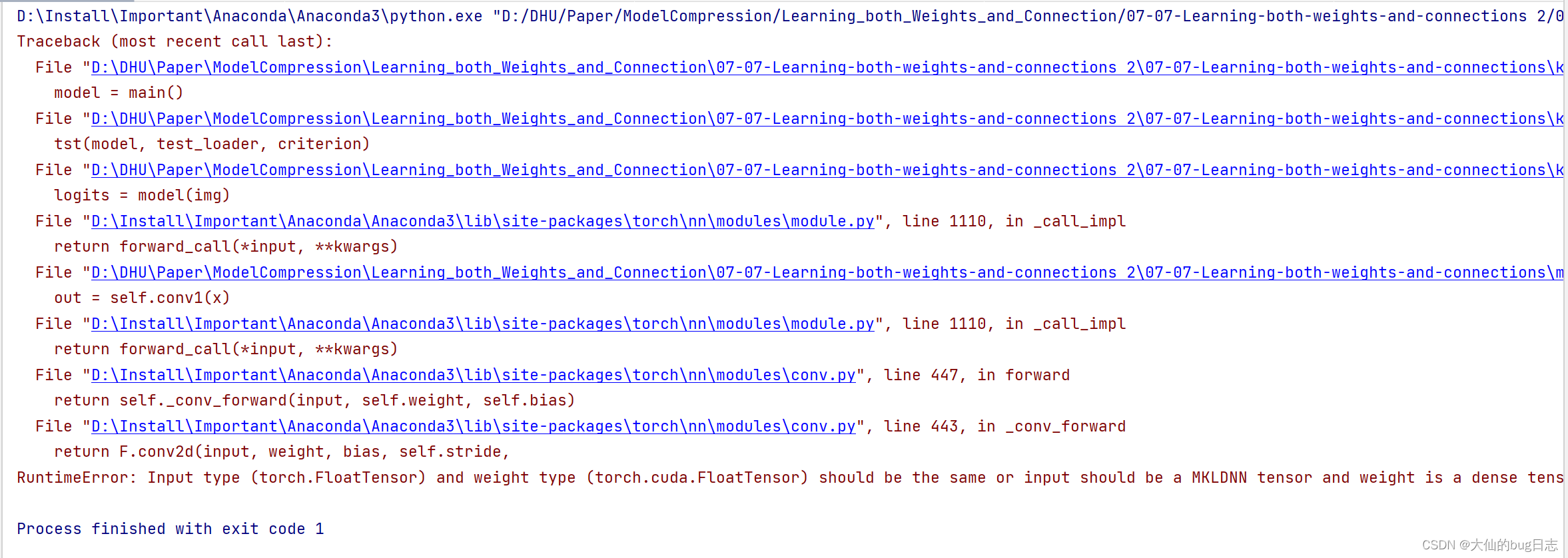

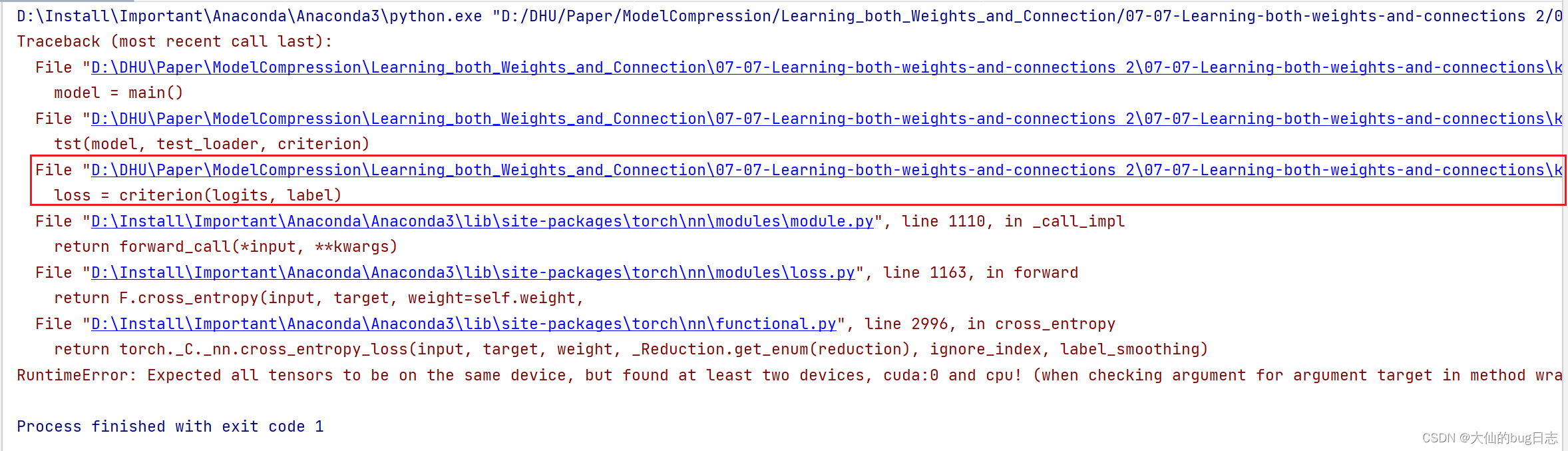

点击红框位置,原因类似上面,修改这一行代码为:

loss = criterion(logits, label.to(device))注意,这里前面的logits已经是to(device)的结果,不用再to(device)

再运行,报错位置又变了,但仍然报错如下:

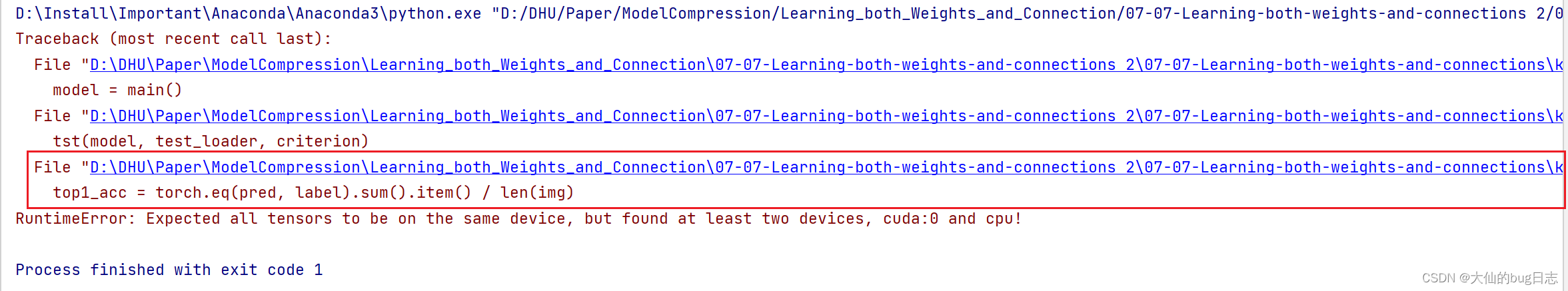

应该不用我讲了,直接点击红框位置,修改代码如下:

top1_acc = torch.eq(pred, label.to(device)).sum().item() / len(img)这里加to(device)的位置有点难,但是大家记住原始的问题,是输入不在device(GPU)上,所以我们需要修改的是输入(函数的参数)让其to(device)。

然后,再运行,成功。

总结:

看代码报错信息和位置(读错误真的很重要),一步步找device不同的代码修改。遇到类似的问题才能举一反三。

希望对你有帮助。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/盐析白兔/article/detail/149480

推荐阅读

相关标签