- 1winfrom软件开发汽车测试_从事汽车电子软件开发岗,我们最近还没那么愁

- 2js:Set集合的实现_js实现set

- 3我,32岁,动力机械专业研究生,转行到算法工程师,完成薪资翻倍_开发转算法工程师

- 4lstm与bp神经网络——时序数据预测_时序数据 神经网络预测

- 5linux内核audit,linux中audit审计服务

- 6问题 D: DS B-树构建及查找_在初始为空的m阶b-树中依次插入n个结点,按层次遍历输出关键字,然后再查找m个关键

- 7docker es持久化_如何用最简短的话讲清楚Docker的全貌?

- 8优质论文list(分布式系统/存储/索引相关)_论文list包括什么

- 9华为OD机试 - 悄悄话(Python、Java、C++、Javascript)_java 悄悄话 od

- 10一款轻量级写作神器Typora

【KNN】K近邻分类算法(k-Neighbour)_knn.kneighbors

赞

踩

参考:https://blog.csdn.net/weixin_45014385/article/details/123618841

https://blog.csdn.net/weixin_45014385/article/details/123619428

1.KNN含义

注意KNN算法是有监督学习中的分类算法,它看起来和另一个机器学习算法Kmeans有点像(Kmeans是无监督学习算法),但却是有本质区别的。那么什么是KNN算法呢,接下来我们就来介绍介绍吧。

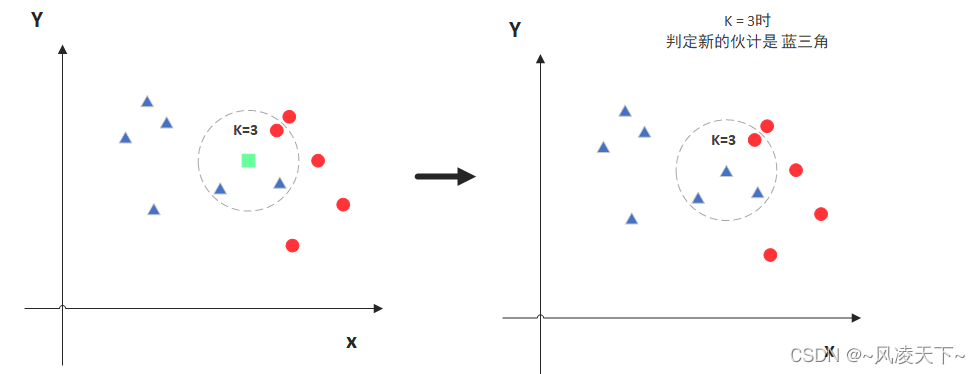

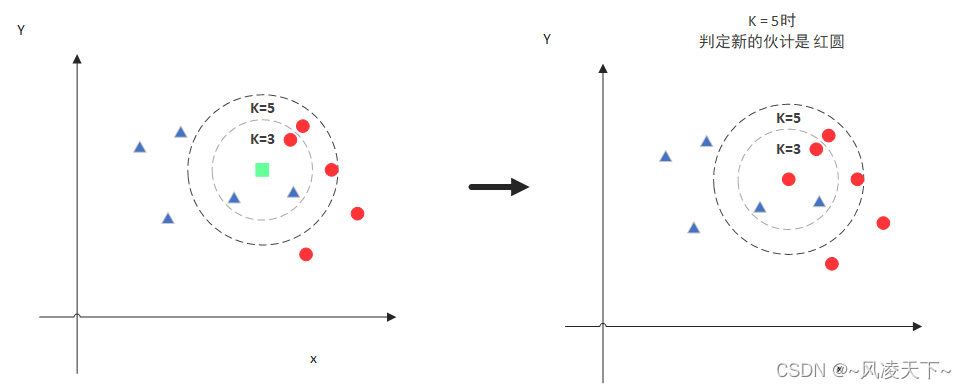

KNN的全称是K Nearest Neighbors,意思是K个最近的邻居,从这个名字我们就能看出一些KNN算法的蛛丝马迹了。K个最近邻居,毫无疑问,K的取值肯定是至关重要的。那么最近的邻居又是怎么回事呢?其实啊,KNN的原理就是当预测一个新的值x的时候,根据它距离最近的K个点是什么类别来判断x属于哪个类别。听起来有点绕,还是看看图吧。

图中绿色的点就是我们要预测的那个点,假设K=3。那么KNN算法就会找到与它距离最近的三个点(这里用圆圈把它圈起来了),看看哪种类别多一些,比如这个例子中是蓝色三角形多一些,新来的绿色点就归类到蓝三角了。

但是,当K=5的时候,判定就变成不一样了。这次变成红圆多一些,所以新来的绿点被归类成红圆。从这个例子中,我们就能看得出K的取值是很重要的。

明白了大概原理后,我们就来说一说细节的东西吧,主要有两个,K值的选取和点距离的计算。

2.KNN代码实现

def KNeighborsClassifier(n_neighbors = 5,

weights='uniform',

algorithm = '',

leaf_size = '30',

p = 2,

metric = 'minkowski',

metric_params = None,

n_jobs = None

)

- n_neighbors:这个值就是指 KNN 中的 “K”了。前面说到过,通过调整 K 值,算法会有不同的效果。

- weights(权重):最普遍的 KNN 算法无论距离如何,权重都一样,但有时候我们想搞点特殊化,比如距离更近的点让它更加重要。这时候就需要 weight 这个参数了,这个参数有三个可选参数的值,决定了如何分配权重。参数选项如下:

• 'uniform':不管远近权重都一样,就是最普通的 KNN 算法的形式。

• 'distance':权重和距离成反比,距离预测目标越近具有越高的权重。

• 自定义函数:自定义一个函数,根据输入的坐标值返回对应的权重,达到自定义权重的目的。

- algorithm:在 sklearn 中,要构建 KNN 模型有三种构建方式,1. 暴力法,就是直接计算距离存储比较的那种放松。2. 使用 kd 树构建 KNN 模型 3. 使用球树构建。 其中暴力法适合数据较小的方式,否则效率会比较低。如果数据量比较大一般会选择用 KD 树构建 KNN 模型,而当 KD 树也比较慢的时候,则可以试试球树来构建 KNN。参数选项如下:

• 'brute' :蛮力实现

• 'kd_tree':KD 树实现 KNN

• 'ball_tree':球树实现 KNN

• 'auto': 默认参数,自动选择合适的方法构建模型

不过当数据较小或比较稀疏时,无论选择哪个最后都会使用 'brute'

- leaf_size:如果是选择蛮力实现,那么这个值是可以忽略的,当使用KD树或球树,它就是是停止建子树的叶子节点数量的阈值。默认30,但如果数据量增多这个参数需要增大,否则速度过慢不说,还容易过拟合。

- p:和metric结合使用的,当metric参数是"minkowski"的时候,p=1为曼哈顿距离, p=2为欧式距离。默认为p=2。

- metric:指定距离度量方法,一般都是使用欧式距离。

• 'euclidean' :欧式距离

• 'manhattan':曼哈顿距离

• 'chebyshev':切比雪夫距离

• 'minkowski': 闵可夫斯基距离,默认参数

- n_jobs:指定多少个CPU进行运算,默认是-1,也就是全部都算。

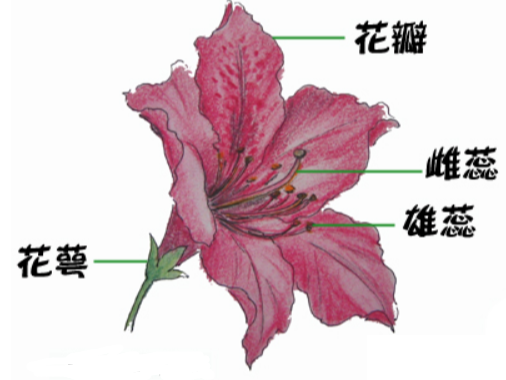

数据集使用的是著名的鸢尾花数据集,用KNN来对它做分类。我们先看看鸢尾花长的啥样。

上面这个就是鸢尾花了,这个鸢尾花数据集主要包含了鸢尾花的花萼长度,花萼宽度,花瓣长度,花瓣宽度4个属性(特征),以及鸢尾花卉属于『Setosa,Versicolour,Virginica』三个种类中的哪一类(这三种都长什么样我也不知道)。

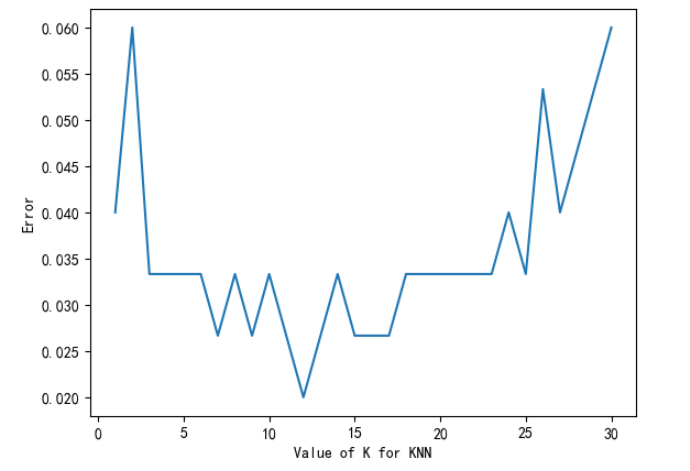

在使用KNN算法之前,我们要先决定K的值是多少,要选出最优的K值,可以使用sklearn中的交叉验证方法,代码如下:

- from sklearn.datasets import load_iris

- from sklearn.model_selection import cross_val_score

- import matplotlib.pyplot as plt

- from sklearn.neighbors import KNeighborsClassifier

-

- #读取鸢尾花数据集

- iris = load_iris()

- x = iris.data

- y = iris.target

- k_range = range(1, 31)

- k_error = []

- #循环,取k=1到k=31,查看误差效果

- for k in k_range:

- knn = KNeighborsClassifier(n_neighbors=k)

- #cv参数决定数据集划分比例,这里是按照5:1划分训练集和测试集

- scores = cross_val_score(knn, x, y, cv=6, scoring='accuracy')

- k_error.append(1 - scores.mean())

-

- #画图,x轴为k值,y值为误差值

- plt.plot(k_range, k_error)

- plt.xlabel('Value of K for KNN')

- plt.ylabel('Error')

- plt.show()

运行后,我们可以得到下面这样的图:

有了这张图,我们就能明显看出K值取多少的时候误差最小,这里明显是K=11最好。当然在实际问题中,如果数据集比较大,那为减少训练时间,K的取值范围可以缩小。