- 1【精选优质人物美图 InsCode Stable Diffusion 美图活动一期】自测使用Inscode-AI绘图模型生成精美图片详细教程(无需任何配置,小白也能立马运行)_算力模型图片生成器

- 2Python使用matplotlib画图后,导出高清图像方法_python绘制的图片如何高清图片保存

- 3Error connecting to node localhost.localdomain:9092 (id: 2147483647 rack: null)_kafka error connecting to node

- 4Gaussian Splatting SLAM 学习笔记——初识3DGS和代码review

- 5对于Fooocus内置style的一些理解和感受_fooocus 提示词

- 6预测算法——指数平滑法_二次指数平滑法例题及答案

- 7list模拟实现【C++】

- 8dom4j从1.x升级到2.x_dom4j版本

- 9Git报错“fatal: refusing to merge unrelated histories”处理方案

- 10大多数项目经理,都没有真正的领导力_大项目经理

论文精讲 | 基于昇思MindSpore梯度差异最小化的联邦多源领域泛化_multi-source collaborative gradient discrepancy mi

赞

踩

论文标题

Multi-Source Collaborative Gradient Discrepancy Minimization for Federated Domain Generalization

论文来源

AAAI 2024

论文链接

https://www.researchgate.net/publication/377162689_Multi-Source_Collaborative_Gradient_Discrepancy_Minimization_for_Federated_Domain_Generalization

代码链接

https://github.com/weiyikang/FedGM

昇思MindSpore社区支持顶级会议论文研究,持续构建原创AI成果。本文是昇思MindSpore AI顶会论文系列第35篇,来自天津大学智能与计算学部的韩亚洪老师团队发表于AAAI 2024的一篇论文解读,感谢各位专家教授同学的投稿,更多精彩的论文精读文章和开源代码实现请访问Models。

01 研究背景

深度学习的成功通常要求训练集与测试集的数据服从独立同分布假设,以便使训练的模型可应用于测试环境。然而在模型的实际部署中通常难以提前预知测试环境中的数据分布,比如由于采集数据时天气、环境的变化等导致测试数据与训练数据存在领域差异。这种领域差异问题使模型在部署的环境中性能急剧下降。

为了解决领域差异问题,传统的领域自适应或者领域泛化方法同时利用源域与目标域或者多个源域执行领域对齐,以减小源域与目标域数据在隐空间中的分布差异,提升模型在目标域上的性能。然而由于隐私保护限制,不同机构的数据难以汇聚为一个数据中心。这种数据去中心化的场景给传统的领域自适应与领域泛化方法带来了巨大的挑战。

本文旨在解决模型在不同端上部署(数据去中心化)场景下的领域差异问题。针对数据去中心化的挑战,本文利用联邦学习协同地训练多个去中心化的源域,实现数据的可用不可见。此外,针对目标域不可见的场景,即联邦多源领域泛化问题,为了学习可泛化的模型用于新场景适配,本文提出通过减小梯度差异来学习域不变模型,以便模型可泛化至不可见的目标域。针对无标签目标域存在的场景,即联邦多源领域自适应问题,本文利用可泛化的源域模型生成伪标签用于目标域模型的微调,以便使模型适应目标域的数据分布。

论文基于昇思MindSpore框架进行开发和实验,在领域泛化数据集PACS、Office-Home、VLCS与领域自适应数据集Digits-5、Office-Caltech10、Office31上的实验结果及分析验证了所提出的解决方案的有效性。

02 团队介绍

论文第一作者魏义康目前就读于天津大学智能与计算学部(2020-至今),博士研究生,主要研究方向包括联邦学习、领域自适应、领域泛化等,导师为韩亚洪教授。

论文通讯作者韩亚洪是天津大学智能与计算学部教授,博士生导师,研究方向为多媒体分析、计算机视觉和机器学习。2012年3月博士毕业于浙江大学计算机学院,博士毕业被天津大学直接聘为副教授,2016年在天津大学破格晋升正教授,2021年被聘为天津大学“英才教授”(长聘系列);曾获得计算机学会(CCF)优秀博士学位论文奖,入选教育部新世纪优秀人才支持计划,加州大学伯克利分校统计系访问学者;获得ACM Multimedia 2017“最佳论文提名奖”和“技术竞赛奖”、ICCV 2017“视频问答LSMDC Challenge”第一名;指导博士生获得2021年度“中国图象图形学学会优秀博士学位论文奖”;近年来,在跨媒体内容理解与推理、对抗视觉和对抗鲁棒性等领域发表TPAMI等权威期刊和NeurIPS等顶级学术会议论文近50篇,承担国家重点研发、自然基金重点、科技创新特区和基础加强等项目课题的研究任务。

03 论文简介

3.1 问题设定

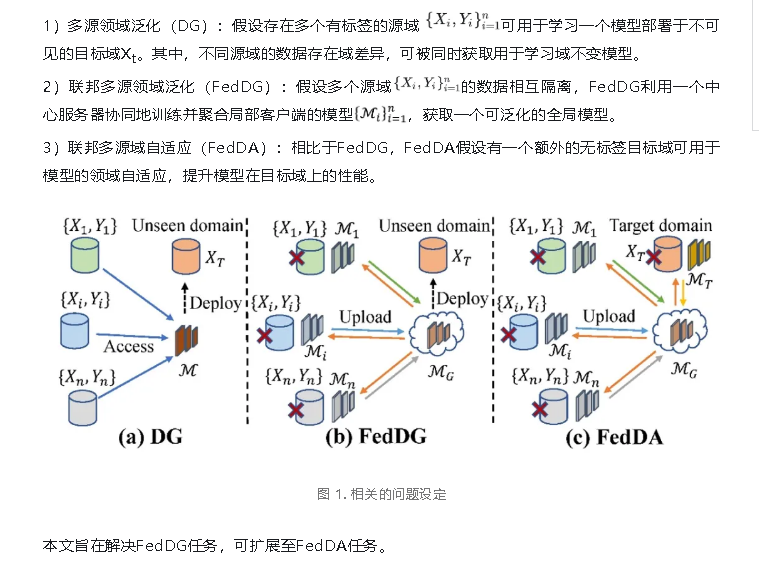

基于前述的研究背景分析,本文提出基于梯度差异最小化的联邦多源领域泛化方法,用于解决数据去中心化场景下的多源领域泛化问题,同时可扩展至联邦多源领域自适应任务。

如图 1所示,与本文相关的问题设定描述如下:

3.2 提出的方法

针对开放场景中目标域数据在训练阶段不可见,同时由于隐私保护限制多个源域数据不可汇聚的挑战,本文提出一种基于梯度差异最小化的联邦多源领域泛化,以便提升模型在未知分布的跨媒体数据上的泛化能力。

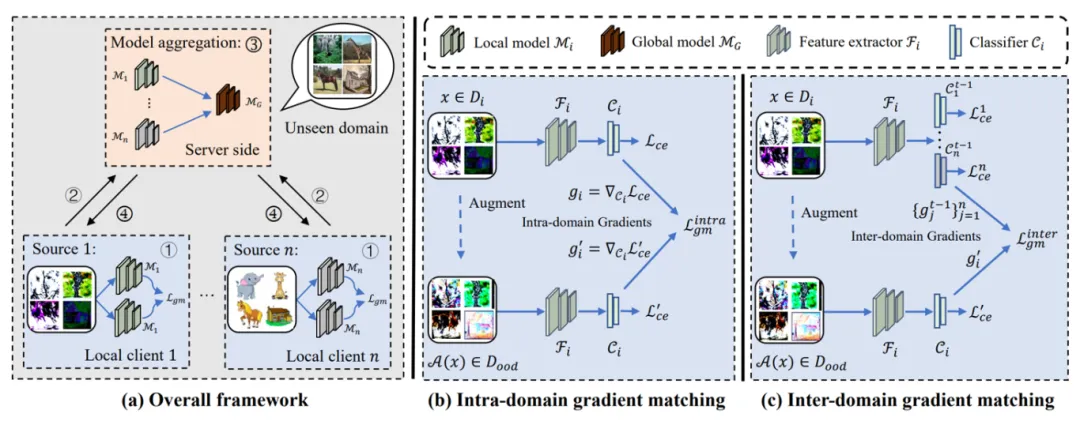

图 2. 基于梯度差异最小化的联邦多源领域泛化

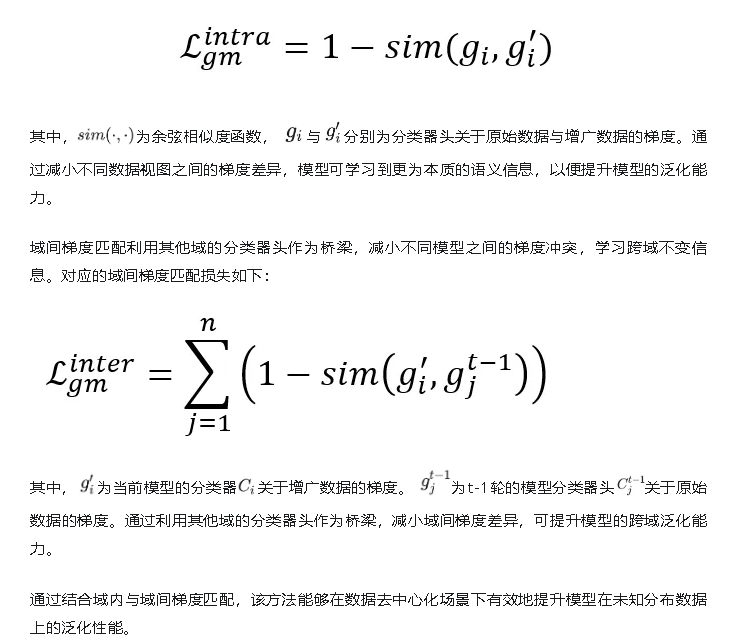

观察到不同域数据之间的梯度冲突作为一种重要的信息反映了模型朝向域特定方向更新,因此提出梯度差异最小化以便学习域不变模型。如图2所示,针对去中心化的源域,本工作分别提出域内梯度匹配与域间梯度匹配以提升模型的泛化能力。

其中域内梯度匹配减小原始数据与增广数据之间的梯度冲突,学习本质的语义信息。对应的域内梯度匹配损失如下:

同时目标域存在时,该方法也可通过在目标域上微调模型实现性能的进一步提升,扩展至联邦多源域自适应场景。具体的,对于无标签的目标域,本方法利用多个可泛化的源域模型来产生更准确的伪标签用于目标域模型的训练,进而提升模型在目标域上的领域自适应能力。

04 实验结果

4.1 联邦多源领域泛化任务上的实验结果对比

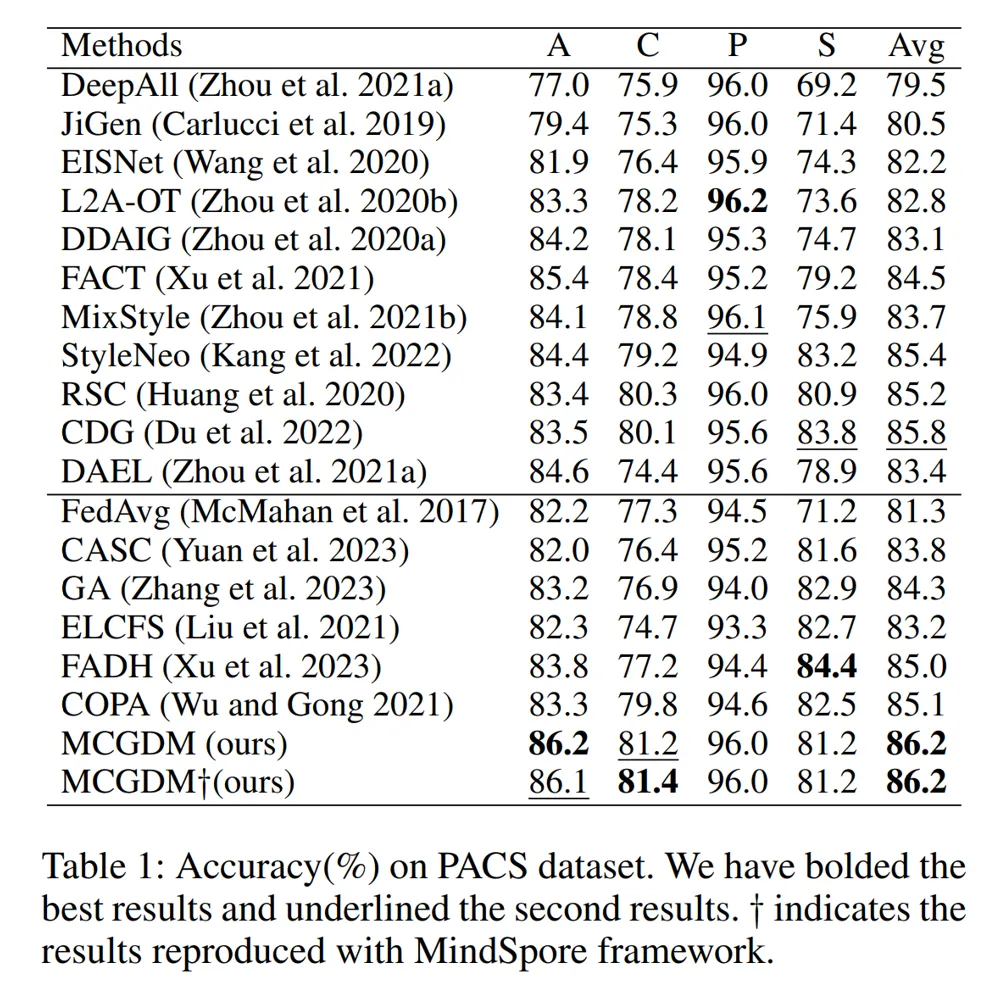

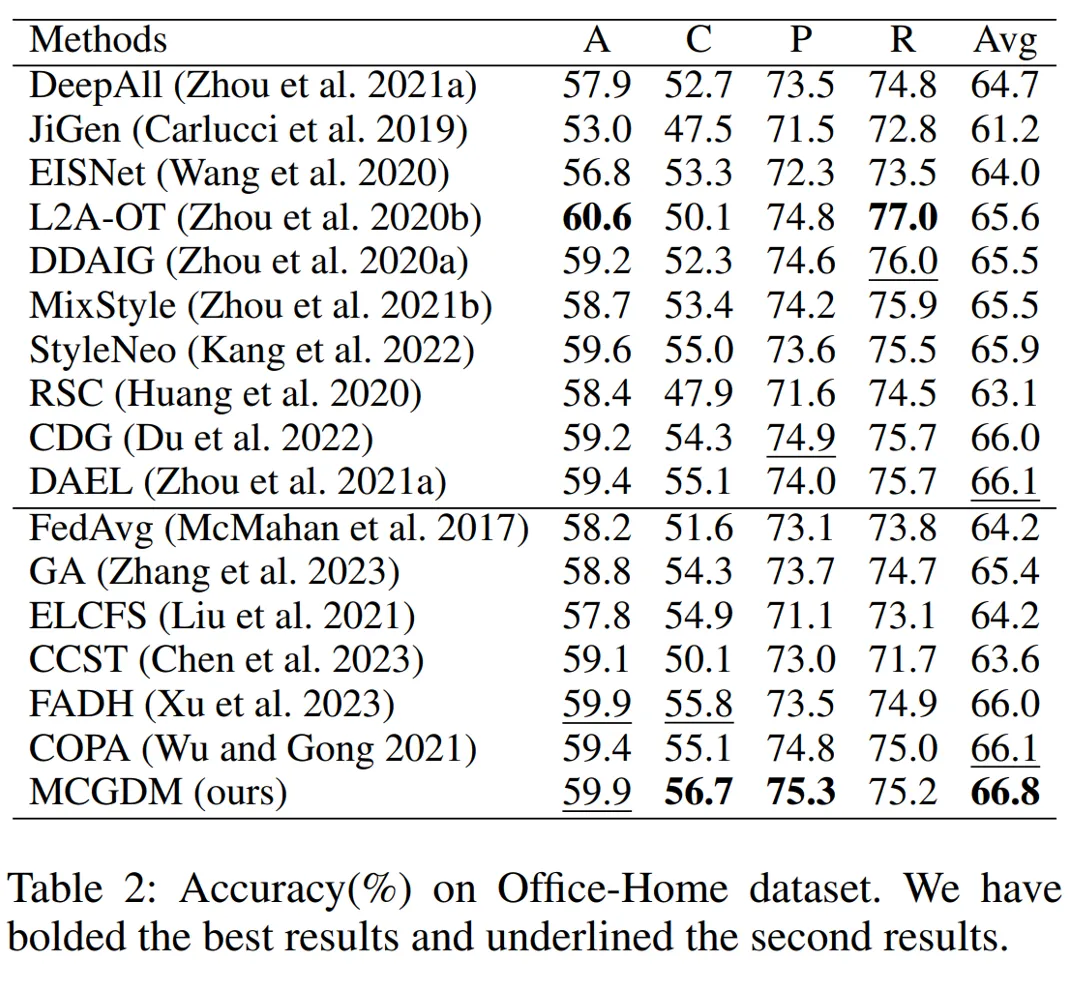

本文在PACS、Office-Home以及VLCS三个图像分类数据集上进行联邦多源领域泛化任务的性能测试,采用Leave-one-domain-out的评价准则,在1个训练阶段不可见的域上测试分类准确率,其他的域作为多个源域用于模型的训练。图3与图4为PACS与Office-Home数据集上的实验结果。结果表明,对比传统的多源领域泛化方法与现有的联邦多源领域泛化方法,本文所提的方法在数据去中心化场景下具有显著的性能优势,甚至优于数据可汇聚场景下的多源领域泛化方法。更多的实验结果以及分析见原文。

其中,在PACS数据集上我们利用昇思MindSpore框架复现本文所提算法的结果。如图3所示,复现结果表明昇思MindSpore框架可实现与友商相当的性能,甚至在某些域如Cartoon上取得了更好的结果。

图 3. PACS数据集上的性能

图 4. Office-Home数据集上的性能

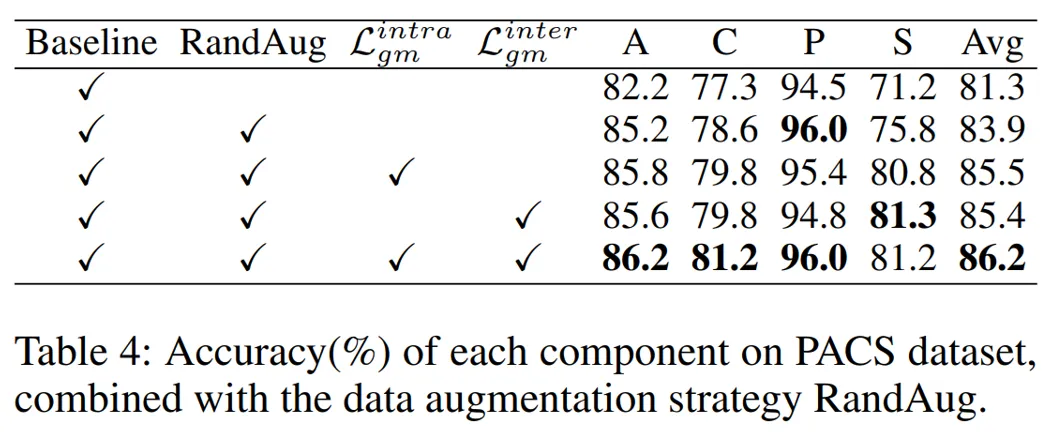

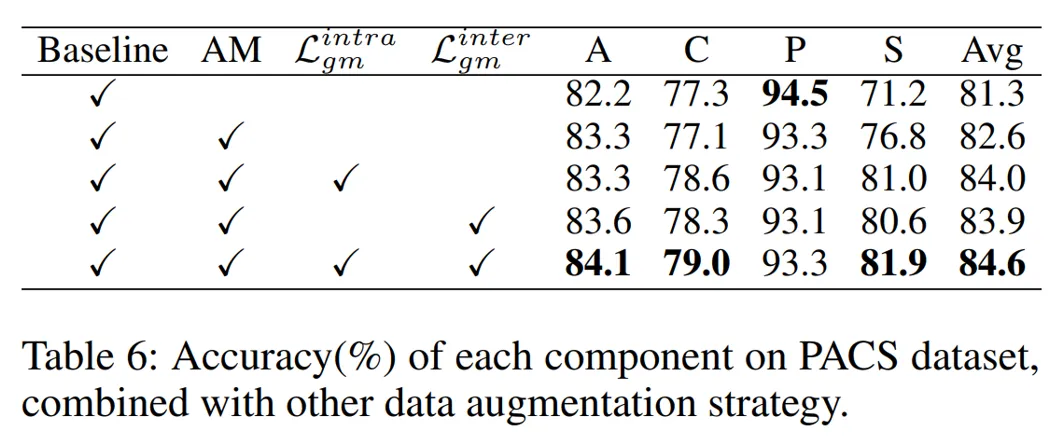

4.2 消融试验

在PACS数据集上的消融实验结果表明了本文所提方法各个成份的有效性。同时,结合其它的数据增广策略,验证了本文所提方法不依赖于特定的数据增广策略,可有效地提升模型的泛化能力。

图 5. 各个成分的贡献

图 6. 结合其它数据增广方法

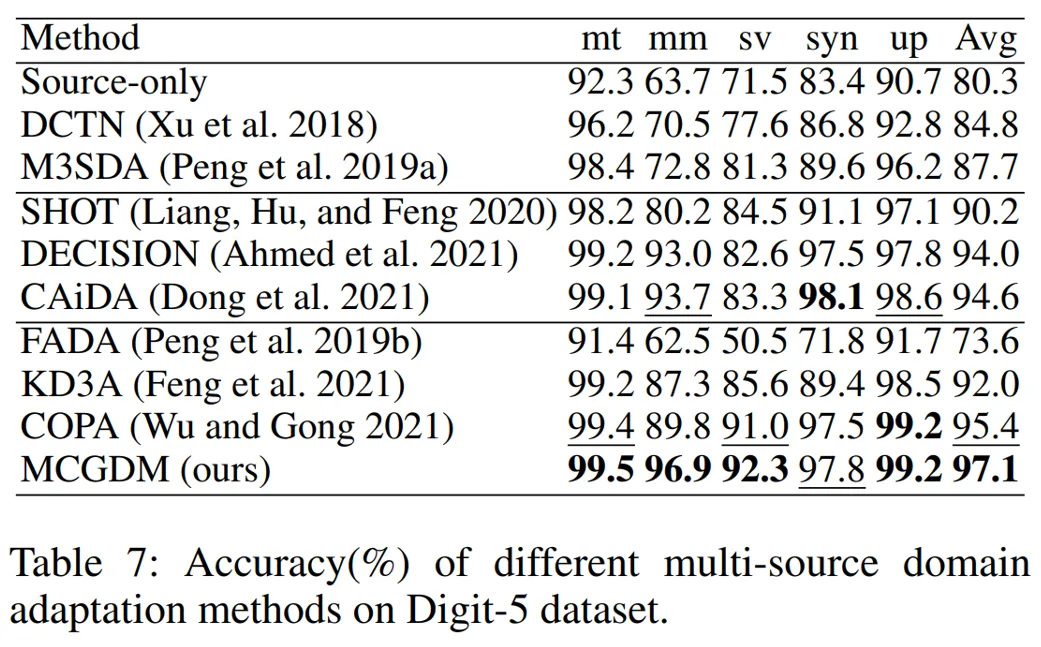

4.3 扩展至联邦多源领域自适应任务

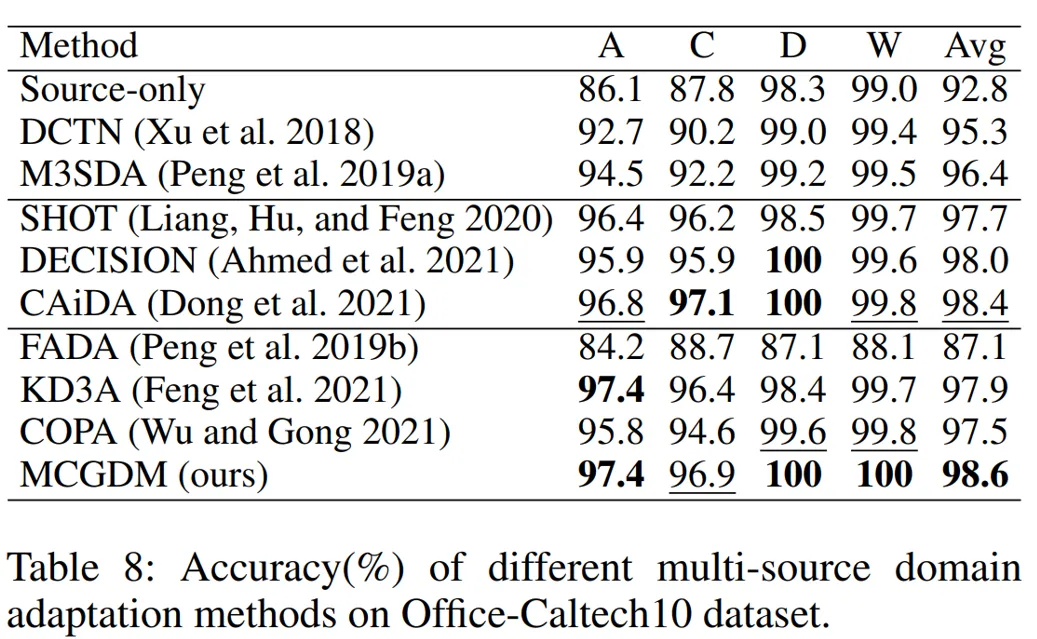

此外,当无标签的目标域存在时,本文所提的方法在目标域上利用可泛化的源域模型产生伪标签,实现在目标域上微调模型,以便扩展至联邦多源领域自适应任务。在Digit-5与Office-Caltech10数据集上的实验结果表明了本文方法在联邦多源领域自适应任务上的优越性能。

图 7. Digits-5数据集上的性能

图 8. Office-Caltech10数据集上的性能

05 总结与展望

本文研究模型在不同端上部署(数据去中心化)场景下的多源领域泛化问题, 设计了一个基于梯度差异最小化的联邦多源领域泛化方法。本文提出域内梯度匹配来学习数据的本质语义信息以便提升模型的跨域泛化能力,同时提出域间梯度匹配来减小去中心化场景下相互独立的各个源域之间的域差异。我们使用昇思MindSpore架构实现了所提出的算法并展现其在效率和准确性上的优势。

在使用昇思MindSpore复现本文的算法时,我们发现昇思MindSpore的设计理念简洁易懂,而且提供的相关API符合开发者的使用习惯,是一款具有巨大潜力的深度学习框架。除此之外,昇思MindSpore开源社区的大量文档与样例可帮助入门,完成相关算法的设计与实现。希望众多MindSpore开发者和使用者依托现有的开源社区平台交流算法设计与实现时遇到的技术问题与挑战,为其他使用者提供可参考的案例,以便快速达到研究目标。

往期回顾

论文精讲 | 基于昇思MindSpore多维度公平性联邦学习

论文精讲 | 基于昇思MindSpore具有可解释自适应优化的联邦因果发现