- 1第十六届“华中杯”大学生数学建模挑战赛C题思路_光纤传感器数学建模

- 2Eureka(服务注册和发现)——Eureka的简介和原理 &; Eureka的使用和分析 &; 心跳续约策略,服务的下线和剔除(1)

- 3git分支合并步骤与解决冲突问题_要整合的更改 head

- 4访问 Postman OAuth 2.0 授权的最佳实践

- 5案例:xpath实例+功能

- 6微信小程序与本地MySQL数据库通信

- 7软件杯 题目:基于深度学习的中文对话问答机器人

- 8详解AttributeError: ‘PyQt5.QtCore.pyqtSignal‘ object has no attribute ‘connect‘_pyqt5.qtcore.pyqtsignal' object has no attribute '

- 9阿里云2025届校招开始了-招前端、java后端、运维的同学

- 10is not in the sudoers file 解决_tino is not in the sudoers file.

Flink任务运行的详细步骤:从入门到精通_flink 任务详解

赞

踩

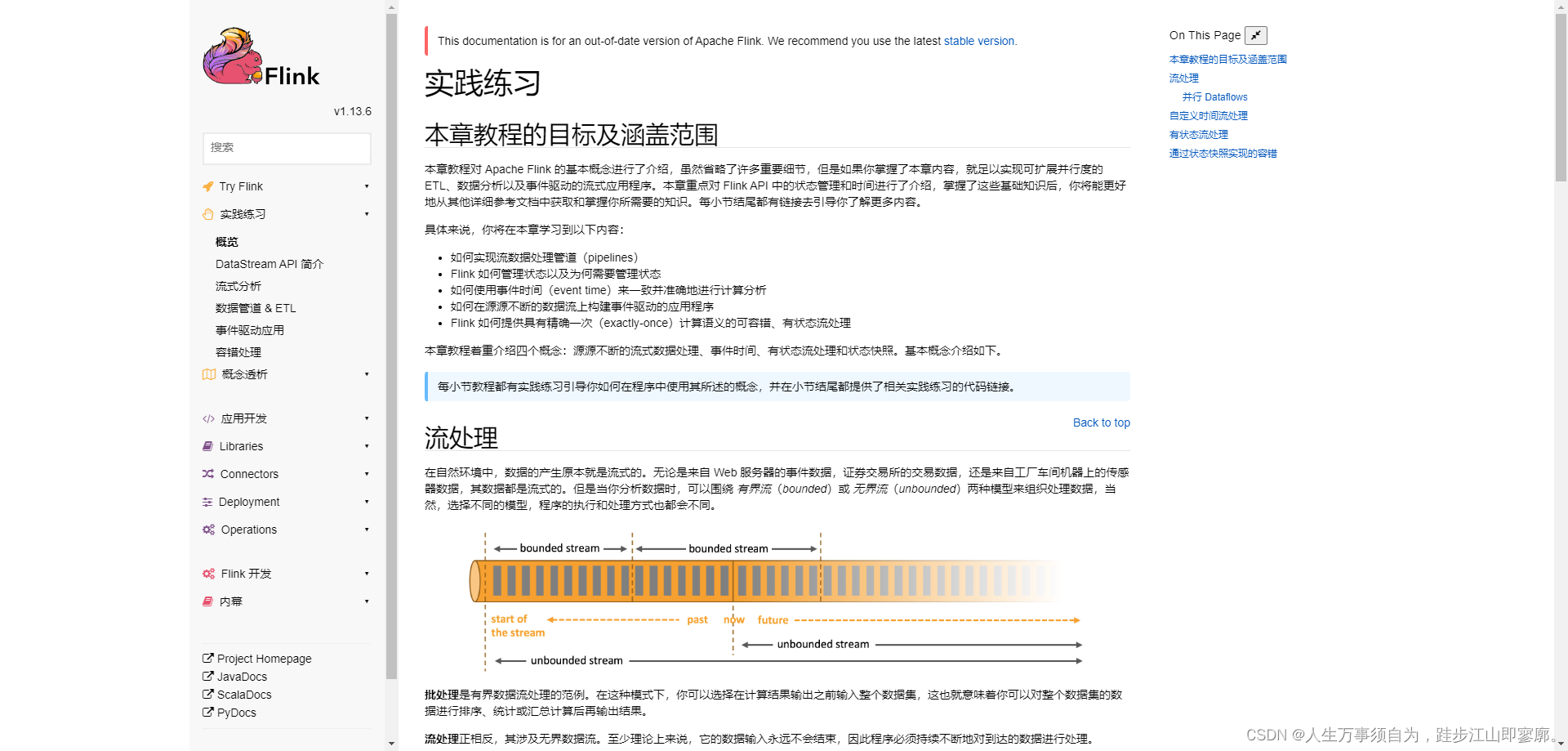

导语:Apache Flink 是一个开源的流处理框架,它允许用户对实时数据流进行有状态计算。本文将为您介绍 Flink 任务运行的详细步骤,帮助您快速上手 Flink,并在项目中发挥其强大的功能。

正文:

一、Flink 简介

Apache Flink 是一个开源的流处理框架,它允许用户对实时数据流进行有状态计算。Flink 具有高性能、高吞吐量和低延迟的特点,适用于各种实时数据处理场景,如实时数据分析、实时监控、实时推荐等。

二、Flink 任务运行的详细步骤

1. 环境准备

在开始运行 Flink 任务之前,请确保您的环境满足以下要求:

- 安装 Java 开发环境,推荐使用 Java 8 或更高版本。

- 安装 Maven,用于构建 Flink 项目。

- 下载 Flink 安装包,并解压到指定目录。

2. 创建 Flink 项目

使用 Maven 创建一个新的 Flink 项目。在项目根目录下,创建一个名为 pom.xml 的文件,并添加以下内容:

-

- <project xmlns="http://maven.apache.org/POM/4.0.0"

- xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

- xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

- <modelVersion>4.0.0</modelVersion>

- <groupId>com.example</groupId>

- <artifactId>flink-project</artifactId>

- <version>1.0-SNAPSHOT</version>

- <name>flink-project</name>

- <packaging>jar</packaging>

- <properties>

- <flink.version>1.12.0</flink.version>

- </properties>

- <dependencies>

- <dependency>

- <groupId>org.apache.flink</groupId>

- <artifactId>flink-java</artifactId>

- <version>${flink.version}</version>

- </dependency>

- <dependency>

- <groupId>org.apache.flink</groupId>

- <artifactId>flink-streaming-java_${scala.binary.version}</artifactId>

- <version>${flink.version}</version>

- </dependency>

- <!-- 添加其他依赖 -->

- </dependencies>

- </project>

3. 编写 Flink 程序

在项目根目录下,创建一个名为 `MyFlinkJob.java` 的文件,并编写 Flink 程序。例如,以下是一个简单的 Flink 程序示例:

- import org.apache.flink.api.common.functions.MapFunction;

- import org.apache.flink.api.common.serialization.SimpleStringEncoder;

- import org.apache.flink.api.common.serialization.SimpleStringSchema;

- import org.apache.flink.streaming.api.datastream.DataStream;

- import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

- import org.apache.flink.streaming.api.functions.sink.filesystem.StreamingFileSink;

- public class MyFlinkJob {

- public static void main(String[] args) throws Exception {

- // 创建 Flink 执行环境

- StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

- // 读取数据源

- DataStream<String> inputStream = env.socketTextStream("localhost", 9999);

- // 转换数据

- DataStream<String> transformedStream = inputStream.map(new MapFunction<String, String>() {

- @Override

- public String map(String value) throws Exception {

- return value.toUpperCase();

- }

- });

- // 输出数据

- StreamingFileSink<String> sink = StreamingFileSink.forRowFormat(

- new Path("output/output/"),

- new SimpleStringEncoder<String>("UTF-8")

- ).build();

- transformedStream.addSink(sink);

- // 执行任务

- env.execute("My Flink Job");

- }

- }

4. 构建和打包 Flink 项目

在项目根目录下,使用 Maven 构建和打包 Flink 项目:

-

- mvn clean package

5. 运行 Flink 任务

在项目根目录下,使用以下命令运行 Flink 任务:

-

- ./bin/flink run -p <parallelism> target/flink-project-1.0-SNAPSHOT.jar

其中,`<parallelism>` 是您希望任务并行执行的度量。您可以根据您的系统资源调整这个值。

6. 监控任务

使用 Flink 提供的监控工具,如 Flink UI,可以实时监控任务的运行状态和性能指标。

三、总结

Flink 是一个强大的流处理框架,可以用于处理实时数据流。本文介绍了 Flink 任务运行的详细步骤,包括环境准备、创建 Flink 项目、编写 Flink 程序、构建和打包 Flink 项目、运行 Flink 任务以及监控任务。通过这些步骤,您可以快速上手 Flink,并在项目中发挥其强大的功能。无论您是初学者还是有一定经验的开发者,都应该掌握这些步骤,以便在项目中发挥 Flink 的强大功能。希望本文的内容能对您有所帮助,让您的 Flink 开发之路更加顺畅!

结语:

Flink 是一个高性能的流处理框架,适用于各种实时数据处理场景。通过本文的介绍,您应该已经了解了 Flink 任务运行的详细步骤。在实际应用中,Flink 可以帮助您更好地管理实时数据,提高数据处理能力和效率。无论您是数据处理的新手还是有一定经验的开发者,都应该掌握 Flink 的使用,以便在项目中发挥其强大的功能。希望本文的内容能对您有所帮助,让您的数据处理之路更加顺畅!