热门标签

热门文章

- 1AI推介-大语言模型LLMs论文速览(arXiv方向):2024.03.15-2024.03.20_agent-flan: designing data and methods of effectiv

- 2保姆级教程:手把手教你使用深度学习处理文本_文本深度学习gun

- 3SINUMERIK西门子828D/840Dsl数控系统数据采集方法与IP地址参数设定_840d机床数据采集

- 4[嵌入式AI从0开始到入土]13_orangepi aipro开箱测评_昇腾 orangepi

- 5通俗的解释什么是Docker,一文搞懂_对docker的理解

- 6NLP自然语言处理学习笔记_自然语言处理笔记

- 7人脸识别 openCV+tensorflow_tensorflow训练opencv人脸模型

- 8词性标注,标注集_词性标签种类

- 9Python设计:基于Django的求职就业系统的设计与实现_python就业管理系统

- 10与ChatGPT的聊天:如何使用Python连接Neo4j并创建无向图?_neo4j chatgpt

当前位置: article > 正文

bp神经网络隐含层神经元个数_闲话神经网络

作者:知新_RL | 2024-03-26 03:05:15

赞

踩

bp神经网络隐含层神经元个数

去年写的一篇神经网络杂文,把之前收集的神经网络点点滴滴串联起来,便于理解,如有不当,麻烦及时指出。

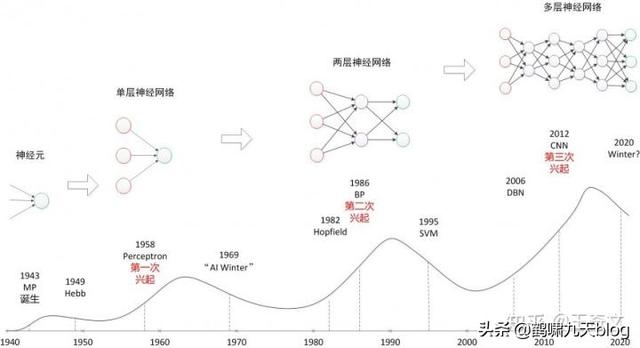

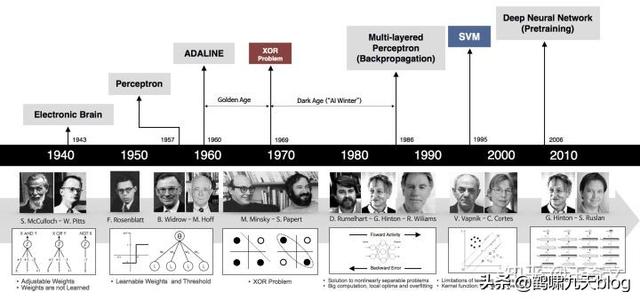

(1)神经网络发展历史

先看几张图:

神经网络三次兴起:

- 第一次,控制论时代,1958年,感知器诞生,能分类,但解决不了异或问题;

- 第二次,联结主义时代,BP网络诞生,加非线性激活函数,解决了异或,但受限于理论不完善(局部最优,黑盒)+数据少+训练方法+计算能力,败于SVM与概率图;

- 第三次,2006年,祖师爷Goeffrey Hinton坐了几十年冷板凳,琢磨出pre-training,DBN等,接着一发不可收拾。Yann LeCun将CNN发扬光大(将BP与CNN结合,推出第一个可用的Le-Net,深度学习入门者的hello world),Jürgen Schmidhuber 90年代发明的LSTM,沉寂多年后复活了,Yoshua Bengio开创了神经网络语言模型。加上大数据时代,GPU的发展等,诸多因素导致深度学习“大爆炸”。

注:这里不做过多介绍,详情参考我在雷锋网上的读书分享,「Deep Learning」读书系列分享(一)

(2)神经网络基础回顾

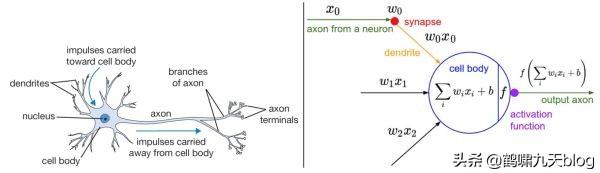

左边展示了一个生物学的神经元,右边展示了一个常用的数学模型。人工神经网络中的神经元设计受到生物神经元的启发。

总结要点:

- 生物神经元(左图)中,树突将信号传递到细胞体,信号在细胞体中相加。如果和高于某个阈值,那么神经元将会激活,向其轴突输出一个峰值信号,注意是一个脉冲信号。

- 数学计算模型(右图)中,将输入进行加权求和加上偏置,输入到激活函数(模拟生物中神经元)中,继续往后传递。

- 注意:生物中神经元复杂得多,其一,输出是一个脉冲,而不是一个值,现在也有脉冲人工神经网络(号称第三代神经网络)。

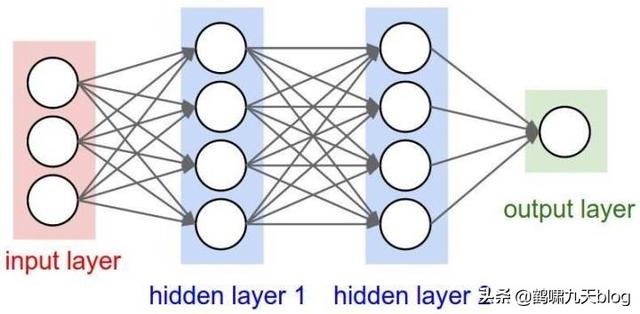

多个神经元组合起来,输入层,隐含层和输出层,形成神经网络。常见的是前馈神经网络,典型例子多层感知器,变种是循环神经网络(时间上共享)和卷积神经网络(空间上共享)等。当然,80-90年代,还有诞生过其他结构的网络,如反馈神经网络(输出与输入直接关联,如Elman网络和Hopfield网络),自组织神经网络(无监督,每次竞争,只更新一个神经元,参数和网络结构自适应),模糊神经网络,径向基神经网络(跟早期的BP网络同步)等等,只是应用效果欠佳,淹没在时代潮流里,被人遗忘。

参考:神经网络用作分类器

(3)十万个为什么

神经网络从名不见经传到现在大红大紫,成了AI浪潮的主力。只要跟AI相关,基本都要扯上神经网络,从多层感知器MLP,到卷积神经网络CNN,循环神经网络RNN,再到自编码器AE,变分自编码VAE,生成对抗网络GAN,让人应接不暇。

身处信息爆炸时代的初学者,如果人云亦云,没有自己的思考,很容易陷入懵逼状态:

- 神经网络到底是什么“神经”物种?神经元?人类大脑?

- 外行一听就觉得高端大气上档次,却又遥不可及,只得双手合十,顶礼膜拜,不可理解推敲焉,只好找个佛龛供起来,一方面自己有了信仰,心里不慌,另一方面又能“吓唬”别人,^_^。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/知新_RL/article/detail/314249

推荐阅读

相关标签