- 1am命令基本知识_am start

- 2ccfcsp201312-2 ISBN号码

- 3分享 GitHub 上的敏感词汇工具类:sensitive-word_sensitive word 开源

- 4MK+Sen趋势检验(长时间栅格数据)_遥感影像theil-sen趋势分析mk检验

- 5【BUG解决】vscode debug python launch.json添加args不起作用_launch.json args

- 6Java多线程面试题_java面试 多线程

- 7检测和解决 SQL Server 2000 SP 4 中的延迟和阻塞 I/O 问题_sql server has encomtered 3 ocurence of i/o reques

- 8【论文泛读】4. 机器翻译:Neural Machine Translation by Jointly Learning to Align and Translate_src_train_data和trg_train_data

- 9redis设置缓存时间一般多少_redis缓存涉及到商品时时间控制多久

- 10VM虚拟机 Linux网络配置(Center os 6.8)。_vm虚拟机 linux6.8更改网络配置

论文阅读【11】Enhancing Label Correlation Feedback in Multi-Label Text Classification via Multi-Task Learn_rcv1-v2

赞

踩

1.论文相关

- 论文标题:通过多任务学习增强多标签文本分类中的标签相关反馈

- 发表时间:2021年

- 领域:自然语言处理

- 代码地址:https://github.com/EiraZhang/LACO.

这篇论文发表与ACL,因为我想学习如何写出高水平的论文,于是我将这篇文章通篇翻译了一遍,并且分析每段的写作方法,用于自己日后写论文做准备。

2.摘要

在多标签文本分类(MLTC)中,每个给定的文档都与一组相关的标签相关联。为了捕获标签相关性,之前的分类器链和序列到序列模型将MLTC转换为序列预测任务。然而,它们往往存在标签顺序依赖性、标签组合过拟合和误差传播等问题。为了解决这些问题,我们引入了一种新的多任务学习方法来增强标签相关反馈。我们首先利用联合embedding(JE)机制来同时获得文本和标签表示.在MLTC任务中,采用文档-标签交叉注意(CA)机制来生成更具鉴别性的文档表示,此外,我们提出了两个辅助的标签共现预测任务来增强标签相关学习:

- 成对标签共现预测(PLCP)

- 条件标签共现预测(CLCP)

在AAPD和RCV1-V2数据集上的实验结果表明,我们的方法大大优于竞争基线.我们分析了低频标签性能、标签依赖性、标签组合多样性和覆盖速度,以表明我们提出的方法在标签相关学习方面的有效性.

摘要部分主要简单介绍了几个方面,第一是创作动机,为什么要写这篇论文,第二就是自己的模型分为那几个部分,第三就是通过那些实验来验证自己的模型比较好,作者使用了

低频标签性能、标签依赖性、标签组合多样性和覆盖速度等实验,来证明自己的模型比其他的模型好,比较全面.

3.引言

多标签文本分类(MLTC)是一项重要的自然语言处理任务,主要应用于文本分类、信息检索、web挖掘等许多现实场景中.每个给定文档都与一组标签相关联,这些标签通常在统计和语义上相关.应充分利用标签相关性来建立具有较强泛化性能的多标签分类化模型.特别是,学习标签之间的依赖关系可能有助于建模低频标签,因为现实世界的分类问题往往表现出长尾标签分布.其中,低频标签只与少数实例相关联,并且很难学习.然而,暴露偏差现象可能会导致模型对训练集中的频繁标签序列的过度拟合,从而导致了几个问题.

- 首先,基于Seq2seq的方法严重依赖于预定义的标签排序,并对标签顺序执行敏感,实际上,标签本质上是MLTC任务中与顺序无关的集合。

- 其次,基于seq2seq的方法存在低泛化能力问题,因为它们往往会过匹配训练集中的标签组合,难以生成不可见的标签组合.

- 第三,基于seq2seq的方法依赖于先前可能存在的错误预测结果.错误可能会在推理阶段传播,即真正的目标标签不可用,因此被模型本身生成的标签所取代.

为了避免上面提到的潜在问题,我们引入了一种基于多任务学习的方法,它不依赖于Seq2Seq架构。

该方法包含一个共享编码器、一个特定任务模块和一个标签相关性增强模型.在共享参数层中,我们引入了一种联合embedding(JE)机制,它利用一个transformer的编码器来联合获得文档和标签表示.标签之间的相关性是通过自我注意机制隐式学习的,这与以往的标签嵌入方法不同.在MLTC任务特定模块中,我们通过文档-标签交叉注意(CA)机制生成特定于标签的文档表示,它保留了歧视性的信息.共享编码器和MLTC任务特定模块是源自于这个称之为LACO的模型—— LAbel COrrelation aware multi-label text classification.

标签间的共现关系是能够明确反映标签相关性的重要信号之一,无需额外的人工标注即可得到.在标签相关增强模块中,我们提出了两个标签共现预测任务,哪些是与MLTC任务共同训练的. 成对标签共现预测(PLCP)任务:通过2乘2的组合来区分它们是否同时出现在相关标签的集合中,来捕获二阶标签相关性.条件标签共现预测(CLCP)任务:通过给定的部分相关标签集来预测其他未知标签的相关性。

我们在AAPD和RCV1- V2数据集上进行了实验,结果表明,我们的方法大大优于对比基线模型。综合的实验结果分析低频标签性能,综合实验结果分析了低频标签性能、标签依赖性、标签组合多样性和覆盖速度,这对衡量标签相关学习能力至关重要.我们强调我们的贡献如下:- 1.我们提出了一种新而有效的MLTC方法,它不仅可以通过联合空间充分地学习文档和标签的特征,它不仅通过联合空间充分学习了文档和标签的特征,而且通过不依赖标签顺序的多任务设计加强了相关性。

- 我们提出了两个可行的任务(PLCP和CLCP)来增强标签相关性的反馈,这有助于引导具有较强泛化性能的多标签预测模型。

- 我们将我们的方法与两个多标签分类数据集上的竞争基线模型进行了比较,并系统地证明了所提模型的优越性。

引言这部分主要介绍了多标签文本分类是什么,对比之前的方法,主要解决了什么问题,并且提出了自己的模型分为那几个模块,跟摘要很类似.

4.相关工作

我们的工作主要涉及MLTC任务的两个领域:标签关联学习和文档表征学习。

4.1 标签关联学习

对于MLTC任务,有下面一些方法

- binary relevance(BR):是一种简单但广泛使用的方法,它将MLC任务分解为多个独立的二元分类问题,而不考虑标签之间的相关性。

- label powerset(LP):为了捕获标签相关性,这个算法将MLTC任务作为多类分类器的训练,作为所有唯一标签组合的分类问题。

- Classi-fier Chains (CC):利用链规则和来自以前的分类器的预测作为输入。提出了Seq2Seq体系结构,通过编码输入文本序列和顺序解码标签,将MLTC转换为标签序列生成问题.然而,基于CC和Seq2的Seq的方法都严重依赖于预定义的标签顺序,并且对标签顺序执行得很敏感。

为了解决标签顺序依赖性问题,人们探索了各种方法:

- 通过启发式排序

- 通过动态规划

- 通过强化学习

- 通过多任务学习

与这些工作不同的是,我们的方法通过非基于seq2seq的方法来学习标签相关性,而不需要遇到上述问题。

最近,研究人员提出了各种不基于Seq2Seq体系结构的MLTC标签相关建模方法。提出了一种采用多轮预测的多标签推理机制,并依赖于预测多轮结果来集成或确定适当的顺序,这是计算成本昂贵的。

CorNetBertXML:利用BERT来获得的联合表示文本和所有候选标签和额外的指数线性单位(ELU)在预测层利用标签相关知识。与上述工作不同的是,我们利用额外的标签共现预测任务,在多任务框架中显式地建模标签相关性。

4.2 文档表示学习

文本表示在文本分类任务中起着重要的作用。为早期模型提取基本的人工标注的特征是至关重要的。基于深度神经网络的MLTC模型已经取得了巨大的成功,例如CNN,RNN,CNN-RNN, attention mechanism等等。他们是文本分类任务发展的一个重要转折点,它的工作原理是通过使用transformer生成上下文化的词向量.深度学习方法如此流行的原因是它们能够从文本中学习复杂的语义表示,它们比人工标注的特征要丰富得多。然而,这些方法往往忽略了标签的语义,而只关注文档的表示。

最近,标签embedding被认为是为了改进多标签文本分类任务。DNN是第一个基于多标签embedding方法,寻找一个深度潜在空间来联合嵌入实例和标签.LEAM在文本分类中应用标签embedding,通过其对应的文本描述获得每个标签的embedding.LSAN利用文档内容和标签文本,借助self-attention和label-attention机制,学习特定于标签的文档表示。我们的工作与这些工作的不同之处在于,我们工作的目标不仅要考虑文档和标签之间的相关性,还要考虑标签之间的相关性。

相关工作这块,作者将相关工作分为2个方面

标签关联学习,文档表示学习,这也对应作者的算法是将二者结合起来使用的,分析这两个部分前人做了那些工作,并且剖析了每个工作中的不足之处,并且每个工作之间都存在关联性,后一个工作是前一个工作的解决办法.

5.算法

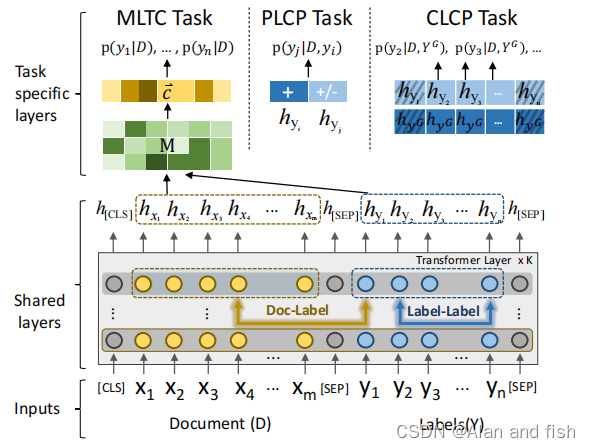

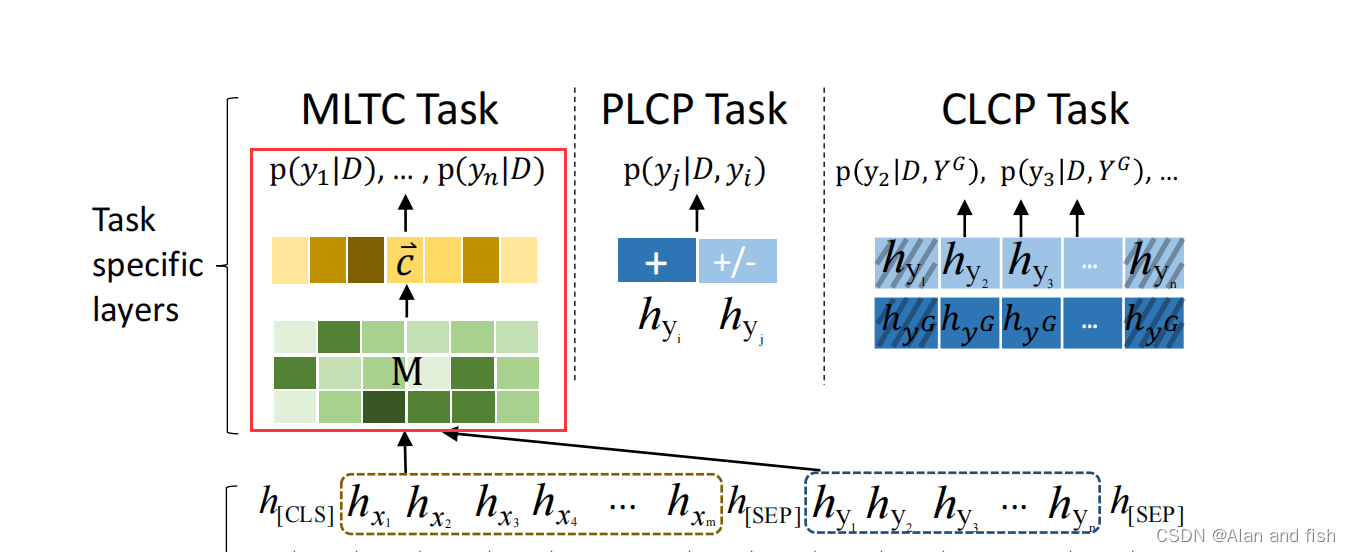

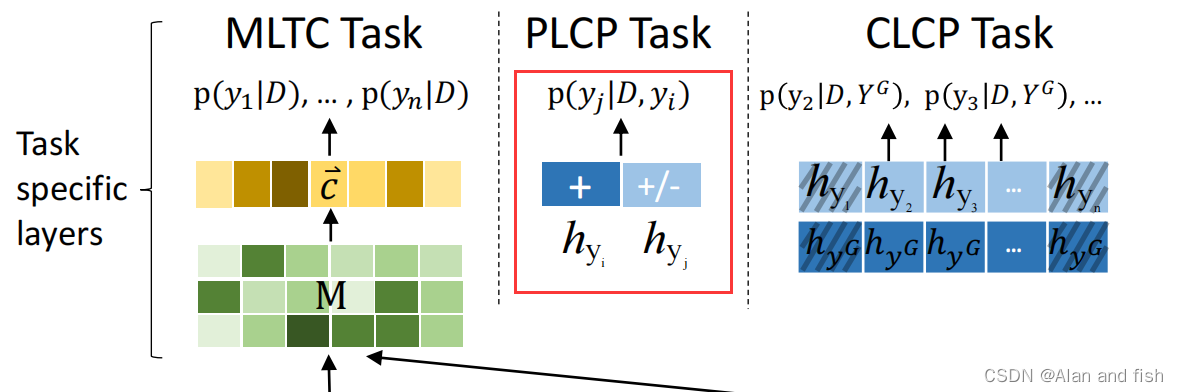

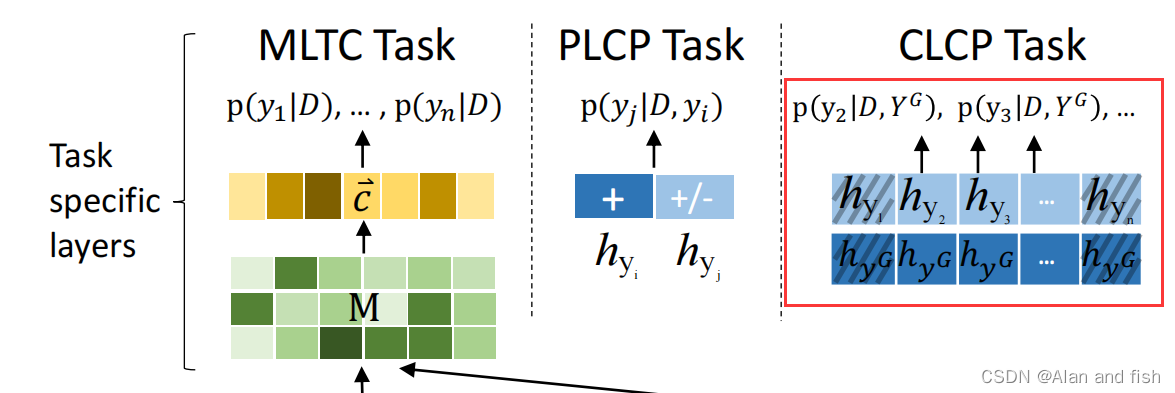

图1:我们提出的方法的框架。请注意,CLCP任务中的阴影方块是给定标签的嵌入,+、−分别表示相关标签和不相关标签

LACO的框架如图1所示,较低的层跨所有任务共享,而顶层是特定于任务的。在本节中,我们首先介绍MLTC的标准形式化定义。然后,我们详细介绍了LACO的详细技术实现。

5.1 格式化问题

多标签任务研究了每个单一实例同时与一组标签相关联的分类问题。给定一个多标签文本分类数据的训练集 S = ( D i , Y i + ) ∣ 1 ≤ i ≤ N S = {(D_i, Y_i^+)|1 ≤ i ≤ N} S=(Di,Yi+)∣1≤i≤N,其中 D i D_i Di是文本序列, Y i + Y_i^+ Yi+是相关的标签.具体来说,一个文本序列的长度m是由word token 序列D组成的,D={ x 1 , x 2 , . . . . . . . x n x_1,x_2,.......x_n x1,x2,.......xn},而Y={ y 1 , y 2 . . . . . . . y n y_1,y_2.......y_n y1,y2.......yn}表示由n个类标签组成的标签空间。MLTC的目的是学习一个预测函数f: D→ 2 Y 2^Y 2Y来预测不可见文本的相关标签集.为此,该模型必须优化一个损失函数,以确保每个训练文本的相关和不相关的标签被预测为最小的错误分类。

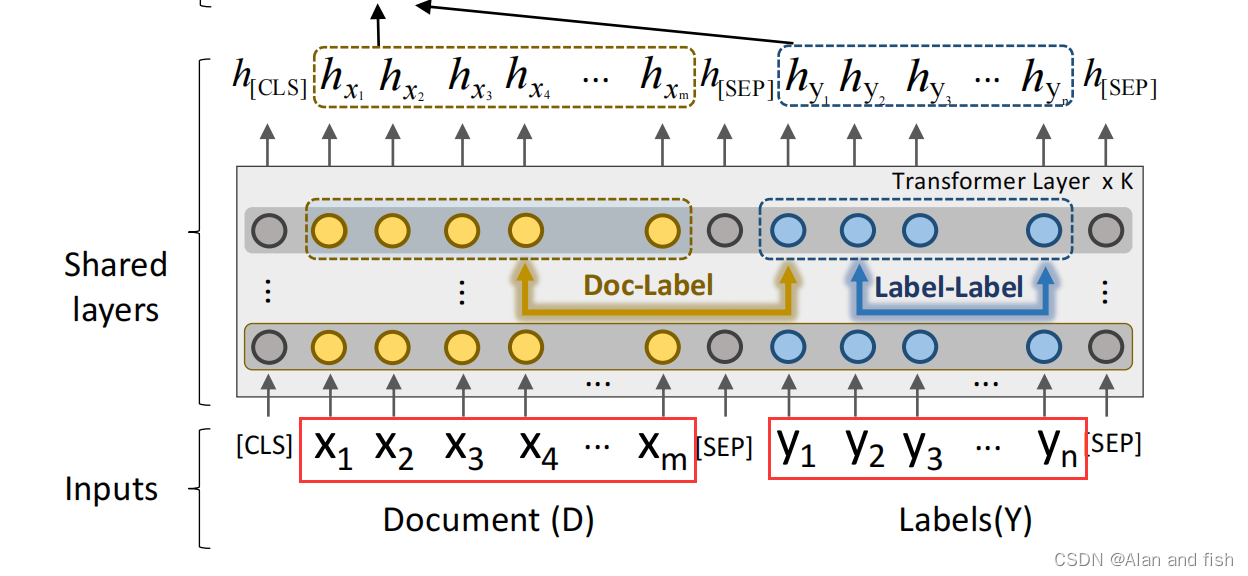

5.2 文档标签联合embedding(JE)

继BERT之后,第一个token总是[CLS]。与[CLS]token对应的输入的文本表示向量聚合了整个文本的特征,并且能够用于文本分类.与这种习惯操作不同,我们提出了一种新的输入结构来直接使用标签信息来构建token级的表示。

如图1所示,输入由一个序列对(D,Y)打包,我们用一个特殊的标记[SEP]将文本序列D和标签序列Y分开.请注意,标签序列是为了连接所有的标签标记。共享的层将输入映射到一系列的embedding向量中,其中的每一个token都被称为token级表示.格式如下:

{

[

C

L

S

]

,

x

1

,

.

.

.

,

x

m

,

[

S

E

P

]

,

y

1

,

.

.

.

,

y

n

,

[

S

E

P

]

\{[CLS], x_1, ..., x_m, [SEP], y_1, ..., y_n, [SEP]

{[CLS],x1,...,xm,[SEP],y1,...,yn,[SEP]},作为encode的一个输入序列,于是我们获得输出是token级表示,

{

h

[

C

L

S

]

,

h

x

1

,

.

.

.

,

h

x

m

,

h

[

S

E

P

]

,

h

y

1

,

.

.

.

,

h

y

n

,

h

[

S

E

P

]

}

\{h_{[CLS]}, h_{x1}, ..., h_{xm}, h_{[SEP]}, h_{y1}, ..., h_{yn}, h_{[SEP]}\}

{h[CLS],hx1,...,hxm,h[SEP],hy1,...,hyn,h[SEP]}.输入结构的设计是为了保证单词和标签被嵌入在同一空间中.采用联合embedding机制,我们的模型可以更多地关注以下两个方面:

- 文档和标签之间的相关性。不同的文档对特定的标签有不同的影响,而相同的文档片段可能会影响多个标签.

- 标签之间的相关性.标签的语义信息是相互关联的,标签共现表明它们之间具有很强的语义相关性。

这里我个人存在一点疑惑,究竟是把所有的标签都追加到后面呢?还是这段文本所对应的真实标签?我个人觉得应该是这段文本对应的真实标签,因为其他标签与这段文本没啥关系,所以不存在关联

5.3 多标签文本分类(MLTC)

在本小节中,我们将介绍MLTC任务特有的模块,包括文本-标签交叉注意力机制(CA)和标签预测。

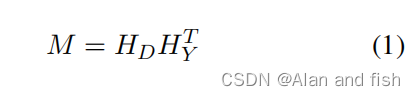

5.3.1 文档标签交叉注意力机制(CA)

来显式地建模每个单词和标签标记之间的语义关系,我们通过点积来衡量标签-词对的兼容性.

其中

H

D

=

[

h

x

1

,

.

.

.

,

h

x

m

]

HD = [h_{x1},...,h_{x_m}]

HD=[hx1,...,hxm]是文本序列embedding,

H

Y

=

[

h

y

1

,

.

.

.

,

h

y

n

]

H_Y = [h_{y1}, ..., h_{y_n}]

HY=[hy1,...,hyn]是标签序列的embedding,M ∈

R

m

×

n

R^{m×n}

Rm×n,考虑到连续单词之间的语义信息,我们通过非线性网络进一步推广了M.具体来说,对于以i为中心长度为2r + 1的文本片段,在M中的局部矩阵块

M

i

−

r

;

i

+

r

M_{i−r;i+r}

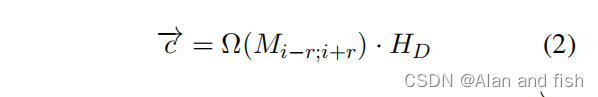

Mi−r;i+r用标签对来衡量相关关系.为了提高稀疏正则化算法的有效性,我们在隐藏层中使用具有ReLU激活函数的CNN模型,并且在函数Ω中依次执行最大池化和双曲切线:

请注意,最终的文档表示

c

⃗

\vec{c}

c

是由单词表示

H

D

H_D

HD的聚合生成的,权重是标签特定的注意力向量Ω(.)这段话的意思HD前面的那个部分是权重参数,是由于标签注意力机制生成,而HD是文本序列

5.3.2 标签预测

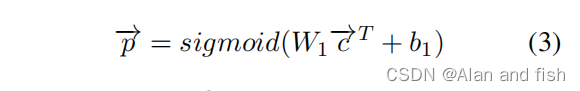

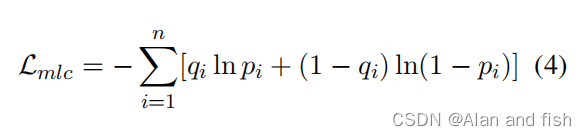

一旦有了有区别的文档表示,我们建立一个拥有全连接层的多标签文本分类器,从文本的不同部分捕获更细粒度的特征:

其中

W

1

∈

R

n

×

k

W_1∈ R^{n×k}

W1∈Rn×k和$ b_1 ∈ R^n$.我们使用二进制交叉熵作为多标签文本分类问题的损失函数.

其中, p i = P ( y i ∣ D ) p_i = P(y_i |D) pi=P(yi∣D)是该模型预测的 y i y_i yi的概率,而 q i ∈ 0 , 1 q_i∈{0,1} qi∈0,1是分类信息 y i y_i yi,我们通过最小化交叉熵误差来训练模型。

5.4 具有标签相关性的多任务学习

在本小节中,我们将介绍两个辅助任务,分别探讨二阶和高阶标签关系.

- 成对标签共现预测(PLCP)

- 条件标签共现预测(CLCP)

5.4.1 PLCP任务

假设每个文档D都包含相应的标签集

Y

+

Y^+

Y+和不对应的标签集

Y

−

Y^−

Y−。为了训练模型来理解二阶标签关系.我们提出了一种名为PLCP的二值化标签对预测任务,它可以从多标签分类语料库中轻松生成.选择标签对进行共现预测的策略很简单。其中一部分只从Y+中取样,这部分被标记为IsCo-occur,另一部分的样本来自Y+和Y−采样,被标记为NotCo-occur.为了构建人工训练数据集,我们根据经验设置了IsCo-occur发生和NotCo-occur发生与γ的比值。如图1所示,我们将两个标签[

y

i

,

y

j

y_i,y_j

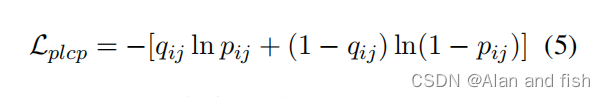

yi,yj ]嵌入在一起作为输入特征.附加的二值分类器用于预测两个标签的状态是IsCo-occur还是NotCo-occur.损失函数如下:

其中,

p

i

j

=

p

(

y

j

∣

D

,

y

i

)

p_{ij} = p(y_j |D,y_i)

pij=p(yj∣D,yi)表示标签对共出现的输出概率,其中q是实际结果,如果

q

i

j

=

1

q_{ij} = 1

qij=1表示IsCo-occur,

q

i

j

=

0

q_{ij }= 0

qij=0表示NotCo-occur

5.4.2 CLCP 任务

为了进一步了解高阶标签关系,我们提出了条件标签共现预测(CLCP)任务。我们首先从

Y

+

Y^+

Y+中随机选择s个标签,形成

Y

G

Y^G

YG.

Y

G

⊆

Y

+

Y^G⊆Y^+

YG⊆Y+,然后预测Y的剩余标签是否与之相关.具体来说,我们引入了一个额外的位置向量

E

Y

=

[

e

y

1

,

.

.

.

,

e

y

n

]

E_Y = [e_{y_1},...,e_{y_n} ]

EY=[ey1,...,eyn],其中

e

y

i

=

0

e_{y_i} = 0

eyi=0表示该位置的

y

i

y_i

yi是采样标签,

y

i

∈

Y

G

y_i ∈ Y^G

yi∈YG,如果

e

y

i

=

1

e_{y_i}=1

eyi=1表示不是采样的标签,此时的

y

i

∈

Y

−

Y

G

y_i∈Y-Y^G

yi∈Y−YG.将零位置标签embedding-

h

y

G

h_y^G

hyG的平均值连接到每个非零位置标签embedding作为输入特征,以预测在知道采样标签时每个剩余标签是否应该共现.在图1中,

p

(

y

i

∣

D

,

Y

G

)

p(y_i |D,Y^G)

p(yi∣D,YG)表示由附加的型分类器预测的

y

i

y_i

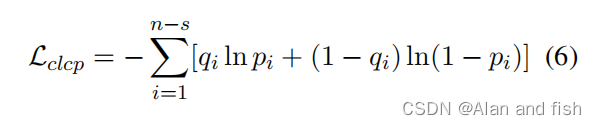

yi的概率.分类的损失是每个非零位置的二值交叉熵损失之和:

其中qi∈{0,1}是表示标签yi是否应该与

Y

G

Y^G

YG共现的基本事实,pi =

p

(

y

i

∣

D

,

Y

G

)

p(y_i|D, Y^G)

p(yi∣D,YG)是每个掩蔽标签=的输出概率。

5.4.3 训练对象

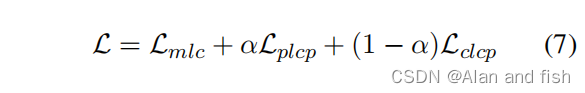

首先将同样的输入输入到共享层,然后,每个子任务模块采用联合嵌入生成的上下文token级文本表示,并为自己的目标标签生成一个概率分布。总的损失可以通过以下公式计算:

其中,α是(0,1)之间的一个超参数,

L

p

l

c

p

L_{plcp}

Lplcp和

L

c

l

c

p

L_{clcp}

Lclcp是 PLCP任务 和 CLCP 任务的特定任务交叉熵损失.

算法部分,作者将自己的模型分成了四块,分别是

文档表示方法,多标签分类,成对共现任务,条件共现任务组成了一个多任务学习,最后解释一下它的损失函数.我们在写论文的时候也可以将自己的模型划分成几个部分,然后对每个部分进行介绍.

6.实验步骤

6.1 数据集

我们在两个多标签文本分类数据集上验证了我们提出的模型:

- Arxiv Academic Paper Dataset (AAPD):收集了55840篇计算机论文摘要,共分为54个相关主题,在AAPD数据集中,每篇论文都被分配了多个主题.

- Reuters Corpus Volume I (RCV1-V2):由804,414个人工分类的新闻专线新闻组成。数据集中的每个故事都可以被分配多个主题,数据集中的每个故事都可以被分配多个主题.

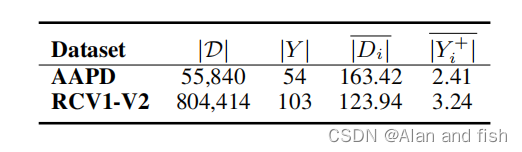

表1: 数据集统计,这里,|D|和|Y |表示文档和标签的总数。

∣

D

i

∣

‾

\overline{ |Di |}

∣Di∣是所有文档的平均长度。

∣

Y

i

+

∣

‾

\overline{ |Yi +|}

∣Yi+∣表示与文档相关联的标签的平均数量。

表1显示了数据集的统计数据。每个数据集被分为训练集、验证集和测试集。我们遵循了Yang等人(2018)对这两个数据集的划分。

6.2 评价指标

多标签分类可以通过一组指标来进行评估,这些指标捕获了任务的不同方面,按照以前的工作,我们采用的是hamming loss,Micro/Macro-F1分数作为我们的主要评估指标。 Micro/Macro-P and Micro/Macro-R也有报告以协助分析,一个宏观平均值会平等地对待所有的标签,而微平均数将根据其频率加权计算每个标签.

6.3 比较算法

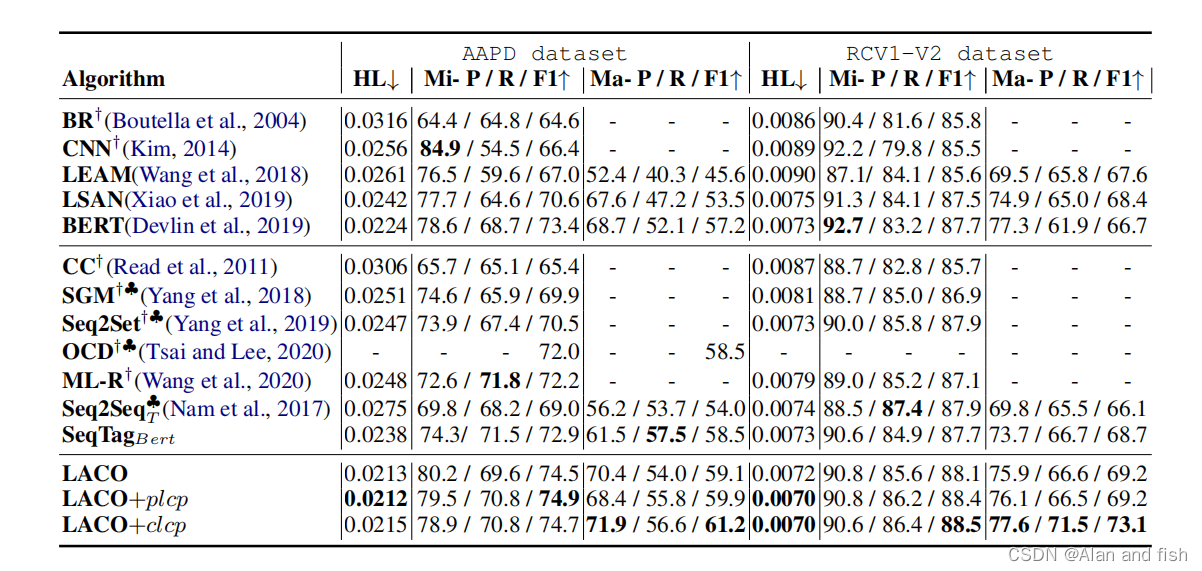

表2:每个比较算法在两个数据集上的预测性能。使用汉明损失(HL)、Micro(Mi-)和Marco(Ma-)平均精度§、召回率®、F1-分数(F1)作为评估指标。↓表示得分越低,表现越好,而↑则相反。带有表示其结果的模型被引用自以前的论文。使用♣的模型是基于seq2seq的模型。

我们采用多种方法作为基线,根据是否考虑标签相关性,可以分为两组.

第1组: 第一组方法不考虑标签相关性。

Binary Relevance(BR)相当于为每个标签独立地训练一个二进制分类器(线性SVM).CNN利用多个卷积核提取文本特征,然后输出标签空间上的概率分布.LEAM涉及到标签嵌入,以获得在文本分类中更具鉴别性的文本表示。LSAN通过注意机制学习特定于标签的文本表示.BERT分类器,该分类器首先将文档编码到向量空间,然后独立输出每个标签的概率。

第2组: 第二组方法考虑标签相关性。

Classifier Chains (CC)将MLTC问题转化为一系列二元分类问题。SGM提出了具有全局embedding机制的Seq2Seq模型来捕获标签相关性。Seq2Set提出了深度强化学习来提高Seq2Seq模型的性能。Seq2Seq_T我们还实现了一个具有12层transformer的Seq2Seq基线,用 S e q 2 S e q T Seq2Seq_T Seq2SeqT命名。OCD提出了一个包括一个编码器和两个解码器的MLTC框架,以减轻暴露偏差。ML-Reasoner采用二元分类器同时预测所有标签,并应用一种新的迭代推理机制.

此外,我们还提供了另一个强大的基线: SeqTagBert将多标签分类任务转换为顺序标记任务,它首先通过我们的共享编码器获得嵌入的每个标签,然后通过BiLSTM-CRF模型依次输出每个标签的概率.

BR、CNN、CC、SGM、Seq2Set、OCD和ML-R的结果在之前的论文中被引用,其他基线的结果由我们实现。所有的算法都遵循相同的数据划分.

6.4 实验参数设置

我们在Tensorflow中实现了我们的模型,并在NVIDIA Tesla P40上运行.我们在英文版本的Bert上进行微调,batch_size设置为32,输入序列的最大长度为320.附加层的窗口大小为10,我设置 γ \gamma γ为0.5.我使用Adam优化器进行优化,学习率为5e-5,通过监测验证集上的Micro-F1分数并停止训练来训练模型,如果5万步连续步骤没有增加则停止训练.

7.实验结果与分析

在本节中,我们将报告在两个文本数据集上的基线模型和所提出的方法的主要实验结果,此外,我们分析了不同频率标签的性能,并进一步评估了我们的方法是否通过标签对协同分布学习和标签组合预测,有效地学习了标签相关性.最后,我们对收敛性研究进行了详细的分析,证明了该方法的泛化能力。

7.1 实验结果

我们在表2中报告了两个数据集上所有比较算法的实验结果.第一个块包括没有学习标签相关性的方法。第二个块是考虑标签相关性的方法,第三个块是我们提出的LACO方法。如表2所示,基于LACO的模型的表现优于所有基线模型,评价指标最高.

我们的LACO基本模型训练仅通过MLTC任务显著改善了汉明损失和Micro-F1的结果.具体来说,在AAPD数据集上,与考虑对标签相关性进行建模的Seq2集相比,我们的基本模型在汉明损失上降低了13.8%,在Micro-F1上提高了5.67%.与LSAN等标签嵌入方法相比,LACO在RCV1-V2数据集上降低了4.00%的汉明损失评分,提高了0.69%的Micro-F1评分。此外,BERT仍然是一个强大的基线,这表明获得一个高质量的鉴别文档表示对于MLTC任务是很重要的。在这里,我们用3个随机种子训练LACO,并计算平均值和标准差。在表3中,我们使用lACO和两个基线模型BERT和

S

e

q

T

a

g

B

e

r

t

SeqTag_{Bert}

SeqTagBert.

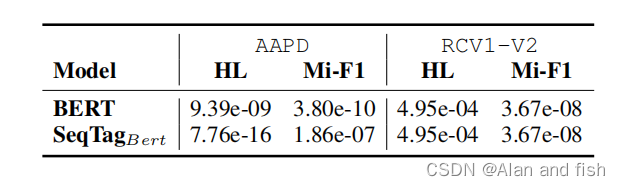

表3:统计分析结果。与两种强基线BERT和SeqTagBert相比,LACO的P值进行了显著性检验。

与两种强基线模型进行了比较,LACO的所有P值均低于阈值(p < 0.05),这表明其表现在统计学上具有显著意义。

我们实现了针对汉明损失和微观f1指标的弗里德曼测试.当相应的临界值为2.8179时,弗里德曼统计的汉明损失的统计

F

F

F_F

FF为7.875,Micro-F1的统计

F

F

F_F

FF为6.125(比较算法k = 12,datasets N=2),因此,在0.05的显著性水平上,明显拒绝了各比较算法之间性能难以区分的零假设。

与SGM相比,

S

e

q

2

S

e

q

T

Seq2Seq_T

Seq2SeqT并没有取得明显的改善,但

S

e

q

T

a

g

B

e

r

t

SeqTag_{Bert}

SeqTagBert基于文档和标签之间的共享transformer编码器,显示出良好的性能。

S

e

q

T

a

g

B

e

r

t

SeqTag_{Bert}

SeqTagBert在Micro-F1上的结果与BERT相当,但在Macro-F1上的结果明显更高。以上说明了标签相关信息对于学习低频标签更为重要。

对于多任务学习方法的结果,我们的方法引入的两个子任务对两个数据集的主要指标有一定程度的改进.具体来说,我们观察到PLCP任务在AAPD数据集的Micro-F1上的最佳表现更好,为74.9,而CLCP任务在RCV1-V2数据集的在Micro-F1上的最佳表现为88.5。此外,所提出的多任务框架比基本模型LACO在Macro-F1上的性能有了很大的改进,这表明,通过我们的标签相关引导子任务,可以大大提高低频标签的性能.值得注意的是,通过考虑高阶相关性,CLCP任务在Marco-F1上表现得更好。我们还同时使用三个任务的损失来实现这个实验,而与

L

A

C

O

+

p

l

c

p

LACO_{+plcp}

LACO+plcp或

L

A

C

O

+

c

l

c

p

LACO_{+clcp}

LACO+clcp相比,这两个子任务的组合并不能进一步提高模型的性能,我们认为这是由于这两个任务之间的强相关性导致的.

7.2 消融实验

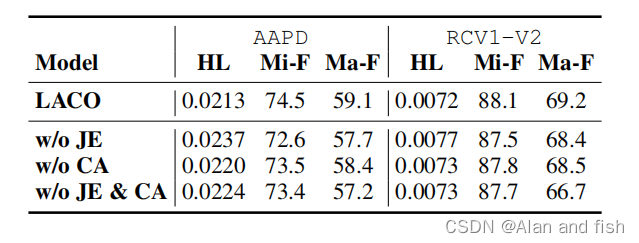

在本节中,我们将演示所提出的LACO模型的两个核心的有效性,即一个文档-标签联合嵌入(JE)机制.以及一种文档标签交叉注意(CA)机制。请注意,w/o JE & CA的设置相当于Tabel 2中的BERT基线,它只编码文档,并基于[CLS]预测每个标签的概率。在w/o JE设置中,文档嵌入由BERT编码,而每个标签嵌入都是一个可学习的随机初始化向量。其标签预测层与LACO相同。在**w/o CA设置中,通过BERT联合获得文档和标签嵌入,并基于[CLS]预测每个标签的概率。

表4: 在AAPD和RCV1-V2数据集上使用LACO模型对所提出的联合嵌入(JE)和交叉注意(CA)机制进行消融

Tabel 4表明,Je和CA对于获得更有区别性的文本表示都很重要.去除Je和CA机制后,AAPD数据集的性能比RCV1-V2数据集的性能下降幅度更大.我们认为,这主要是由于在AAPD中的训练实例较少,这更难学习相关特征,特别是对于那些低频标签。

7.3 低频标签性能

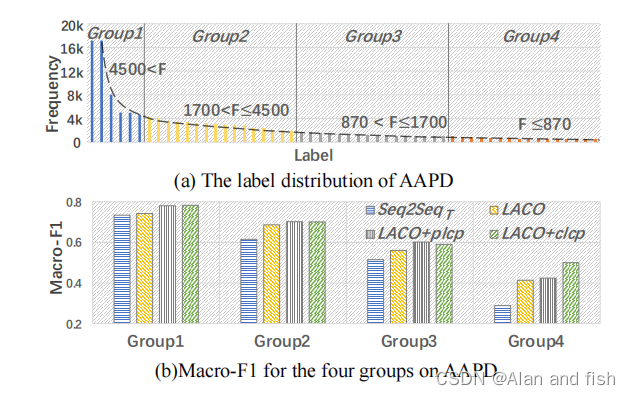

**图2:不同频率分布下的标签分类性能。子图(a)显示了AAPD训练集上每个标签的标签频率分布。子图(b)说明了四组中不同方法的Macro-F1性能 **

图2(a)说明了AAPD训练集上的标签频率分布,这是一个典型的大头-长尾分布。我们根据频率将所有的标签分为四组,即大头组(第1组),高频组(2组)、中频组(3组)、低频组(4组)。如图2(b)所示,我们发现所有方法的性能都随着标签出现频率的增加而降低。基于Seq2SeqT和基于LACO的方法之间的性能差距随着频率的减小而增大.特别是在第4组中,LACO+clcp比Seq2SeqT模型提高了74.5%,这表明,条件标签共现预测任务可以提高低频标签的性能。

7.4 标签相关性分析

标签间的共现关系是反映标签相关性的重要方面之一。在本实验中,我们利用标签

y

a

y_a

ya和

y

b

y_b

yb之间的条件概率

p

(

y

b

∣

y

a

)

p(y_b|y_a)

p(yb∣ya)来定量地表示它们的依赖性。此外,我们计算了

p

(

y

b

∣

y

a

)

p(y_b|y_a)

p(yb∣ya)的条件KL散度,以测量模型预测分布(

P

p

P^p

Pp)和训练/测试数据集(

P

g

P^g

Pg)上的真实分布之间的“距离”。该分数的计算方法为:

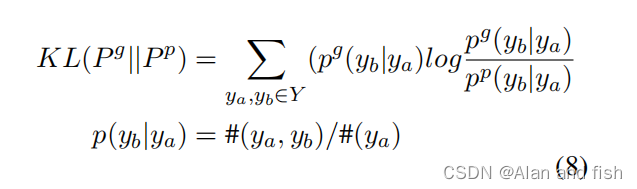

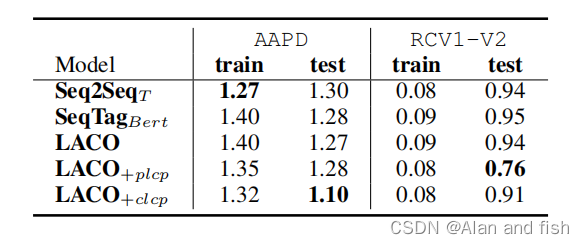

其中,#表示训练/测试数据集中的单个标签或标签组合的数量。AAPD和RCV1-V2数据集上的kl-距离如表5所示.

表5:AAPD和RPV1-V2数据集上不同模型的

K

L

(

P

g

∣

∣

P

p

)

KL(P^g ||P^p)

KL(Pg∣∣Pp)。注意,

P

g

P^g

Pg是数据集的真实分布,

P

p

P^p

Pp是模型分布。分数越小,表明两个分布越接近。

在测试集设置上,我们可以发现LACO对标签之间的依赖关系具有更好的拟合能力,特别是在引入了共现关系预测任务后。Seq2SeqT模型在AAPD和RCV1-V2训练集上都达到了最低的KL距离,但在测试集上达到了更大的分数。这一结论进一步证明了基于seq2seq的模型在训练过程中容易出现过拟合标签对。需要强调的是,这个KL距离只是量化了模型所学习到的标签对之间的相互依赖程度.但它不能直接衡量模型的预测精度。

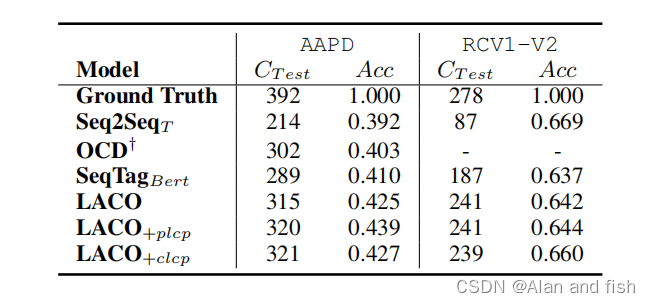

7.5 标签组合多样性分析

表6:关于标签组合的数量的统计数据。

C

T

e

s

t

C_Test

CTest是不同预测的标签组合的数量。Acc是测试集上的子集精度.

表6显示了不同预测标签组合的数量( C T e s t C_{Test} CTest)和子集精度(Acc)的数量,这是一个严格的度量,指示所有标签正确分类的样本的百分比. S e q 2 S e q T Seq2Seq_T Seq2SeqT在两个数据集上产生更少的标签组合。因为他们倾向于“记住”标签的组合,生成的标签集是最相似的,表明对看不见标签组合的泛化能力较差。因为 S e q 2 S e q T Seq2Seq_T Seq2SeqT是保守的,并且只生成它在训练集中看到的标签组合,它获得了较高的Acc值,尤其是在RCV1-V2数据集.对于我们的模型,它们产生更多样化的标签组合,同时获得良好的Acc,因为我们不将多标签分类视为使用解码器来建模标签之间的关系的序列生成任务。相反,我们学习了编码侧标签之间的相关性,而且标签之间的评分不会相互干扰,与seq2seq-based的模型相比,生成在训练中没有看到的标签组合的概率更高。

7.6 覆盖速度

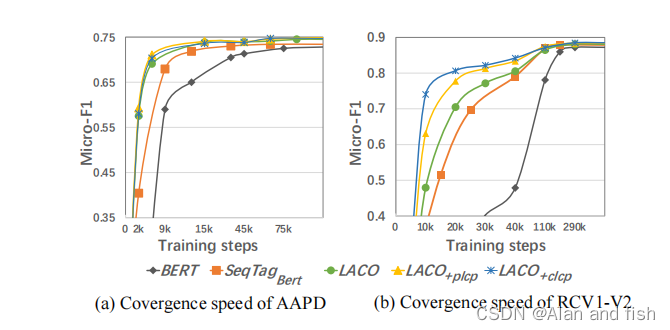

**图3:五种基于bert的方法的收敛速度。x轴为训练步骤,y轴为Micro-F1得分表现。 **

5个基于bert的模型的收敛速度如图3所示。我们的基本模型LACO在收敛速度方面优于其他基于bert的模型,所提出的多任务机制能够增强LACO,加快收敛速度。主要原因可能是通过多任务的特征交换加速了模型学习更健壮和通用的表示。

6.结论和未来的工作

本文提出了一种基于文档-标签联合嵌入和关联感知多任务学习的MLTC新方法。实验结果表明我们的方法大大优于比较的基线模型。详细的分析显示了我们提出的使用文档标签和标签-标签之间的语义连接的架构的有效性,这有助于获得一个有区别的文本表示。此外,多任务框架显示出较强的低频标签预测和标签相关学习能力。

考虑到包含一个非常大的标签集的极端多标签文本分类,LACO可以通过计划标签采样、分层标签嵌入策略等方法进一步开发。我们希望进一步的研究能从我们的工作中得到线索。