热门标签

热门文章

- 1Spring Boot 整合Redis进行数据缓存_spring boot redis缓存数据,提高

- 2python图形界面教程(tkinter)

- 3PHP高校高校图书管理系统设计与实现-附源码04988_php图书管理系统

- 4代码随想录训练营Day 29|Python|Leetcode|1005.K次取反后最大化的数组和 ● 134. 加油站● 135. 分发糖果

- 5【Python】Windows如何在cmd中切换python版本_电脑终端里默认运行的python版本怎么切换_如何改变命令提示符中使用的python版本

- 6数据结构之B树的理解与示例(C#)

- 7windows,dos命令

- 8使用 Diffusers 实现 ControlNet 高速推理

- 9抓包工具Charles的安装及代理设置(Windows浏览器代理、安卓代理)_charles代理怎么设置

- 10uniapp扩展组件---uni-list

当前位置: article > 正文

open-interpreter调用Ollama本地各种模型的方法(如llama3:8b)_ollama调用api 没有响应

作者:知新_RL | 2024-06-15 22:51:26

赞

踩

ollama调用api 没有响应

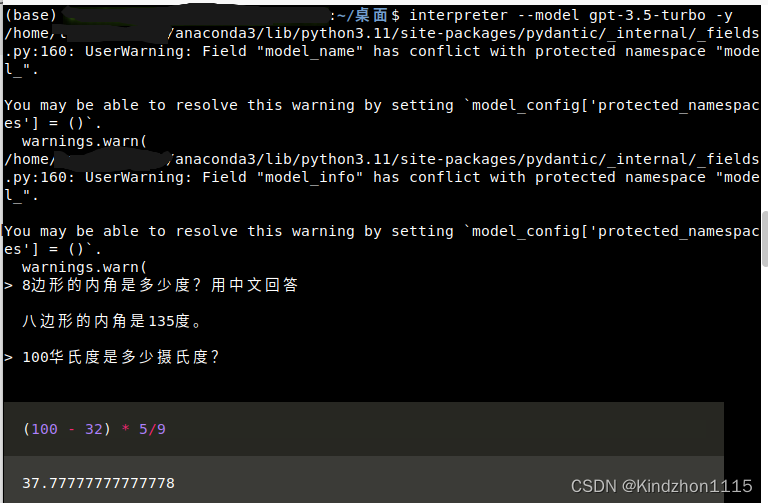

open-interpreter可以使用各种大模型来当基座,也可以使用本地的大模型。

但当我使用Ollama安装好llama3:8b时,用"http://192.168.0.113:8000/api"直接调用api时,却不停的报错:

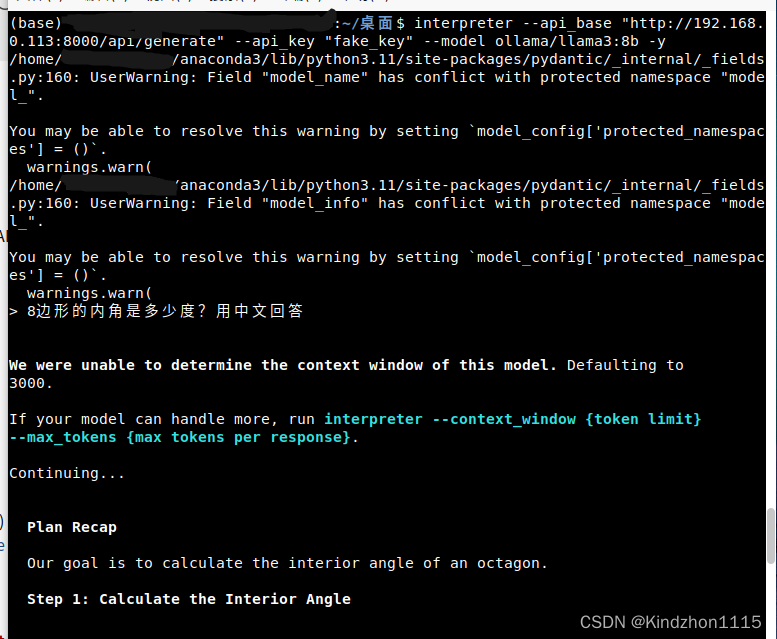

用这个命令行启动时:

interpreter --api_base "http://192.168.0.113:8000/api" --api_key "fake_key"是报这个错误:

raise NotFoundError(

litellm.exceptions.NotFoundError: OpenAIException - 404 page not found

加上指定模型后:

interpreter --api_base "http://192.168.0.113:8000/api" --api_key "fake_key" --model ollama/llama3:8b -y是报这个错误:

httpx.ResponseNotRead: Attempted to access streaming response content, without having called `read()`.

最后终于发现启动命令应该是这个,才是正确的:

interpreter --api_base "http://192.168.0.113:8000/api/generate" --api_key "fake_key" --model ollama/llama3:8b -y

正确的调用方法是http://192.168.0.113:8000/api/generate

如果调用的是微软最新的phi3,则直接使用:

interpreter --api_base "http://192.168.0.113:8000/api/generate" --api_key "fake_key" --model ollama/phi3 -y

至此,完美解决open-interpreter调用Ollama各种模型出错的问题。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/知新_RL/article/detail/724144

推荐阅读

相关标签