- 1接收第三方系统的附件文件转为MultipartFile对象进行存储_接收第三方文件信息和附件

- 22024年目标检测数据集大合集所有下载地址汇总_仓鼠数据集下载

- 3相机系列——透视投影:针孔相机模型_透视投影模型

- 4在使用pro-cli来搭建初始化脚手架时出现:“git‘ 不是内部或外部命令,也不是可运行的程序或批处理文件。”_git' 不是内部或外部命令,也不是可运行的程序 或批处理文件。

- 5牛客网Java测试题解析_public class hasstatic { private static int x = 10

- 6算法数据结构——图的遍历之深度优先搜索算法(Depth First Search)_图的深度优先搜索 试用自己的语言理解图的深度遍历的过程。 并写成下列图的深度遍

- 7Unity3D人物移动篇之刚体跳跃重力下落慢的问题_unity中如何修改刚体下落加速度

- 8nginx的配置:TLSv1 TLSv1.1 被暴露不安全_nginx 放行tls1

- 9select * into 和insert into 备份与插入_select insert into

- 10女生当程序员到底行不行?数学149的女学霸,直言男生也没有比我好!_程序员张功

小学生都能看懂的人工智能原理

赞

踩

前言

人工智能,AI的概念在22/23年随着chatgpt的诞生而爆火,而事实上AI技术在我们日常生活中早已得到广泛应用,从日常使用各类APP,到坐火车飞机。基本上你能想到的日常生活场景都能有AI的一席之地。作为一名研发工程师,我们不需要去深究各种复杂的人工智能模型到底是如何搭建的,但了解人工智能的基本原理对我们对于AI的应用是有帮助的,这里用最简单的方式为大家介绍常用人工智能算法实现原理,保证高中数学水平就能看懂。

什么是人工智能

人工智能(Artificial Intelligence,简称AI)是指利用计算机技术来模拟、扩展和承担人的智能活动的一种技术和科学。人工智能技术可以实现和模拟人类的思维、学习、推理、判断、决策、语言、知识获取和处理等智能活动,具有自主、自适应、自我学习和推理、自我控制等特征。人工智能是目前计算机科学领域的重要研究方向之一,应用广泛,包括自然语言处理、机器翻译、图像识别、语音识别、智能游戏、智能家居、智能医疗、智能交通等领域。

从本质上讲,人工智能要解决的问题绝大部分可以总结为预测结果,而从技术手段来看,人工智能算法大部分可以归类为曲线拟合(观点有争议,详情大家可以看下这个问答)

为什么说人工智能主要解决的是预测问题。我们日常使用的大部分人工智能算法,包括搜索推荐,图片识别,甚至于chatgpt这类通用语言模型都在解决一个问题,即在一个业务场景下给一个输入值,计算机预测输出值应该是什么。以chatgpt为例,用户在输入提示词后,chatgpt做的事情可以理解为根据从网络上获取的问答和文本计算出每个词可能出现的概率,并选出概率最高的一个词作为预测结果输出,同时将前面的输出当作输入再次计算概率并最终生成文本。

举一个具体的例子,我们向chatgpt输入“胖胖是最帅的人吗?”chatgpt计算出“是”这个词出现的概率是50%,“否”出现的概率是20%、“一般般”的概率是15%、“钝角”的概率是10%...,在计算完所有词的概率之后,chatgpt发现“是”的概率最高,因此输出“是”,这时候它会再将“胖胖是最帅的人吗?是”作为输入,chatgpt计算出下个词为空的概率最高,就会结束内容生成。

为什么说人工智能算法大部分可以归类为曲线拟合呢,实际上大部分机器学习算法都是在构建一类模型,这类模型通常会根据已有数据训练出一系列参数,输入值和这些参数做运算后就能得到我们上面说到的预测结果,由于这些参数构成的模型画在坐标系中可以看做一条曲线(1维的情况下),而机器学习算法要做的其实就是找到最能拟合现有数据的曲线,从而能对未知的数据进行预测。

解决预测问题

这里我会用一个让机器自己学会预测房价的例子让大家直观的感受人工智能是如何通过“曲线拟合”来解决现实中的“预测”问题的。实际情况下,预测房价需要的因素有很多,地理位置、朝向、房间个数、面积、层高等,这里为了方便讲解,我们只考虑房屋面积这一个因素,因此读者只需要高中数学水平就能理解这个算法。

问题定义

在这个例子中,我们会让机器学会从一些房价成交数据中找到规律,并且能够自主的根据面积预测房价,在机器学习领域中,这类算法被称为监督学习算法,即通过已有的数据进行训练,实现分类数据或预测结果的功能。我们已有的房价数据格式如下(详情可以见附录)

| 房屋面积(㎡) | 房屋售价(万) |

| 88.64 | 305 |

| 88.75 | 350 |

| 117.12 | 312 |

| ... | ... |

数学建模

有了数据以后,计算机要怎么开始学习呢?我们首先要定义问题,即用数学语言对问题进行描述(这种过程也被称为建模)。为了直观理解,我们直接在二维坐标系中画出这些数据。

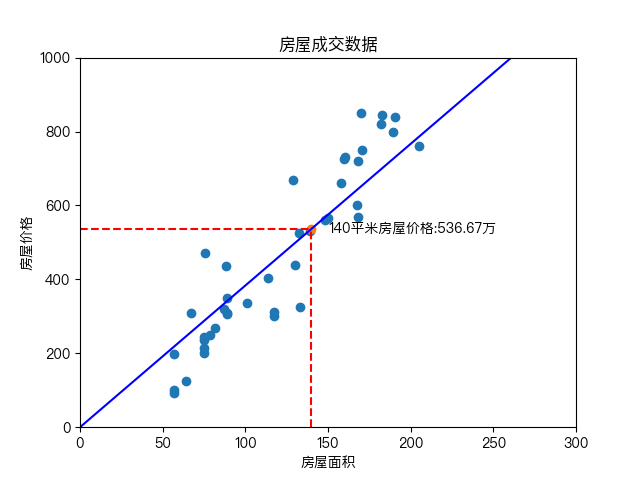

通过观察数据,我们可以做出一个假设,即房屋面积和房屋价格之间呈线简单的性关系,我们可以直接在坐标系中划一条线,这就是我们的模型,如下图所示。

通过这个模型,计算机就可以直接对房价预测。例如一个人的房屋面积是140平米,那么我们可以告诉他,他大约能以535万的价格出售。用高中数学的知识来描述这个模型其实就是一个二元一次函数,(x为房屋面积,函数值为房屋售价)

而实现准确预测的前提是我们需要找到最佳的 参数(即找到最拟合房屋成交数据的直线)。

代价函数

如何评估两个参数的效果呢?在这个场景中,我们可以用已有训练数据的实际值到预测模型的预测值之间的平均距离来定义模型拟合效果,平均距离越小,代表模型越精准,具体计算方式如下,每个红线长度代表一个实际值到预测值的距离

由于求绝对值不便于计算,我们用求平方除以2来替换,同时用稍微书面化一些的语言来描述这个函数

(表示第i行数据的预测值,

表示第i行数据的实际值,m表示训练数据总行数)

我们稍微简化一下就成了如下形式(没学过累加符号不要慌,后面会有更简单的方式)

这个二元二次函数我们称之为代价函数,函数的结果用于衡量模型的预测准确度,对应的函数结果越小,模型预测越精准。此时,我们要解决的问题变成了找到使代价函数最小的

。下面是我们用不同的

得到的模型以及计算出的代价函数的值。

当然,上面这个函数看起来还是有点复杂,我们可以直接把房屋成交数据带入代价函数并简化可以得到如下结果

这个二元二次函数在坐标系中是一个曲面,我们要找的就是这个曲面的最底部,即z最小值对应的

这个时候有同学可能会问,二元二次函数我高中没学过啊?没关系,观察上图我们可以发现,代价函数的值几乎只与有关,而与

几乎无关(由于面积为0的时候房屋价格一定为0,因此线性模型下

应该为0),将

代入后函数就会简化为二元一次。

这个函数我们就非常熟悉了,在坐标系中的表现形式是一条曲线,现在问题终于变成了一道高中数学填空题,找最二元一次函数的最小值

梯度下降算法

高中数学告诉我们,求出函数导数为0的解就可以找到最小值(最大值),但要注意,我们这里为了讲解,只列举了最简单的例子,实际的人工智能模型中参数通常会多达成千上万个,而且通常不会采用简单的线性模型,计算机是无法针对如此复杂的函数求解的,因此我们可以选择一种更适合计算机的方式,梯度下降算法。

我们可以这么理解梯度下降算法,在上述的函数图中随机找一个点,不断以固定步长朝着函数值变小的方向移动,最终找到最小值。在二元函数中,函数值变小的方向可以理解为求导数

如上所示,在第一张图中选取一个点,求导数(这里可以看做求斜率),发现导数大于0,则向左移动一个步长,迭代足够次数后,求得最小值,这里给出求导公式(其实是微分公式)

化简后得到

看起来很复杂,其实将上面代价函数以及房价数据全部带入后得到

算法实现

- def getThetaSimple(x_array, y_array, times, step):

- #先随机选取一个theta

- theat = 10

- for i in range(times):

- print(theat)

- theat -= compute_grad(theat, x_array, y_array) * step

- return theat

-

- def compute_grad(theat, x_array, y_array):

- cost_grad = 0

- for x_index in range(len(x_array)):

- x = x_array[x_index]

- y = y_array[x_index]

- cost_grad += (theat * x - y) * x

- return cost_grad / len(x_array)def getThetaSimple(x_array, y_array, times, step):

- #先随机选取一个theta

- theat = 10

- for i in range(times):

- print(theat)

- theat -= compute_grad(theat, x_array, y_array) * step

- return theat

-

- def compute_grad(theat, x_array, y_array):

- cost_grad = 0

- for x_index in range(len(x_array)):

- x = x_array[x_index]

- y = y_array[x_index]

- cost_grad += (theat * x - y) * x

- return cost_grad / len(x_array)

我们运行一遍迭代一千次的算法,并将每一次迭代的到的画在坐标系中,图像如下

可以看到随着迭代次数增加,的值逐渐收敛至3.96左右,至此,得出用于预测房价的模型。

需要注意的是,我这里为了方便大家理解只是举了一个及其简单的案例,在实际情况中通常不会存在仅有一个特征值的情况,模型也通常不会是简单的线性模型,这时候会应用到的高次多维函数求导以及矩阵运算就不是高中数学水平能够理解的了,这里附上支持任意维度数据的梯度下降算法实现供大家参考。

- #支持任意参数数量的梯度下降算法

- #注意这里为了支持任意参数并且支持矩阵运算,输入参数会人为添加一个0维度

- def getTheta(x,y,times,step):

- a,b = np.shape(x)

- train = np.ones((a,b+1))

- m, n = np.shape(train)

- train[:,1:] = x

- theta = np.zeros(n)

- for i in range(times):

- hp = np.dot(train,theta.transpose())

- error = hp - y

- grand = np.dot(train.transpose(),error)/m

- theta = theta- step*grand

- return train,theta#支持任意参数数量的梯度下降算法

- #注意这里为了支持任意参数并且支持矩阵运算,输入参数会人为添加一个0维度

- def getTheta(x,y,times,step):

- a,b = np.shape(x)

- train = np.ones((a,b+1))

- m, n = np.shape(train)

- train[:,1:] = x

- theta = np.zeros(n)

- for i in range(times):

- hp = np.dot(train,theta.transpose())

- error = hp - y

- grand = np.dot(train.transpose(),error)/m

- theta = theta- step*grand

- return train,theta

解决分类问题

前面讲解房价预测的例子中我们用的就是线性回归算法,这种算法比较适用于预测具体的值。而针对机器学习中的另一类问题-分类,例如根据年龄大小判断是否结婚,我们就需要采用另一种有些类似的算法-逻辑回归来实现。

数学建模

相比较线性回归,逻辑回归的最大变化是在线性模型的基础上增加Sigmoid函数其中z为前面讲的线性模型的输出值,因此我们也可以写作

,以下是Sigmoid函数的图像,可以看到这个函数最大的特点是y值被严格限定在[0,1]的范围内,且x大于0时y大于0.5,x小于0时y小于0.5。

这样模型预测的结果从求具体的值变成了求某一分类的概率。我这里以根据年龄判断是否结婚为例子,判断结果只会有已婚和未婚两种,在上面的模型中,如果给定一个年龄对应输出值是0.7,说明用户已婚的概率是0.7,未婚的概率则是0.3,模型判定用户已婚。

数学模型的直观解释

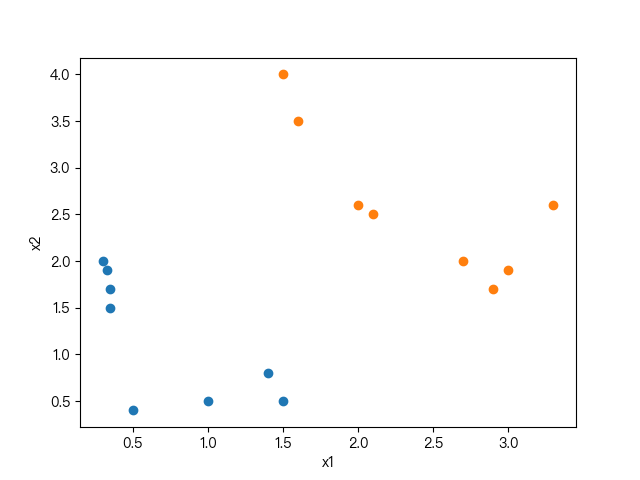

看到这里你可能一头雾水,为啥套了个函数就变成求分类的概率了?我这里简单解释一下上面的sigmond函数到底做了什么事情。假设我们现在有一系列可以分为两类的数据如下图所示。

图中x1和x2分别表示两个特征值(可以理解为我们现在要实现一个判断房屋是在滨江区还是萧山区的算法,并且有了一系列不同面积和售价的房屋数据,其中x1为面积,x2为售价),基于简单线性模型的输出作为sigmond函数输入我们构建了逻辑回归模型,得出的方程如下

这里我们假设参数是,前文讲过,sigmond函数的特性就是y值被严格限定在[0,1]的范围内,且x大于0时y大于0.5,x小于0时y小于0.5,因此当Z值(也就是线性模型输出值)大于等于0时,sigmond函数值将大于等于0.5,我们这里将大于或等于0.5的结果分类为1(滨江),反之分类0(萧山)。因此将参数带入模型很容易得出,当

时,结果分类为1(滨江),否则分类为0(萧山),因此

就是两类数据的分界线,越远离这条线,分类正确的概率越高,这就是sigmond的意义。

当然现实情况下分类问题通常不会这么简单,可能还会有一些比较复杂的数据,比如如下图所示的数据分布

这时候我们需要采用一些比较复杂的模型,例如高次模型作为输入。这个模型在

值分别为[-1,0,0,1,1]时我们得到的是一个半径为1的圆

代价函数

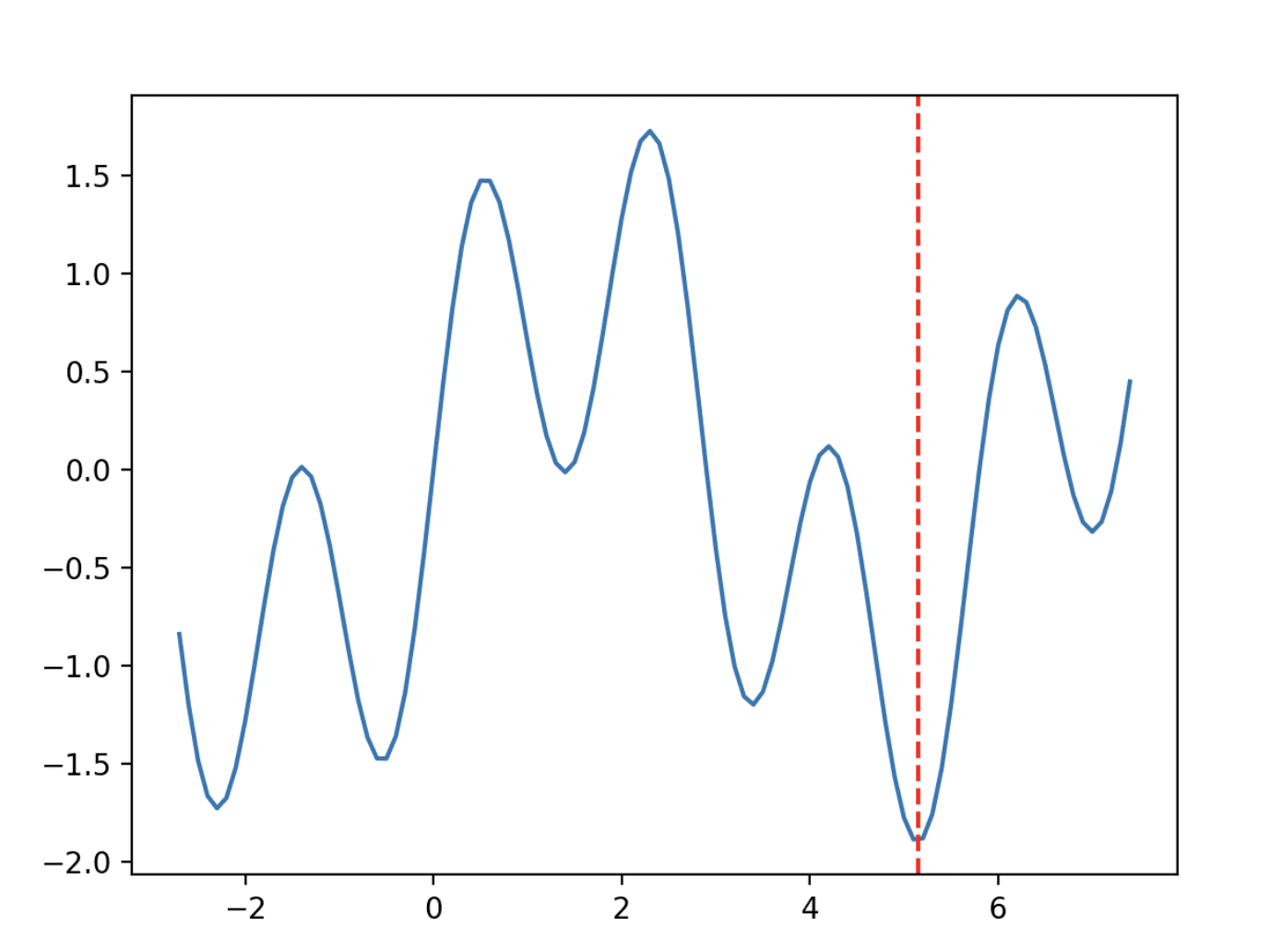

线性回归的代价函数定义可以应用到逻辑回归算法中,但是带入后会发现该函数是一个非凸函数,意味着代价函数存在许多的极小值,我们在这类函数中应用梯度下降算法时程序可能会停在其中某一个极小值(局部最优解)而不是找到全局的极小值(图中红线标出的部分)

因此在逻辑回归中,可能使用的代价函数是这样的,其中

在坐标系中画出与

之间的关系如下图所示:

这样构建的函数的特点是:当实际的

且

也为 1 时误差为 0,当

但

不为1时误差随着

变小而变大;当实际的

且

也为 0 时代价为 0,当

但

不为 0时误差随着

的变大而变大。

套公式就能实现的机器学习算法

贝叶斯公式

前面讲过机器学习算法大部分在做曲线拟合,但是凡是都有例外,比如这一节要讲的朴素贝叶斯算法。贝叶斯算法的鼎鼎大名我这里就不过多介绍了。作为一种能应用在几乎所有你能想象的生活场景中的统计方法,它的公式其实只需要初中水平就能看懂

名词解释:P(A|B)是在B发生的情况下A发生的概率;P(A)是A发生的概率;P(B|A)是在A发生的情况下B发生的概率;P(B)是B发生的概率。

在贝叶斯算法产生前,人们只会计算正向概率,只能解决【已知一个箱子里有3个白球7个黄球,摸出黄球的概率是多少】这类问题,而贝叶斯算法让我们有了能够解决【摸了出1个白球,3个黄球,计算箱子里白球和黄球的比例】这类计算逆向概率的方法。前面我们讲过,人工智能要解决的根本问题就是预测,因此擅长基于已有数据反推概率的贝叶斯算法在人工智能领域应用相当广泛。例如判断是否垃圾邮件,判断是否恶意评论等都可以用到它。

简单应用

我们这里用一个判断恋爱情况的案例简单介绍朴素贝叶斯算法的原理

问题:假设我们已经有了如下数据,我们如何判断一个【有房,没车,抽烟,非常丑,非常高】的人是否单身?

| 是否有房 | 是否有车 | 是否抽烟 | 帅不帅 | 高不高 | |

| 有 | 有 | 否 | 丑 | 非常高 | 非单身 |

| 有 | 有 | 否 | 丑 | 不高 | 单身 |

| 无 | 无 | 否 | 一般 | 非常高 | 单身 |

| 有 | 无 | 是 | 丑 | 非常高 | 单身 |

| 有 | 无 | 是 | 非常帅 | 一般 | 非单身 |

| 无 | 无 | 是 | 非常帅 | 一般 | 非单身 |

| 有 | 有 | 是 | 一般 | 一般 | 非单身 |

| 有 | 无 | 是 | 一般 | 非常高 | 非单身 |

上述问题其实可转换为求有房,没车,抽烟,丑,非常高的前提下单身和非单身的概率,概率更高的就是我们的预测结果,这里直接将问题带入公式

P(单身|有房,没车,抽烟,非常丑,非常高) = P(有房,没车,抽烟,丑,非常高|单身) * P(单身) / P(有房,没车,抽烟,丑,非常高)

直接拿数据套公式计算

P(有房,没车,抽烟,丑,非常高|单身) = 2 / 3 * 2 / 3 * 2 / 3 * 2 / 3 * 2 / 3 = 32 / 243

P(单身) = 3 / 8

P(有房,没车,抽烟,丑,非常高) = 3 / 4 * 5 / 8 * 5/ 8 * 3 / 8 * 1 / 2 = 225/4096

则有房,没车,抽烟,丑,非常高的前提下单身的概率为(32 / 243 * 3 / 8) / (225/4096)

通过同样的方式计算出不单身的概率为(96/3125 * 5 / 8) / (225/4096),和单身的概率进行比较。分母相同的情况下比较分子大小(32 / 243 * 3 / 8)> (96/3125 * 5 / 8)单身概率更大 ,因此预测有房,没车,抽烟,丑,非常高的人应该是单身。

实现文本分析

相比较于线性回归逻辑回归等算法,朴素贝叶斯虽然非常容易理解,实现起来也很简单,但其应用非常广泛,语言模型chatgpt中就有应用。你可能会好奇,前面介绍的基于可量化的数据来实现机器学习算法很容易理解,文本这种难以量化的内容机器是如何分析的呢?这里基于朴素贝叶斯实现一个简单的文本分析算法来做一个介绍。我们现在有一些已分类完成的歌曲,可谓分为“红歌”和“情歌”两种(详情见附件2),这里会基于朴素贝叶斯实现一个机器学习算法,根据已分类的歌曲自动对未分类的歌曲进行分类。

分词和词表

要实现文本分析,重点是将文本转化为可量化的数据,最简单的方式是基于分词+词表的形式。分词顾名思义是将一句话拆分为词。而词表是将分词完成后的全部词组汇集成一个大的列表,列表的长度就是数据的维度,例如如下歌词

红星闪闪放光彩红星闪闪放光彩分词后

['红星', '闪闪', '放', '光彩']['红星', '闪闪', '放', '光彩']对所有分类过的歌词进行分词并汇总就得到一个长度为2409的词表

['为', '歌唱祖国', '瞄准', '唉', '滋味', '柱', '忍不住', '全', '理想', '容不下', '农奴', '不曾', '扬波', '宽广', '战旗', '开了花', '军队', '唱的歌', '红太阳', '叫儿', '19', '后方', '染', '我会', '五斗', '摇', '乐', '艰苦奋斗', '晴空万里', '端起', '寒', '宿营地', '纵情歌唱', '被', '强盗', '记得', '"', '小河', '似海', '抢占', '万里', '温暖', '自己', '今年', '牧民', '野鸭', '天天', '鸟', '转', '成群', '一杆', '水流', '海空', '......', '用', '决定', '努力', '故事', '彩霞', '打', '放声', '死亡', '忽然', '藏', '士兵', '27', '汽车', '平静', '每', '香飘', '想要', '结成', '最美', '路程', '就别', '随', '三年', '带路', '可以', '太行山', '心头', '天上飞', '新天地', '不幸', '沙洲', '长江', '一声', '创', '民族', '像', '独立', '营造', '认份', '红墙', '悲伤', '阳', '人民共和国', '美如画', '用心', '万丈光芒', '北斗星', '一送', '默默', '承受', '受不了', '燃起', '碎', '靠', '问', '环绕着', '曾经', '轻轻', '某一人', '指望', '描绘', '过去', '绿浪', '明媚', '泪汪汪', '东方', '黄莲脸', '比钢', '林带', '照得人', '小小', '土枪', '天涯', '21', '41', '挽手', '比天', '梦中', '空中', '整座', '屋檐', '投降', '美', '顽强', '声', ';', '劈涛', '身暖', '火炬', '整', '革命理想', '这么', '山高水', '拣', '跳', '轻易', '细雨', '日夜', '遥', '金黄', '哟', '客人', '背叛', '星星', '说服', '青纱帐', '小鸟', '密密的', '前方', '以后', '清楚', '千秋万代', '小', '花瓣', '合', '冷风吹', '出来', '来到', '10', '麦穗', '明白', '看惯', '慈悲', '奢侈', '江岸', '处处', '满地', '昏头昏脑', '天涯海角', '它们', '崩', '一年', '南泥湾', '树树里', '不甜', '有人', '迎面', '风在', '掉下来', '野鹿', '祝福', '严寒', '牛羊', '画', '心胸', '荣耀', '边上', '解放战争', '锦绣河山', '开出', '五谷', '好比', '介支个', '战马', '愤怒', '丰收', '坦平', '者', '最好', '雪山', '事业', '眼中', '那年', '不问', '的话', '长征', '年', '围屏', '春常', '罗', '情深谊长', '目光', '驱', '觉得', '照', '修起', '亲吻', '没', '有', '兴旺', '一生', '千金', '盼', '向', '抹', '千里', '依靠', '站岗', '害怕', '依然', '怀念', '遇到', '共产党', '瓜果', '苍老', '穷', '花蓝', '中华民族', '阳光灿烂', '雄心', '迎着', '26', '羊', '憧憬', '战鹰', '密', '踢', '硬', '尚', '绵绵', '画面', '相连', '香榭', '回乡', '模糊', '淋', '改造', '忙', '壮大', '49', '开在', '一些', '泛起', '栋梁', '深情', '平原', '卷', '若要', '花园里', '每根', '谁', '不进', '一朵朵', '造成', '很小', '到', '阿姨', '炮', '松柏', '模样', '真', '人来人往', '遮盖着', '红蓝', '您', '面容', '放', '硬骨头', '去', '迷路', '热恋', '它', '子弹', '顶天', '远', '里格', '只在乎', '江山', '衷心', '缠绕', '双双', '坚定不移', '巷子', '早上', '百', '心甘情愿', '要是', '时刻', '我度', '日本', '诉说着', '开遍', 'Do', '品格', '开始', '出生', '光', '理由', '不该', '金色', '不悔', '回山', '任人宰割', '伟大祖国', '走远', '领导', '自', '塔影', '买', '望见', '紧握', '白鸽', '盖成', '红棉', '巨人', '18', '挽救', '寄', '梧桐', '42', '欢庆', '贴近', '伴着', '临江', '景', '晚', '月亮', '公路', '后', '滚滚', '种豆', '传颂', '无故', '喜悦', '原油', '山高林', '天不怕', '代表', '秒', '曾', '?', '鼓', '相距', '脸上', '前面', '昆仑山', '改变', '每条', '十三岁', '天', '漫步', '就', '安全', '迎春', '山坡', '距离', '红军', '轻抚', '梯田', '杀败', '开满', '寂寞', 'Music', '举动', '匆匆', '受罪', '群众', '很近', '花儿', '开放', '一唱', '时光', '战线', '跨过', '比翼', '路上', '海疆', '掩', ')', '结局', '种瓜', '大寨', '挣开', '怀中', '碎片', '组合', '五指山', '命运', '山河', '八一', '?', '落花', '天堂', '骑兵', '顺从', '赞美', '血肉', '群山', '逞凶', '沸腾', '棒棒', '承诺', '人为', '紧闭', '微笑', '强国', '感觉', '那时', '拿', '这个', '大家', '延长', '支离破碎', '毕竟', '扬起', '无情', '人民战争', '并蒂', '当个', '赶', '富', '波浪', '现阶段', '淌', '彻底', '这样', '!', '才', '日子', '哭', '旁', '普照大地', '只', '分享', '亲人', '夺', '船上', '前进', '人生', '阵阵', '天明', '唤醒', '雄鹰', '几时', '嘿', '轰隆隆', '中原', '靳逞', '滋润', '情歌', '初见', '提醒', '上', '牧羊', '自有', '完全', '立', '我们', '到底', '里', '满带', '情绪', '站', '蒋匪', '千言万语', '12', '海洋', '没看', '达到', '离不开', '不要', '饼', '无所谓', '吼叫', '如何', '17', '放肆', '分开', '疼', '爱情', '街道', '中', '那里', '就要', '跟', '作和声', '管它', '野菜', '动人', '保卫祖国', '赛呀赛', '气球', '硬撑', '呵', '走心', '工人阶级', '什么', '风中', '街', '年少', '得儿', '北国', '之前', '格拉', '祖国颂', '万年青', '慌', 'La', '男', '爱上', '不敢', '边', '喔', '并', '6', '好威风', '生活', '坚强', '战场', '继续', '心事', '晴天', '冰冷', '寒冬腊月', '夕阳', '留', '机器', '追忆', '找寻', '迷失', '收起', '躲', '早日', '美丽', '不忍', '高', '虎豹', '无', '妻子', '别', '身', '太', '发出', '家乡', '风光', '暖', '唇印', '来来来', '风吹雨打', '些', '以往', '团结友爱', '蔼', '不屈', '看着', '难有', '只会', '秘密', '丰满', '画凤', '错', '熬过', '爱', '写', '变成', '高高的', '草原', '雅鲁藏布江', '三送', '带', '遭殃', '春光', '怎么样', '亮', '母亲', '双唇', '人民军队', '沉睡', '心太急', '掉落', '棉似', '银光', '世界', '这里', '夜里', '知道', '鲤鱼', '份', '晚霞', '日记', '每束', '挽回', '7', '惊起', '路开', '歌声', '红领巾', '浪', '围剿', '等待', '哪里', '见', '.', '上前', '软弱', '井冈山', '平安', '地响', '心里', '勇敢', '怎能不', '金光', '我爱你', '在所难免', '过握', '乌云', '强大', '温热', '思情', '矫健', '醉人', '给', '山野', '主张', '双桨', '勇士', '海浪', '海员', '阻止', '眼泪', '借', '时候', '草毯', '仇恨', '终于', '开火', '遍地', '壮丽', '舌', '玩耍', '西施', '爱家乡', '不会', '气势', '~', '不必', '含着', '打天下', '咿儿', '忘', '我要', '拜', '放晴', '毛泽东', '蝴蝶', '长茧', '可', '哄', '里个', '痴', '良田', '建立', '古老', '高中', '守护', '推开', '树', '路', '苦难', '耳机', '了', '狠', '不', '丰富', '竞相', 'Re', '一夜', '燃烧', '这片', '叔叔', '云朵', '高于', '血染', '爱心', '但是', '无边', '口中', '天寒地冻', '看不见', '东风', '红梅', '最怕', '救', '放不下', '无声', '新', '朝霞', '战士', '烽火', '千百里', '蓝天', '迷恋', '羽毛', '渐渐', '一扇', '穿梭', '无味', '石油', '加快', '说出', '接过', '分派', '飞行', '可会知', '边防军', '三九', '英雄', '军民鱼水', '彩门', '过得', '小船', '下面', '气势磅礴', '惊涛骇浪', '作', '门窗', '农隶', '教室', '常青', '中南海', '烟波', '任', '计较', '头顶', '枯萎', '自我', '沿着', '柔软', '唱歌', '后悔', '写下', '永不', '宿舍', '滚烫', '心像', '照样', '踩', '第一回', '子弟兵', '翻', '同样', '响亮', '收豆', '借口', '山沟', '铁路', '真相', '侧后方', '决心', '梦之旅', '轰响', '感到', '白帆', '身体', '鱼', '青蓝', '天使', '保证', '还要', '矢', '哪怕', '无数', '笑声', '赞颂', '希望', '阵线', '钢铁', '永远', '号子', '全都', '很', '伤感', '得', '伤害', '树林', '可能', '望月', '鞭子', '河', '高原', '全世界', '无际', '想', '一起', '缠', '鱼水', '感染', '眼睛', '碧波', '错觉', '万泉河', '铁墙', '任随', '迎风', '敌歼', '头戴', '懂', '晃到', '谋', '日', '知己', 'music', '姑娘', '一般', '我亲', '昨天', '岭上', '付出', '矿山', '古城', '开心', '白杨树', '四面', '飘落', '辉煌', '还是', '那样', '从无到有', '-', '遇见', '看作', '大旗', '约会', '33', '乱冲', '筑成', '倒映', '一齐', '永', '晚灯', '印', '此刻', '敲', '对', '哀号', '擦肩而过', '无怨无悔', '壮', '真情', '青草', '风雨', '甜蔗', '时', '旁边', '陕北', '流泪', '长', '每日', '每天', '天顶', '前途', '随风飘荡', '35', '相信', '油桐', '飘', '抗日', '嗨', '保卫', '占据', '果儿', '枪炮', '靠着', '挥霍', '严阵以待', '允满', '瑞金', '宽畅', '气息', '指尖', '呀', '危急', '向着', '湖边', '小心', '课', '荒原', '心窝', '工农', '双眼', '骗人', '塞纳河畔', '从今', '天山', '战舰', '泥土', '骄傲', '车窗', '毡房', '海面', '久', '怎能', '十万', '兄弟', '小伙儿', '只要', '颠倒', '完整', '白云', '怨', '无论谁', '涌', '独', '来自', '胸口', '建造', '舍生忘死', '工人', '31', '船儿', '手握', '象征', '中国', '吼', '万岁', '安排', '湖中', '树下点', '突破', '彷佛', '首创', '草地', '英勇', '需要', '爆破筒', '就此', '时想', '像是', '高梁', '赛', '收成', '绿', '翘', '珍惜', '踪和影', '不盼缘', '真不少', '充满', '冷漠', '坚定', '捎信', '抽', '赞', '秋日', '土地', '仍', '24', '深处', '长矛', '天山南北', '心儿', '砸碎', '有多美', '早餐', '豺狼', '远客', '看到', '畏畏缩缩', '高台', '二月', '怒目', '胸中', '阵地', '38', '迈开', '流水', '感应', '强', '共', '依旧', '一句', '波澜壮阔', '捐些', '名叫', '响起', '喜欢', '鞭儿响', '林海', '28', '飘飘', '情意', '换', 'he', '蛋', '我试', '摔死', '再美终', '还', '书信', '忧伤', '翻身', '一点', '成功', '力量', '皑皑', '如铁', '想像', '闪闪', '日落', '消灭', '首歌', '袂', '知难而退', '湖水', '洋枪', '家园', '讲', '出', '看透', '铁锁链', '苦苦', '和', '强求', '一层层', '时代', '黑暗', '亲手', '16', '马', '闹革命', '好好', '嘴', '不理', '说谎', '五送', '九送', '前程', '怎么', '意义', '窗', '所以', '越', '白雪', '愿意', '但愿', '感谢', '手', '她', '艄公', '灿烂', '亲善', '最爱', '长城', '无踪', '磨', '扩张', '红旗飘飘', '唯一', '辽阔', '埋伏圈', '海防线', '火车头', '脚边', '好', '山冈', '牺牲', '青松', '象', '有点', '始终', '吻', '响', '摘', '也许', '坡', '从', '看吧', '猎枪', '广场', '缘分', '太阳', '哎', '赞歌', '变了样', '交换', '荷塘', '咆哮', '变', '看', '11', '盼望', '如钢', '年老', '难受', '捡', '荒山', '得到', '大树', '新春', '捎', '满', '歌', '刮风', '肥', '旧', '勇气', '走入', '四年', '花言巧语', '…', '加紧', '武装', '必死', '彩蝶', '烟成', '高举', '山路', '变冷', '一会儿', '回来', '俺', '夏天', '回', '拥挤', '红', '肯定', '海深', '差错', '就象', '梦', '没考上', '山头', '向前', '(', '撒下', '祖国', '良心', '阳光', '抬头', '离骚', '冷', '琴', '真爱', '一条心', '和平', '江南', '天安门广场', '根本', '珍珠', '买卖', '让', '充饥', '似', '礼物', '年代', '好山好水', '撩乱', '年轻', '香', '彩', '含', '放手', '同', '草', '一杯', '挣扎', '望', '升起', '明天', '随便', '百万', '劳动', '十丈', '一整瓶', '一回', '朋友', '一个', '送郎', '改善', '颂歌', '指', '活下去', '8', '村庄', '找', '青年', '吃', '大学', '万古', '痴情', '今天', '离人', '渠水', '伤', '一阵阵', '太阳升', '22', '也', '巡逻', '朵朵', '垂危', '愉快', '领袖', '操场', '咱们', '不怕难', '放牛郎', '.......', '撒', '清泉', '要', '照得', '冷冷的', '延安', '与', '最后', '骏马', '听到', '影子', '煮', '原来', '说唱', '谁种', '左岸', '跟着', '反攻', '认真', '掌权', '忍受', '交错', '都', '会试', '城市', '不是', '风', '就是', '4', '变迁', '花', '飘扬', '待', '诶', '怒放', '卑污', '算', '湘', '展', '夜半三更', '云霞', '无敌', '成就', '千万', '抬起', '呼儿', '锣儿', '造', '献身', '哪儿', '呦', '安慰', '意气风发', '做', '回忆', '掉', '请', '十六', '一切', '再次', '送', '红旗', '早', '就算', '种子', '心连心', '30', '门', '说梦话', '率领', '长长的', '紧', '介支格', '井', '河边', '清晰可见', '热爱', '男女老少', '掩护着', '白塔', '最深', '无比', '混乱', '深根', '实行', '法西斯蒂', '不知', '伟大领袖', '染红', '永夜', '大雨', '失去', '苦干', '肥来', '绿树', '安康', '拥抱', '南海', '可爱', '生产', '花朵', '离去', '月色', '下', '现在', '真心', '低头', '天安门', '写错', '俯瞰', '芦苇', 'So', '紧紧', '歌颂', '头发', '鲜', '最亲', '骗', '或许', '出卖', '薄', '仰望', '洒满', '飞去', '绿色', '稻', '无端', '37', '眼睁睁', '留下来', '50', '开车', '乐曲', '梳子', '光辉', '哪请', '扬鞭', '签', '索玛', '游击队', '皮鞭', '金灿灿', '威武雄壮', '离别', '八年', '大到', '朝阳', '家家户户', '丰润', '落', '酒', '远方', '不落', '打败', '读书', '我愿', '拨弄', '。', '庄严', '只生', '赣江', '幸福', '跨', '云海', '哨所', '进', '小黄花', '44', '闭上', '牛', '越来越少', '样子', '九月', '化', '温习', '浪潮', '颂', '东洋', '河西', '城墙', '千山万壑', '输赢', '抵抗', '多久', '清', '爱将', '试着', '云雾', '扫荡', '抗战', '岩上', '已', '盘', '白莲花', '摆', '再也', '搅拌', '背', '水', '等', '多年', '儿记', '相爱', '拜拜', '石上', '金星', '正', '在历史上', '万丈', '听', '咱', '仙女', '这台', '道路', '45', '解放', '扎营', '啊呀', '王子', '愿', '人民', '云和雾', '人心', '浪漫', '每晚', '带领', '吧', '唱', '足够', '离', '东北', '捷报', '后心', '深', '那山', '反正', '泥', '革命队伍', '下课', '挺立', '大庆', '个人', '掰', '总有一天', '暴风', '五月', '开辟', '参战', '红花', '000', '准备', '星', '同胞', '指引', '弹着', '季节', '水兵', '枪口', '山里', '天色', '春雷', '献', '不闻不问', '亲兄弟', '叫', '童话', '我家', '狂', '村镇', '吹得', '干部', '面对', '篝火', '恋爱', '千锤百炼', '相约', '但', '收到', '鲜艳', '雷', '我手', '为什么', '淙淙', '边防线', '四方', '总有', '开天辟地', '蓝色', '叫做', '贪', '破', '山歌', '茫茫', '朝', '二小', '流萤', '喷火', '不分富', '期待', '大石头', '没有', '何所惧', '黑眼圈', '随处', '不肯', '侵略者', '舄', '沦亡', '雨', '关心', '跳动', '比较', '天真', '空嘴', '每一寸', '冲', '歌舞升平', '一片丹心', '恩情', '秋千', '双手', '叶落', '如果', '建设', '心碎', '奔腾', '白色', '带走', '心', '披荆斩棘', '几千', '山峰', '城堡', '起', '身边', '放在', '地方', '天上', '大', '星空', '荷花', '蓬勃', '井岗山', '搞砸', '尽', '碧水', '怒吼', '高歌', '现代化', '个', '海里', '40', '划出', '海防', '长得', '飞', '5', '47', '凉爽', '骗骗', '一样', '挂', '两万五千里', '容易', '玫瑰', '善变', '崭新', '仿佛', '乒乒乓乓', '十分', '腐烂', '停留', '河东', '平常', '开', '毛泽东思想', '侵犯', '如火遍', '根据地', '埋藏', '听惯', '鲜花', '睡', '革命道路', '打越', '多少', '共产主义', '狂乱', '稻田', '映照', '心中', '天空', '包围', '14', '如今', '拼到底', '飘荡', '翅膀', '瓜', '拱手让人', '炮声', '勤恳', '贡献', '下雨天', '片片', '大道', '岁月', '鲜红', '不动', '痴心', '拉着', '爱情故事', '琴声', '吉祥', '错过', '把', '割断', '四下里', '尽寒枝', '春天', '风沙', '王二小', '指路', '雨水', '万朵', '同志', '那些', '四周', '孤雁', '铺', '盛开', '思念', '意外', '有情', '照遍', '游击', '海南岛', '骄傲地', '一望无边', '落叶', '我身', '火红', '斜阳', '‘', '忍住', '大海', '脚下', '我心', '离开', '曲折', '飞来', '进入', '万山', '誓', '爱过', '战略', '进攻', '39', '张开', '大刀', '翻江倒海', '毛主席', '身旁', '若', '祥和', '甜如蜜', '雄伟', '青春', '钟', '外', '人人', '下河', '万年', '抚育', '无法', '那天', ',', '清晰', '丈', '绑票', '海', '泪', '喜讯', '勒', '出现', '一片', '忠于党', '一遍', '狠心', '哗啦啦', '浇灌', '红星', '迎', '居住', '红台', '五彩', '种田', '田间', '从此', '日照', '一丝丝', '认识', '刀', '冰霜', '雪', '隆', '绕', '不到', 'He', '拥', '万代', '戈壁', '耸立', '井架', '献给', '回家', '比', '当初', '大地', '痛苦', '那么', '弟兄', '儿女', '坚持', '一首歌', '东方红', '发现', '荡起', '抱定', '滑落', '机关', '奔', '曙光', '工作', '23', '一季', '公寓', '情书', '囚禁', '平凡', '如', '荣光', '真的', '不怕', '带路人', '昏暗', '儿', '七送', '花落', '民主', '思想', '雕龙', '这天', '会', '独行', '可惜', '这', '童年', '每个', '声响', '炊', '更好', '外衣', '过往', '驱散', '斗志昂扬', '从来', '雷电', ')', '勤劳', '向阳', '经过', '挑', '兵强', '侵衣骨', '鲜血', '丢', '他们', '军', '心肠', '黑夜', '连', '下送', '道', '行列', '追问', '飞奔', '流', '行驶', '告白', '逼', '隅', '航程', '我该', '走', '粮如山', '徘徊', '展翅飞翔', '男人', '映', '团结', '开启', '高山', '46', '告诉', '响叮当', '\n', '侧耳', '放牛', '又', '繁荣', '飞过', '歌唱', '军旗', '种', '留下', '伐木', '传捷报', '片刻', '流言蜚语', '结果', '25', '泉罗', '秋天', '难', '多保', '双飞', '我能', '拥有', '天地', '流眼泪', '求求', '学会', '队伍', '何必', '背影', '43', '锻炼', '辛劳', '黄河', '发奋图强', '一弯', '亭', '金鼓', '大路', '陪', '谷穗', '简单', '凯旋', '怕', '亲爱', '旧社会', '好像', '充军', '风传', '人潮', '适合', '煤矿', '到处', '山巅', '即将', '山间', '写给', '整个', '秧苗', '一', '压迫者', '已经', '之情', '肆无忌惮', '债', '制度', '嗨哟', '钢', '风烟', '太多', '诺言', '方向', '可是', '快乐', '粮', '坚', '最', '老乡', '一条', '带风', '华北', '似人', '山上', '声声', '昆仑', '脸', '同甘苦', '当有', '定', '抓住', '感情', '穿', '空气', '除了', '.', '万水千山', '恋人', '还有', '头', '再见', '...', '映山红', '他', '将', '千重', '歌儿', '一直', '清波', '躲过', '温柔', '海岸', '浓烈', '齐', '冲动', '眼神', '(', '最苦', '慢慢', '铁锤', '34', '一颗', '江畔', '传遍', '反', '一家人', '田野', '山', '再', '红梅赞', '灭亡', '接受', '明', '乳汁', '北京', '以为', '36', '这些', '飘处', '相恋', '无论', '多', '神枪手', '敢', '生命', '百鸟', '手指', '干劲冲天', '灼身', '冬夏', '最贵', '爱上你', '拳头', '我用', '首都', '社会主义', '党', '所有', '唱支', '合唱', '一间', '楼房', '红色', '乎', '记忆', '里瑟', '无计可施', '宽', '主席', '春', '秋风', '汗珠', '别人', '树上', '根', '那', '兵', '言语', '难过', '分', '一心', '黄昏', '肥大', '海军', '弯弯的', '飞舞', '揍', '古早', '完', '石岩', '军民联防', '好不容易', '荡', '转危为安', ':', '灿灿暖', '岸上', '安歇', '野茫茫', '点头', '照耀', '人马', '无限', '战胜', '绿草', '人们', '消失', '风吹', '海来', '瑟罗', '学校', '起伏', '敌后', '求', '困难', '一棵', '最暖', '敌人', '慌乱', '好处', '泪淋林', '宝藏', '熬煎', '咱全', '天有', '麦浪', '不能', '大河', '地下', '名字', '鹅毛雪', '繁荣富强', '不见', '走向', '看见', '美好', '号召', '我租', '奔驰', '城', '迷人', '棵', '步伐', '那个', '河畔', '光明', '剩下', '各', '革命', '有种', '叶', '拼命', '人', '、', '一首', '成长', '等到', '放下', '搭', '矢掉', '不变', '逃不了', '吹', '胜利', '割下来', '百灵鸟', '流过', '纯', '满腔', '虽然', '挥动', '条条', '幻灭', '地', '杯', '躺', '救星', '云天', '迎接', '城乡', '20', '没差', '拒绝', '当', '9', '铜壁', '没想到', '天罗地网', '捱', '不可', '受', '因为', '各族人民', '起来', '铝盔', '虚伪', '气质', '热血', '不歇', '凶', '花店', '千军万马', '决不', '仍然', '地平线', '偏偏', '新长征', '荡秋千', '征途', '扎', '牛儿', '十送', '阻挡', '梦境', '包谷', '衣裳', '碰', '笑', '嘉', '钢枪', '鸟儿', '可有可无', '任性', '来', '在', '与非', '五星红旗', '咖啡', '长虹', '这是', '红光', '直到', '甜蜜', '走过', '断粮', '轻触', '路旁', '怀抱', '屈辱', '后来', '!', '---', '唇', '霞光', '一群', '森林', '奔跑', '摆下', '最红', '欢笑', '心上', '疲倦', '胸怀', '鸿雁', '浩浩', '志士', '中华儿女', '能够', '不尽', '两岸', '了解', '万', '猪', '想念', '15', '自力更生', '红心', '才能', '向前走', '节日', '嘱咐', '工厂', '不需', '配有', '满船', 'Si', '放眼世界', '想起', '黎明', '往年', '河北', '时时刻刻', '枪尖', '住', '野果', '卖', '闪', '巍然屹立', '不吃', '四万万', '高空', '哨兵', '灯', '倒影', '举起', '几何', '河水', '人烟', '—', '边迎', '正在', '家', '身上', '昂首', '寒冬', '花香', '眼前', '好似', '万古流芳', '响雷', '在乎', '泉水', '飞行员', '’', '一片片', '明亮', '硕果', '春风', '孤单', '遍', '保', '身披', '吹遍', '抱歉', '13', '吗', '碧绿', '高楼大厦', '风儿', '48', '犯', '熟', '后面', '往事', '不期而遇', '志越', '百姓', '追', '甘心', '路途', '青山', '天亮', '是不是', '能', '品尝', '多么', '目的', '千千万万', '朝着', '蓝蓝的', '一天', '携手前进', '微带', '如同', '闯', '伤心欲绝', '官兵一致', '却', '生长', '一座座', '山岗', '们', '枪', '说', '战鼓', '暗恋', '是否', '心脏', '白玉', '绿油油', '功绩', '坚固', '归来', '烈日', '江', '马儿跑', '庄稼', '烧伤', '过', '从前', '战斗', '胸怀祖国', '童话故事', '水中', '憔悴', '国家', '英豪', '重围', '时间', '睦邻', '千年', '夜深人静', '许多', '放弃', '爱祖国', '柔情', '不了', '心意', '往下', '伟大', '传扬', '松树', '金丝鸟', '雾气', '为了', '风雪', '更', '自由', '动', '32', '果树', '曾用', '热泪', '河流', '千万颗', '忘掉', '灯光', '主人', '汉', '湿透', '原野', '孩子', '天天向上', '线', '飞翔', '坚决', '丛中', '百花', '斗争', '不分', '纷飞', '女', '..', '着', '起雾', '守卫', '前奏', '比铁', '铁', '伤悲', '边疆', '毡', '犁锄', '炉火', '越过', '地活', '传', '搏斗', '饭碗', '巍峨', '垫', '气焰', '催', '回到', '灿烂辉煌', '埋葬', '呼吸', '啊', '光彩', '心扉', '斩浪', '之歌']['为', '歌唱祖国', '瞄准', '唉', '滋味', '柱', '忍不住', '全', '理想', '容不下', '农奴', '不曾', '扬波', '宽广', '战旗', '开了花', '军队', '唱的歌', '红太阳', '叫儿', '19', '后方', '染', '我会', '五斗', '摇', '乐', '艰苦奋斗', '晴空万里', '端起', '寒', '宿营地', '纵情歌唱', '被', '强盗', '记得', '"', '小河', '似海', '抢占', '万里', '温暖', '自己', '今年', '牧民', '野鸭', '天天', '鸟', '转', '成群', '一杆', '水流', '海空', '......', '用', '决定', '努力', '故事', '彩霞', '打', '放声', '死亡', '忽然', '藏', '士兵', '27', '汽车', '平静', '每', '香飘', '想要', '结成', '最美', '路程', '就别', '随', '三年', '带路', '可以', '太行山', '心头', '天上飞', '新天地', '不幸', '沙洲', '长江', '一声', '创', '民族', '像', '独立', '营造', '认份', '红墙', '悲伤', '阳', '人民共和国', '美如画', '用心', '万丈光芒', '北斗星', '一送', '默默', '承受', '受不了', '燃起', '碎', '靠', '问', '环绕着', '曾经', '轻轻', '某一人', '指望', '描绘', '过去', '绿浪', '明媚', '泪汪汪', '东方', '黄莲脸', '比钢', '林带', '照得人', '小小', '土枪', '天涯', '21', '41', '挽手', '比天', '梦中', '空中', '整座', '屋檐', '投降', '美', '顽强', '声', ';', '劈涛', '身暖', '火炬', '整', '革命理想', '这么', '山高水', '拣', '跳', '轻易', '细雨', '日夜', '遥', '金黄', '哟', '客人', '背叛', '星星', '说服', '青纱帐', '小鸟', '密密的', '前方', '以后', '清楚', '千秋万代', '小', '花瓣', '合', '冷风吹', '出来', '来到', '10', '麦穗', '明白', '看惯', '慈悲', '奢侈', '江岸', '处处', '满地', '昏头昏脑', '天涯海角', '它们', '崩', '一年', '南泥湾', '树树里', '不甜', '有人', '迎面', '风在', '掉下来', '野鹿', '祝福', '严寒', '牛羊', '画', '心胸', '荣耀', '边上', '解放战争', '锦绣河山', '开出', '五谷', '好比', '介支个', '战马', '愤怒', '丰收', '坦平', '者', '最好', '雪山', '事业', '眼中', '那年', '不问', '的话', '长征', '年', '围屏', '春常', '罗', '情深谊长', '目光', '驱', '觉得', '照', '修起', '亲吻', '没', '有', '兴旺', '一生', '千金', '盼', '向', '抹', '千里', '依靠', '站岗', '害怕', '依然', '怀念', '遇到', '共产党', '瓜果', '苍老', '穷', '花蓝', '中华民族', '阳光灿烂', '雄心', '迎着', '26', '羊', '憧憬', '战鹰', '密', '踢', '硬', '尚', '绵绵', '画面', '相连', '香榭', '回乡', '模糊', '淋', '改造', '忙', '壮大', '49', '开在', '一些', '泛起', '栋梁', '深情', '平原', '卷', '若要', '花园里', '每根', '谁', '不进', '一朵朵', '造成', '很小', '到', '阿姨', '炮', '松柏', '模样', '真', '人来人往', '遮盖着', '红蓝', '您', '面容', '放', '硬骨头', '去', '迷路', '热恋', '它', '子弹', '顶天', '远', '里格', '只在乎', '江山', '衷心', '缠绕', '双双', '坚定不移', '巷子', '早上', '百', '心甘情愿', '要是', '时刻', '我度', '日本', '诉说着', '开遍', 'Do', '品格', '开始', '出生', '光', '理由', '不该', '金色', '不悔', '回山', '任人宰割', '伟大祖国', '走远', '领导', '自', '塔影', '买', '望见', '紧握', '白鸽', '盖成', '红棉', '巨人', '18', '挽救', '寄', '梧桐', '42', '欢庆', '贴近', '伴着', '临江', '景', '晚', '月亮', '公路', '后', '滚滚', '种豆', '传颂', '无故', '喜悦', '原油', '山高林', '天不怕', '代表', '秒', '曾', '?', '鼓', '相距', '脸上', '前面', '昆仑山', '改变', '每条', '十三岁', '天', '漫步', '就', '安全', '迎春', '山坡', '距离', '红军', '轻抚', '梯田', '杀败', '开满', '寂寞', 'Music', '举动', '匆匆', '受罪', '群众', '很近', '花儿', '开放', '一唱', '时光', '战线', '跨过', '比翼', '路上', '海疆', '掩', ')', '结局', '种瓜', '大寨', '挣开', '怀中', '碎片', '组合', '五指山', '命运', '山河', '八一', '?', '落花', '天堂', '骑兵', '顺从', '赞美', '血肉', '群山', '逞凶', '沸腾', '棒棒', '承诺', '人为', '紧闭', '微笑', '强国', '感觉', '那时', '拿', '这个', '大家', '延长', '支离破碎', '毕竟', '扬起', '无情', '人民战争', '并蒂', '当个', '赶', '富', '波浪', '现阶段', '淌', '彻底', '这样', '!', '才', '日子', '哭', '旁', '普照大地', '只', '分享', '亲人', '夺', '船上', '前进', '人生', '阵阵', '天明', '唤醒', '雄鹰', '几时', '嘿', '轰隆隆', '中原', '靳逞', '滋润', '情歌', '初见', '提醒', '上', '牧羊', '自有', '完全', '立', '我们', '到底', '里', '满带', '情绪', '站', '蒋匪', '千言万语', '12', '海洋', '没看', '达到', '离不开', '不要', '饼', '无所谓', '吼叫', '如何', '17', '放肆', '分开', '疼', '爱情', '街道', '中', '那里', '就要', '跟', '作和声', '管它', '野菜', '动人', '保卫祖国', '赛呀赛', '气球', '硬撑', '呵', '走心', '工人阶级', '什么', '风中', '街', '年少', '得儿', '北国', '之前', '格拉', '祖国颂', '万年青', '慌', 'La', '男', '爱上', '不敢', '边', '喔', '并', '6', '好威风', '生活', '坚强', '战场', '继续', '心事', '晴天', '冰冷', '寒冬腊月', '夕阳', '留', '机器', '追忆', '找寻', '迷失', '收起', '躲', '早日', '美丽', '不忍', '高', '虎豹', '无', '妻子', '别', '身', '太', '发出', '家乡', '风光', '暖', '唇印', '来来来', '风吹雨打', '些', '以往', '团结友爱', '蔼', '不屈', '看着', '难有', '只会', '秘密', '丰满', '画凤', '错', '熬过', '爱', '写', '变成', '高高的', '草原', '雅鲁藏布江', '三送', '带', '遭殃', '春光', '怎么样', '亮', '母亲', '双唇', '人民军队', '沉睡', '心太急', '掉落', '棉似', '银光', '世界', '这里', '夜里', '知道', '鲤鱼', '份', '晚霞', '日记', '每束', '挽回', '7', '惊起', '路开', '歌声', '红领巾', '浪', '围剿', '等待', '哪里', '见', '.', '上前', '软弱', '井冈山', '平安', '地响', '心里', '勇敢', '怎能不', '金光', '我爱你', '在所难免', '过握', '乌云', '强大', '温热', '思情', '矫健', '醉人', '给', '山野', '主张', '双桨', '勇士', '海浪', '海员', '阻止', '眼泪', '借', '时候', '草毯', '仇恨', '终于', '开火', '遍地', '壮丽', '舌', '玩耍', '西施', '爱家乡', '不会', '气势', '~', '不必', '含着', '打天下', '咿儿', '忘', '我要', '拜', '放晴', '毛泽东', '蝴蝶', '长茧', '可', '哄', '里个', '痴', '良田', '建立', '古老', '高中', '守护', '推开', '树', '路', '苦难', '耳机', '了', '狠', '不', '丰富', '竞相', 'Re', '一夜', '燃烧', '这片', '叔叔', '云朵', '高于', '血染', '爱心', '但是', '无边', '口中', '天寒地冻', '看不见', '东风', '红梅', '最怕', '救', '放不下', '无声', '新', '朝霞', '战士', '烽火', '千百里', '蓝天', '迷恋', '羽毛', '渐渐', '一扇', '穿梭', '无味', '石油', '加快', '说出', '接过', '分派', '飞行', '可会知', '边防军', '三九', '英雄', '军民鱼水', '彩门', '过得', '小船', '下面', '气势磅礴', '惊涛骇浪', '作', '门窗', '农隶', '教室', '常青', '中南海', '烟波', '任', '计较', '头顶', '枯萎', '自我', '沿着', '柔软', '唱歌', '后悔', '写下', '永不', '宿舍', '滚烫', '心像', '照样', '踩', '第一回', '子弟兵', '翻', '同样', '响亮', '收豆', '借口', '山沟', '铁路', '真相', '侧后方', '决心', '梦之旅', '轰响', '感到', '白帆', '身体', '鱼', '青蓝', '天使', '保证', '还要', '矢', '哪怕', '无数', '笑声', '赞颂', '希望', '阵线', '钢铁', '永远', '号子', '全都', '很', '伤感', '得', '伤害', '树林', '可能', '望月', '鞭子', '河', '高原', '全世界', '无际', '想', '一起', '缠', '鱼水', '感染', '眼睛', '碧波', '错觉', '万泉河', '铁墙', '任随', '迎风', '敌歼', '头戴', '懂', '晃到', '谋', '日', '知己', 'music', '姑娘', '一般', '我亲', '昨天', '岭上', '付出', '矿山', '古城', '开心', '白杨树', '四面', '飘落', '辉煌', '还是', '那样', '从无到有', '-', '遇见', '看作', '大旗', '约会', '33', '乱冲', '筑成', '倒映', '一齐', '永', '晚灯', '印', '此刻', '敲', '对', '哀号', '擦肩而过', '无怨无悔', '壮', '真情', '青草', '风雨', '甜蔗', '时', '旁边', '陕北', '流泪', '长', '每日', '每天', '天顶', '前途', '随风飘荡', '35', '相信', '油桐', '飘', '抗日', '嗨', '保卫', '占据', '果儿', '枪炮', '靠着', '挥霍', '严阵以待', '允满', '瑞金', '宽畅', '气息', '指尖', '呀', '危急', '向着', '湖边', '小心', '课', '荒原', '心窝', '工农', '双眼', '骗人', '塞纳河畔', '从今', '天山', '战舰', '泥土', '骄傲', '车窗', '毡房', '海面', '久', '怎能', '十万', '兄弟', '小伙儿', '只要', '颠倒', '完整', '白云', '怨', '无论谁', '涌', '独', '来自', '胸口', '建造', '舍生忘死', '工人', '31', '船儿', '手握', '象征', '中国', '吼', '万岁', '安排', '湖中', '树下点', '突破', '彷佛', '首创', '草地', '英勇', '需要', '爆破筒', '就此', '时想', '像是', '高梁', '赛', '收成', '绿', '翘', '珍惜', '踪和影', '不盼缘', '真不少', '充满', '冷漠', '坚定', '捎信', '抽', '赞', '秋日', '土地', '仍', '24', '深处', '长矛', '天山南北', '心儿', '砸碎', '有多美', '早餐', '豺狼', '远客', '看到', '畏畏缩缩', '高台', '二月', '怒目', '胸中', '阵地', '38', '迈开', '流水', '感应', '强', '共', '依旧', '一句', '波澜壮阔', '捐些', '名叫', '响起', '喜欢', '鞭儿响', '林海', '28', '飘飘', '情意', '换', 'he', '蛋', '我试', '摔死', '再美终', '还', '书信', '忧伤', '翻身', '一点', '成功', '力量', '皑皑', '如铁', '想像', '闪闪', '日落', '消灭', '首歌', '袂', '知难而退', '湖水', '洋枪', '家园', '讲', '出', '看透', '铁锁链', '苦苦', '和', '强求', '一层层', '时代', '黑暗', '亲手', '16', '马', '闹革命', '好好', '嘴', '不理', '说谎', '五送', '九送', '前程', '怎么', '意义', '窗', '所以', '越', '白雪', '愿意', '但愿', '感谢', '手', '她', '艄公', '灿烂', '亲善', '最爱', '长城', '无踪', '磨', '扩张', '红旗飘飘', '唯一', '辽阔', '埋伏圈', '海防线', '火车头', '脚边', '好', '山冈', '牺牲', '青松', '象', '有点', '始终', '吻', '响', '摘', '也许', '坡', '从', '看吧', '猎枪', '广场', '缘分', '太阳', '哎', '赞歌', '变了样', '交换', '荷塘', '咆哮', '变', '看', '11', '盼望', '如钢', '年老', '难受', '捡', '荒山', '得到', '大树', '新春', '捎', '满', '歌', '刮风', '肥', '旧', '勇气', '走入', '四年', '花言巧语', '…', '加紧', '武装', '必死', '彩蝶', '烟成', '高举', '山路', '变冷', '一会儿', '回来', '俺', '夏天', '回', '拥挤', '红', '肯定', '海深', '差错', '就象', '梦', '没考上', '山头', '向前', '(', '撒下', '祖国', '良心', '阳光', '抬头', '离骚', '冷', '琴', '真爱', '一条心', '和平', '江南', '天安门广场', '根本', '珍珠', '买卖', '让', '充饥', '似', '礼物', '年代', '好山好水', '撩乱', '年轻', '香', '彩', '含', '放手', '同', '草', '一杯', '挣扎', '望', '升起', '明天', '随便', '百万', '劳动', '十丈', '一整瓶', '一回', '朋友', '一个', '送郎', '改善', '颂歌', '指', '活下去', '8', '村庄', '找', '青年', '吃', '大学', '万古', '痴情', '今天', '离人', '渠水', '伤', '一阵阵', '太阳升', '22', '也', '巡逻', '朵朵', '垂危', '愉快', '领袖', '操场', '咱们', '不怕难', '放牛郎', '.......', '撒', '清泉', '要', '照得', '冷冷的', '延安', '与', '最后', '骏马', '听到', '影子', '煮', '原来', '说唱', '谁种', '左岸', '跟着', '反攻', '认真', '掌权', '忍受', '交错', '都', '会试', '城市', '不是', '风', '就是', '4', '变迁', '花', '飘扬', '待', '诶', '怒放', '卑污', '算', '湘', '展', '夜半三更', '云霞', '无敌', '成就', '千万', '抬起', '呼儿', '锣儿', '造', '献身', '哪儿', '呦', '安慰', '意气风发', '做', '回忆', '掉', '请', '十六', '一切', '再次', '送', '红旗', '早', '就算', '种子', '心连心', '30', '门', '说梦话', '率领', '长长的', '紧', '介支格', '井', '河边', '清晰可见', '热爱', '男女老少', '掩护着', '白塔', '最深', '无比', '混乱', '深根', '实行', '法西斯蒂', '不知', '伟大领袖', '染红', '永夜', '大雨', '失去', '苦干', '肥来', '绿树', '安康', '拥抱', '南海', '可爱', '生产', '花朵', '离去', '月色', '下', '现在', '真心', '低头', '天安门', '写错', '俯瞰', '芦苇', 'So', '紧紧', '歌颂', '头发', '鲜', '最亲', '骗', '或许', '出卖', '薄', '仰望', '洒满', '飞去', '绿色', '稻', '无端', '37', '眼睁睁', '留下来', '50', '开车', '乐曲', '梳子', '光辉', '哪请', '扬鞭', '签', '索玛', '游击队', '皮鞭', '金灿灿', '威武雄壮', '离别', '八年', '大到', '朝阳', '家家户户', '丰润', '落', '酒', '远方', '不落', '打败', '读书', '我愿', '拨弄', '。', '庄严', '只生', '赣江', '幸福', '跨', '云海', '哨所', '进', '小黄花', '44', '闭上', '牛', '越来越少', '样子', '九月', '化', '温习', '浪潮', '颂', '东洋', '河西', '城墙', '千山万壑', '输赢', '抵抗', '多久', '清', '爱将', '试着', '云雾', '扫荡', '抗战', '岩上', '已', '盘', '白莲花', '摆', '再也', '搅拌', '背', '水', '等', '多年', '儿记', '相爱', '拜拜', '石上', '金星', '正', '在历史上', '万丈', '听', '咱', '仙女', '这台', '道路', '45', '解放', '扎营', '啊呀', '王子', '愿', '人民', '云和雾', '人心', '浪漫', '每晚', '带领', '吧', '唱', '足够', '离', '东北', '捷报', '后心', '深', '那山', '反正', '泥', '革命队伍', '下课', '挺立', '大庆', '个人', '掰', '总有一天', '暴风', '五月', '开辟', '参战', '红花', '000', '准备', '星', '同胞', '指引', '弹着', '季节', '水兵', '枪口', '山里', '天色', '春雷', '献', '不闻不问', '亲兄弟', '叫', '童话', '我家', '狂', '村镇', '吹得', '干部', '面对', '篝火', '恋爱', '千锤百炼', '相约', '但', '收到', '鲜艳', '雷', '我手', '为什么', '淙淙', '边防线', '四方', '总有', '开天辟地', '蓝色', '叫做', '贪', '破', '山歌', '茫茫', '朝', '二小', '流萤', '喷火', '不分富', '期待', '大石头', '没有', '何所惧', '黑眼圈', '随处', '不肯', '侵略者', '舄', '沦亡', '雨', '关心', '跳动', '比较', '天真', '空嘴', '每一寸', '冲', '歌舞升平', '一片丹心', '恩情', '秋千', '双手', '叶落', '如果', '建设', '心碎', '奔腾', '白色', '带走', '心', '披荆斩棘', '几千', '山峰', '城堡', '起', '身边', '放在', '地方', '天上', '大', '星空', '荷花', '蓬勃', '井岗山', '搞砸', '尽', '碧水', '怒吼', '高歌', '现代化', '个', '海里', '40', '划出', '海防', '长得', '飞', '5', '47', '凉爽', '骗骗', '一样', '挂', '两万五千里', '容易', '玫瑰', '善变', '崭新', '仿佛', '乒乒乓乓', '十分', '腐烂', '停留', '河东', '平常', '开', '毛泽东思想', '侵犯', '如火遍', '根据地', '埋藏', '听惯', '鲜花', '睡', '革命道路', '打越', '多少', '共产主义', '狂乱', '稻田', '映照', '心中', '天空', '包围', '14', '如今', '拼到底', '飘荡', '翅膀', '瓜', '拱手让人', '炮声', '勤恳', '贡献', '下雨天', '片片', '大道', '岁月', '鲜红', '不动', '痴心', '拉着', '爱情故事', '琴声', '吉祥', '错过', '把', '割断', '四下里', '尽寒枝', '春天', '风沙', '王二小', '指路', '雨水', '万朵', '同志', '那些', '四周', '孤雁', '铺', '盛开', '思念', '意外', '有情', '照遍', '游击', '海南岛', '骄傲地', '一望无边', '落叶', '我身', '火红', '斜阳', '‘', '忍住', '大海', '脚下', '我心', '离开', '曲折', '飞来', '进入', '万山', '誓', '爱过', '战略', '进攻', '39', '张开', '大刀', '翻江倒海', '毛主席', '身旁', '若', '祥和', '甜如蜜', '雄伟', '青春', '钟', '外', '人人', '下河', '万年', '抚育', '无法', '那天', ',', '清晰', '丈', '绑票', '海', '泪', '喜讯', '勒', '出现', '一片', '忠于党', '一遍', '狠心', '哗啦啦', '浇灌', '红星', '迎', '居住', '红台', '五彩', '种田', '田间', '从此', '日照', '一丝丝', '认识', '刀', '冰霜', '雪', '隆', '绕', '不到', 'He', '拥', '万代', '戈壁', '耸立', '井架', '献给', '回家', '比', '当初', '大地', '痛苦', '那么', '弟兄', '儿女', '坚持', '一首歌', '东方红', '发现', '荡起', '抱定', '滑落', '机关', '奔', '曙光', '工作', '23', '一季', '公寓', '情书', '囚禁', '平凡', '如', '荣光', '真的', '不怕', '带路人', '昏暗', '儿', '七送', '花落', '民主', '思想', '雕龙', '这天', '会', '独行', '可惜', '这', '童年', '每个', '声响', '炊', '更好', '外衣', '过往', '驱散', '斗志昂扬', '从来', '雷电', ')', '勤劳', '向阳', '经过', '挑', '兵强', '侵衣骨', '鲜血', '丢', '他们', '军', '心肠', '黑夜', '连', '下送', '道', '行列', '追问', '飞奔', '流', '行驶', '告白', '逼', '隅', '航程', '我该', '走', '粮如山', '徘徊', '展翅飞翔', '男人', '映', '团结', '开启', '高山', '46', '告诉', '响叮当', '\n', '侧耳', '放牛', '又', '繁荣', '飞过', '歌唱', '军旗', '种', '留下', '伐木', '传捷报', '片刻', '流言蜚语', '结果', '25', '泉罗', '秋天', '难', '多保', '双飞', '我能', '拥有', '天地', '流眼泪', '求求', '学会', '队伍', '何必', '背影', '43', '锻炼', '辛劳', '黄河', '发奋图强', '一弯', '亭', '金鼓', '大路', '陪', '谷穗', '简单', '凯旋', '怕', '亲爱', '旧社会', '好像', '充军', '风传', '人潮', '适合', '煤矿', '到处', '山巅', '即将', '山间', '写给', '整个', '秧苗', '一', '压迫者', '已经', '之情', '肆无忌惮', '债', '制度', '嗨哟', '钢', '风烟', '太多', '诺言', '方向', '可是', '快乐', '粮', '坚', '最', '老乡', '一条', '带风', '华北', '似人', '山上', '声声', '昆仑', '脸', '同甘苦', '当有', '定', '抓住', '感情', '穿', '空气', '除了', '.', '万水千山', '恋人', '还有', '头', '再见', '...', '映山红', '他', '将', '千重', '歌儿', '一直', '清波', '躲过', '温柔', '海岸', '浓烈', '齐', '冲动', '眼神', '(', '最苦', '慢慢', '铁锤', '34', '一颗', '江畔', '传遍', '反', '一家人', '田野', '山', '再', '红梅赞', '灭亡', '接受', '明', '乳汁', '北京', '以为', '36', '这些', '飘处', '相恋', '无论', '多', '神枪手', '敢', '生命', '百鸟', '手指', '干劲冲天', '灼身', '冬夏', '最贵', '爱上你', '拳头', '我用', '首都', '社会主义', '党', '所有', '唱支', '合唱', '一间', '楼房', '红色', '乎', '记忆', '里瑟', '无计可施', '宽', '主席', '春', '秋风', '汗珠', '别人', '树上', '根', '那', '兵', '言语', '难过', '分', '一心', '黄昏', '肥大', '海军', '弯弯的', '飞舞', '揍', '古早', '完', '石岩', '军民联防', '好不容易', '荡', '转危为安', ':', '灿灿暖', '岸上', '安歇', '野茫茫', '点头', '照耀', '人马', '无限', '战胜', '绿草', '人们', '消失', '风吹', '海来', '瑟罗', '学校', '起伏', '敌后', '求', '困难', '一棵', '最暖', '敌人', '慌乱', '好处', '泪淋林', '宝藏', '熬煎', '咱全', '天有', '麦浪', '不能', '大河', '地下', '名字', '鹅毛雪', '繁荣富强', '不见', '走向', '看见', '美好', '号召', '我租', '奔驰', '城', '迷人', '棵', '步伐', '那个', '河畔', '光明', '剩下', '各', '革命', '有种', '叶', '拼命', '人', '、', '一首', '成长', '等到', '放下', '搭', '矢掉', '不变', '逃不了', '吹', '胜利', '割下来', '百灵鸟', '流过', '纯', '满腔', '虽然', '挥动', '条条', '幻灭', '地', '杯', '躺', '救星', '云天', '迎接', '城乡', '20', '没差', '拒绝', '当', '9', '铜壁', '没想到', '天罗地网', '捱', '不可', '受', '因为', '各族人民', '起来', '铝盔', '虚伪', '气质', '热血', '不歇', '凶', '花店', '千军万马', '决不', '仍然', '地平线', '偏偏', '新长征', '荡秋千', '征途', '扎', '牛儿', '十送', '阻挡', '梦境', '包谷', '衣裳', '碰', '笑', '嘉', '钢枪', '鸟儿', '可有可无', '任性', '来', '在', '与非', '五星红旗', '咖啡', '长虹', '这是', '红光', '直到', '甜蜜', '走过', '断粮', '轻触', '路旁', '怀抱', '屈辱', '后来', '!', '---', '唇', '霞光', '一群', '森林', '奔跑', '摆下', '最红', '欢笑', '心上', '疲倦', '胸怀', '鸿雁', '浩浩', '志士', '中华儿女', '能够', '不尽', '两岸', '了解', '万', '猪', '想念', '15', '自力更生', '红心', '才能', '向前走', '节日', '嘱咐', '工厂', '不需', '配有', '满船', 'Si', '放眼世界', '想起', '黎明', '往年', '河北', '时时刻刻', '枪尖', '住', '野果', '卖', '闪', '巍然屹立', '不吃', '四万万', '高空', '哨兵', '灯', '倒影', '举起', '几何', '河水', '人烟', '—', '边迎', '正在', '家', '身上', '昂首', '寒冬', '花香', '眼前', '好似', '万古流芳', '响雷', '在乎', '泉水', '飞行员', '’', '一片片', '明亮', '硕果', '春风', '孤单', '遍', '保', '身披', '吹遍', '抱歉', '13', '吗', '碧绿', '高楼大厦', '风儿', '48', '犯', '熟', '后面', '往事', '不期而遇', '志越', '百姓', '追', '甘心', '路途', '青山', '天亮', '是不是', '能', '品尝', '多么', '目的', '千千万万', '朝着', '蓝蓝的', '一天', '携手前进', '微带', '如同', '闯', '伤心欲绝', '官兵一致', '却', '生长', '一座座', '山岗', '们', '枪', '说', '战鼓', '暗恋', '是否', '心脏', '白玉', '绿油油', '功绩', '坚固', '归来', '烈日', '江', '马儿跑', '庄稼', '烧伤', '过', '从前', '战斗', '胸怀祖国', '童话故事', '水中', '憔悴', '国家', '英豪', '重围', '时间', '睦邻', '千年', '夜深人静', '许多', '放弃', '爱祖国', '柔情', '不了', '心意', '往下', '伟大', '传扬', '松树', '金丝鸟', '雾气', '为了', '风雪', '更', '自由', '动', '32', '果树', '曾用', '热泪', '河流', '千万颗', '忘掉', '灯光', '主人', '汉', '湿透', '原野', '孩子', '天天向上', '线', '飞翔', '坚决', '丛中', '百花', '斗争', '不分', '纷飞', '女', '..', '着', '起雾', '守卫', '前奏', '比铁', '铁', '伤悲', '边疆', '毡', '犁锄', '炉火', '越过', '地活', '传', '搏斗', '饭碗', '巍峨', '垫', '气焰', '催', '回到', '灿烂辉煌', '埋葬', '呼吸', '啊', '光彩', '心扉', '斩浪', '之歌']前面说过列表的长度就是数据的维度,这里的维度指的就影响结果的特征数,例如房价可能受面积、朝向、层高、房屋数量四个因素影响,那维度就是4。同样的,一首歌词是“情歌”还是“红歌”会受词表中的每词是否出现,或者出现次数影响,因此词表中的每个词都都是决定一首歌是情歌还是红歌的特征,词表长度就是特征维度。

向量化

得到词表后,我们还需要将每一首歌曲转化为计算机可处理的量化值,最简单的方式是通过词表中歌词在歌曲中是否出现或者出现次数来进行映射,这里选择第一种方式。

简单来讲我们会将要向量化的歌词先进行分词,并遍历词表数组,判断每个词是否在输入歌词中出现,如果出现,则对应位置的值设置为1,否则设置为0。

例如我们有词表['中国','喜欢','秋刀鱼','猫'],当输入歌词为“我爱你中国”时,得到的结果是[1,0,0,0],当输入值是“秋刀鱼的滋味、猫跟你都想了解”时,得到的向量是[0,0,1,1]

歌词全部向量化完成后,我们得到的数据非常类似于前面讲简单应用时给的数据,只是特征有2409个

| 红星 | 毛主席 | 爱情 | 喜欢 | 其他特征 | ||

| 歌曲1 | 1 | 1 | 0 | 0 | ... | 红歌 |

| 歌曲2 | 0 | 0 | 1 | 1 | ... | 情歌 |

数据加工

从公式中我们可以得出,当词表中存在一个输入歌曲没有的词时,计算出的概率将会直接是0导致分类失败,这个时候我们可以将分子和分母同时加上一个固定值保证不会得到零概率,这里称之为拉普拉斯平滑

当一些词在每首歌中都会出现(或者出现频率基本一致),那这些词对于分类其实是没有帮助的,例如“的”,“我”,标点符号等等,我们可以将这部分词从词表中去除来降低数据维度,减少计算量并提升识别准确度

最后一个问题是编码层面的,在计算机程序中,太多太小的数相乘超过数据类型可表示的最小值后,程序会下溢或得不到正确答案(比如四舍五入变成0),这个时候可以利用对数函数的性质ln(a*b) = ln(a)+ln(b)将乘法化为加法来解决这一问题

编码实现

- import jieba

- import numpy

- from sklearn.naive_bayes import MultinomialNB

- from sklearn import datasets

- #停用词表

- STOP_USING_WORDS = set([',',"我","你","是","的"," "])

-

- #将一句话转换为向量

- def sentence_to_vec(vocab_list, input):

- return_vec = [0] * len(vocab_list)

- for i in range(len(vocab_list)):

- word = vocab_list[i]

- if word in input:

- return_vec[i] = 1

- return return_vec

-

- #创建词表,将每句话中不同词汇提取出来用于计算每句话的向量

- def create_vocab_list(seg_list):

- vocab_set = set([])

- for seg in seg_list:

- vocab_set = vocab_set | set(seg)

- return list(vocab_set - STOP_USING_WORDS)

-

- #分词

- def word_split(sentence):

- seg_list = jieba.cut(sentence, use_paddle=True)

- return list(seg_list)

-

- #计算这句话在指定归类下的概率

- def predit(tran_sentences, tran_labels, input_words):

- #创建分词矩阵

- seq_list = []

- for sentence in tran_sentences:

- seq_list.append(word_split(sentence))

- #创建词表

- vocab_list = create_vocab_list(seq_list)

- #创建语句向量

- vec_list = []

- for seq in seq_list:

- vec_list.append(sentence_to_vec(vocab_list, seq))

- clf = MultinomialNB()

- X = numpy.array(vec_list)

- Y = numpy.array(tran_labels)

- clf.fit(X, Y)

- #获取输入值

- input = numpy.array(sentence_to_vec(vocab_list, word_split(input_words))).reshape(1, -1)

- label = clf.predict(input)

- print("预测结果:" + str(label))

-

- def load_datas_and_labels():

- red_data_file = open("./byers/红歌.txt", mode='r')

- red_lines = red_data_file.readlines()

- red_text = "".join(red_lines)

- red_datas = red_text.split("-----------")

- red_lebals = []

- for red_data in red_datas:

- red_lebals.append("红歌")

-

- love_data_file = open("./byers/情歌.txt", mode='r')

- love_lines = love_data_file.readlines()

- love_text = "".join(love_lines)

- love_datas = love_text.split("-----------")

- love_lebals = []

- for love_data in love_datas:

- love_lebals.append("情歌")

- return red_datas + love_datas, red_lebals + love_lebals

-

- datas, labels = load_datas_and_labels()

- love_then_year = '''

- 啊...啊...啊...啊...

- 寒风吹起细雨迷离 风雨解开我的记忆

- 我像小船寻找港湾

- 不能把你忘记

- 爱的希望(时光)爱的回味

- 爱的往事难以追忆

- 风中花蕊生(深)怕枯萎 我愿(意)为你祝福

- 我爱你我心已属于你

- 今生今世不移

- 在我心中再没有谁

- 代替你的地位

- 我爱你对你付出真意

- 不会漂浮不定(移)

- 你要为我再想一想

- 我决定爱你一万年

- music

- 喔...喔...喔...喔

- music

- 我爱你一万年我爱你一万年

- 我爱你一万年我爱你一万年

- 爱你爱你哦

- music

- 我决定爱你一万年

- '''

- predit(datas, labels, love_then_year)import jieba

- import numpy

- from sklearn.naive_bayes import MultinomialNB

- from sklearn import datasets

- #停用词表

- STOP_USING_WORDS = set([',',"我","你","是","的"," "])

-

- #将一句话转换为向量

- def sentence_to_vec(vocab_list, input):

- return_vec = [0] * len(vocab_list)

- for i in range(len(vocab_list)):

- word = vocab_list[i]

- if word in input:

- return_vec[i] = 1

- return return_vec

-

- #创建词表,将每句话中不同词汇提取出来用于计算每句话的向量

- def create_vocab_list(seg_list):

- vocab_set = set([])

- for seg in seg_list:

- vocab_set = vocab_set | set(seg)

- return list(vocab_set - STOP_USING_WORDS)

-

- #分词

- def word_split(sentence):

- seg_list = jieba.cut(sentence, use_paddle=True)

- return list(seg_list)

-

- #计算这句话在指定归类下的概率

- def predit(tran_sentences, tran_labels, input_words):

- #创建分词矩阵

- seq_list = []

- for sentence in tran_sentences:

- seq_list.append(word_split(sentence))

- #创建词表

- vocab_list = create_vocab_list(seq_list)

- #创建语句向量

- vec_list = []

- for seq in seq_list:

- vec_list.append(sentence_to_vec(vocab_list, seq))

- clf = MultinomialNB()

- X = numpy.array(vec_list)

- Y = numpy.array(tran_labels)

- clf.fit(X, Y)

- #获取输入值

- input = numpy.array(sentence_to_vec(vocab_list, word_split(input_words))).reshape(1, -1)

- label = clf.predict(input)

- print("预测结果:" + str(label))

-

- def load_datas_and_labels():

- red_data_file = open("./byers/红歌.txt", mode='r')

- red_lines = red_data_file.readlines()

- red_text = "".join(red_lines)

- red_datas = red_text.split("-----------")

- red_lebals = []

- for red_data in red_datas:

- red_lebals.append("红歌")

-

- love_data_file = open("./byers/情歌.txt", mode='r')

- love_lines = love_data_file.readlines()

- love_text = "".join(love_lines)

- love_datas = love_text.split("-----------")

- love_lebals = []

- for love_data in love_datas:

- love_lebals.append("情歌")

- return red_datas + love_datas, red_lebals + love_lebals

-

- datas, labels = load_datas_and_labels()

- love_then_year = '''

- 啊...啊...啊...啊...

- 寒风吹起细雨迷离 风雨解开我的记忆

- 我像小船寻找港湾

- 不能把你忘记

- 爱的希望(时光)爱的回味

- 爱的往事难以追忆

- 风中花蕊生(深)怕枯萎 我愿(意)为你祝福

- 我爱你我心已属于你

- 今生今世不移

- 在我心中再没有谁

- 代替你的地位

- 我爱你对你付出真意

- 不会漂浮不定(移)

- 你要为我再想一想

- 我决定爱你一万年

- music

- 喔...喔...喔...喔

- music

- 我爱你一万年我爱你一万年

- 我爱你一万年我爱你一万年

- 爱你爱你哦

- music

- 我决定爱你一万年

- '''

- predit(datas, labels, love_then_year)

无监督学习算法

上面我们介绍的所有算法统称为监督学习算法,这类算法可以从已标注过的训练集中得到预测函数。相对应的,无监督学习算法可以从无标记的训练数据中推断出结论,这里我介绍一种在聚类分析中常用的算法,k-means,他能将一系列数据分离成指定数量的集合。

数学原理

假设我们现在有一系列未分类的数据,按照惯例,我们画在坐标系中

k-means算法实现分类的过程很简单,分为以下几步

-

确定我们要将数据分为N个集合,这里我们假设需要分为两个集合

-

在数据空间中随机选择N个点,这里同样选取两个点

-

计算每个数据到选取的点的距离(这里选用欧几里得距离),并归类到距离最短的数据点的集合中,如下粉色是关联到绿点的数据,蓝色是关联到红点的数据

-

计算每个集合内数据的平均值,并将对应的点移动到集合平均值的位置

-

重复步骤3-4直到数据点不再变化,此时分类完成

我们会发现无论初始点选在什么地方,最终都会收敛到一致的分类结构中,如下是不同初始点得到的结果

算法实现

- import numpy as np

- import matplotlib.pyplot as plt

- import math

- import random

- all_points_x = [-0.06169977295010054, 0.49340177626966897, 0.2095444296181419, -0.5207938316197955, 0.4542243765615126, 0.10746365600263008, -0.5852052323013195, -0.8966334136864398, 0.02324160428849842, -0.7923747167840338, -0.23765065220905357, 0.6853348949870643, -0.4559711540212552, -0.3985320012624167, 0.9270183191133377, -0.6091860078663087, 0.5854151797931826, -0.22740774828468346, -0.4291158928234511, -0.10808463072883878, 0.6483747030633713, -0.011770444372368738, 0.3844407998227539, 0.7854935375873353, -0.6531808545885178, -0.1844683987358482, -0.3454765448279362, 0.5159326203327808, -0.1275169813033623, 0.34719597917237666, 0.7695061780560508, 0.15641961156384965, -0.6982595075270799, 0.5372183109794928, -0.3055044418941959, -0.20496967068648986, -0.0864207155208414, 0.20201548282858095, 0.757379635897723, -0.2534690276281091, -0.32170578221579427, -0.3911888090915394, -0.5763880830489512, -0.7816223430784566, -0.38700634949039125, -0.06429420000332531, -0.4530703794428841, 0.2692443884711351, -0.2919249907530941, 0.29125031576438554, -0.4653944555432845, -0.380523734541802, 0.8246267864052144, -0.379868805495742, -0.20344329814348128, 0.5749593002818367, 0.8508568124747824, 0.38901173217324914, -0.45683759514328726, 0.7908780287477655, -0.6212867404557392, 0.332510578589031, 0.3558292130112657, 0.691765122910311, -0.9585960900460035, 0.38011809744509883, 0.5824975944778181, 0.434447483174242, -0.7147622063521395, 0.6864978590021817, -0.3193454349355187, 0.2355499395852041, -0.2603930462935433, -0.4501594930778141, -0.08290733767030978, -0.373858360593869, -0.05467846017091915, 0.21401977282358864, -0.5728165113379156, 0.2774017443859518, 0.3886659506486536, 0.5491454657103723, 0.9790036359720516, 1.4215380335223016, 1.9595227777218343, 1.3359316836775936, 1.5690534720599953, 1.8459544653164461, 1.6902961931378413, 1.3580596581983828, 1.606110265779514, 2.238770337551623, 2.0685218722948435, 1.5207552900867904, 1.1356574236126549, 0.44591091214451484, 2.168446692766002, 1.6078489838291192, 0.8246936990682452, 1.4846675600318644, 1.1270503348631937, 1.1070177185327579, 0.5519390205243968, 1.239553873324542, 1.1229056409660543, 1.3954523336871982, 1.4547350714924734, 1.966957962901158, 1.5641327735689896, 1.8962486078403828, 1.7180085485035308, 1.3080184413229663, 1.5213279702171483, 1.0609352680223645, 1.1953663193273845, 1.1059127700688838, 0.7094909045701486, 0.5095845026182433, 0.6109806918037491, 1.0992851542337152, 1.9807188833530027, 2.070622099985574, 1.7727964078020082, 1.0367043148724493, 1.8561885718810882, 1.47951484711355, 0.46786572369726276, 1.7511496136838272, 1.4522133231911682, 2.0410550816388757, 1.9152979423110217, 1.4078290249577736, 1.1638880366828568, 1.2555428913043847, 0.5499453394134135, 1.5451473369291857, 1.3079659505414627, 0.8034037335758748, 0.37490966915783575, 0.8128153427575452, 1.0517075860547642, 2.1541961968691794, 1.3499053730791282, 0.7309562703436878, 0.9587268879933908, 1.2657268730812832, 1.3848551388941366, 1.404296624316741, 0.9792639829789301, 0.8999494853964968, 1.5383505310643404, 2.191213798080589, 1.6342163409851413, 2.1941545520110957, 0.5519000655769901, 1.3603368038672092, 0.8675294321038324, 1.2966905741418193, 1.720257471423815, 1.1076414540833373, 2.057112362325583, 0.7472252363491177, 1.7733961709636619, 1.396016744931351, 0.6611710519525588, 1.326516515733599, 0.7916038685662236, 0.7412092189703734, 1.0303645920682958, 1.3890049811671512, 1.2740680605158061, 1.3046018213182953, 0.4846076488736939, 1.7744916276601652, 1.2767575660924253, 0.6359773547984621, 1.198034082190006, 1.142709268631501, 1.7491941861060507, 1.6923930629549067, 0.5896384492405626, 1.6670757385635375, 1.7583774089869704, 1.2973716263250445, 0.8756239689335737, 1.4964020155766955, 1.3345757160076004, 1.924988036662909, 1.4097754669043088, 0.9187357474952046, 1.9340041102531413, 1.9353471317695288, 2.085294867258334, 1.9374072882260718, 1.6862176270564215, 1.525614202165928, 1.0198480702430757, 0.9747303786193684, 1.9580111124218758, 0.6397361593436046, 0.5972697024329843, 1.2852762298045306, 1.5929789076977636, 1.1023406387631063, 0.8027256633864344, 1.1417374932514979, 1.8845866777817577, 0.8872481484346156, 1.6749422039245865, 1.4857617536485463, 1.4806876429758042, 0.46522421059757846, 1.3840883664404364, 2.0549960977346737, 0.987729541539375]

- all_points_y = [0.5786629012040929, 0.23725850581139074, -0.759728437056777, 0.5061374012379047, 0.7441019928234256, -0.2341586670016378, -0.1771548714764808, 0.37126813836175954, -0.7248061909417074, 0.23476061458900932, 0.7857678325335402, 0.2929091648888891, 0.5775833837561508, -0.8105102193724782, -0.19851918010980962, -0.101419866420982, 0.39656243892847254, -0.776309399579068, 0.2746959812774157, -0.2896510339262468, -0.011263078092559997, 0.9170607403105755, 0.15756804496865562, -0.32035512114973574, -0.2792133279966391, -0.6080649765496857, -0.05495744706474803, 0.24113020293338572, -0.4722309866405694, -0.21582473615617936, 0.5289289988275705, -0.15770374123605735, 0.2708307529335805, -0.0259110919070884, 0.27209034633603957, 0.7376821842999068, 0.8267795668210798, 0.7503479463786076, 0.15395504530182258, 0.8175971407055236, -0.6631410705598126, -0.03743145890308197, 0.27092885286221136, 0.1980486518604816, -0.4906178459834363, 0.3188247416913992, 0.7497113822202737, -0.7215856267750183, -0.2982227679478249, 0.6151431042261353, -0.5480273912250464, 0.8143326402568969, 0.4305605478292802, 0.5632818990811501, 0.1675939017435586, 0.45921860652780677, -0.10877957376257097, 0.12483130641440288, 0.11657394309987357, 0.5504619821531185, 0.02423576395578486, -0.49846637319448184, 0.8459527245358385, -0.1384617388649556, -0.17050753115514006, 0.18032768832220514, 0.47598408495633304, -0.23060832147119492, -0.13320532983954902, -0.2986328766260309, 0.07291753629319264, 0.8132848820287741, -0.7777105658470398, -0.07344030840151827, -0.7042615804798618, -0.678077292913815, -0.9221210621255063, 0.10097849666798275, 0.25721944700899746, 0.8975584116222655, -0.07320517839918339, 1.6023062887174704, 1.5447765935127544, 0.587677057209397, 0.968133779448408, 2.2775393114966196, 1.0231095123992633, 1.6335283783900905, 1.0864953749147581, 2.196244694818856, 0.9065999522038765, 1.419903284522745, 1.1950840653564743, 1.8174763021278513, 1.3979332491515333, 1.7944389947400103, 1.4445539295949335, 2.0781688515778693, 1.272826708903409, 1.535337250749715, 2.106261241003851, 2.183975560009213, 0.9991457107128482, 1.7176390218060784, 0.8247339371677115, 0.339790426800764, 1.1554548612094413, 1.6114719104395974, 2.1721670255345904, 1.9767741228836755, 1.0728993983301571, 1.027074947572682, 1.7016085721544727, 1.0491455418835844, 1.3579432640622384, 1.6001594777131274, 1.9328475120320903, 1.3373117369243914, 1.162231671852945, 2.1939510222935783, 1.9618588171405555, 1.735467532285206, 0.8747045211059878, 1.0803292383507408, 1.319360795753246, 1.404849070644822, 0.8677645847004878, 1.3427611785333737, 1.9312326377566187, 0.7579602979854572, 1.1376434831393971, 0.38792765758283054, 0.6275797644195641, 2.007638193256228, 0.6804211807507438, 2.2335220998354464, 1.5464180773752012, 1.4551670463346067, 1.1335589116338611, 2.147826008108369, 1.0337470137136724, 1.3751922922635402, 0.7851569913108936, 1.1815035498632798, 1.3564587603940093, 2.161592293532924, 2.0528268801203864, 1.6632709712644629, 1.1646318467884087, 0.6113480132722565, 0.9241598695692183, 0.8972059332489019, 2.0289698599112675, 1.603796914793143, 1.6539176382934122, 0.38676478201395026, 1.946175470648377, 0.9027334922863961, 0.906108480563384, 0.5065733163976427, 1.3989067890560865, 0.5339738080103057, 1.717351204964645, 0.7889382298841446, 1.5907623620270273, 0.6641101833316732, 1.24780459945797, 2.010106332370372, 1.813662547962489, 1.548174356067507, 0.7113164286138507, 0.806404346105945, 1.294436467508231, 1.602019022286253, 0.8895500930570022, 1.7744384589453661, 1.3133806879795333, 0.6663945292399837, 0.7022593514904724, 1.8646152004956846, 1.4959160794972381, 1.801644106325011, 0.9527823703744637, 0.3619844958282792, 0.7051727607673441, 1.5646521983107005, 1.1706409573534626, 1.9327631246868653, 1.8498670051512134, 1.4000997211249733, 0.7194372541748983, 1.810839217986161, 0.743087325193092, 1.629099866898066, 1.3333398536472734, 0.9264748937910183, 0.5181759661495855, 0.5465225351286834, 1.9710551172461561, 0.7637364897365101, 1.3464805162401727, 1.3245917336444823, 0.89751348499999, 1.4588828483947842, 2.0099524760696967, 0.39514963304352224, 1.0899905007054855, 0.42842971364817684, 1.8059650255739934, 1.6613511675656178, 0.771966947621609, 0.9830499497691703, 1.1540648440041639, 1.2042792558909472, 1.6663794995184622]

-

- start_green_point = [0, -1]

- start_red_point = [0, 0]

-

- def step(red_point, green_point):

- red_points_x = []

- red_points_y = []

- green_points_x = []

- green_points_y = []

-

- average_red_point_x = 0

- average_red_point_y = 0

- red_point_num = 0

- average_green_point_x = 0

- average_green_point_y = 0

- green_point_num = 0

-

- for i in range(len(all_points_x)):

- point_i_x = all_points_x[i]

- point_i_y = all_points_y[i]

- red_distance = ((point_i_x - red_point[0]) ** 2 + (point_i_y - red_point[1]) ** 2) / 2

- green_distance = ((point_i_x - green_point[0]) ** 2 + (point_i_y - green_point[1]) ** 2) / 2

- if red_distance <= green_distance:

- red_points_x.append(point_i_x)

- red_points_y.append(point_i_y)

- red_point_num += 1

- average_red_point_x += point_i_x

- average_red_point_y += point_i_y

- else:

- green_points_x.append(point_i_x)

- green_points_y.append(point_i_y)

- average_green_point_x += point_i_x

- average_green_point_y += point_i_y

- green_point_num += 1

- print(red_point_num, green_point_num)

- return red_points_x, red_points_y, green_points_x, green_points_y, [average_red_point_x / red_point_num, average_red_point_y / red_point_num],[average_green_point_x / green_point_num, average_green_point_y / green_point_num]

- import numpy as np

- import matplotlib.pyplot as plt

- import math

- import random

- all_points_x = [-0.06169977295010054, 0.49340177626966897, 0.2095444296181419, -0.5207938316197955, 0.4542243765615126, 0.10746365600263008, -0.5852052323013195, -0.8966334136864398, 0.02324160428849842, -0.7923747167840338, -0.23765065220905357, 0.6853348949870643, -0.4559711540212552, -0.3985320012624167, 0.9270183191133377, -0.6091860078663087, 0.5854151797931826, -0.22740774828468346, -0.4291158928234511, -0.10808463072883878, 0.6483747030633713, -0.011770444372368738, 0.3844407998227539, 0.7854935375873353, -0.6531808545885178, -0.1844683987358482, -0.3454765448279362, 0.5159326203327808, -0.1275169813033623, 0.34719597917237666, 0.7695061780560508, 0.15641961156384965, -0.6982595075270799, 0.5372183109794928, -0.3055044418941959, -0.20496967068648986, -0.0864207155208414, 0.20201548282858095, 0.757379635897723, -0.2534690276281091, -0.32170578221579427, -0.3911888090915394, -0.5763880830489512, -0.7816223430784566, -0.38700634949039125, -0.06429420000332531, -0.4530703794428841, 0.2692443884711351, -0.2919249907530941, 0.29125031576438554, -0.4653944555432845, -0.380523734541802, 0.8246267864052144, -0.379868805495742, -0.20344329814348128, 0.5749593002818367, 0.8508568124747824, 0.38901173217324914, -0.45683759514328726, 0.7908780287477655, -0.6212867404557392, 0.332510578589031, 0.3558292130112657, 0.691765122910311, -0.9585960900460035, 0.38011809744509883, 0.5824975944778181, 0.434447483174242, -0.7147622063521395, 0.6864978590021817, -0.3193454349355187, 0.2355499395852041, -0.2603930462935433, -0.4501594930778141, -0.08290733767030978, -0.373858360593869, -0.05467846017091915, 0.21401977282358864, -0.5728165113379156, 0.2774017443859518, 0.3886659506486536, 0.5491454657103723, 0.9790036359720516, 1.4215380335223016, 1.9595227777218343, 1.3359316836775936, 1.5690534720599953, 1.8459544653164461, 1.6902961931378413, 1.3580596581983828, 1.606110265779514, 2.238770337551623, 2.0685218722948435, 1.5207552900867904, 1.1356574236126549, 0.44591091214451484, 2.168446692766002, 1.6078489838291192, 0.8246936990682452, 1.4846675600318644, 1.1270503348631937, 1.1070177185327579, 0.5519390205243968, 1.239553873324542, 1.1229056409660543, 1.3954523336871982, 1.4547350714924734, 1.966957962901158, 1.5641327735689896, 1.8962486078403828, 1.7180085485035308, 1.3080184413229663, 1.5213279702171483, 1.0609352680223645, 1.1953663193273845, 1.1059127700688838, 0.7094909045701486, 0.5095845026182433, 0.6109806918037491, 1.0992851542337152, 1.9807188833530027, 2.070622099985574, 1.7727964078020082, 1.0367043148724493, 1.8561885718810882, 1.47951484711355, 0.46786572369726276, 1.7511496136838272, 1.4522133231911682, 2.0410550816388757, 1.9152979423110217, 1.4078290249577736, 1.1638880366828568, 1.2555428913043847, 0.5499453394134135, 1.5451473369291857, 1.3079659505414627, 0.8034037335758748, 0.37490966915783575, 0.8128153427575452, 1.0517075860547642, 2.1541961968691794, 1.3499053730791282, 0.7309562703436878, 0.9587268879933908, 1.2657268730812832, 1.3848551388941366, 1.404296624316741, 0.9792639829789301, 0.8999494853964968, 1.5383505310643404, 2.191213798080589, 1.6342163409851413, 2.1941545520110957, 0.5519000655769901, 1.3603368038672092, 0.8675294321038324, 1.2966905741418193, 1.720257471423815, 1.1076414540833373, 2.057112362325583, 0.7472252363491177, 1.7733961709636619, 1.396016744931351, 0.6611710519525588, 1.326516515733599, 0.7916038685662236, 0.7412092189703734, 1.0303645920682958, 1.3890049811671512, 1.2740680605158061, 1.3046018213182953, 0.4846076488736939, 1.7744916276601652, 1.2767575660924253, 0.6359773547984621, 1.198034082190006, 1.142709268631501, 1.7491941861060507, 1.6923930629549067, 0.5896384492405626, 1.6670757385635375, 1.7583774089869704, 1.2973716263250445, 0.8756239689335737, 1.4964020155766955, 1.3345757160076004, 1.924988036662909, 1.4097754669043088, 0.9187357474952046, 1.9340041102531413, 1.9353471317695288, 2.085294867258334, 1.9374072882260718, 1.6862176270564215, 1.525614202165928, 1.0198480702430757, 0.9747303786193684, 1.9580111124218758, 0.6397361593436046, 0.5972697024329843, 1.2852762298045306, 1.5929789076977636, 1.1023406387631063, 0.8027256633864344, 1.1417374932514979, 1.8845866777817577, 0.8872481484346156, 1.6749422039245865, 1.4857617536485463, 1.4806876429758042, 0.46522421059757846, 1.3840883664404364, 2.0549960977346737, 0.987729541539375]

- all_points_y = [0.5786629012040929, 0.23725850581139074, -0.759728437056777, 0.5061374012379047, 0.7441019928234256, -0.2341586670016378, -0.1771548714764808, 0.37126813836175954, -0.7248061909417074, 0.23476061458900932, 0.7857678325335402, 0.2929091648888891, 0.5775833837561508, -0.8105102193724782, -0.19851918010980962, -0.101419866420982, 0.39656243892847254, -0.776309399579068, 0.2746959812774157, -0.2896510339262468, -0.011263078092559997, 0.9170607403105755, 0.15756804496865562, -0.32035512114973574, -0.2792133279966391, -0.6080649765496857, -0.05495744706474803, 0.24113020293338572, -0.4722309866405694, -0.21582473615617936, 0.5289289988275705, -0.15770374123605735, 0.2708307529335805, -0.0259110919070884, 0.27209034633603957, 0.7376821842999068, 0.8267795668210798, 0.7503479463786076, 0.15395504530182258, 0.8175971407055236, -0.6631410705598126, -0.03743145890308197, 0.27092885286221136, 0.1980486518604816, -0.4906178459834363, 0.3188247416913992, 0.7497113822202737, -0.7215856267750183, -0.2982227679478249, 0.6151431042261353, -0.5480273912250464, 0.8143326402568969, 0.4305605478292802, 0.5632818990811501, 0.1675939017435586, 0.45921860652780677, -0.10877957376257097, 0.12483130641440288, 0.11657394309987357, 0.5504619821531185, 0.02423576395578486, -0.49846637319448184, 0.8459527245358385, -0.1384617388649556, -0.17050753115514006, 0.18032768832220514, 0.47598408495633304, -0.23060832147119492, -0.13320532983954902, -0.2986328766260309, 0.07291753629319264, 0.8132848820287741, -0.7777105658470398, -0.07344030840151827, -0.7042615804798618, -0.678077292913815, -0.9221210621255063, 0.10097849666798275, 0.25721944700899746, 0.8975584116222655, -0.07320517839918339, 1.6023062887174704, 1.5447765935127544, 0.587677057209397, 0.968133779448408, 2.2775393114966196, 1.0231095123992633, 1.6335283783900905, 1.0864953749147581, 2.196244694818856, 0.9065999522038765, 1.419903284522745, 1.1950840653564743, 1.8174763021278513, 1.3979332491515333, 1.7944389947400103, 1.4445539295949335, 2.0781688515778693, 1.272826708903409, 1.535337250749715, 2.106261241003851, 2.183975560009213, 0.9991457107128482, 1.7176390218060784, 0.8247339371677115, 0.339790426800764, 1.1554548612094413, 1.6114719104395974, 2.1721670255345904, 1.9767741228836755, 1.0728993983301571, 1.027074947572682, 1.7016085721544727, 1.0491455418835844, 1.3579432640622384, 1.6001594777131274, 1.9328475120320903, 1.3373117369243914, 1.162231671852945, 2.1939510222935783, 1.9618588171405555, 1.735467532285206, 0.8747045211059878, 1.0803292383507408, 1.319360795753246, 1.404849070644822, 0.8677645847004878, 1.3427611785333737, 1.9312326377566187, 0.7579602979854572, 1.1376434831393971, 0.38792765758283054, 0.6275797644195641, 2.007638193256228, 0.6804211807507438, 2.2335220998354464, 1.5464180773752012, 1.4551670463346067, 1.1335589116338611, 2.147826008108369, 1.0337470137136724, 1.3751922922635402, 0.7851569913108936, 1.1815035498632798, 1.3564587603940093, 2.161592293532924, 2.0528268801203864, 1.6632709712644629, 1.1646318467884087, 0.6113480132722565, 0.9241598695692183, 0.8972059332489019, 2.0289698599112675, 1.603796914793143, 1.6539176382934122, 0.38676478201395026, 1.946175470648377, 0.9027334922863961, 0.906108480563384, 0.5065733163976427, 1.3989067890560865, 0.5339738080103057, 1.717351204964645, 0.7889382298841446, 1.5907623620270273, 0.6641101833316732, 1.24780459945797, 2.010106332370372, 1.813662547962489, 1.548174356067507, 0.7113164286138507, 0.806404346105945, 1.294436467508231, 1.602019022286253, 0.8895500930570022, 1.7744384589453661, 1.3133806879795333, 0.6663945292399837, 0.7022593514904724, 1.8646152004956846, 1.4959160794972381, 1.801644106325011, 0.9527823703744637, 0.3619844958282792, 0.7051727607673441, 1.5646521983107005, 1.1706409573534626, 1.9327631246868653, 1.8498670051512134, 1.4000997211249733, 0.7194372541748983, 1.810839217986161, 0.743087325193092, 1.629099866898066, 1.3333398536472734, 0.9264748937910183, 0.5181759661495855, 0.5465225351286834, 1.9710551172461561, 0.7637364897365101, 1.3464805162401727, 1.3245917336444823, 0.89751348499999, 1.4588828483947842, 2.0099524760696967, 0.39514963304352224, 1.0899905007054855, 0.42842971364817684, 1.8059650255739934, 1.6613511675656178, 0.771966947621609, 0.9830499497691703, 1.1540648440041639, 1.2042792558909472, 1.6663794995184622]

-

- start_green_point = [0, -1]

- start_red_point = [0, 0]

-

- def step(red_point, green_point):

- red_points_x = []

- red_points_y = []

- green_points_x = []

- green_points_y = []

-

- average_red_point_x = 0

- average_red_point_y = 0

- red_point_num = 0

- average_green_point_x = 0

- average_green_point_y = 0

- green_point_num = 0

-

- for i in range(len(all_points_x)):

- point_i_x = all_points_x[i]

- point_i_y = all_points_y[i]

- red_distance = ((point_i_x - red_point[0]) ** 2 + (point_i_y - red_point[1]) ** 2) / 2

- green_distance = ((point_i_x - green_point[0]) ** 2 + (point_i_y - green_point[1]) ** 2) / 2

- if red_distance <= green_distance:

- red_points_x.append(point_i_x)

- red_points_y.append(point_i_y)

- red_point_num += 1

- average_red_point_x += point_i_x

- average_red_point_y += point_i_y

- else:

- green_points_x.append(point_i_x)

- green_points_y.append(point_i_y)

- average_green_point_x += point_i_x

- average_green_point_y += point_i_y

- green_point_num += 1

- print(red_point_num, green_point_num)

- return red_points_x, red_points_y, green_points_x, green_points_y, [average_red_point_x / red_point_num, average_red_point_y / red_point_num],[average_green_point_x / green_point_num, average_green_point_y / green_point_num]

附录1:房价数据

左侧为面积(单位平方米),右侧为价格(单位万元)

- [88.64,305],

- [88.75,350],

- [117.12,312],

- [132.79,325],

- [117.12,300],

- [113.82,405],

- [88.59,435],

- [130,440],

- [57.04,199],

- [81.4,268],

- [149.75,566],

- [205.26,760],

- [100.96,335],

- [89.21,310],

- [132.65,525],

- [148.2,560],

- [139.18,530],

- [87.34,320],

- [129.01,668],

- [78.43,250],

- [158.09,660],

- [75.54,470],

- [75.04,215],

- [74.97,245],

- [74.91,200],

- [74.96,235],

- [67.24,308],

- [64.37,125],

- [56.74,100],

- [56.74,92],

- [159.39,725],

- [160,730],

- [168.44,570],

- [167.83,600],

- [168.44,720],

- [170.07,850],

- [170.84,750],

- [182.13,820],

- [182.59,845],

- [189.08,800],

- [190.36,840],[88.64,305],

- [88.75,350],

- [117.12,312],

- [132.79,325],

- [117.12,300],

- [113.82,405],

- [88.59,435],

- [130,440],

- [57.04,199],

- [81.4,268],

- [149.75,566],

- [205.26,760],

- [100.96,335],

- [89.21,310],

- [132.65,525],

- [148.2,560],

- [139.18,530],

- [87.34,320],

- [129.01,668],

- [78.43,250],

- [158.09,660],

- [75.54,470],

- [75.04,215],

- [74.97,245],

- [74.91,200],

- [74.96,235],

- [67.24,308],

- [64.37,125],

- [56.74,100],

- [56.74,92],

- [159.39,725],

- [160,730],

- [168.44,570],

- [167.83,600],

- [168.44,720],

- [170.07,850],

- [170.84,750],

- [182.13,820],

- [182.59,845],

- [189.08,800],

- [190.36,840],