热门标签

热门文章

- 1Oracle RAC 关键参数与常用命令_oracle rac常用命令

- 2配置Nginx解决http host头攻击漏洞_nginx host头攻击

- 3总结一下使用Emgucv的经验和经历

- 4ESXI HostDatastoreSystem.RemoveDatastore

- 5如何通过pytest+requests+allure自动化测试接入Jenkins?测开必备

- 6LDPC码简介_ldpc编码

- 7One of the configured repositories failed (Unknown),

- 8如何计算机器人运动学,机器人运动学正解的新算法

- 9Attention注意力机制介绍_注意力机制可以用余弦相似度吗

- 10计算机专业毕业设计题目大全(持续更新)_编程毕业设计题目

当前位置: article > 正文

内容安全与网络治理7、8章

作者:码创造者 | 2024-08-22 15:32:27

赞

踩

内容安全与网络治理

第七讲 对抗攻击与防御

一、概述

1. 动机

分类器对噪声具有鲁棒性和在“大多数情况下”有效是不够的;

我们想要鲁棒的分类器用来对付用户愚弄分类器的输入;应付来自人类的恶意;

特别适用于垃圾邮件分类、恶意软件检测、网络入侵检测等。

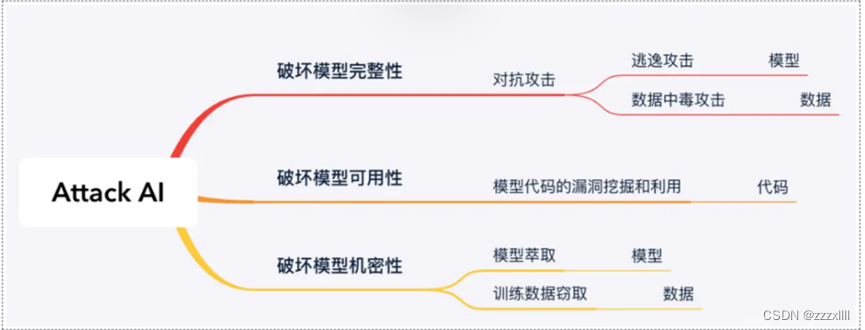

2. Attack AI:

3. 逃逸攻击:

是指攻击者在不改变目标机器学习系统的情况下,通过构造特定输入样本以完成欺骗目标系统的攻击——对抗样本

4. 投毒攻击:攻击者通过篡改训练数据或添加恶意数据来影响模型训练过程,最终降低其在预测阶段的准确性。

二、攻击

1. 想做什么?

通过在原始图像中添加一些人眼无法察觉的扰动,使得模型预测的结果出错。

2. 攻击的损失函数:

模型训练:Ltrainθ=C(y0,ytrue)

[训练过程中输入x是固定的]

无目标攻击Non-targeted Attack: L(x')=-C(y',ytrue)

[θ即模型参数是固定的] 损失函数越小,模型输出离ytrue就越远;

有目标攻击 Targeted Attack: Lx'=-C(y',ytrue) + C(y',yfalse)

损失函数越小,模型输出离ytrue越远,离yfalse越近;

约束:d(x0,x')≤ε

确保输入的改变难以被察觉;

衡量距离的方法:

L2-norm: dx0,x'=|x0-x'|2=∆x12+∆x22+…

L-infinity:dx0,x'=|x0-x'|∞=max{∆x1,∆x2,…}

3. 如何攻击:

就像训练一个神经网络, 但是网络参数 声明:本文内容由网友自发贡献,转载请注明出处:【wpsshop博客】

推荐阅读

相关标签

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。